Ten artykuł został przygotowany jako uzupełnienie innych tekstów i ogólne wsparcie w nauce o sztucznej inteligencji. Jeśli nie masz jeszcze podstawowej wiedzy o tym, jak działa AI i uczenie maszynowe, polecam najpierw przeczytać artykuł wyjaśniający zasadę działania modeli językowych – znajdziesz w nim omówienie pojęć takich jak tokeny, wektory, warstwy czy temperatura.

Warto też poszerzać wiedzę o sztucznej inteligencji, korzystając z różnych źródeł. Szczególnie polecam kanał YouTube 3Blue1Brown, który w przejrzysty i wizualny sposób tłumaczy nawet bardzo złożone zagadnienia.

Spis treści

Podstawy

Sztuczna Inteligencja

Zbiór metod pozwalających maszynom wykonywać zadania kojarzone z ludzką inteligencją, na przykład rozumienie języka, rozpoznawanie obrazów, planowanie. Ponieważ nie da się zdefiniować czym jest ludzka inteligencja, definicja sztucznej inteligencji ma charakter ogólny, a jej celem jest dostarczenie kontekstu. Możemy wyróżnić parę poziomów sztucznej inteligencji, np. wąską i szeroką.

Uczenie Maszynowe

Podzbiór AI, w którym model uczy się wzorców z danych zamiast być programowany reguła po regule.

Uczenie Głębokie

Uczenie maszynowe oparte na wielowarstwowych sieciach neuronowych; dobrze skaluje się na duże dane.

Halucynacje

Halucynacje modeli językowych to sytuacje, w których model generuje treści pewne w tonie, lecz niezgodne z faktami albo wymyślone. Wynikają z probabilistycznej natury przewidywania kolejnych tokenów oraz braków wiedzy, niejednoznacznych poleceń i presji na „domykanie” odpowiedzi.

Model

Model to funkcja matematyczna z zestawem parametrów. W sieciach neuronowych parametry to wagi oraz biasy. Waga określa siłę połączenia między neuronami, bias wprowadza przesunięcie, które ułatwia dopasowanie krzywej do danych.

Działanie modeli językowych

Token

Tokeny to najmniejsze jednostki tekstu przetwarzane przez model; mogą być znakami, subwyrazami /sylabami, lub rzadziej całymi słowami.

Identyfikator tokenu

Liczba przypisana każdemu słowu, w odpowiednim słowniku, np. gdy wpiszemy słowo „Kot”, tokenizator zapisze to słowo w postaci liczby, np. 5432

Macierz osadzeń

Modele językowe nie operują na zwykłych liczbach, operują na wielowymiarowych wektorach. Tak więc liczba słowa „kot” ( 5432), jest zamieniana na wektor [0.12, -0.87, 0.33, …]. Robi się to za pomocą macierzy osadzeń, gdzie każdy wektor jest przypisany do odpowiedniej liczby.

Uczenie modelu

Uczenie modelu językowe polega na ustaleniu odległości między słowami, czyli na ustaleniu odpowiednich współrzędnych tokenów, czyli ich parametrów. Kluczowym pojęciem jest propagacja wsteczna (backpropagacja), czyli zmienianie parametrów funkcji na podstawie różnicy pomiędzy wynikiem uzyskanym przez AI, a kontrolnym wynikiem ustalonym przez człowieka.

Embeding bazowy

W uproszczeniu, współrzędne wektora, np. [0.12], [-0.87] to właśnie embeding bazowy.

Wagi spółczynniki określające siłę połączeń między neuronami; to one są głównie aktualizowane w procesie uczenia się modeli.

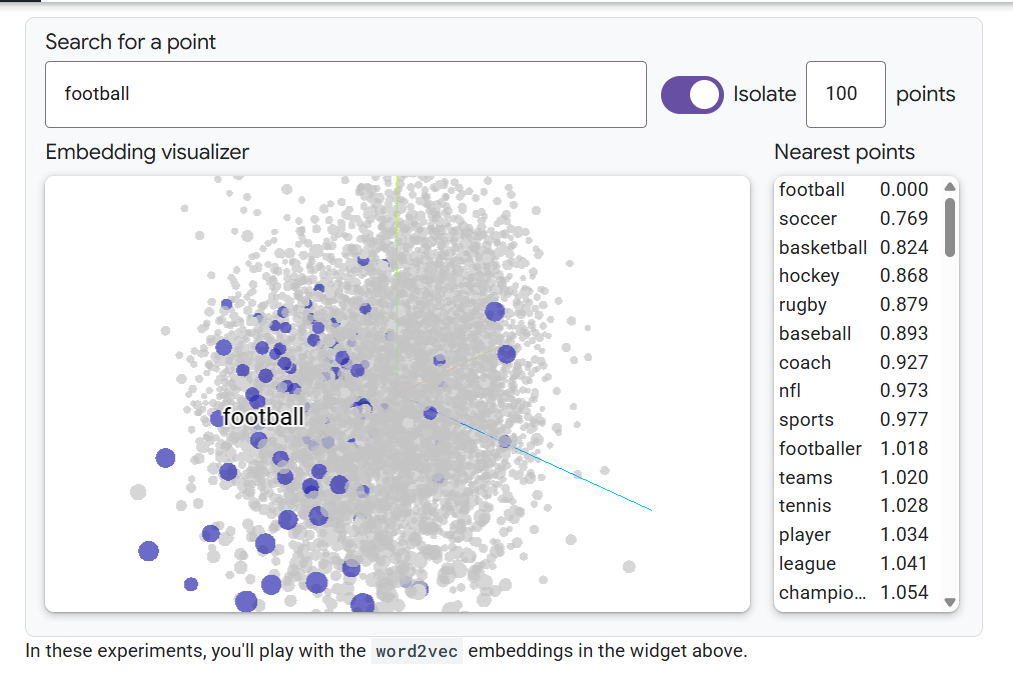

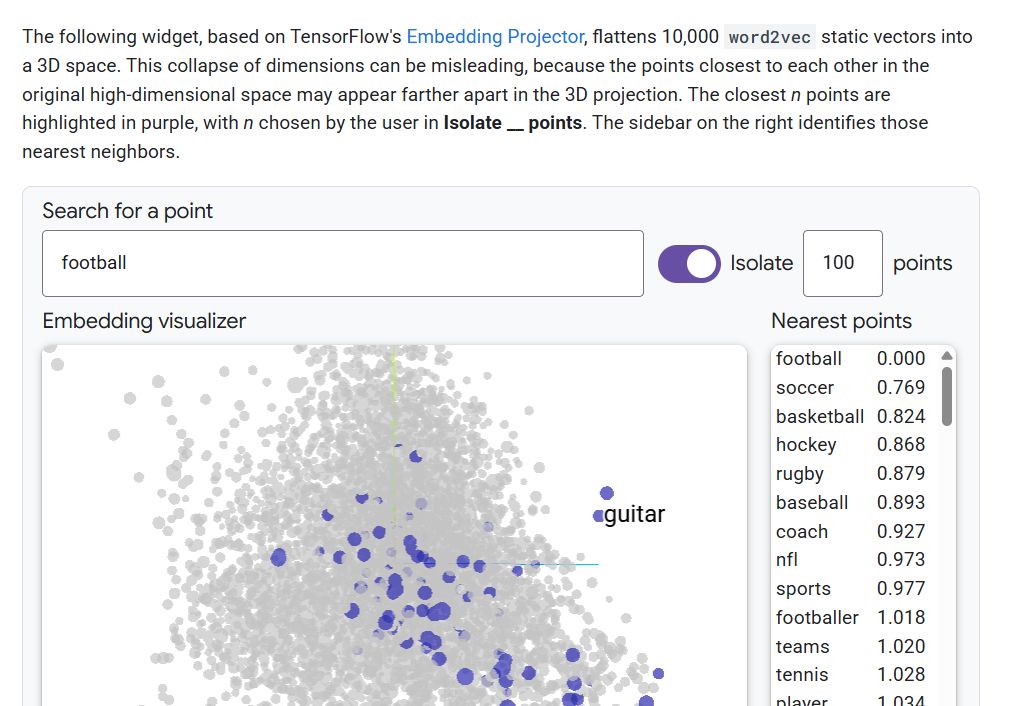

Wspaniałe narzędzie od Google, które pokazuje odległości między słowami (tokenami, wektorami). Wielowymiarowa przestrzeń wektorów jest tu sprowadzona do wygodnej dla ludzi, przestrzeni trójwymiarowej. Z tego powodu, wektory które są blisko siebie w złożonej przestrzeni, nie są aż tak blisko siebie w przestrzeni trójwymiarowej. Po wybraniu odpowiedniego słowa, podświetlają się powiązane pojęcia. Ale już przy takim uproszczeniu, widać pogrupowania słów w jednej części wykresu.

Zaskakująco blisko słowa „football”, jest słowo „guitar”. Może to się wydawać bez sensu, ponieważ gitary nie są zbytnio używane na meczach piłki nożnej. Jeśli więc człowiek miałby wypisać skojarzenia z piłką nożną, gitary raczej nie znalazły by się w pierwszej setce słów. Inaczej rzecz wygląda, gdy spojrzymy na kategorię „hobby”. Domyślnymi przykładami, ilustrującymi czym są zainteresowania, np. gdy się uczy języka angielskiego, jest właśnie między innymi piłka nożna i gra na gitarze.

Taka wizualizacja 3D pozwala w prosty sposób zrozumieć podstawy halucynacji modelu.

Wiele powiązań między słowami ma intuicyjny sens, np. słowo „kot” jest blisko słowa „drapieżnik”, ale nie zawsze tak to działa.

Parametry

Liczby sterujące zachowaniem modelu; w sieciach to wagi oraz biasy.

Wagi

Wagi określają siłę połączeń między tokenami. Dany token może znajdować się blisko innego w przestrzeni osadzeń (embeddingów), ale ich znaczenie semantyczne może być odległe. Wagi odgrywają też kluczową rolę w mechanizmie self-attention, który pozwala modelowi ustalić, na które tokeny powinien „zwracać uwagę”.

Przykładowo, rozważ zdanie:

Kotka piła mleko, potem wbiegła na łąkę, była ona wielka i mokra, więc szybko zawróciła.

Dzięki wagom model rozpoznaje, że token „kotka” wiąże się z „mlekiem”, a określenia „wielka” i „mokra” odnoszą się do „łąki”, nie do kotki.

Wagi pozwalają też modelowi rozumieć znaczenie słów w szerszym kontekście. Na przykład słowo „strugać” może wiązać się z innymi słowami w zdaniu, które wskazują, co dokładnie jest strugane. Model nie analizuje tylko sąsiadujących tokenów, lecz całe zdanie, wyszukując powiązania między nimi.

W wagach zakodowana jest więc wiedza o relacjach między słowami, o ich znaczeniu i o strukturze gramatycznej języka.

Bias

Bias (przesunięcie) to dodatkowa wartość dodawana do neuronu lub kanału, która pozwala modelowi lepiej dopasować funkcję do danych. Wagi określają kierunek i siłę wpływu, a bias przesuwa wynik tak, by model mógł znaleźć właściwe położenie (punkt odniesienia) w przestrzeni znaczeń.

Z matematycznego punktu widzenia bias dodaje stałą wartość do iloczynu wektora wag i wektora wejściowego. Dzięki temu funkcja aktywacji może przesunąć się w przestrzeni, co pozwala modelowi uczyć się zależności, które nie przechodzą przez punkt (0,0). Innymi słowy, bias nadaje każdemu neuronowi możliwość niezależnego przesunięcia płaszczyzny decyzyjnej, dzięki czemu model staje się bardziej elastyczny.

Bias jest stały dla danego neuronu lub kanału, ale różny między nimi. Podczas działania modelu (gdy generuje tekst) nie zmienia się dynamicznie; stanowi część wyuczonych parametrów. Jednak w trakcie treningu, bias – podobnie jak wagi – uczy się, jak najlepiej przesuwać wyniki, by neuron aktywował się we właściwych momentach. Optymalizowany jest metodą gradientu, co pozwala modelowi minimalizować błąd i dopasować się do danych treningowych.

Intuicyjnie można powiedzieć, że bias pomaga „ustawić ton” odpowiedzi. Gdy model generuje tekst, wpływa na to, w którą stronę zostanie przesunięta interpretacja znaczenia — może sprawić, że zdanie będzie bardziej pozytywne, bardziej formalne albo że model częściej wybierze określony rodzaj słowa. To subtelna korekta, która nadaje całości wypowiedzi właściwy kierunek i spójność.

Architektura

Architektura to układ warstw, bloków i przepływów danych w modelu. Określa, jak informacje przechodzą od wejścia do wyjścia i jakie operacje wykonują poszczególne elementy.

W dużych modelach językowych stosuje się zwykle architekturę transformera, zbudowaną z powtarzalnych bloków zawierających mechanizmy self-attention, normalizację i sieci liniowe.

W modelach generatywnych, takich jak GPT, używa się transformera dekoderowego, który przewiduje kolejne tokeny na podstawie wcześniejszych. Architektura ta pozwala modelowi zachować kontekst i tworzyć spójne sekwencje tekstu krok po kroku.

Architektura definiuje więc nie tylko strukturę sieci, ale także sposób, w jaki model „myśli” – jakie informacje zapamiętuje, jak je łączy i jak uczy się zależności w języku. W praktyce to właśnie od architektury zależy, czy model będzie lepiej rozumiał kontekst, budował dłuższe związki semantyczne czy radził sobie z zawiłymi zdaniami.

Warstwa

Warstwa to podstawowy element sieci neuronowej, odpowiedzialny za przekształcanie danych wejściowych w bardziej złożone reprezentacje. Każda warstwa wykonuje określone obliczenia: mnoży wejściowe wektory przez wagi, dodaje bias, a następnie przekazuje wynik przez funkcję aktywacji. W modelach językowych, takich jak transformer, warstwy są ułożone jedna nad drugą, tworząc głęboką strukturę, w której każda kolejna warstwa interpretuje dane na wyższym poziomie abstrakcji. Dzięki temu pierwsze warstwy rozpoznają proste zależności między tokenami, a wyższe uchwytują znaczenie, składnię i kontekst całych zdań.

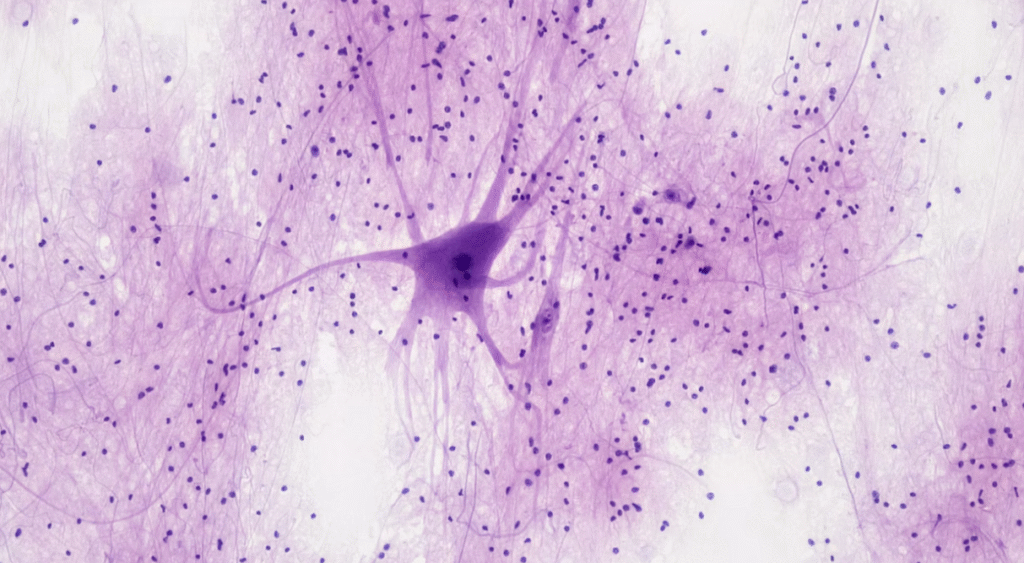

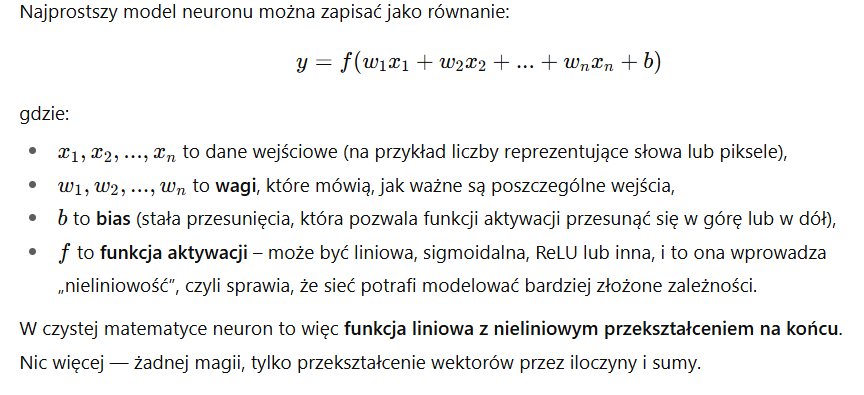

Neuron

Neuron to podstawowa jednostka obliczeniowa w sieci neuronowej, odpowiedzialna za przetwarzanie fragmentu informacji. Każdy neuron przyjmuje dane wejściowe, mnoży je przez przypisane wagi, dodaje tzw. bias, a następnie przekazuje wynik przez funkcję aktywacji, która decyduje o tym, czy sygnał zostanie przesłany dalej. W ten sposób sieć może uczyć się rozpoznawać zależności między danymi, a neurony, działając wspólnie, przetwarzają coraz bardziej złożone wzorce.

Każdy neuron na jednej warstwie, połączony jest z każdym neuronem w kolejnej warstwie.

Każdy neuron przetwarza wszystkie tokeny (wektory) do jakich ma dostęp.

Matematycznie neuron to po prostu funkcja.

W praktyce jednak nie operuje się pojedynczymi neuronami. Obliczenia prowadzone są równolegle na całych macierzach lub tensorach, które reprezentują tysiące lub miliony neuronów działających jednocześnie. Dzięki temu model może uczyć się efektywnie i przetwarzać ogromne ilości danych w krótkim czasie. Takie podejście pozwala też lepiej odwzorowywać relacje w danych, zwłaszcza w modelach językowych, gdzie kontekst zdania czy znaczenie słów zależy od wielu czynników jednocześnie.

Liczba neuronów w jednej warstwie zależy od rozmiaru modelu, czyli od liczby jego parametrów. W dużych modelach językowych, takich jak GPT-3 czy GPT-4, liczba neuronów w pojedynczej warstwie sięga nawet kilkuset tysięcy. Dla przykładu GPT-3, mający 175 miliardów parametrów, zawiera około 12 288 neuronów w każdej z 96 warstw, podczas gdy w mniejszych modelach, takich jak GPT-2 Small, liczba ta wynosi około 768. W praktyce liczba neuronów w warstwie odpowiada wymiarowi wektora osadzeń (embedding dimension) – czyli długości wektora reprezentującego token – co określa, jak szeroka jest warstwa i ile informacji model może przetwarzać równocześnie.

Hiperparametry

Wartości ustawiane przed treningiem, na przykład szybkość uczenia, rozmiar partii, liczba warstw, liczba głów uwagi, długość kontekstu. Nie są uczone z danych; dobiera się je eksperymentalnie albo algorytmicznie.

Trenowanie Modeli

Funkcja straty

Funkcja straty to sposób, w jaki model mierzy swoje błędy. Porównuje to, co przewidział, z tym, jaka jest prawda. Im większa różnica, tym większa wartość straty. Podczas uczenia sieci neuronowej model dąży do zmniejszenia tej wartości, czyli do popełniania coraz mniejszych błędów.

Można to sobie wyobrazić jak nauczyciela, który po każdym zadaniu mówi uczniowi, o ile się pomylił. Na podstawie tej informacji model poprawia swoje „odpowiedzi”.

Przykłady:

- w regresji (np. przewidywanie ceny mieszkania) używa się często błędu średniokwadratowego (Mean Squared Error – MSE),

- w klasyfikacji (np. rozpoznawanie zdjęć kotów i psów) – entropii krzyżowej (Cross-Entropy Loss).

Metryki

Metryki to wskaźniki jakości działania modelu, które pozwalają człowiekowi łatwo zrozumieć, jak dobrze działa. Nie wpływają bezpośrednio na uczenie, ale pomagają sprawdzić efekty.

Na przykład:

- Dokładność (accuracy) pokazuje, jaki procent przewidywań był poprawny,

- F1-score łączy precyzję i czułość – mówi, jak dobrze model rozpoznaje i nie pomija ważnych przypadków,

- ROC AUC ocenia, jak skutecznie model odróżnia jedną klasę od drugiej,

- w zadaniach językowych używa się metryk takich jak BLEU (ocenia podobieństwo tłumaczenia do prawdziwego) czy ROUGE (porównuje streszczenia),

- w modelach językowych pojawia się też perplexity, która pokazuje, jak dobrze model przewiduje kolejne słowa.

Metryki to więc język, którym model tłumaczy swoje wyniki ludziom – pokazują, czy jego błędy mają sens i czy w praktyce robi to, czego od niego oczekujemy.

Gradient

Gradient to matematyczna wskazówka, w którą stronę model powinien „pójść”, żeby popełniać mniej błędów. Pokazuje kierunek najszybszego wzrostu błędu względem wag (czyli liczb, które model zmienia podczas uczenia). Żeby poprawić wyniki, model idzie w przeciwną stronę – tam, gdzie błąd maleje.

Można to porównać do schodzenia z górki: funkcja straty to krajobraz z dolinami i szczytami, a gradient to strzałka pokazująca, gdzie góra jest bardziej stroma. Model idzie w dół po tej górze, aż znajdzie możliwie najniższy punkt – miejsce, gdzie błąd jest najmniejszy.

Na tej zasadzie działają popularne algorytmy uczenia, takie jak spadek gradientu (Gradient Descent), jego wersja losowa SGD (Stochastic Gradient Descent) czy bardziej zaawansowany Adam, który automatycznie dostosowuje tempo uczenia.

Wsteczna Propagacja (Backpropagacja, backpropagation)

Wsteczna propagacja (ang. backpropagation) to algorytm obliczania gradientów funkcji błędu względem wag wszystkich warstw sieci neuronowej poprzez zastosowanie reguły łańcuchowej rachunku różniczkowego.

Czyli: przy czym w każdej warstwie gradient (pochodna błędu względem wag) jest wyliczany właśnie dzięki regule łańcuchowej. Najpierw obliczany jest błąd na wyjściu sieci (różnica między przewidywaniem a wartością rzeczywistą). Następnie ten błąd jest propagowany wstecz przez kolejne warstwy (stąd nazwa).

W prostszych słowach: model startuje mając losowe parametry funkcji, następnie porównujemy wynik z odpowiedzią którą policzyliśmy ręcznie, i na tej podstawie zmieniamy parametry funkcji modelu.

Optymalizator

Optymalizator to mechanizm, który uczy model, czyli aktualizuje jego parametry na podstawie obliczonych gradientów. Decyduje, jak bardzo i w jakim kierunku zmienić wagi, żeby zmniejszyć błąd. Do najpopularniejszych należą SGD (stochastic gradient descent) – prosty, ale skuteczny, oraz Adam i AdamW, które automatycznie dopasowują tempo uczenia i poprawiają stabilność treningu.

Szybkość uczenia

Szybkość uczenia (ang. learning rate) określa, jak duży krok wykonuje model, gdy się uczy. Jeśli krok jest zbyt duży, model może „przeskakiwać” dobre rozwiązania i stać się niestabilny; jeśli zbyt mały – uczenie trwa bardzo długo. Dobór odpowiedniej wartości to jedna z najważniejszych decyzji podczas trenowania sieci.

Harmonogram uczenia

Harmonogram uczenia to plan zmiany szybkości uczenia w czasie. Początkowo model może uczyć się szybciej, a później coraz wolniej, by dopracować szczegóły. Przykładem jest cosine decay, w którym tempo uczenia maleje zgodnie z funkcją kosinusa. Często stosuje się też fazę wstępnej rozgrzewki (warm-up), zanim harmonogram zacznie działać.

Rozgrzewka

Rozgrzewka (ang. warm-up) to krótki okres na początku treningu, kiedy szybkość uczenia stopniowo rośnie od małej do docelowej wartości. Pomaga to ustabilizować pierwsze kroki modelu, który jeszcze nie „wie”, jak zachowują się dane. Dzięki temu uczenie przebiega płynniej i bez gwałtownych zmian błędu.

Epoka

Epoka (ang. epoch) to jedno pełne przejście modelu przez cały zbiór treningowy. Po każdej epoce wagi są trochę lepsze, a model staje się bardziej precyzyjny. Zazwyczaj proces powtarza się wiele razy, aż do momentu, gdy dalsze uczenie nie przynosi już wyraźnej poprawy.

Partia

Partia (ang. batch) to mała porcja danych, którą model przetwarza naraz podczas uczenia. Dzięki partiom model nie musi analizować całego zbioru jednocześnie, co pozwala oszczędzać pamięć i przyspiesza obliczenia. Wybór wielkości partii (np. 32, 64, 128) wpływa na stabilność i tempo treningu.

Iteracja

Iteracja to pojedynczy krok uczenia, czyli moment, w którym model aktualizuje swoje parametry po przetworzeniu jednej partii danych. Liczba iteracji w jednej epoce zależy od tego, na ile partii podzielono dane.

Przeuczenie

Przeuczenie (ang. overfitting) oznacza, że model nauczył się danych treningowych zbyt dobrze – zapamiętał szczegóły, zamiast zrozumieć ogólne wzorce. W efekcie świetnie działa na danych, które już widział, ale słabo radzi sobie z nowymi.

Niedouczenie

Niedouczenie (ang. underfitting) to sytuacja odwrotna – model jest zbyt prosty lub zbyt krótko trenowany, więc nie potrafi uchwycić istotnych zależności w danych. Wyniki są wtedy słabe zarówno na treningu, jak i na testach.

Regularyzacja

Regularyzacja to zestaw metod, które zapobiegają przeuczeniu. Ograniczają one zbyt duże dopasowanie do danych treningowych. Przykłady to: L2 (kara za duże wartości wag), dropout (losowe „wyłączanie” neuronów podczas uczenia) i wczesne zatrzymanie (early stopping), które przerywa trening, gdy model zaczyna się pogarszać na danych walidacyjnych.

Walidacja

Walidacja to etap kontroli jakości w trakcie uczenia. Używa się specjalnego zbioru danych, który nie uczestniczy w treningu, żeby sprawdzić, jak dobrze model uogólnia wiedzę. Wyniki walidacji pomagają dobrać tzw. hiperparametry – na przykład szybkość uczenia czy rozmiar sieci.

Test

Test to ostateczna ocena modelu – sprawdzenie, jak radzi sobie z danymi, których nigdy wcześniej nie widział. Ten etap pokazuje, jak skuteczny będzie w rzeczywistym użyciu. Zbiór testowy powinien być całkowicie odseparowany od treningu i walidacji.

Podziały danych

Podział danych to rozdzielenie całego zestawu na trzy części: treningową (do nauki), walidacyjną (do strojenia) i testową (do końcowej oceny). Dzięki temu można sprawdzić, czy model faktycznie uczy się uogólniać, a nie tylko zapamiętuje. Kluczowe jest unikanie tzw. przecieku danych, czyli sytuacji, gdy informacje z testu lub walidacji „dostają się” do treningu.

Szkolenie modeli językowych – inne pojęcia

Szkolenie modeli językowych to proces uczenia sieci neuronowych rozumienia i generowania tekstu. Odbywa się etapami – najpierw model uczy się ogólnych wzorców języka, a potem dopasowuje się do konkretnych zadań lub stylów. Dzięki temu może odpowiadać na pytania, pisać teksty czy tłumaczyć języki.

Pretraining

Pretraining, czyli wstępne uczenie, polega na trenowaniu modelu na ogromnych zbiorach tekstu, takich jak książki, artykuły i strony internetowe. Model uczy się przewidywać kolejny token (czyli fragment tekstu), co pozwala mu poznać strukturę języka, gramatykę i zależności między słowami. To etap, w którym model zdobywa ogólną wiedzę o języku.

Self-Supervised Learning

Self-supervised learning, czyli uczenie samonadzorowane, to sposób trenowania bez ręcznie tworzonych etykiet. Model sam tworzy sobie „zadania”, np. przewiduje brakujące słowa w zdaniu lub kolejny token. Dzięki temu może uczyć się na nieopisanych danych, co jest niezwykle efektywne przy dużych zbiorach tekstu.

Fine-tuning

Fine-tuning to dostrajanie modelu do konkretnego zadania lub dziedziny. Po wstępnym uczeniu model zna ogólny język, ale fine-tuning uczy go specjalizacji – na przykład rozumienia tekstów medycznych, kodu komputerowego czy rozmów klientów. Wymaga znacznie mniej danych niż pretraining, bo model już ma „bazową wiedzę”.

Instruction tuning

Instruction tuning to uczenie modelu, jak reagować na polecenia w stylu rozmowy z człowiekiem. Model nie tylko przewiduje następny token, ale także uczy się rozumieć intencje użytkownika i odpowiadać zgodnie z instrukcją. To etap, który przekształca model językowy w asystenta konwersacyjnego – potrafiącego odpowiadać naturalnie i sensownie.

RLHF

RLHF (Reinforcement Learning from Human Feedback) to uczenie przez wzmocnienie z informacją zwrotną od ludzi. W tym podejściu model najpierw generuje różne odpowiedzi, a ludzie oceniają, które są lepsze. Następnie tworzony jest model nagrody, który uczy główny model wybierać bardziej pożądane odpowiedzi. RLHF poprawia spójność, uprzejmość i zgodność modelu z oczekiwaniami użytkowników.

DPO

DPO (Direct Preference Optimization) to prostsza alternatywa dla RLHF. W tej metodzie model uczy się preferencji ludzi bez budowania osobnego modelu nagrody. Porównuje pary odpowiedzi (lepsza/gorsza) i bezpośrednio optymalizuje swoje zachowanie na podstawie tych porównań. DPO jest mniej kosztowne i bardziej stabilne w praktyce.

KTO

KTO (Kahneman-Tversky Optimization) to kolejna metoda dostrajania z preferencjami, zbliżona do DPO, ale lepiej uwzględniająca różnice między wyborem a odrzuceniem odpowiedzi. Jej celem jest bardziej „ludzki” sposób oceniania i uczenia się preferencji użytkowników.

Adaptery

Adaptery to małe dodatkowe warstwy wpinane do gotowego modelu. Zamiast trenować wszystkie miliony lub miliardy parametrów, aktualizuje się tylko te nowe, niewielkie warstwy. Dzięki temu model można łatwo dostroić do nowych zadań przy małych kosztach obliczeniowych.

LoRA

LoRA (Low-Rank Adaptation) to technika, która rozbija duże macierze wag na mniejsze i uczy tylko te małe fragmenty. To pozwala znacząco zmniejszyć ilość pamięci i czasu potrzebnego na fine-tuning, zachowując wysoką jakość wyników.

PEFT

PEFT (Parameter-Efficient Fine-Tuning) to rodzina metod oszczędzających parametry. Obejmuje między innymi adaptery i LoRA. Jej celem jest umożliwienie dostrajania ogromnych modeli nawet na zwykłym sprzęcie, bez konieczności trenowania całej sieci od nowa.

Mixture of Experts

Mixture of Experts (MoE) to architektura, w której wiele „ekspertów” przetwarza dane równolegle, ale tylko część z nich jest aktywowana dla danego przykładu. „Router” decyduje, którzy eksperci mają zająć się konkretnym fragmentem tekstu. Dzięki temu model jest wydajniejszy – uczy się specjalizacji, ale nie musi używać wszystkich zasobów naraz.

Reprezentacje Danych

Token

Token to najmniejszy fragment tekstu, który model potrafi zrozumieć i przetwarzać. Może to być całe słowo, jego część (subwyraz), pojedynczy znak lub nawet spacja. Modele językowe nie operują na pełnych zdaniach, lecz właśnie na tokenach. Przykładowo, słowo „komputerowy” może zostać rozbite na dwa tokeny: „komputer” i „owy”. Dzięki temu model lepiej radzi sobie z różnymi formami językowymi.

Tokenizacja

Tokenizacja to proces dzielenia tekstu na tokeny, czyli etap przygotowania danych wejściowych dla modelu. Stosuje się do tego różne metody, takie jak BPE (Byte Pair Encoding) czy WordPiece, które pozwalają znaleźć równowagę między zbyt drobnym a zbyt ogólnym podziałem. Dzięki tokenizacji tekst można zapisać w postaci liczb, które model potrafi przetwarzać.

Wektory

Wektory to reprezentacje numeryczne obiektów, takich jak słowa, obrazy czy dźwięki. Każdy obiekt jest zamieniany na ciąg liczb opisujących jego cechy w pewnej przestrzeni matematycznej. Dzięki temu komputer może wykonywać na nich obliczenia, na przykład mierzyć odległość czy podobieństwo między dwoma wektorami.

Osadzenia

Osadzenia (ang. embeddings) to nauczone przez model wektory, które reprezentują znaczenie słów, zdań lub innych danych. Jeśli dwa słowa są podobne znaczeniowo, ich wektory (osadzenia) znajdują się blisko siebie w przestrzeni. Przykładowo, osadzenia słów „król” i „królowa” będą blisko, ale różnić się subtelnie, co pozwala modelowi uchwycić relacje semantyczne. Osadzenia są więc sposobem, w jaki model „rozumie” znaczenie języka.

Paradygmaty Uczenia

Uczenie nadzorowane

Uczenie nadzorowane to najbardziej klasyczny sposób trenowania modeli, w którym system uczy się mapować dane wejściowe na znane etykiety. Oznacza to, że w zbiorze treningowym każdemu przykładowi (np. zdjęciu, zdaniu, dźwiękowi) towarzyszy poprawna odpowiedź. Model analizuje te pary i stara się przewidzieć etykiety dla nowych danych. Przykłady to rozpoznawanie obrazów, klasyfikacja wiadomości czy przewidywanie cen.

Uczenie nienadzorowane

Uczenie nienadzorowane to poszukiwanie wzorców w danych bez znanych etykiet. Model sam odkrywa strukturę danych, na przykład grupuje podobne elementy lub zmniejsza wymiar danych, zachowując najważniejsze informacje. Typowe zastosowania to klastrowanie (np. grupowanie klientów według zachowań) i redukcja wymiarów (np. PCA, t-SNE), które ułatwia wizualizację i analizę.

Uczenie samonadzorowane

Uczenie samonadzorowane to forma uczenia bez etykiet, w której model sam tworzy sobie zadanie. Często polega na przewidywaniu brakujących fragmentów danych – np. słowa w zdaniu lub piksela w obrazie. Dzięki temu model może wykorzystywać ogromne ilości nieoznaczonych danych i uczyć się ogólnych wzorców, które potem przydają się w bardziej wyspecjalizowanych zadaniach.

Uczenie ze wzmocnieniem

Uczenie ze wzmocnieniem (ang. reinforcement learning) to uczenie przez doświadczenie, w którym agent uczy się podejmować decyzje w środowisku. W każdym kroku wykonuje działanie, otrzymuje nagrodę i aktualizuje swoją strategię, aby w przyszłości zdobywać większe sumy nagród. To podejście stosowane np. w grach, robotyce czy sterowaniu systemami.

Polityka

Polityka (ang. policy) to funkcja opisująca sposób działania agenta – określa, jakie działanie powinien wykonać w danym stanie środowiska. Może być deterministyczna (zawsze to samo działanie) lub probabilistyczna (z pewnym prawdopodobieństwem różne decyzje). Dobrze nauczona polityka maksymalizuje przewidywaną nagrodę w długim okresie.

Wartość stanu

Wartość stanu (ang. state value) to oczekiwana łączna nagroda, jaką agent może zdobyć, zaczynając od danego stanu i działając zgodnie ze swoją polityką. Pomaga ocenić, które sytuacje są korzystne, a które nie, zanim jeszcze agent wykona jakiekolwiek działanie.

Model nagrody

Model nagrody (ang. reward model) to funkcja przewidująca, jak dobre jest dane działanie lub odpowiedź. W klasycznym RL pochodzi ona od środowiska, ale w modelach językowych może być uczona na podstawie opinii ludzi (jak w RLHF). Model nagrody odzwierciedla, co system powinien preferować, i prowadzi go w stronę lepszych decyzji.

Eksploracja i eksploatacja

Eksploracja i eksploatacja to równowaga między próbowaniem nowych rzeczy a korzystaniem z tego, co już działa. Agent musi czasem ryzykować i testować nieznane strategie (eksploracja), ale też umieć wykorzystywać to, co przynosi dobre wyniki (eksploatacja). Dobre uczenie polega na zachowaniu tej równowagi, żeby nie utknąć w lokalnym maksimum.

PPO

PPO (Proximal Policy Optimization) to popularny i stabilny algorytm uczenia aktor-krytyk, który ogranicza, jak bardzo może zmieniać się polityka między kolejnymi krokami. Dzięki temu trening jest bardziej przewidywalny i mniej podatny na niestabilność, co sprawia, że PPO jest często używany w modelach językowych i robotyce.

DQN

DQN (Deep Q-Network) to algorytm, który uczy się wartości akcji w środowisku dyskretnym. Wykorzystuje sieć neuronową do przewidywania, jaka nagroda wyniknie z podjęcia danego działania w określonym stanie. DQN był przełomem w grach komputerowych – to dzięki niemu agent nauczył się grać w Atari lepiej niż człowiek.

Aktor-krytyk

Aktor-krytyk to rodzina metod, w których współpracują dwa modele:

- krytyk ocenia, jak dobre są te działania.

Dzięki temu agent może szybciej i stabilniej się uczyć. Ten podział jest podstawą wielu współczesnych algorytmów, w tym PPO i A3C. - aktor decyduje, jakie działania podejmować,

Transformery i dziłanie modeli językowych

Transformer

Transformer to architektura sieci neuronowej, która potrafi przetwarzać całe sekwencje (np. tekst) równolegle, a nie krok po kroku jak starsze modele. Jej kluczowym elementem jest mechanizm uwagi własnej (self-attention), dzięki któremu model potrafi zrozumieć zależności między wszystkimi tokenami w zdaniu jednocześnie. Dzięki temu transformery są szybkie, skuteczne i dobrze skalują się w dużych modelach językowych.

Uwaga własna

Uwaga własna to mechanizm, który pozwala modelowi „zwracać uwagę” na różne części tekstu w zależności od ich znaczenia. Każdy token może „spojrzeć” na inne tokeny i przypisać im wagi, które mówią, jak bardzo są ze sobą powiązane. Dzięki temu model rozumie kontekst — na przykład wie, do jakiego rzeczownika odnosi się dane słowo.

KQV

KQV to skrót od Query (zapytanie), Key (klucz) i Value (wartość) – trzech zestawów wektorów obliczanych z tokenów wejściowych. Mechanizm uwagi działa właśnie na tych trzech reprezentacjach. Model porównuje zapytania z kluczami, aby ustalić, które słowa są dla siebie ważne, a następnie na podstawie wartości (V) tworzy wynik.

Wielogłowa uwaga

Wielogłowa uwaga (ang. multi-head attention) oznacza, że model ma kilka „głów” uwagi działających równolegle. Każda głowa skupia się na innym rodzaju relacji – jedna może analizować zależności gramatyczne, inna semantyczne. Dzięki temu model lepiej rozumie złożone struktury języka.

Kodowanie pozycyjne

Ponieważ transformer przetwarza tokeny równolegle, sam z siebie nie zna ich kolejności. Kodowanie pozycyjne dodaje więc informację o tym, który token jest pierwszy, drugi itd.. Może mieć postać wzorów sinusoidalnych (stałych) lub być uczone razem z modelem. To pozwala sieci zachować poczucie struktury zdania.

Połączenia rezydualne

Połączenia rezydualne (ang. residual connections) polegają na dodawaniu wejścia bloku do jego wyjścia. Pomagają w przepływie informacji przez wiele warstw, dzięki czemu model łatwiej się uczy i unika problemu zanikających gradientów. To rozwiązanie sprawia, że nawet bardzo głębokie sieci działają stabilnie.

Normalizacja warstwy

Normalizacja warstwy (ang. layer normalization) to technika standaryzacji aktywacji neuronów w obrębie pojedynczej próbki. Utrzymuje stabilne wartości i zapobiega rozchodzeniu się błędów podczas uczenia. W praktyce przyspiesza trening i poprawia jego stabilność.

Blok transformera

Blok transformera to podstawowy element budowy modelu. Zawiera kolejno: normalizację, uwagę własną, dodanie połączenia rezydualnego, ponowną normalizację, sieć typu feed-forward (czyli zwykłą warstwę neuronową) i drugie dodanie. Funkcja aktywacji to zwykle GELU, która działa płynniej niż klasyczny ReLU.

Enkoder

Enkoder to część transformera, która przetwarza całą sekwencję naraz i wyłapuje zależności między jej elementami. Nie używa maskowania, więc widzi całość tekstu. Enkodery są używane np. w modelach do tłumaczenia lub klasyfikacji tekstu.

Dekoder

Dekoder to część odpowiedzialna za generowanie tekstu – produkuje token po tokenie. Używa maskowania, żeby „nie widzieć przyszłości”, czyli nie korzystać z tokenów, które jeszcze nie zostały wygenerowane. Dekodery są kluczowe w modelach typu GPT.

Okno kontekstu

Okno kontekstu to maksymalna liczba tokenów, które model może analizować jednocześnie. Jeśli tekst jest dłuższy niż to okno, starsze fragmenty muszą zostać ucięte lub streszczone. Wielkość okna kontekstu decyduje o tym, jak długie zależności model potrafi rozumieć.

Pamięć

Pamięć to rozszerzenie klasycznego okna kontekstu. Model może zapamiętywać i ponownie wykorzystywać wcześniejsze stany, np. w formie uśrednionych osadzeń lub wybranych fragmentów tekstu. Dzięki temu zachowuje kontekst rozmowy na dłuższych dystansach, co jest kluczowe w modelach konwersacyjnych.

Logity

Logity to surowe wyniki modelu – liczby, które opisują, jak bardzo każdy token pasuje jako kolejny w sekwencji. Jeszcze nie są to prawdopodobieństwa; dopiero funkcja softmax zamienia je w wartości zrozumiałe jako rozkład prawdopodobieństwa.

Softmax

Softmax to funkcja, która zamienia logity w rozkład prawdopodobieństwa. Dzięki niej model może zdecydować, który token jest najbardziej prawdopodobny jako następny. Wszystkie wartości po softmaxie sumują się do 1, co pozwala losować lub wybierać tokeny zgodnie z ich prawdopodobieństwem.

Temperatura

Temperatura (ang. temperature) to parametr kontrolujący losowość generowania. Gdy jest niska (np. 0,2), model wybiera bardziej przewidywalne i logiczne odpowiedzi. Gdy jest wysoka (np. 1,0 lub więcej), generacje stają się bardziej losowe, co daje wrażenie większej kreatywności, , ale i mniej stabilne.

Top-k

Top-k to metoda ograniczania wyboru tokenów – model wybiera tylko spośród k najbardziej prawdopodobnych i losuje jeden z nich. Na przykład przy k=5 rozważa pięć najlepszych kandydatów, co daje równowagę między dokładnością a różnorodnością.

Top-p

Top-p (ang. nucleus sampling) to dynamiczna metoda próbkowania, w której model wybiera najmniejszy zestaw tokenów, których łączne prawdopodobieństwo przekracza wartość p (np. 0,9). Dzięki temu ilość rozważanych opcji dostosowuje się do pewności modelu.

Beam Search

Beam search to metoda przeszukiwania wielu możliwych ścieżek generacji naraz. Zamiast wybierać tylko jeden najbardziej prawdopodobny token, model śledzi kilka najlepszych wersji równolegle. Pomaga to znaleźć bardziej spójne i sensowne odpowiedzi, szczególnie w tłumaczeniach lub zadaniach wymagających długiej koherencji.

Jakość, Bezpieczeństwo, Etyka

Halucynacje

Halucynacje to odpowiedzi modeli, które brzmią pewnie, ale są nieprawdziwe. Mogą wynikać z braków w danych treningowych lub błędnego uogólnienia. Model nie „kłamie” celowo – po prostu tworzy logicznie brzmiącą treść, która nie ma oparcia w faktach. Halucynacje ogranicza się poprzez lepsze dane, metody RAG (Retrieval-Augmented Generation) oraz testowanie modeli na wiarygodność.

Ugruntowanie

Ugruntowanie (ang. grounding) to zakotwiczenie odpowiedzi modelu w zewnętrznych źródłach lub danych wejściowych. Oznacza to, że model nie tylko generuje tekst, ale także odwołuje się do rzeczywistych informacji – np. dokumentów, baz danych lub wyników wyszukiwania. Dzięki temu odpowiedzi stają się bardziej wiarygodne i możliwe do zweryfikowania.

Zaufanie

Zaufanie (ang. trustworthiness) to ocena wiarygodności modelu. Obejmuje takie aspekty jak spójność odpowiedzi, możliwość ich powtórzenia, przejrzystość działania i zgodność z faktami. Modele o wysokim poziomie zaufania nie tylko generują dobre wyniki, ale też umożliwiają użytkownikom zrozumienie, skąd pochodzą dane i jak powstała odpowiedź.

Uprzedzenia

Uprzedzenia (ang. biases) to stronniczości, które model dziedziczy z danych treningowych. Mogą prowadzić do nierównego traktowania grup lub utrwalania stereotypów. Aby je ograniczyć, stosuje się procesy pomiaru, analizy i korekty danych, a także przeglądy etyczne.

Sprawiedliwość

Sprawiedliwość (ang. fairness) to właściwość systemu polegająca na równym traktowaniu wszystkich grup użytkowników. Wymaga jasnych metryk i audytów, które pozwalają ocenić, czy model nie faworyzuje ani nie dyskryminuje żadnej grupy. Sprawiedliwe modele mają kluczowe znaczenie w zastosowaniach społecznych, finansowych czy medycznych.

Prywatność

Prywatność to ochrona informacji o użytkownikach i danych osobowych. Modele mogą nieświadomie zapamiętywać fragmenty danych treningowych, dlatego stosuje się techniki takie jak różnicowa prywatność (differential privacy), która dodaje kontrolowany „szum” do danych, aby uniemożliwić identyfikację osób.

Wyciek danych

Wyciek danych to niezamierzone odtworzenie fragmentów danych treningowych w odpowiedziach modelu. Może prowadzić do ujawnienia poufnych informacji. Aby temu zapobiec, stosuje się deduplikację danych, filtry oraz testy wykrywające takie przypadki.

Alignment

Alignment to zgodność zachowania modelu z ludzkimi intencjami i normami społecznymi. Oznacza, że model nie tylko rozumie polecenia, ale też działa w sposób bezpieczny, etyczny i zgodny z wartościami użytkowników. To jeden z głównych celów współczesnych badań nad sztuczną inteligencją.

Zabezpieczenia

Zabezpieczenia to polityki, filtry i procedury bezpieczeństwa, które ograniczają ryzyko nadużyć i niepożądanych zachowań modeli. Mogą obejmować blokowanie treści szkodliwych, filtrowanie danych wejściowych i monitorowanie wyników. Celem jest zapewnienie, że model pozostanie pomocny i bezpieczny w każdej sytuacji.

Wykorzystanie Modeli W Systemach

RAG

RAG (Retrieval-Augmented Generation) to połączenie modelu językowego z wyszukiwaniem informacji. Zamiast polegać wyłącznie na wiedzy zapisanej w parametrach, model pobiera aktualne dane z baz wiedzy, dokumentów lub wyszukiwarek. Odpowiedź powstaje na podstawie tego kontekstu, dzięki czemu jest bardziej precyzyjna i zgodna z faktami.

Wywoływanie narzędzi

Wywoływanie narzędzi to zdolność modelu do korzystania z zewnętrznych funkcji i usług – na przykład baz danych, kalkulatorów, API czy systemów wewnętrznych. Model może zainicjować zapytanie, otrzymać wynik i wykorzystać go w swojej odpowiedzi. Dzięki temu nie tylko „mówi”, ale też działa, wykonując konkretne operacje.

Pamięć rozmowy

Pamięć rozmowy to mechanizmy przechowywania kontekstu wcześniejszych interakcji. Dzięki niej model pamięta, o czym była mowa wcześniej, potrafi streszczać długie rozmowy i kontynuować dialog w sposób spójny. Pamięć może być krótko- lub długoterminowa, w zależności od systemu.

Stan

Stan to informacje, które są utrzymywane między kolejnymi wywołaniami modelu. Mogą to być dane użytkownika, historia rozmowy lub wyniki wcześniejszych działań. Stan wpływa na zachowanie modelu, pozwalając mu lepiej dostosowywać odpowiedzi do kontekstu i indywidualnych potrzeb użytkownika.

Ocena

Ocena (ang. evaluation) to proces mierzenia jakości odpowiedzi modelu. Obejmuje zarówno metody automatyczne (np. porównywanie tekstu z odpowiedzią wzorcową), jak i oceny ludzkie, które biorą pod uwagę sens, spójność czy styl. Dzięki regularnej ocenie można śledzić, czy model faktycznie spełnia swoje zadania i gdzie wymaga poprawy.

Monitorowanie

Monitorowanie to ciągłe śledzenie działania modeli po wdrożeniu. Obejmuje analizę jakości odpowiedzi, kosztów obliczeniowych, opóźnień i bezpieczeństwa. Dzięki monitorowaniu można szybko reagować na problemy, wykrywać błędy i dbać o to, by system pozostawał stabilny, wydajny i zgodny z założeniami.

Inżynieria Promptów

Rola

Rola to część wejścia, która określa, kim lub czym ma być model w danej rozmowie. Może wskazywać jego ton, styl, poziom wiedzy lub sposób reagowania. Na przykład można ustawić rolę „eksperta technicznego”, „nauczyciela języka” albo „asystenta projektowego”, by dopasować charakter odpowiedzi do potrzeb użytkownika.

Instrukcja systemowa

To fundament – opisuje ogólne zasady zachowania modelu w całej sesji. Definiuje jego osobowość, styl, poziom formalności, język i reguły bezpieczeństwa.

Warstwy meta (np. zarządzanie sesją, filtry, polityki bezpieczeństwa)

Poza samym modelem działają zewnętrzne moduły kontrolne – filtry bezpieczeństwa, detektory treści, polityki etyczne, cache kontekstu itp. To one egzekwują reguły, które nie są częścią modelu, ale wpływają na jego zachowanie.

Polecenie

Polecenie (ang. prompt) to główna treść zadania przekazywana modelowi. Może zawierać pytanie, opis sytuacji albo prośbę o wykonanie konkretnego działania. Jakość i precyzja polecenia mają ogromny wpływ na wynik – dobrze sformułowane prompt prowadzi do trafniejszej i bardziej użytecznej odpowiedzi.

Przykład few-shot

Przykład few-shot to kilka przykładów wejścia i wyjścia dodanych do promptu, które pokazują modelowi, jak ma reagować. Dzięki nim model lepiej rozumie kontekst i potrafi dopasować styl odpowiedzi. Na przykład można pokazać dwa krótkie przykłady pytań i pożądanych odpowiedzi, by ustabilizować zachowanie w kolejnym zadaniu.

Strategia zadawania zadań

Strategia zadawania zadań to sposób, w jaki formułuje się prompt, by prowadzić model do oczekiwanego rezultatu. Może obejmować instrukcje krok po kroku, wymagane formaty wyjścia (np. tabelę, kod, podsumowanie) albo prośby o cytaty i źródła. Dobrze dobrana strategia sprawia, że model działa bardziej przewidywalnie i skutecznie.

Wydajność I Inżynieria Obliczeń

GPU

GPU (Graphics Processing Unit) to procesor graficzny, który świetnie radzi sobie z równoległym przetwarzaniem dużych ilości danych. W uczeniu maszynowym używa się go do przyspieszania obliczeń tensorowych, czyli działań na macierzach i wektorach. Dzięki tysiącom rdzeni GPU znacznie skraca czas trenowania modeli.

Tensor

Tensor to wielowymiarowa tablica liczb, czyli sposób, w jaki sieci neuronowe zapisują i przetwarzają dane. Jest to pojęcie ogólne, które obejmuje zarówno proste, jak i bardzo złożone struktury matematyczne. Tensor pozwala przedstawić obrazy, teksty, dźwięki czy dane czasowe w postaci liczb, które można przetwarzać i analizować. To właśnie na tensorach wykonywane są wszystkie operacje obliczeniowe w uczeniu maszynowym – dodawanie, mnożenie, konwolucje czy propagacja gradientów.

Można wyróżnić kilka podstawowych rodzajów tensorów:

- Skalar – pojedyncza liczba, tensor zerowego rzędu.

- Wektor – lista liczb, tensor pierwszego rzędu.

- Macierz – tablica wierszy i kolumn, tensor drugiego rzędu.

- Tensor wyższego rzędu – struktura o więcej niż dwóch wymiarach, np. opisująca obraz (szerokość × wysokość × kolory) lub sekwencję danych w czasie.

Każdy tensor ma swój kształt (ang. shape), czyli informację o liczbie wymiarów i rozmiarze każdej osi, na przykład [batch_size, wysokość, szerokość, kanały] w przypadku obrazu albo [długość_sekwencji, rozmiar_wektora] dla tekstu.

W bibliotekach takich jak PyTorch i TensorFlow, tensory to specjalne obiekty, które przechowują dane (często w pamięci GPU) i umożliwiają automatyczne obliczanie gradientów potrzebnych do uczenia modeli. Dzięki nim sieć neuronowa może stopniowo poprawiać swoje wagi, ucząc się z danych. Tensor jest więc matematycznym fundamentem działania modeli – wspólnym językiem, w którym zapisany jest świat liczb, relacji i wzorców.

TPU

TPU (Tensor Processing Unit) to specjalny akcelerator stworzony przez Google do obliczeń macierzowych wykorzystywanych w sieciach neuronowych. Jest bardziej wyspecjalizowany niż GPU – jego architektura została zaprojektowana konkretnie pod operacje głębokiego uczenia, co pozwala uzyskać jeszcze większą wydajność przy trenowaniu dużych modeli.

Pamięć

Pamięć to ilość dostępnych zasobów do przechowywania parametrów modelu i pośrednich obliczeń. Każda warstwa i każde działanie zajmuje miejsce, więc ograniczona pamięć stanowi praktyczne ograniczenie rozmiaru modelu i wielkości partii danych (batch size).

Precyzja

Precyzja oznacza liczbę bitów, jaką model wykorzystuje do zapisu wartości liczbowych. Typowe formaty to 32-bitowe (FP32), 16-bitowe (FP16) lub 8-bitowe (INT8). Niższa precyzja zwiększa szybkość i zmniejsza zapotrzebowanie na pamięć, ale może pogarszać stabilność obliczeń, jeśli nie jest dobrze kontrolowana.

Mieszana precyzja

Mieszana precyzja (ang. mixed precision) to łączenie różnych poziomów precyzji w jednym treningu, zazwyczaj 16 i 32 bity. Dzięki temu można znacząco przyspieszyć obliczenia, zachowując przy tym stabilność numeryczną. To obecnie standardowa praktyka w treningu dużych modeli.

Kwantyzacja

Kwantyzacja to zamiana wag i aktywacji modelu na liczby o mniejszej precyzji, np. z 32 bitów na 8 bitów. Pozwala zmniejszyć rozmiar modelu i przyspieszyć jego działanie, często przy niewielkiej utracie dokładności. Stosuje się ją głównie podczas wdrażania (inferencji).

Przycinanie

Przycinanie (ang. pruning) to usuwanie wag o małych wartościach lub całych połączeń neuronów, które mają niewielki wpływ na wynik. W efekcie model staje się mniejszy, szybszy i bardziej energooszczędny, zachowując zbliżoną jakość predykcji.

Destylacja

Destylacja wiedzy (ang. knowledge distillation) to proces, w którym mniejszy model (uczeń) uczy się zachowania większego modelu (nauczyciela). Uczeń nie uczy się bezpośrednio z danych, lecz z odpowiedzi nauczyciela, co pozwala zachować dużą część jakości przy znacznie mniejszym rozmiarze i kosztach obliczeniowych.

Pamięć klucz-wartość

Pamięć klucz-wartość (ang. key-value cache) to bufor przechowujący wyniki uwagi z poprzednich kroków generacji. Dzięki temu model nie musi za każdym razem przeliczać całej sekwencji, co znacząco przyspiesza dekodowanie w modelach generatywnych.

Strumieniowanie

Strumieniowanie (ang. streaming) to generowanie i zwracanie części odpowiedzi na bieżąco, zamiast czekać, aż model wygeneruje całość. Poprawia to wrażenie szybkości i umożliwia interakcję w czasie rzeczywistym – użytkownik widzi, jak odpowiedź „pisze się” na ekranie.

Gradient clipping

Gradient clipping to ograniczanie wartości (normy) gradientu, by zapobiec zbyt dużym skokom w aktualizacji wag. Chroni to model przed niestabilnością w trakcie treningu, szczególnie w głębokich sieciach lub przy dużych szybkościach uczenia.

Gradient checkpointing

Gradient checkpointing to technika oszczędzania pamięci, która polega na tym, że część wyników pośrednich nie jest zapisywana, tylko ponownie przeliczana podczas wstecznej propagacji. Pozwala trenować większe modele na kartach o mniejszej pamięci kosztem dłuższego czasu obliczeń.

Warmup

Warmup to okres początkowy treningu, w którym szybkość uczenia stopniowo rośnie od niskiej do docelowej wartości. Zapobiega to niestabilnościom na początku nauki, gdy wagi są jeszcze losowe, i pozwala modelowi płynnie „rozpędzić się” do właściwego tempa uczenia.

Cosine decay

Cosine decay to harmonogram zmiany szybkości uczenia, w którym tempo maleje zgodnie z krzywą kosinusoidy. Umożliwia płynne spowalnianie nauki w miarę postępu treningu, co pomaga modelowi dopracować parametry bez gwałtownych zmian.

AdamW

AdamW to popularny optymalizator, który łączy adaptacyjne tempo uczenia (z algorytmu Adam) z lepszym sposobem regularyzacji wag. Jest stabilny, skuteczny i dobrze działa w dużych modelach, dlatego stał się standardem w uczeniu głębokim.

Lion

Lion to nowszy, lekki optymalizator, który opiera się na znakach gradientów zamiast ich pełnych wartości. Dzięki temu zużywa mniej pamięci i obliczeń, a w praktyce często trenuje modele szybciej niż AdamW, zachowując podobną jakość wyników.

Klasyczne Sieci, Widzenie, Audio

Konwolucje

Konwolucje to operacje, które przetwarzają dane lokalnie, wykrywając wzorce w ich strukturze. W przypadku obrazów analizują niewielkie fragmenty (okna) pikseli, dzięki czemu model uczy się rozpoznawać kształty, krawędzie i inne cechy wizualne. W sieciach konwolucyjnych (CNN) warstwy te są podstawą do zrozumienia zawartości obrazu bez konieczności analizowania każdego piksela oddzielnie.

Pooling

Pooling to proces zmniejszania wymiarów danych po konwolucji. Polega na łączeniu informacji z sąsiadujących fragmentów, na przykład przez wybór wartości maksymalnej (max pooling) lub średniej (average pooling). Dzięki temu model zachowuje najważniejsze cechy obrazu, a jednocześnie staje się szybszy i bardziej odporny na drobne przesunięcia czy zniekształcenia.

Autoenkoder

Autoenkoder to model uczący się kompresji i odtwarzania danych. Składa się z enkodera, który zamienia dane wejściowe w krótszy wektor (reprezentację ukrytą), oraz dekodera, który stara się z tej postaci odtworzyć oryginał. Autoenkodery są używane do redukcji wymiarów, usuwania szumów lub wykrywania anomalii.

Wariacyjny autoenkoder

Wariacyjny autoenkoder (VAE) to probabilistyczna wersja klasycznego autoenkodera, w której model uczy się nie pojedynczych reprezentacji, ale rozkładu prawdopodobieństwa w przestrzeni ukrytej. Dzięki temu może generować nowe dane – na przykład obrazy – podobne do tych z treningu, co czyni go jednym z fundamentów nowoczesnych modeli generatywnych.

Dyfuzja

Modele dyfuzyjne to generatywne modele uczące się procesu odszumiania danych. W treningu dodaje się do danych losowy szum, a model uczy się odwracać ten proces – czyli krok po kroku przekształcać losowy szum w realistyczny obraz lub dźwięk. Dzięki temu osiągają dziś najwyższą jakość w generowaniu treści wizualnych (np. DALL·E, Stable Diffusion).

Transformatory wizji

Transformatory wizji (Vision Transformers, ViT) to architektura, która przenosi pomysł mechanizmu uwagi z NLP do przetwarzania obrazów. Zamiast konwolucji, obrazy są dzielone na małe fragmenty (patches), które model analizuje równolegle, ucząc się zależności między nimi. Dzięki temu transformatory wizji potrafią wykrywać bardziej złożone wzorce i często przewyższają klasyczne CNN w dużych zadaniach wizualnych.

Słowniczek skrótów I Haseł

LLM

LLM (Large Language Model) to duży model językowy, uczony na ogromnych zbiorach tekstów. Dzięki milionom lub miliardom parametrów potrafi analizować, rozumieć i generować tekst w sposób zbliżony do ludzkiego. Stosowany jest w asystentach AI, tłumaczeniach, analizie danych czy generowaniu treści.

MoE

MoE (Mixture of Experts) to architektura, w której działa wiele „ekspertów”, czyli wyspecjalizowanych części modelu. Dla każdego przykładu aktywowany jest tylko wybrany fragment tych ekspertów, co pozwala osiągnąć wysoką wydajność przy niższym koszcie obliczeń.

Perplexity

Perplexity to miara jakości przewidywania tokenów przez model językowy. Określa, jak dobrze model przewiduje kolejne słowa w zdaniu. Im niższa wartość, tym lepszy model – oznacza to, że jego przewidywania są bardziej pewne i zgodne z rzeczywistym językiem.

Zero-shot

Zero-shot to rozwiązywanie zadania bez żadnych przykładów w promptach. Model korzysta wyłącznie ze swojej ogólnej wiedzy. Na przykład można poprosić go o tłumaczenie zdania, mimo że nie podano żadnych wcześniejszych przykładów tłumaczeń.

Few-shot

Few-shot to rozwiązywanie zadania na podstawie kilku przykładów zawartych w promptach. Pokazując modelowi kilka par „wejście–wyjście”, można go naprowadzić na właściwy sposób rozwiązania nowego, podobnego zadania.

Kontaminacja

Kontaminacja to przeciek danych testowych do zbioru treningowego. Powoduje, że ocena modelu staje się zafałszowana, ponieważ model może rozpoznawać znane wcześniej przykłady zamiast faktycznie uczyć się generalizacji.

Augmentacja

Augmentacja danych to sztuczne wzbogacanie zbioru treningowego – na przykład przez parafrazowanie zdań, tłumaczenie ich na inne języki lub dodawanie szumu do obrazów. Celem jest zwiększenie różnorodności danych i poprawa odporności modelu.

Curriculum

Curriculum learning to stopniowe zwiększanie trudności przykładów w trakcie treningu. Model najpierw uczy się prostych przypadków, a potem coraz trudniejszych, co ułatwia mu zrozumienie złożonych zależności.

GELU

GELU (Gaussian Error Linear Unit) to funkcja aktywacji często stosowana w transformerach. Działa płynniej niż klasyczny ReLU, co poprawia stabilność i jakość treningu.

ReLU

ReLU (Rectified Linear Unit) to prosta i szybka funkcja aktywacji, która przepuszcza tylko dodatnie wartości. Dzięki swojej efektywności jest jedną z najczęściej używanych w sieciach neuronowych.

SwiGLU

SwiGLU to nowsza funkcja aktywacji, łącząca mechanizm bramkowania (gating) z nieliniowością. Poprawia wydajność bloków feed-forward w transformerach, czyniąc modele bardziej ekspresyjne i stabilne.

Layer Norm

Layer Norm (Layer Normalization) to normalizacja w obrębie cech pojedynczej próbki, a nie całej partii. Pomaga utrzymać stabilne wartości aktywacji i przyspiesza uczenie, szczególnie w modelach sekwencyjnych i transformatorach.

RMS Norm

RMS Norm (Root Mean Square Normalization) to wariant normalizacji oparty na średnim kwadracie wartości, zamiast odchylenia standardowego. Bywa stabilniejszy w bardzo dużych modelach i często używany w nowych architekturach.

Instrukcja systemowa

Instrukcja systemowa (ang. system prompt) to część wejścia definiująca ogólne reguły i styl działania modelu. Określa język, ton, sposób interpretacji poleceń oraz zasady bezpieczeństwa. Jest fundamentem zachowania modelu w całej sesji.

Format odpowiedzi

Format odpowiedzi to ustalony sposób prezentacji wyników, na przykład w postaci tekstu, listy, JSON-a lub markdownu. Pomaga uzyskać spójne i łatwe do przetworzenia odpowiedzi, szczególnie gdy model ma współpracować z innymi systemami.

Raterzy

Raterzy to ludzie oceniający odpowiedzi modeli podczas treningu lub ewaluacji. Ich oceny służą do tworzenia modeli nagrody w RLHF oraz do poprawy jakości i zgodności modeli z ludzkimi preferencjami.

Grounding

Grounding (ugruntowanie) to zakotwiczenie odpowiedzi w wiarygodnych źródłach lub dokumentach. Oznacza, że model nie tylko generuje treść, ale także potrafi wskazać, skąd pochodzą dane informacje, co zwiększa ich wiarygodność i możliwość weryfikacji.