Modele językowe, takie jak GPT, potrafią generować teksty, podsumowania czy analizy na imponującym poziomie. Ich ograniczeniem jest jednak to, że działają w oparciu o dane, na których zostały wytrenowane, a więc nie mają dostępu do Twoich aktualnych dokumentów, projektów czy wewnętrznych materiałów. Tu wkracza RAG, czyli Retrieval-Augmented Generation: podejście, które łączy siłę modelu językowego z Twoją prywatną bazą wiedzy.

W wielu przypadkach, wystarczy do danego modelu językowego załadować swoje pliki, Notebook LM pozwala zarządzać wieloma plikami, a tryb projektów w Chat GPT pozwala wielu wątkom korzystać z tych samych plików. W przypadku prostych zagadnień, tworzenie RAG-u nie jest konieczne, natomiast tam gdzie chcemy korzystać z setek plików, bardziej złożone rozwiązania są niezbędne.

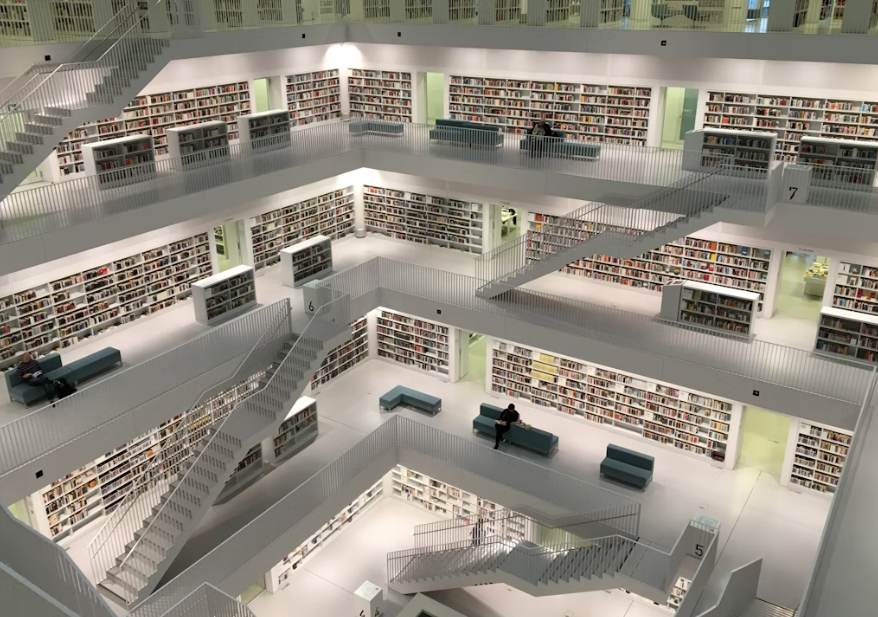

Dzięki RAG-owi możesz stworzyć własnego asystenta AI, który nie tylko „zna” ogólną wiedzę, ale też potrafi odpowiadać w oparciu o Twoje dane. Może analizować raporty firmowe, dokumentację projektów, notatki, a nawet pliki PDF, i generować odpowiedzi oparte na tych treściach.

Spis treści

Czym właściwie jest RAG

Łączenie dwóch światów

RAG to połączenie dwóch elementów:

- Retrieval — część odpowiedzialna za wyszukiwanie informacji.

Zamiast trenować model od nowa, RAG wykorzystuje wyszukiwarkę (np. bazę wektorową), by znaleźć fragmenty tekstu najbardziej pasujące do pytania użytkownika. - Augmented Generation — część generatywna.

Model językowy (np. GPT-4 lub Claude) otrzymuje te znalezione fragmenty jako kontekst i na ich podstawie tworzy odpowiedź.

W efekcie RAG nie „zgaduje” jak klasyczny chatbot, tylko odpowiada w oparciu o realne źródła danych, które Ty kontrolujesz.

Jak to działa krok po kroku

- Użytkownik zadaje pytanie (np. „Jakie były wyniki sprzedaży w Q3?”).

- System wyszukuje najbardziej trafne fragmenty z Twoich dokumentów.

- Model językowy łączy te dane i generuje odpowiedź w naturalnym języku.

Dzięki temu AI może działać jak Twój prywatny analityk, konsultant lub asystent biurowy.

RAG a pliki w wątku Chat GPT, pliki w projektach, czy w Notebook LM

Czym są projekty ChatGPT?

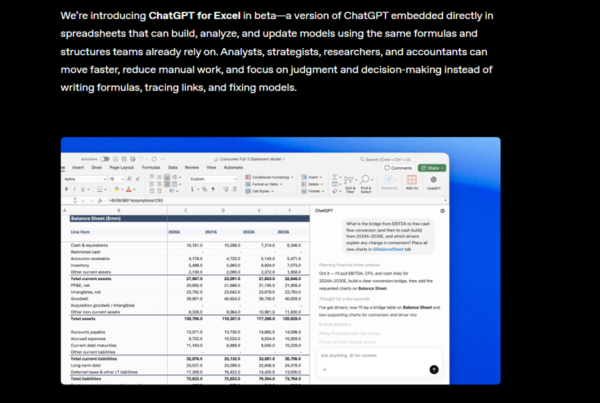

Tryb Projektów w ChatGPT pozwala przypisać zestaw plików do konkretnego projektu, tak aby model mógł z nich korzystać w wielu wątkach. To wygodne rozwiązanie dla użytkowników, którzy chcą mieć stały dostęp do własnych materiałów, bez konieczności ich ponownego przesyłania. Model potrafi analizować dokumenty, wyszukiwać w nich informacje i tworzyć odpowiedzi na podstawie zawartej treści, co sprawia, że praca z większymi zbiorami danych jest znacznie szybsza i bardziej spójna.

Jak działa RAG?

System Retrieval-Augmented Generation (RAG) działa na podobnej zasadzie, lecz w znacznie bardziej elastyczny sposób. W tym podejściu dane są przechowywane w zewnętrznej bazie (np. Weaviate, Milvus, Pinecone), która umożliwia ich przeszukiwanie na poziomie semantycznym. Model językowy pobiera wtedy tylko te fragmenty tekstu, które są najbardziej adekwatne do pytania użytkownika, a następnie generuje odpowiedź na ich podstawie. Dzięki temu baza wiedzy może być dynamicznie aktualizowana i rozbudowywana bez potrzeby ponownego trenowania modelu.

Główne różnice między projektami a RAG

Struktura i kontrola danych

W projektach ChatGPT dane są przechowywane w zamkniętym środowisku OpenAI, a użytkownik nie ma bezpośredniego wpływu na sposób ich indeksowania. W systemie RAG kontrola jest pełna — można decydować, jak dane są przechowywane, przetwarzane i wyszukiwane, a także dodawać własne metadane i reguły filtrowania.

Skalowalność i integracje

Projekty są idealne do pracy z niewielkimi zbiorami dokumentów, natomiast RAG pozwala obsługiwać tysiące lub miliony plików oraz integrować się z zewnętrznymi systemami, takimi jak CRM, bazy wiedzy czy serwisy API.

Aktualizacja danych

W projektach pliki trzeba aktualizować ręcznie. W RAG można ten proces zautomatyzować, aby baza wiedzy była stale uzupełniana o nowe treści.

Dostosowanie zachowania modelu

RAG pozwala regulować sposób wyszukiwania kontekstu (np. semantycznie, słownikowo, według źródła), a nawet wprowadzać filtry i wagi dla poszczególnych dokumentów. W projektach ChatGPT ten proces jest całkowicie ukryty przed użytkownikiem.

Kiedy warto wybrać które rozwiązanie?

| Sytuacja | Lepsze rozwiązanie |

|---|---|

| Chcesz szybko połączyć kilka plików i korzystać z nich w rozmowach | Projekt ChatGPT |

| Potrzebujesz własnego systemu wiedzy z aktualizacjami i integracjami | RAG |

| Zależy Ci na prywatności i kontroli nad danymi | RAG |

| Chcesz wygodnie analizować kilka dokumentów bez konfiguracji | Projekt ChatGPT |

Dlaczego warto zbudować własny system RAG

Aktualność danych

RAG umożliwia korzystanie z najnowszych dokumentów, bez potrzeby trenowania nowego modelu. Wystarczy dodać plik, a system od razu zacznie go wykorzystywać.

Prywatność i kontrola

Twoje dane pozostają pod Twoją kontrolą — nie są wysyłane do publicznego modelu ani włączane w jego trening. To ważne, jeśli pracujesz na poufnych informacjach.

Elastyczność

System można dostosować do dowolnego kontekstu: może służyć jako asystent do obsługi klientów, narzędzie do przeszukiwania dokumentacji technicznej lub baza wiedzy dla zespołu.

Jak przygotować dane do RAG

Zbierz i uporządkuj dokumenty

Zacznij od zebrania materiałów, które mają stanowić Twoją bazę wiedzy. Mogą to być:

- pliki PDF i DOCX,

- notatki tekstowe,

- dokumentacja projektów,

- instrukcje, raporty i e-maile.

Najlepiej, jeśli dokumenty są uporządkowane tematycznie i logicznie. Każdy powinien mieć tytuł i zawierać spójną treść — system łatwiej wtedy dzieli je na fragmenty.

Podziel dokumenty na mniejsze części

RAG działa na tzw. chunkach, czyli fragmentach tekstu o długości np. 300–1000 słów.

Dlaczego? Bo modele lepiej radzą sobie z krótszymi kontekstami. Jeśli masz długi raport, warto go podzielić na rozdziały lub sekcje.

Ujednolić format danych

Przed importem warto przekonwertować wszystko do prostego formatu tekstowego (np. .txt lub .md).

Niektóre narzędzia potrafią automatycznie przetwarzać PDF-y czy Wordy, ale czysty tekst jest zawsze najpewniejszy.

Jak działa wektoryzacja

Co to znaczy „zamienić tekst na wektory”

Wektoryzacja to proces przekształcania fragmentów tekstu w liczby (wektory), które odzwierciedlają znaczenie treści. Dzięki temu komputer potrafi „zrozumieć”, że zdania o podobnym sensie mają bliskie wartości numeryczne.

Przykład:

„Jak działa fakturowanie w systemie?”

i

„Na czym polega proces wystawiania faktur?”

Po wektoryzacji oba zdania będą miały bardzo zbliżone reprezentacje.

Wektorowe bazy danych

Takie wektory są przechowywane w specjalnych bazach danych, zwanych wektorowymi. Najpopularniejsze z nich to:

- FAISS (Facebook AI Similarity Search) — szybka i darmowa biblioteka open-source,

- Weaviate — platforma z gotowym interfejsem API,

- Milvus — wydajna baza do dużych zbiorów danych,

- Pinecone — rozwiązanie chmurowe, często używane w aplikacjach produkcyjnych.

Tworzenie własnego RAG — krok po kroku

Krok 1. Przygotuj dane

Zbierz dokumenty, uporządkuj je i podziel na fragmenty. Jeśli masz np. 20 plików po kilka stron każdy, system zamieni je na dziesiątki „kawałków” tekstu, które później będzie łatwiej przeszukiwać.

Krok 2. Wektoryzuj dane

Użyj jednego z narzędzi do wektoryzacji, np.:

- LangChain — framework w Pythonie, który automatyzuje cały proces,

- LlamaIndex (dawniej GPT Index) — idealny do prostych integracji,

- OpenAI embeddings API — pozwala tworzyć wektory bez konieczności instalacji czegokolwiek lokalnie.

Proces wektoryzacji wygląda mniej więcej tak:

- Wczytujesz dokument.

- Dzielisz go na fragmenty.

- Każdy fragment przetwarzasz przez model embeddingowy (np.

text-embedding-3-large). - Wynik zapisujesz w bazie wektorowej.

Krok 3. Stwórz warstwę wyszukiwania (retrieval)

To kluczowy element. Gdy użytkownik zada pytanie, system musi znaleźć najtrafniejsze fragmenty w Twojej bazie.

W tym celu wyszukiwanie odbywa się poprzez porównanie wektora pytania z wektorami Twoich dokumentów.

Wyniki są sortowane według podobieństwa semantycznego.

Krok 4. Połącz wszystko z modelem językowym

Teraz integrujesz retrieval z modelem generatywnym.

Najprościej:

- wyszukane fragmenty przekazujesz jako kontekst do modelu,

- model tworzy odpowiedź, korzystając z tej wiedzy.

W LangChain czy LlamaIndex można to zrobić kilkoma linijkami kodu.

Przykładowy pseudokod:

query = "Jak działa system rezerwacji?"

context = retriever.get_relevant_documents(query)

response = llm.generate_answer(context + query)

print(response)

Jak dodać nowe dane do systemu

Kiedy chcesz dodać nowe pliki, nie musisz przebudowywać wszystkiego od nowa.

Wystarczy wektoryzować tylko nowe fragmenty i dodać je do bazy.

Stare dane pozostają nietknięte, więc proces jest szybki i skalowalny.

Jak przetestować swój system RAG

Prosty test funkcjonalny

Zadaj pytania, na które odpowiedzi znajdują się w Twoich dokumentach, np.:

„Kiedy został wprowadzony nowy regulamin?”

„Jak wygląda proces onboardingu?”

Jeśli model odpowiada precyzyjnie i cytuje treści z Twojej bazy, wszystko działa poprawnie.

Ocena jakości wyników

Warto sprawdzić:

- czy model wybiera właściwe fragmenty (tzw. recall),

- czy generuje odpowiedzi zgodne z dokumentami (tzw. precision),

- czy nie „zmyśla” danych, gdy nie ma ich w bazie.

Jak utrzymywać i rozwijać RAG

Regularne aktualizacje

Im częściej dodajesz nowe dokumenty, tym bardziej aktualne są odpowiedzi.

Można ustawić automatyczny proces, który raz w tygodniu skanuje katalog i wektoryzuje nowe pliki.

Monitoring

Dobrze jest zapisywać pytania użytkowników oraz to, czy odpowiedź była trafna.

Dzięki temu można stopniowo ulepszać system, np. dodając brakujące dokumenty lub poprawiając indeksowanie.

Skalowanie

Jeśli baza rośnie, możesz przejść z lokalnej instalacji FAISS na chmurowe rozwiązanie, np. Weaviate Cloud albo Pinecone.

Dzięki temu wyszukiwanie pozostanie szybkie, nawet przy tysiącach dokumentów.

Typowe błędy przy budowie RAG

Zbyt duże fragmenty tekstu

Jeśli system przetwarza bardzo długie bloki (np. całe rozdziały), model może gubić sens i zwracać nieprecyzyjne odpowiedzi.

Lepiej dzielić teksty na mniejsze kawałki.

Dane niskiej jakości

Niechlujne, nieaktualne lub powtarzające się treści obniżają jakość wyszukiwania.

Zadbaj o to, by Twoje dane były spójne i przejrzyste.

Brak testów

Bez testowania systemu trudno ocenić, czy działa poprawnie.

Warto stworzyć kilka przykładowych pytań kontrolnych i regularnie je sprawdzać.

Przykładowe zastosowania RAG

- Asystent firmowy — odpowiada na pytania o regulaminy, produkty i procedury.

- System wsparcia technicznego — automatycznie przeszukuje dokumentację i podaje gotowe rozwiązania.

- Narzędzie dla zespołów sprzedaży — błyskawicznie wyszukuje informacje o ofertach, klientach i historii kontaktów.

- Wewnętrzna baza wiedzy — zamienia rozproszone pliki w jeden spójny system odpowiedzi.

Potencjalne problemy przy używaniu RAG

1. Jakość i spójność danych źródłowych:

Jeśli dokumenty, które wrzucasz, są niespójne, nieaktualne albo słabo zorganizowane, to model może mieć problem z dobieraniem odpowiedniego kontekstu. W efekcie odpowiedzi mogą być mniej trafne. To znaczy, że jakość tego, co wrzucisz, naprawdę wpływa na jakość odpowiedzi.

2. Odpowiednie strojenie i dostrojenie systemu:

Czasami trzeba trochę poeksperymentować z parametrami wyszukiwania albo z samym sposobem, w jaki model wybiera kontekst. Jeśli te ustawienia nie są dobrze dobrane, RAG może nie zwracać najbardziej odpowiednich fragmentów.

3. Wydajność i zasoby:

Jeśli masz bardzo dużą bazę danych, to wyszukiwanie może być trochę wolniejsze, zwłaszcza na mniej wydajnym sprzęcie. Czasami trzeba zadbać o optymalizację albo skorzystać z mocniejszej infrastruktury, jeśli tych plików jest naprawdę dużo.

4. Problemy z aktualizacją:

Chociaż dodawanie nowych plików jest dość proste, to jednak trzeba pamiętać o regularnej aktualizacji bazy. Jeśli zapomnisz dodać nowe dane, model może pracować na nieaktualnych informacjach, co może obniżyć jakość odpowiedzi.

5. Złożoność integracji:

Na początku, jeśli ktoś nie jest przyzwyczajony do takich narzędzi, sama konfiguracja może wydawać się trochę skomplikowana. Trzeba zrozumieć, jak działa baza wektorowa i jak ją podłączyć do modelu. To może być wyzwanie na samym starcie.

Co oznacza dobra jakość danych dla RAG

W systemach RAG jakość nie wynika wyłącznie z mocy modelu językowego. To efekt czterech równie ważnych elementów: sposobu dzielenia danych, doboru modelu embeddingowego, jakości promptu i spójności metadanych. Każdy z nich bezpośrednio wpływa na precyzję odpowiedzi oraz to, czy system faktycznie rozumie Twoje dane.

Prawidłowe dzielenie na fragmenty z zachowaniem kontekstu

Dobre fragmentowanie tekstu (tzw. chunking) polega na takim podziale dokumentów, by model nie tracił znaczenia całości. Fragmenty nie powinny być zbyt długie, bo model może zgubić sens, ani zbyt krótkie, bo stracą kontekst.

Praktyczna zasada mówi: około 300–1000 słów na fragment, z lekkim nakładaniem się treści (tzw. overlap), by zachować ciągłość zdania i logiki.

Na przykład, jeśli rozdział kończy się zdaniem „W kolejnym kroku omówimy proces płatności…”, to ten fragment powinien zaczynać się również w kolejnym chunku. Dzięki temu system potrafi logicznie połączyć te informacje w odpowiedzi.

Trafne wyszukiwanie – dobór modelu embeddingowego i wartości k

To, jak system RAG znajduje kontekst, zależy od jakości embeddingów, czyli reprezentacji tekstu w formie liczb. Model embeddingowy musi być dopasowany do języka, typu dokumentów i poziomu szczegółowości.

- Do danych technicznych dobrze sprawdzają się modele typu

text-embedding-3-large. - Dla prostszych tekstów wystarczy mniejszy model, który działa szybciej i taniej.

Parametr k określa, ile fragmentów system pobiera z bazy, by przygotować odpowiedź. Zbyt niskie k może spowodować pominięcie ważnych kontekstów, zbyt wysokie – przeciążenie modelem nadmiarem danych.

Optymalne wartości to k = 3–7 dla małych baz i k = 10–20 dla dużych.

Przejrzysty prompt z instrukcją cytowania

Prompt to szkielet rozmowy między Tobą a modelem. Jeśli jest nieprecyzyjny, nawet najlepsze dane nie zagwarantują jakości.

Dobry prompt w systemie RAG powinien:

- Wyraźnie nakazywać oparcie odpowiedzi tylko na dostarczonym kontekście.

- Wymuszać cytowanie źródeł, np. poprzez:

„Podaj odpowiedź wyłącznie na podstawie kontekstu. Jeśli nie ma wystarczających informacji, powiedz: ‘brak danych’. Na końcu wypisz źródła w nawiasach kwadratowych.” - Być prosty i powtarzalny, aby model nie interpretował instrukcji inaczej za każdym razem.

Dzięki temu odpowiedzi są spójne, wiarygodne i można łatwo sprawdzić, z jakich dokumentów pochodzą.

Spójne metadane – tytuł, rozdział, wersja dokumentu

Metadane to ukryte informacje, które pozwalają zrozumieć kontekst dokumentu. Dobrze zaprojektowane metadane to klucz do jakości wyszukiwania i interpretacji.

Każdy dokument powinien mieć:

- Tytuł – jednoznaczny i opisowy, np. „Polityka prywatności – wersja 2025.01”.

- Rozdział lub dział – wskazujący obszar tematyczny („Kadry”, „Rezerwacje”, „Bezpieczeństwo IT”).

- Wersję dokumentu – dzięki temu system może odrzucać nieaktualne dane i preferować najnowsze.

Spójność metadanych pozwala filtrować wyniki i uniknąć błędnych odpowiedzi, np. gdy dwie wersje regulaminu różnią się tylko jednym akapitem. W praktyce dobrze zaprojektowana struktura metadanych sprawia, że RAG staje się nie tylko wyszukiwarką, ale też systemem kontroli wersji wiedzy.

Podsumowanie

RAG to jeden z najprostszych sposobów, aby przekształcić statyczne dokumenty w inteligentny system wiedzy.

Nie wymaga trenowania modeli ani dużej infrastruktury — wystarczy dobra organizacja danych i kilka narzędzi open-source.

Kiedy raz go uruchomisz, staje się Twoim własnym, prywatnym ChatGPT, który zna wszystkie Twoje materiały, pamięta kontekst i zawsze korzysta z najnowszych informacji.