Podstawą działania modeli językowych jest rozpoznawanie powiązań między tokenami, czyli najmniejszymi jednostkami tekstu. Każde słowo ma swoje miejsce w wielowymiarowej przestrzeni liczb, a na podstawie tych relacji model potrafi przewidywać kolejne słowa i tworzyć całe zdania.

Jak jednak model „wie”, że „kot” jest bliżej „psa” niż „komputera”? Albo że związek między „Niemcami” i „Bratwurst” przypomina relację między „Japonia” i „sushi”?

Nie ma tu żadnej magii ani ręcznego ustawiania. Na początku wszystkie parametry są losowe; model niczego nie rozumie, a słowa są w przestrzeni rozmieszczone przypadkowo. To czysty chaos.

Z czasem jednak, dzięki procesowi uczenia, sieć zaczyna odkrywać wzory: zauważa, że po „dobry” często występuje „dzień”, a po „grać w” zwykle pojawia się „piłkę nożną”.

Jak to możliwe, że z losowych liczb powstaje zrozumienie języka?

Odpowiedź tkwi w trzech pojęciach: parametrach, tokenach i propagacji wstecznej czyli podstawach współczesnej sztucznej inteligencji.

Spis treści

Jak działa model językowy (w skrócie)

Model językowy przewiduje prawdopodobieństwo kolejnych słów na podstawie relacji między tokenami, czyli najmniejszymi jednostkami tekstu. Każde słowo ma swoje miejsce w wielowymiarowej przestrzeni liczb – jeśli dwa słowa często występują razem, ich punkty znajdują się blisko siebie. Dzięki temu model potrafi przewidzieć, że po „Kupiłem piłkę i poszedłem grać w…” najprawdopodobniej pojawi się „piłkę nożną”.

Cała wiedza modelu jest zakodowana w tych relacjach między słowami. Nie istnieją w nim gotowe fakty ani zdania – wszystko jest zapisane w postaci matematycznych powiązań między tysiącami parametrów. Dlatego trudno jednoznacznie stwierdzić, co model „wie”. Nie możemy w nim znaleźć jednego miejsca, które mówi, że woda wrze w 100°C – ta informacja jest rozproszona w zależnościach między słowami woda, ciepło, temperatura.

Aby uzupełnić tę ograniczoną „pamięć wewnętrzną”, coraz częściej stosuje się systemy RAG (Retrieval-Augmented Generation). Pozwalają one modelowi korzystać z zewnętrznych baz wiedzy – wyszukiwać aktualne informacje i włączać je do odpowiedzi. Dzięki temu model nie tylko rozumie język, ale potrafi też odwoływać się do realnych danych, łącząc rozumienie kontekstu z faktami.

Co to jest token

Token to najmniejsza jednostka tekstu, jaką model potrafi rozpoznać. W zależności od konfiguracji może to być:

- całe słowo („dom”, „pies”),

- fragment słowa („pił”, „ka”),

- lub nawet znak interpunkcyjny.

Model nie widzi więc zdań w całości – widzi ciągi tokenów. Każdy z nich reprezentowany jest jako wektor, czyli zestaw liczb opisujących jego „położenie” w przestrzeni znaczeń.

Na początku ta przestrzeń jest przypadkowa. Współrzędne każdego tokena są po prostu lsoowe Token „piłka” nie ma nic wspólnego z tokenem „sport”. Dopiero trening sprawia, że ich reprezentacje zaczynają zbliżać się do siebie w sensie matematycznym, co w praktyce oznacza, że model rozpoznaje podobieństwo znaczeń.

Czym są parametry

Każdy model językowy ma miliony, a często miliardy parametrów. Są to liczby, które określają, jak silne jest połączenie między poszczególnymi tokenami.

Można powiedzieć, że parametry to „pamięć” modelu. To właśnie w nich zapisane są wszystkie wzorce językowe, skojarzenia i struktury gramatyczne, których model nauczył się podczas treningu.

Na przykład:

- Jeśli model widzi często parę „Kupiłem piłkę i poszedłem grać w…”, to jego parametry zostaną dostrojone tak, aby w przyszłości przewidywać, że kolejnym słowem będzie coś w rodzaju „piłkę nożną” lub „football”.

- Jeśli w zdaniach technicznych często pojawia się „błąd kompilacji”, model nauczy się, że słowo „kompilacja” ma związek z kodem i komputerami, a nie ze sportem czy kuchnią.

Jak model uczy się poprawnych odpowiedzi

Proces nauki polega na tym, że model dostaje zadanie przewidywania brakującego słowa w zdaniu. To podstawowy sposób trenowania dużych modeli językowych.

Przykład:

„Kupiłem piłkę i poszedłem grać w ___.”

Model musi odgadnąć, co pasuje w puste miejsce. Jeśli poda „piłkę nożną” lub „football”, dostaje punkt. Jeśli wybierze „szachy” – myli się.

Ta różnica między poprawną a błędną odpowiedzią nazywa się błędem (loss). To sygnał, który informuje model, jak daleko jest od prawdy.

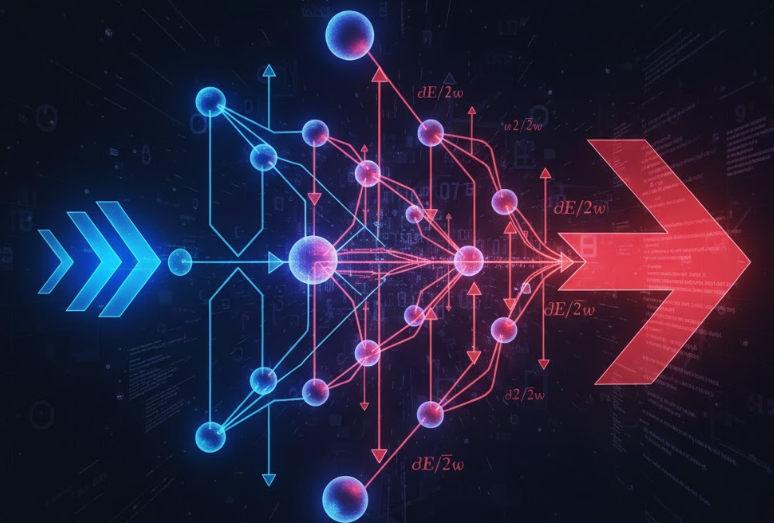

Czym jest propagacja wsteczna (backpropagation)

Aby poprawić się po błędzie, model używa mechanizmu propagacji wstecznej. Można to porównać do procesu nauki człowieka: najpierw próbujesz, potem widzisz, co poszło źle, a następnie korygujesz swoje podejście.

W przypadku sieci neuronowej wygląda to tak:

- Model dokonuje prognozy (np. „szachy” zamiast „piłkę nożną”).

- Obliczany jest błąd (różnica między przewidywaniem a rzeczywistą odpowiedzią).

- Błąd „przepływa” wstecz przez warstwy sieci, wskazując, które parametry należy lekko zmienić.

- Wagi neuronów zostają zaktualizowane – o malutki krok w stronę lepszego wyniku.

Ten cykl powtarza się miliardy razy. W efekcie parametry modelu stają się coraz bardziej dopasowane do rzeczywistości językowej.

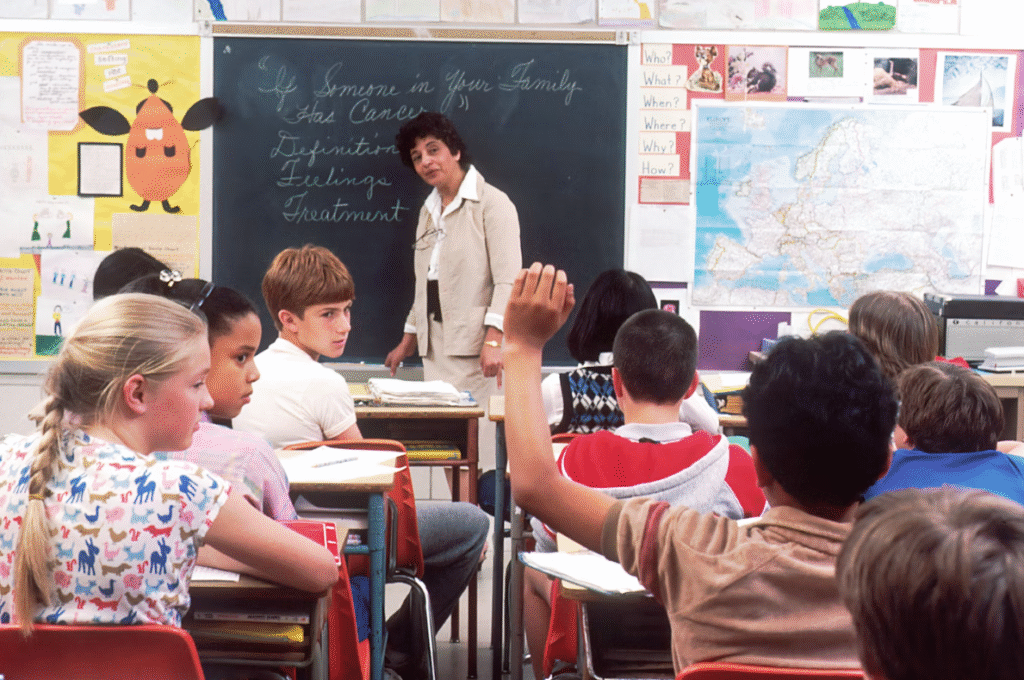

Najprostsza analogia: nauczyciel i uczeń

Wyobraź sobie ucznia, który uczy się nowego języka. Pisze zdanie: „I go football play.” Nauczyciel mówi: „Nie, powinno być I play football.” Uczeń zapamiętuje tę poprawkę.

W modelu dzieje się coś bardzo podobnego: backpropagacja pełni rolę nauczyciela, który pokazuje, w którą stronę model powinien się poprawić. Ale zamiast słów używa równań i gradientów – miar tego, jak zmiana jednego parametru wpływa na wynik.

Choć lepszym przykładem może być np. strzelanie z łuku. Po wystrzeleniu strzały, porównuję się odległość strzały od celu. Jeśli trafiliśmy zbyt nisko, konieczne jest wycelowanie wyżej. To jak bardzo podniesiemy łuk, to właśnie współczynnik uczenia.

Prosty przykład matematyczny.

Zróbmy bardzo prosty eksperyment. Wyobraźmy sobie miniaturową sieć neuronową, która ma nauczyć się prostej zależności:

y=2x, czyli:

Wyjście = 2 × wejście

czyli: jeśli podajemy 1, powinniśmy dostać 2; jeśli podajemy 2, powinniśmy dostać 4 itd.

Krok 1. Inicjalizacja

Niech:

- w = 0.5 (waga połączenia, losowo wybrany parametr)

- η = 0.1 (współczynnik uczenia), arbitralnie wybrana liczba. Zbyt niska, sprawia że model uczy się za wolno, zbyt wysoka sprawia że poprawka będzie zbyt duża, i model nigdy się nie nauczy.

- wejście x = 1,

- oczekiwane wyjście y_true = 2.

Na początku sieć nie wie, jak to działa.

Krok 2. Przepływ w przód (forward pass)

Model oblicza wynik:

y_pred = x × w = 1 × 0.5 = 0.5

Błąd to różnica między wynikiem a prawdą:

Loss = (y_true − y_pred)² = (2 − 0.5)² = 2.25

Krok 3. Przepływ wstecz (backward pass)

Teraz musimy obliczyć, jak zmienić wagę, aby zmniejszyć błąd.

Obliczamy pochodną błędu względem wagi:

dE/dw = 2 × (y_pred − y_true) × x

dE/dw = 2 × (0.5 − 2) × 1 = −3

To mówi nam, że zmniejszenie błędu wymaga zwiększenia wagi, bo gradient jest ujemny.

Krok 4. Aktualizacja wagi

Nowa wartość w:

w_new = w − η × dE/dw

w_new = 0.5 − 0.1 × (−3) = 0.8

Krok 5. Kolejne przewidywanie

Powtarzamy obliczenia:

y_pred = 1 × 0.8 = 0.8

Loss = (2 − 0.8)² = 1.44

Błąd się zmniejszył! Wystarczy kilkanaście takich iteracji, by sieć zbliżyła się do prawidłowego rozwiązania w ≈ 2.

Intuicja matematyczna

Równanie aktualizacji wag:

w ← w − η × ∂E/∂w

to sedno uczenia się w sztucznej inteligencji. Symbol ∂E/∂w (czytaj: „pochodna błędu po wadze”) mówi, jak bardzo zmiana danej wagi wpływa na całkowity błąd.

Dzięki temu model nie zgaduje na ślepo, lecz uczy się kierunkowo – zawsze w stronę mniejszego błędu.

Uczenie się w miliardach wymiarów

W powyższym przykładzie mieliśmy tylko jedną wagę. W rzeczywistości modele językowe mają miliardy wag, a więc i miliardy takich równań. Każda z nich jest aktualizowana po każdym kroku treningu.

Sieć tworzy w ten sposób ogromny, wielowymiarowy krajobraz, w którym szuka najniższego punktu błędu – miejsca, w którym najlepiej odwzorowuje prawidłowości w danych językowych.

Backpropagacja przy uczeniu modelu językowego.

Z matematycznego punktu widzenia model robi tylko jedno: przekształca liczby według wzoru.

Z ludzkiego punktu widzenia robi coś znacznie głębszego – uczy się znaczeń.

W wcześniejszym przykładzie użyłem samych liczb, dzięki czemu łatwiej można zrozumieć działanie backpropagacji. W przypadku modeli, zamiast liczb, stosuje się słowa (które potem program zamienia na liczby).

Przykładowo, model językowy dostaje za zadanie dokończyć zdanie, np.: „Kot wszedł na…”

Jeśli model korzysta z całkowicie losowych parametrów, to może napisać np.: Kot wszedł na … Ekumenizm”. Następnie odpowiedź jest porównywana z modelową odpowiedzią, czyli „Kot wszedł na drzewo”, obliczany jest błąd, i liczona jest aktualizacja wag.

Po miliardach iteracji model zaczyna rozumieć, że:

- słowa „piłka” i „bramka” często występują razem,

- „dzień dobry” jest powitaniem, a nie pytaniem,

- po „bo” zwykle występuje przyczyna.

Te regularności nie są zaprogramowane – model odkrywa je sam, analizując statystyki w danych. Każda poprawka wag przybliża go do świata ludzkiego języka.

Co dzieje się z tokenami

Tokeny są punktem wyjścia, ale po treningu stają się czymś znacznie więcej. Ich reprezentacje (wektory) zyskują strukturę semantyczną.

W przestrzeni modelu:

- „kot”, „pies”, „królik” są blisko siebie,

- „stół” i „krzesło” tworzą inną grupę,

- „piękny”, „brzydki” i „średni” leżą na wspólnej osi opisującej estetykę.

Matematycznie oznacza to, że odległości między wektorami mają sens semantyczny.

Różnica między „król” a „królowa” jest podobna do różnicy między „mężczyzna” a „kobieta” – i to nie dlatego, że ktoś to zaprogramował, lecz dlatego, że model sam odkrył wzorce w danych.

Jak to wygląda w praktyce

W modelach takich jak GPT czy Gemini proces uczenia trwa miesiącami. Setki tysięcy procesorów analizują ogromne zbiory tekstów: książki, artykuły, strony internetowe, dialogi.

Każdy token jest analizowany w kontekście innych tokenów. Model oblicza prawdopodobieństwo, że po danym ciągu słów pojawi się kolejne słowo.

To trochę jakby uczeń przeczytał cały internet i przy każdym zdaniu zapisał, co najczęściej występuje po czym. Backpropagacja sprawia, że z każdą pomyłką jego wewnętrzne mapy znaczeń stają się coraz dokładniejsze.

Dlaczego to działa tak dobrze

Zaskakujące jest to, że mimo prostoty matematycznej, backpropagacja i uczenie przez przewidywanie kontekstu prowadzą do powstania czegoś, co przypomina rozumienie.

Model nie ma świadomości, ale potrafi:

- streszczać teksty,

- odpowiadać logicznie na pytania,

- wykrywać sprzeczności,

- a nawet pisać poezję.

To możliwe, ponieważ język jest systemem pełnym regularności, a sieci neuronowe są mistrzami w odkrywaniu regularności ukrytych w danych.

Gdzie kończy się matematyka, a zaczyna intuicja

Warto zrozumieć, że wszystkie te procesy – wagi, gradienty, tokeny – to tylko narzędzia. Ich zadaniem nie jest „rozumienie” w sensie ludzkim, lecz modelowanie prawdopodobieństwa: jakie słowo najczęściej występuje po innym.

Jednak z punktu widzenia użytkownika efekt jest zadziwiający. Model, który zaczynał od losowych liczb, potrafi prowadzić sensowną rozmowę, tłumaczyć zawiłe pojęcia i dopasowywać ton wypowiedzi do kontekstu.

Podsumowanie

- Tokeny to najmniejsze jednostki języka w modelu – liczby opisujące fragmenty tekstu.

- Parametry (wagi i biasy) określają, jak silnie neurony reagują na te tokeny i ich wzajemne powiązania.

- Propagacja wsteczna to metoda poprawiania parametrów po każdej pomyłce.

- Gradient wskazuje kierunek zmian – mówi modelowi, jak przesuwać parametry, by lepiej przewidywać.

- Wynik: sieć stopniowo uczy się prawidłowości językowych, aż zaczyna odwzorowywać strukturę i sens ludzkiego języka.

Na początku słowa są przypadkowe punkty w pustej przestrzeni. Potem, miliard po miliardzie kroków, sieć zaczyna widzieć w tym chaosie wzory. Tokeny tworzą grupy, sensy łączą się, a matematyka przemienia się w coś, co przypomina rozumienie.

To właśnie cud backpropagacji – prosty algorytm różniczkowy, który sprawia, że z liczb rodzi się język.