W świecie sztucznej inteligencji łatwo ulec wrażeniu, że wszystko zostało już rozwiązane. Modelom, które piszą kod, udzielają porad medycznych i zdają olimpiady matematyczne, trudno odmówić imponujących zdolności. A jednak istnieje jeden benchmark, który pozostaje prawdziwą granicą nie do przekroczenia. Mowa o rodzinie testów ARC-AGI, zaprojektowanej tak, aby oceniać to, co najbliższe „prawdziwej” inteligencji, czyli zdolność do tworzenia nowych reguł w locie, uczenia się z małej liczby przykładów i rozwiązywania problemów, których nie ma w żadnych danych treningowych.

W ostatnich latach, obok samego benchmarku ARC, pojawiło się też pojęcie Arcpize. To potoczne określenie metod, które łączą kilka podejść naraz: iteracyjne udoskonalanie rozwiązań, syntetyczne myślenie, biblioteki koncepcji budowane w trakcie działania oraz techniki ewolucyjne. Arcpize nie jest nazwą oficjalnej architektury. To raczej sposób myślenia o tym, jak zmusić współczesne modele AI do prawdziwego rozumowania, a nie tylko przewidywania kolejnych tokenów. W praktyce najlepsze wyniki na ARC-AGI w 2025 roku pochodzą właśnie z systemów o charakterze arcpizowym: hybrydowych, nieoczywistych, wielokrotnie iterujących swoje pomysły.

Żeby zrozumieć, dlaczego to potrzebne, warto zacząć od tego, czym w ogóle jest ARC.

Spis treści

ARC-AGI: benchmark, który wymyka się skalowaniu

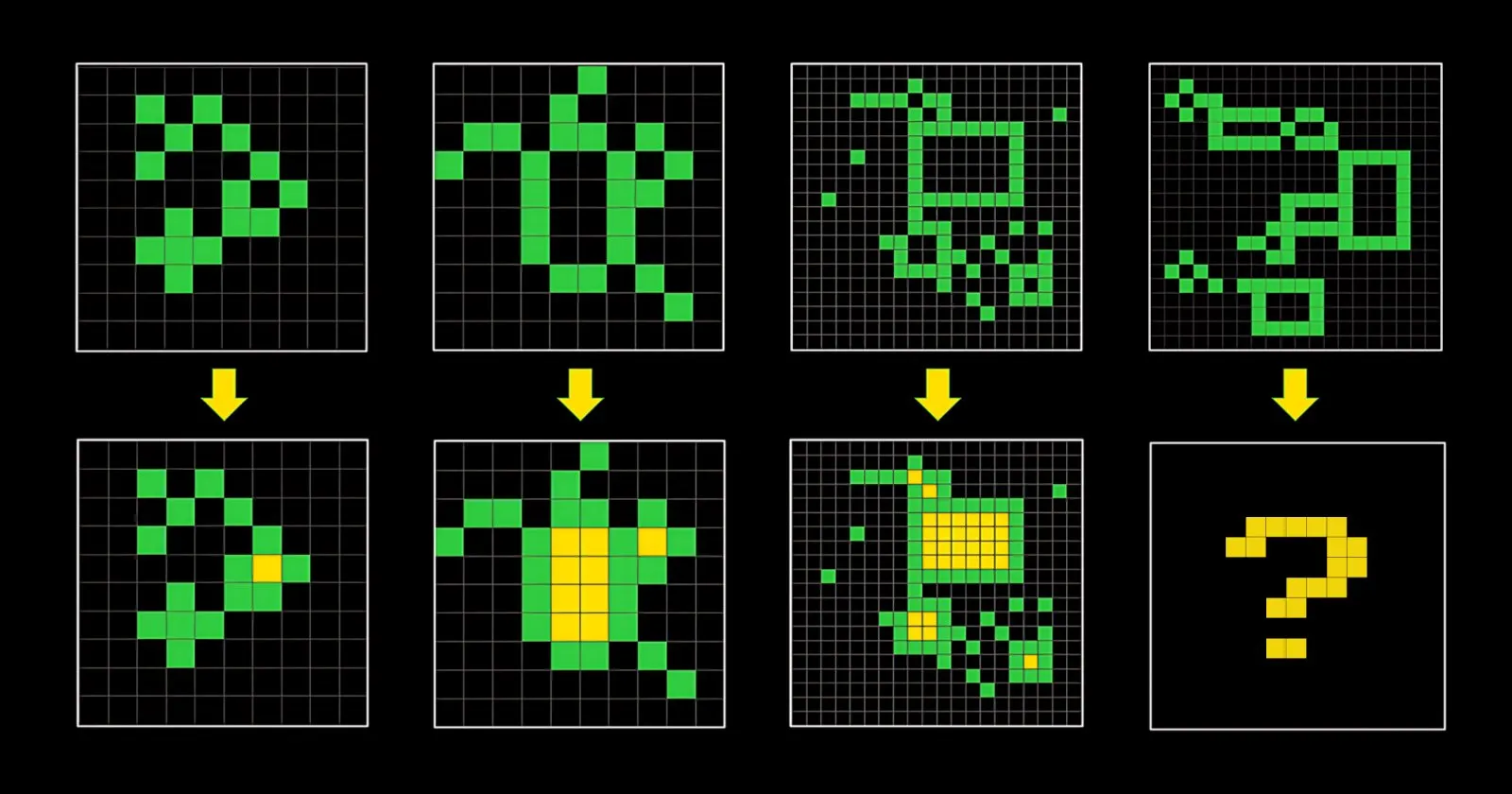

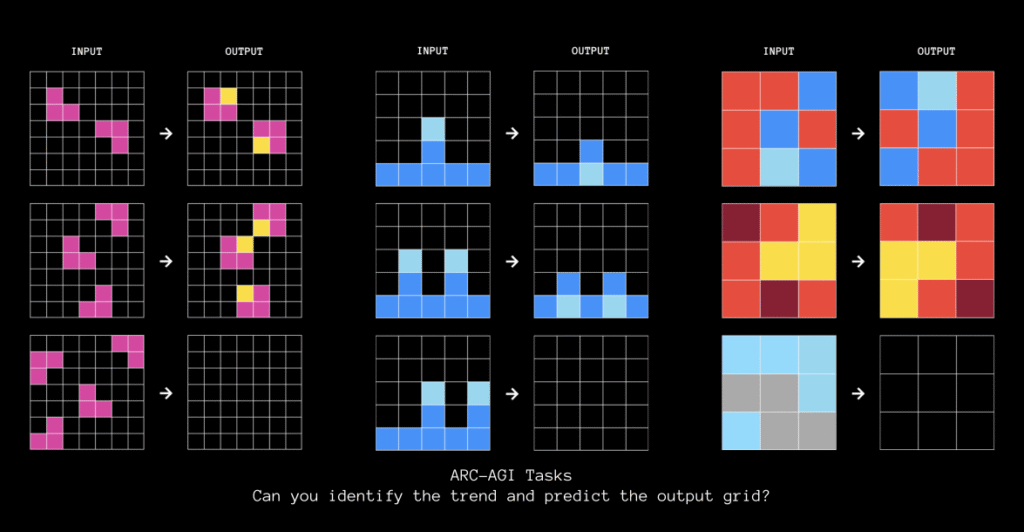

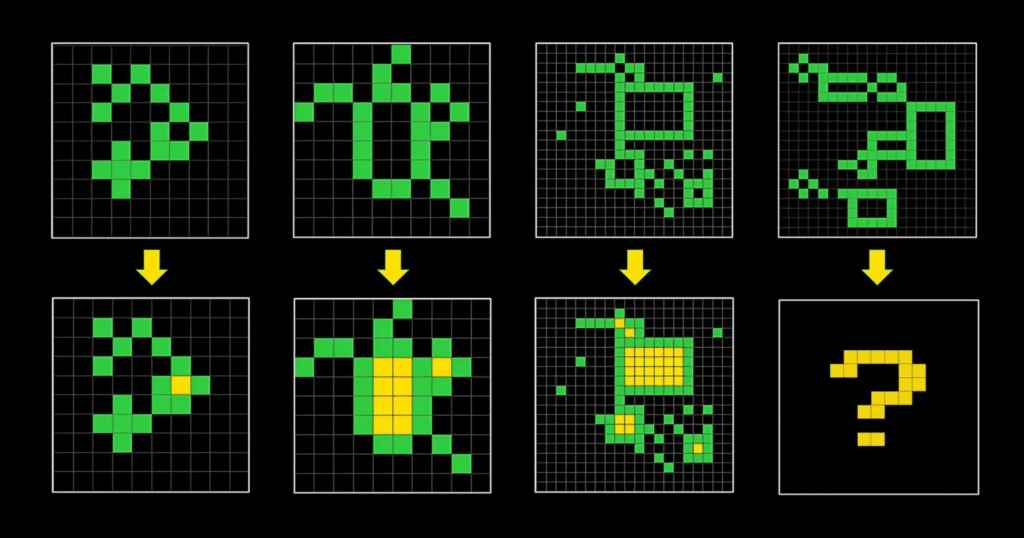

ARC-AGI (Abstraction and Reasoning Corpus for AGI) to zestaw łamigłówek wizualnych, które wyglądają banalnie: kolorowe siatki o rozmiarach od kilku do kilkudziesięciu pikseli, kilka przykładów wejście i ich poprawnych wyjść oraz jedno nowe wejście, dla którego model musi wygenerować prawidłowe wyjście. W teorii zadanie brzmi jak klasyczna zagadka logiczna. W praktyce jest to test głębokiej abstrakcji.

Każda łamigłówka jest unikalna, a jej logika budowana jest w oparciu o symbole definiowane lokalnie. Model nigdy wcześniej nie widział tych zasad, więc nie może używać pamięci treningowej. To fundamentalnie odróżnia ARC od benchmarków takich jak MMLU, HumanEval czy Big-Bench, gdzie modele korzystają z miliardów wzorców zapisanych podczas treningu.

W 2025 roku używa się głównie wersji ARC-AGI-2. Ta odsłona wprowadza restrykcje kosztowe i konstrukcyjne, aby ograniczyć brute force. Skupia się nie tylko na wyniku procentowym, ale także na efektywności, czyli kosztach obliczeniowych per task. Człowiek rozwiązuje takie łamigłówki za cenę kawy. Frontierowe modele potrafią „zużyć” dziesięć, dwadzieścia albo nawet trzydzieści dolarów na jeden problem, a i tak uzyskują wyniki rzędu kilkunastu procent.

Dlaczego współczesnym modelom LLM idzie tak źle?

Modele takie jak GPT-5, Claude 4.5, Sonnet 4.5 czy Grok 4 imponują, kiedy mają dużo tekstu, kontekstu i możliwość wykonania długiego ciągu rozumowania. Niestety duża część ich „rozumowania” wynika z szerokiej statystyki tekstu, a nie z mechanizmu abstrakcyjnego myślenia.

Na ARC-AGI-2 wygląda to bardzo wyraźnie:

- czyste modele LLM (bez dodatkowych technik) osiągają zwykle 0-3 procent;

- modele używające Chain-of-Thought osiągają 10-18 procent;

- najbardziej zaawansowane bespoke systems oparte na iteracyjnym refinement dobijają do około 30 procent.

Rezultaty pokazują, że współczesna generatywna AI świetnie radzi sobie z odtwarzaniem wzorców, ale nadal ma ogromne trudności z tworzeniem nowych reguł.

Czym są CoT, refinement i arcpizowe metody?

Chain-of-Thought (CoT)

To technika, która każe modelowi „myśleć na głos”. W typowym promptingu dodaje się instrukcję „pomyśl krok po kroku”. Dzięki temu model produkuje sekwencję uzasadnień. To znacząco pomaga przy zadaniach matematycznych lub logicznych, ale często prowadzi do halucynacji i eksplozji kosztów obliczeniowych.

Na ARC CoT daje umiarkowaną poprawę, lecz nie jest panaceum. W pewnym momencie model zaczyna gubić się w nadmiarze kroków.

Refinement

Refinement to pomysł, aby nie oczekiwać od modelu perfekcyjnej odpowiedzi od razu. Zamiast tego buduje się pętlę iteracyjną: model generuje kilka pierwszych pomysłów, system je testuje na danych \treningowych, a następnie prosi model o poprawę i rozwinięcie tych kandydatów.

To trochę jak projektowanie maszyną, która potrafi sama siebie poprawić po każdej iteracji. Najlepsze systemy wykonują setki takich iteracji podczas jednego zadania. To niezwykle kosztowne, ale skuteczne.

Evolutionary compute i program synthesis

W podejściu arcpizowym stosuje się idee inspirowane ewolucją. Zamiast jednego rozwiązania generuje się wiele kandydatów, ocenia się je i zachowuje tylko najlepsze. Podczas kolejnych iteracji kandydaci mutują, łączą się albo uczą nowych operacji. Dokładnie tak powstają najlepsze rozwiązania na ARC-AGI.

Program synthesis to z kolei technika, w której system generuje nie tylko rozwiązanie konkretnego problemu, ale także buduje bibliotekę funkcji lub koncepcji, z których może korzystać później. Z czasem taka biblioteka staje się zasobem strukturalnej wiedzy możliwej do ponownego wykorzystania.

To jest właśnie kwintesencja arcpizowania: system nie tylko generuje odpowiedź, ale rozwija swój własny aparat pojęciowy.

Kim są J. Berman i E. Pang – i dlaczego ich systemy wygrywają?

Większość spodziewałaby się, że szczyt tabeli ARC-AGI będzie należał do największych laboratoriów. Tymczasem w 2025 roku dominują tam niezależni badacze, pracujący na własnych pipeline’ach.

Jeremy Berman

To badacz znany z Reflection AI. Jego system osiągnął około 29,4 procent na ARC-AGI-2 oraz około 79,6 procent na starszym ARC-AGI-1. Najciekawsze w jego pracy jest to, że używa ewolucyjnego test-time compute. System generuje setki rozwiązań, testuje je, wybiera najlepsze i udoskonala dalej. Co zaskakujące, okazało się, że lepiej działa generowanie pomysłów w naturalnym języku niż w Pythonie.

Berman udostępnia większość swoich metod publicznie, od blogów po kod, dzięki czemu jego techniki szybko stają się inspiracją dla innych.

E. Pang

E. Pang (często podpisujący się jako epang080516) zajmuje drugie miejsce z wynikiem około 26 procent. Jego podejście jest oparte na koncepcjach z DreamCoder. System w trakcie rozwiązywania zadań sam rozwija bibliotekę funkcji i pomysłów. Dzięki temu poprawia się nie tylko w obrębie jednej łamigłówki, ale także w ramach całego procesu. Pang wyróżnia się tym, że jego rozwiązania są znacznie tańsze obliczeniowo.

To właśnie z takich prac wywodzi się pojęcie arcpizowania: twórczego, zwinnego, iteracyjnego podejścia do ARC.

Jak wygląda leaderboard ARC-AGI w końcówce 2025?

Na ARC-AGI-1 najlepsze modele potrafią wejść na poziom 70-80 procent, a system Bermana potrafi przekroczyć 79 procent. Człowiek osiąga prawie komplet. Różnica między człowiekiem a algorytmem jest widoczna, ale nie dramatyczna.

Sytuacja zmienia się, kiedy patrzymy na ARC-AGI-2. Tutaj wyniki spadają:

- J. Berman: około 29 procent;

- E. Pang: około 26 procent;

- GPT-5 Pro oraz GPT-5.1 Thinking: około 17-18 procent;

- Grok 4 Thinking: około 16 procent;

- Claude Sonnet 4.5: około 13-14 procent.

Zwykły człowiek osiąga od 77 do 98 procent, w zależności od poziomu wykształcenia. To przepaść, której nie zasypiemy kolejną warstwą neuronową.

Wykres wyników modeli AGI i kosztów

Wykres ARC-AGI-1 działa jak mapa możliwości współczesnych systemów rozumujących. Na osi pionowej widać skuteczność, na poziomej koszt jednego zadania w dolarach. W lewym górnym rogu znajduje się strefa Grand Prize, czyli wymarzona kombinacja wysokiego wyniku i niskich kosztów, której nikt jeszcze nie osiągnął. Rozkład punktów pokazuje, które podejścia radzą sobie najlepiej, a które polegają na sile czystego skalowania.

Najwyżej położone pomarańczowe punkty należą do Jeremy’ego Bermana i E. Panga. To systemy bespoke, oparte na iteracyjnym refinemencie i syntezie programów, które rozumieją zadania ARC nie statystycznie, lecz strukturalnie. Berman osiąga najwyższy wynik, Pang jest tańszy; obaj potwierdzają, że klucz do ARC leży poza klasycznymi LLM-ami.

Niedaleko od nich, choć przy ogromnym koszcie, znajduje się o3-preview (Low), frontierowy model OpenAI. Potrafi wejść w okolice siedemdziesięciu kilku procent, lecz zużywa setki dolarów na zadanie. To dobry przykład granicy podejścia „więcej compute może wszystko”.

Poniżej zbierają się sekwencje punktów reprezentujące rodziny modeli OpenAI: GPT-5, GPT-5.1 Thinking, o3-Pro i o4-mini. Ich pozycje układają się w logiczne trajektorie: im większy budżet reasoningowy, tym lepszy wynik, ale także wyższy koszt. Najbardziej zrównoważony jest GPT-5.1 Thinking (High), osiągający około siedemdziesięciu procent przy umiarkowanych kosztach.

Do tego dochodzi rodzina Grok. Grok 4 w trybie Thinking plasuje się w okolicach sześćdziesięciu kilku procent, co czyni go najskuteczniejszym modelem xAI. Wokół trzydziestu procent pojawiają się bardziej zaawansowane, lecz wciąż klasyczne systemy, jak Claude Opus 4, TRM czy HRM. Niżej znajdują się Qwen, Llama i inne tanie modele, które radzą sobie słabo, ale są bardzo efektywne kosztowo.

Z wykresu płynie kilka jasnych wniosków. Najwyższą skuteczność osiągają systemy iteracyjne, nie same modele językowe. Frontierowe modele potrafią wejść wysoko, lecz nie są efektywne. Open-source pozostaje daleko w tyle. I przede wszystkim: ARC-AGI-1 pokazuje, że prawdziwe rozumowanie nie wynika z rozmiaru modelu, lecz z odpowiedniej strategii działania, testowania i poprawiania własnych hipotez. To nie ranking, lecz kompas przyszłej sztucznej inteligencji.

Dlaczego ARC-AGI wciąż jest „niepokonany”?

Z trzech powodów.

Po pierwsze: każdy problem jest unikalny

ARC nie pozwala korzystać z pamięci treningowej. Żadne dane statystyczne nie pomogą, bo każde zadanie posiada własną, wcześniej nieznaną logikę.

Po drugie: reguły są symboliczne

Modele neuronowe są świetne, kiedy wzorce są ciągłe i statystyczne. ARC wymaga rozumowania w stylu: „zielony piksel otoczony niebieskimi trzema razy z rzędu oznacza przeniesienie obiektu dwa pola w prawo”. To działanie symboliczne, które jest trudne do wykonania przez sieci neuronowe w obecnej formie.

Po trzecie: brak skalowania

ARC-AGI-2 jest skonstruowany tak, żeby wyniki nie rosły po prostu wraz z rozmiarem modelu. Potrzebne są nowe idee, a nie większe GPU.

Co nam mówi arcpize o przyszłości AGI?

Najważniejsze odkrycie ostatnich dwóch lat brzmi: postęp nie wynika dziś z powiększania parametrów, ale z inteligentnego wykorzystania modeli podczas działania. Arcpizowe systemy pokazują, że LLM może być czymś więcej niż predyktorem tokenów. Może być generatorem koncepcji i elementem większej struktury.

Kierunki, które prawdopodobnie ukształtują kolejną dekadę badań nad AGI:

- iteracyjny refinement z kontrolą kosztów;

- ewolucyjny test-time compute;

- biblioteki koncepcji syntetyzowane podczas działania;

- połączenie modeli językowych z symbolicznymi aparatami rozumowania;

- systemy multi-agentowe, w których modele oceniają i modyfikują swoje pomysły.

Przyszłe AGI może nie być pojedynczym modelem z bilionem parametrów. Bardziej prawdopodobna jest architektura modularna, dynamiczna, oparta na ewolucyjnym przeszukiwaniu przestrzeni pomysłów.

Podsumowanie

Arcpize to nie algorytm, nie protokół i nie nowa architektura. To sposób pracy nad zadaniami wymagającymi prawdziwego rozumowania. Zakłada iteracje, testowanie, poprawianie i rozwijanie własnej biblioteki idei. To właśnie dzięki takim podejściom niezależni badacze wyprzedzają potężne laboratoria na najbardziej prestiżowym teście AGI na świecie.

W listopadzie 2025 roku ARC-AGI-2 pozostaje nierozwiązany. Grand Prize czeka na system, który przekroczy 85 procent. Obecnie nikt nie zbliża się nawet do połowy tego poziomu. Jednak tempo zmian jest duże: jeszcze rok temu 3 procent było sukcesem. Dziś 30 procent jest standardem dla najlepszych systemów arcpizowych.

To wyraźny sygnał, że prawdziwy postęp w kierunku AGI nie przychodzi już dzięki skalowaniu, lecz dzięki nowym strukturom myślenia. A to znaczy, że najbardziej przełomowe pomysły dopiero przed nami.