Zdarzyło Ci się kiedyś prowadzić długą, fascynującą dyskusję z czatem AI, tylko po to, by w pewnym momencie zorientować się, że model kompletnie zapomniał, o czym rozmawialiście na samym początku? A może próbowałeś wkleić do analizy całą książkę, a system odmówił współpracy, twierdząc, że wiadomość jest „zbyt długa”?

To nie złośliwość maszyny ani błąd oprogramowania. To zderzenie z jedną z najbardziej fundamentalnych barier współczesnej sztucznej inteligencji, czyli oknem kontekstowym.

Choć wielkie modele językowe (LLM) podczas treningu „przeczytały” niemal cały internet, ich pamięć robocza (której używają podczas rozmowy z Tobą ), jest zaskakująco ograniczona i, co ważniejsze, niezwykle kosztowna obliczeniowo. Dlaczego dodanie AI „więcej pamięci” jest o wiele trudniejsze niż dokupienie kości RAM do laptopa? Dlaczego matematyka stojąca za generowaniem tekstu sprawia, że każde dodatkowe zdanie w historii czatu to wyzwanie dla superkomputerów?

W tym artykule zajrzymy pod maskę modeli językowych. Wyjaśnimy, jak działają tokeny, dlaczego koszty „uwagi” rosną lawinowo i w jaki sposób inżynierowie (oraz użytkownicy) radzą sobie z tym ograniczeniem, stosując sprytne techniki takie jak RAG czy sliding window.

Artykuł jest pisany w taki sposób, żeby był użyteczny dla osób które nie mają większej wiedzy o sztucznej inteligencji. Natomiast zrozumienie podstaw działania sztucznej inteligencji znacząco ułatwia zrozumienie pojęcia okna kontekstowego.

Spis treści

Czym jest okno kontekstowe?

Można to porównać do rozmowy z kimś, kto potrafi pamiętać tylko ostatnie dziesięć zdań rozmowy. Niezależnie od tego, jak długo ze sobą gadacie, wszystko co powiedziałeś wcześniej po prostu znika z jego pamięci. To właśnie dzieje się z modelami językowymi, ich „pamięć robocza” jest ograniczona przez tak zwane okno kontekstowe.

Okno kontekstowe to maksymalna ilość tekstu (mierzona w tokenach), którą model może przetworzyć jednocześnie. Token to zwykle fragment słowa, całe słowo lub znak interpunkcyjny, w języku polskim średnio jedno słowo to około 1,5-2 tokeny. Gdy przekroczysz limit okna kontekstowego, model po prostu „zapomina” najstarsze fragmenty, zachowując tylko najnowsze informacje.

W praktyce oznacza to, że jeśli model ma okno 4000 tokenów (około 3000 słów w języku polskim), a wyślesz mu dokument liczący 10 000 słów, zobaczy tylko końcówkę. Wszystkie ważne informacje z początku dokumentu będą dla niego niedostępne. To jakby próbować zrozumieć film, oglądając tylko ostatnie dwadzieścia minut (a dokładniej, tak jakby w każdej minucie ktoś czyścił Ci wspomnienia z przed ostatnich 20 minut).

Dlaczego po prostu nie zwiększyć rozmiaru okna kontekstowego?

Na pierwszy rzut oka rozwiązanie wydaje się oczywiste: wystarczy rozszerzyć okno z 4000 do 100 000 tokenów i sprawę mamy z głowy. Rzeczywistość jest jednak znacznie bardziej złożona, a ograniczenia mają charakter fundamentalny.

Przede wszystkim, matematyka stojąca za modelami językowymi nie pozostawia pola na kompromisy. Przy kwadratowej złożoności obliczeniowej dziesięciokrotne powiększenie okna przekłada się na stukrotny wzrost wymaganych obliczeń. Model, który sprawnie przetwarzał 4000 tokenów w ciągu sekundy, przy 40 000 tokenów potrzebowałby kilku minut, i to przy drastycznie większym zapotrzebowaniu na pamięć GPU.

Kolejny problem ma charakter strukturalny: modele uczą się na określonym rozmiarze kontekstu. Embeddingi pozycyjne, czyli matematyczne znaczniki informujące o kolejności tokenów, są precyzyjnie skalibrowane pod konkretną maksymalną długość. Gdy nagle zaserwujemy modelowi sekwencję znacznie dłuższą od tej, na której był trenowany, jego skuteczność gwałtownie maleje. To jak próba czytania mapy Polski w skali 1:500 000, żeby znaleźć drogę w Szklarskiej Porębie, proporcje kompletnie nie pasują.

Wreszcie istnieje problem jakościowy: wraz z wydłużaniem kontekstu model traci zdolność równomiernego przetwarzania informacji. Badania ujawniają zjawisko nazwane „lost in the middle” , modele mają tendencję do pomijania fragmentów ze środka bardzo długich sekwencji, koncentrując uwagę głównie na początku i końcu. To nie jest tylko kwestia techniczna, lecz ograniczenie wynikające z samej architektury.

Matematyka stojąca za oknem kontekstowym

Tokeny i embeddingi

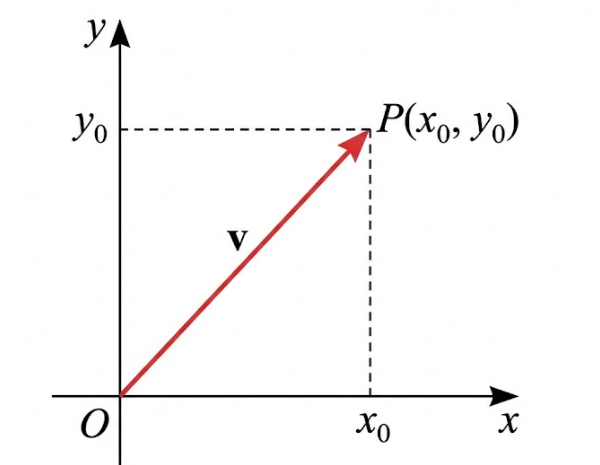

Zanim model w ogóle przystąpi do „myślenia” o tekście, musi go najpierw przetłumaczyć na język liczb. Każdy token zostaje przekształcony w wektor, uporządkowaną sekwencję setek lub tysięcy liczb zmiennoprzecinkowych. Proces ten nazywamy embeddingiem. Dla przykładu, słowo „kot” może przyjąć formę wektora [0.234, -0.891, 0.445, …, 0.123] liczącego 768 lub więcej wymiarów.

Wektory te nie powstają przypadkowo – są tak skonstruowane, by słowa o zbliżonym znaczeniu posiadały podobne reprezentacje numeryczne. Wygenerowane embeddingi trafiają następnie do macierzy, która staje się fundamentem wszystkich późniejszych obliczeń w modelu. Jeśli przetwarzasz sekwencję 1000 tokenów, gdzie każdy ma embedding o wymiarze 768, pracujesz na macierzy o rozmiarze 1000 × 768. I to dopiero punkt wyjścia.

Wielowymiarowa macierz jest dużo łatwiejsza do zrozumienia, niż się większości ludzi wydaje. W teorii, modele mogły by korzystać z trójwymiarowego czy nawet dwuwymiarowego układu współrzędnych. Takie coś każdy jest w stanie sobie wyobrazić, łatwe jest nawet wykonywanie operacji przez człowieka na takim układzie. Do opisu dowolnego punktu wystarczają dwie współrzędne, opisanie dowolnego wektora też jest proste.

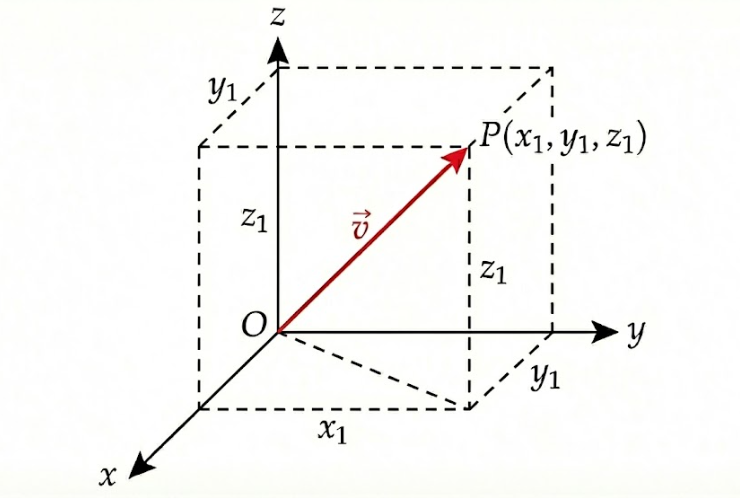

Trój wymiarowy układ współrzędnych również jest prosty do zrozumienia, każdy może na nim operować. Zmienia się jedynie nieco opis wektora (i punktu). Teraz jeśli chcemy opisać położenie dowolnego punktu, musimy użyć trzech współrzędnych, długości, szerokości, i wysokości.

A jak to wygląda w czwór wymiarowym układzie współrzędnych? Wizualizacja jest bardzo trudna, praktycznie niemożliwa, choć można próbować przybliżyć wygląd takiego układu na wiele sposobów, ale nie da się już na tym operować wizualnie. Za to opis dowolnego punktu, czy wektora, jest nadal stosunkowo prostu. Do opisu dowolnego punktu, wystarczy dodać kolejną współrzędną. Wszystkie operacje dodawania i odejmowania wektorów, działają w gruncie rzeczy tak samo. W ten sposób można tworzyć układy mające dowolną ilość współrzędnych.

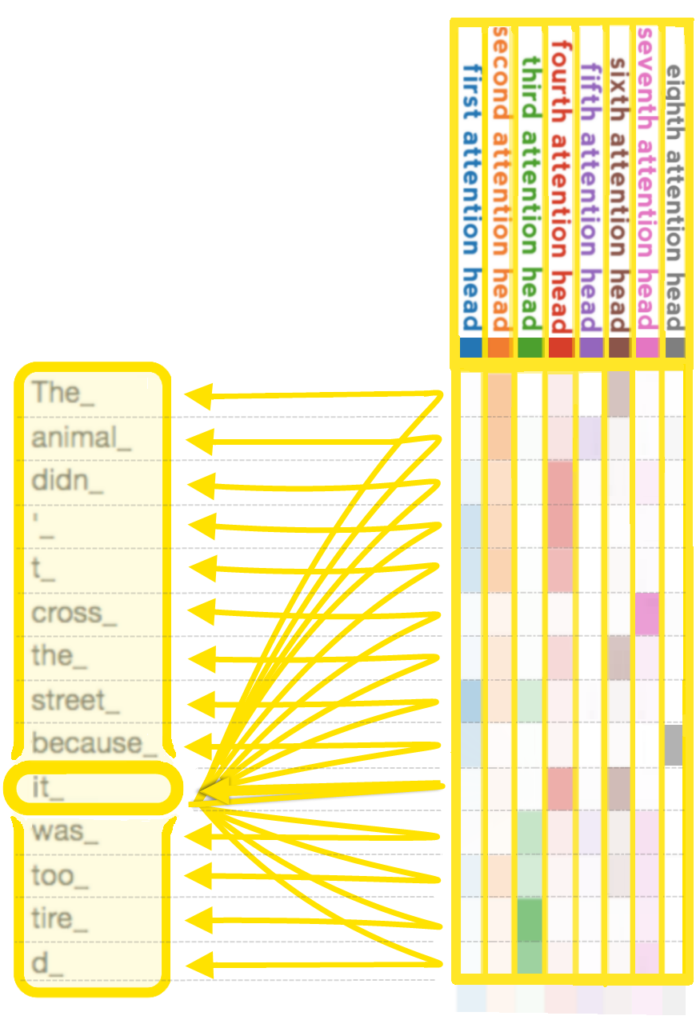

Mechanizm attention i jego koszt

Sercem każdego współczesnego modelu językowego jest mechanizm nazwany attention (uwaga). To właśnie on umożliwia modelowi „skanowanie” różnych fragmentów tekstu i podejmowanie decyzji, które elementy są kluczowe dla zrozumienia aktualnie analizowanego słowa. Brzmi niegroźnie – a jednak tu właśnie kryje się prawdziwe wyzwanie.

W klasycznej implementacji attention (nazywanej self-attention) model wykonuje porównanie każdego tokenu z każdym innym tokenem w sekwencji. Matematycznie realizuje się to poprzez mnożenie macierzy: macierz zawierającą wszystkie tokeny mnożymy przez jej transpozycję, otrzymując macierz uwagi. Dla sekwencji długości N powstaje macierz o wymiarach N × N.

I właśnie tutaj ujawnia się problem, przy 1000 tokenów model musi obliczyć 1 000 000 relacji (1000 × 1000). Gdy rozszerzysz kontekst do 10 000 tokenów, liczba ta skoczy do 100 000 000 relacji. Złożoność obliczeniowa rośnie kwadratowo w stosunku do długości sekwencji, co zapisujemy jako O(N²). To nie jest przyrost liniowy – to prawdziwa eksplozja.

Co więcej, typowy model składa się z wielu warstw (często 24, 32 lub więcej), z których każda przeprowadza własne obliczenia attention. Wiele modeli wykorzystuje dodatkowo kilkanaście równoległych „głów” attention w każdej warstwie, co jeszcze bardziej zwielokrotnia wymagania obliczeniowe. Do tego wszystkiego dochodzi pamięć niezbędna do przechowywania tych licznych macierzy w trakcie obliczeń.

Praktyczne sposoby na zwiększenie okna kontekstowego.

Chunking i sumaryzacja

Najprostszą metodą obejścia ograniczeń okna kontekstowego jest podział długiego tekstu na mniejsze fragmenty (chunki) i przetwarzanie ich sekwencyjnie. Możesz na przykład podzielić 50-stronicowy dokument na 10 części po 5 stron, każdą analizować osobno, a potem zebrać wyniki.

Jeszcze lepiej działa sumaryzacja kaskadowa: dzielisz dokument na fragmenty, każdy fragment sumaryujiesz, a następnie tworzysz „meta-streszczenie” ze wszystkich podsumowań. To jak czytanie not ze spotkań zamiast pełnych stenogramów – tracisz szczegóły, ale zachowujesz istotę. Ta metoda jest szczególnie użyteczna, gdy potrzebujesz ogólnego zrozumienia, a nie dosłownych cytatów.

RAG (Retrieval-Augmented Generation)

RAG to znacznie bardziej wyrafinowane podejście. Zamiast wpychać cały dokument do modelu, system najpierw wyszukuje tylko te fragmenty, które są relevantne dla Twojego pytania. Działanie wygląda tak: masz bazę dokumentów przekształconą w embeddingi, zadajesz pytanie, system znajduje najbardziej podobne fragmenty semantycznie (używając podobieństwa wektorów), a następnie tylko te fragmenty trafiają do modelu razem z pytaniem.

Załóżmy, że masz tysiąc raportów firmowych i pytasz „Jakie były koszty marketingu w Q3?”. System RAG nie musi czytać wszystkich tysiąca dokumentów – znajdzie te 3-5 fragmentów, które wspominają o Q3 i marketingu, i tylko je prześle do modelu. To jak mieć genialnego bibliotekarza, który zawsze wie, na której półce leży to, czego szukasz.

RAG świetnie działa z bazami wiedzy, dokumentacją techniczną czy archiwami. Wymaga jednak dodatkowej infrastruktury: bazy wektorowej, systemu indeksowania i mechanizmu wyszukiwania. Narzędzia takie jak LangChain czy LlamaIndex bardzo to ułatwiają.

Sliding window i inne optymalizacje

Niektóre nowsze architektury stosują przesuwne okno (sliding window): zamiast patrzeć na wszystkie tokeny naraz, każdy token widzi tylko swoich N najbliższych sąsiadów. Model Mistral 7B używa dokładnie tego podejścia z oknem 4096 tokenów, ale dzięki sprytnej architekturze może efektywnie przetwarzać znacznie dłuższe sekwencje.

Inna technika to sparse attention – zamiast obliczać relacje między wszystkimi parami tokenów, model skupia się tylko na wybranych, strategicznie ważnych relacjach. To zmniejsza złożoność z O(N²) do O(N log N) lub nawet O(N). Modele takie jak Longformer czy BigBird wykorzystują te optymalizacje.

Istnieje też kompresja kontekstu – specjalne modele mogą „skompresować” długi tekst do zwięzłej reprezentacji zachowującej kluczowe informacje. To jak robienie notatek: 100 stron wykładu zmienia się w 5 stron najważniejszych punktów.

Okna kontekstowe popularnych modeli

Świat modeli językowych szybko ewoluuje, ale warto znać aktualne możliwości.. Najnowszy GPT-5 łączy duże okno, które pozwala przetwarzać kilkaset tysięcy tokenów naraz, z wysoką jakością rozumowania i stabilnymi odpowiedziami. To model, który dobrze radzi sobie z analizą rozbudowanych materiałów, projektowaniem złożonych rozwiązań i pracą na tekstach, które wcześniej wymagały wielu etapów podziału.

Z kolei Gemini 1.5 Pro przesuwa granice czysto fizycznej pojemności: ponad dwa miliony tokenów sprawiają, że model potrafi wczytać obszerne archiwa dokumentów lub kilka książek jednocześnie. Tak duża przestrzeń nie zawsze jest potrzebna, ale otwiera nowe scenariusze, zwłaszcza w pracy badawczej i audytowej, gdzie ważna jest możliwość spojrzenia na cały materiał bez fragmentacji.

W segmencie open-source Meta rozwija Llama 3.3, która oferuje do 128 tysięcy tokenów i pozostaje jedną z najciekawszych propozycji dla osób ceniących elastyczność i kontrolę nad danymi. Równolegle powstają lżejsze modele długokontekstowe, takie jak nowe odmiany Mistrala, które przy dużo mniejszym koszcie zapewniają realną zdolność pracy z obszernymi dokumentami.

Choć imponujące liczby robią wrażenie, warto pamiętać, że wielkość okna jest tylko jednym z elementów układanki. O jakości pracy z długim kontekstem decyduje także sposób, w jaki model wykorzystuje dostępne informacje oraz jak stabilnie prowadzi rozumowanie. Wybór odpowiedniego modelu nie sprowadza się więc do maksymalnej liczby tokenów, lecz do dopasowania narzędzia do realnych potrzeb.

Okno kontekstowe w ludzkim umyśle.

Amnezja następcza i ciekawy przypadek H.M.

Najlepiej obrazuje to jeden z najbardziej fascynujących przypadków w historii neuronauki, czyli historia Henry’ego Molaisona, znanego światu jako pacjent H.M. Choć jego mózg utracił zdolność tworzenia nowych trwałych wspomnień, Henry pozostawał bystrym, uprzejmym i angażującym rozmówcą. Potrafił rozwiązywać krzyżówki, żartować i prowadzić logiczne dyskusje, o ile mieściły się one w jego kilkunastominutowym „oknie teraźniejszości”. Współczesna sztuczna inteligencja to w pewnym sensie cyfrowy odpowiednik tego niezwykłego stanu umysłu. Model jest błyskotliwy i elokwentny, ale podobnie jak Henry, żyje w wiecznym „teraz”. Nie posiada on „cyfrowego hipokampu”, który zapisywałby Waszą konwersację na twardym dysku jego osobowości. Gdy limit tokenów się wyczerpuje, najstarsze wątki po prostu rozpływają się w niebycie, a AI kontynuuje rozmowę z niesłabnącym entuzjazmem, skupiona wyłącznie na tym, co widzi w danej chwili.

Okno kontekstowe dotyczy też każdego człowieka, choć trudniej jest to zauważyć.

Okno kontekstowe dotyczy także każdego człowieka, choć na pierwszy rzut oka niełatwo to zauważyć. Mózg przetwarza informacje w cyklach, które obejmują pamięć sensoryczną, pamięć roboczą oraz wczesną konsolidację zależną od hipokampa. Każdy z tych etapów działa w określonym przedziale czasowym, podobnie jak w modelach językowych określa się liczbę znaków możliwych do bieżącego uwzględnienia. W naszym przypadku takim oknem jest zestaw informacji, które umysł potrafi utrzymać, powiązać i wykorzystać w danym momencie. Gdy pojawia się zbyt wiele nowych bodźców, wcześniejsze ślady stają się mniej dostępne, ponieważ system musi zwolnić miejsce na kolejne elementy.

Trudność polega na tym, że w człowieku te procesy nie są tak czytelne jak w algorytmie. Pamięć robocza ma ograniczoną pojemność, a wczesna konsolidacja trwająca od kilku do kilkudziesięciu minut jest wrażliwa na zakłócenia. Hipokamp utrzymuje świeże informacje, zanim trafią do trwałego zapisu, więc jeśli w tym czasie pojawi się za dużo nowych sygnałów, mózg częściowo nadpisze poprzednie treści. W efekcie pamiętamy nie tyle to, co faktycznie widzieliśmy lub słyszeliśmy, ile to, co zmieściło się w naszym wewnętrznym oknie kontekstowym i zostało utrwalone na czas.

Dopiero gdy zdamy sobie sprawę z istnienia tego ograniczonego okna, łatwiej jest zrozumieć, dlaczego niektóre rozmowy gubią wątki, dlaczego trudno przypomnieć sobie drobny szczegół sprzed kwadransa albo z jakiego powodu intensywne sytuacje tak mocno wypychają z pamięci wcześniejsze zdarzenia. To nie wada, lecz naturalna architektura ludzkiego mózgu, która działa podobnie do modeli AI, choć jest znacznie bardziej złożona i delikatna.

Nauka nowych rzeczy i złożone prace koncepcyjne.

W praktyce widać to przy nauce nowych, wymagających rzeczy, a także podczas pracy koncepcyjnej. W takich sytuacjach pomocne jest szybkie dostarczenie sobie użytecznych informacji, czyli stworzenie odpowiedniego kontekstu. Ludzie drukują więc notatki i przyklejają je na ścianie, przeglądają krótkie podsumowania albo wracają do wcześniejszych tekstów. Artyści przygotowują zestawy inspiracji, a w procesie projektowym powstaje mood board, który pełni tę samą funkcję: uporządkowuje świat bodźców, żeby umysł mógł pracować na właściwym zestawie danych.

Mając taki kontekst w głowie, łatwiej jest wykonać bardziej złożone zadanie, które później prościej zapamiętać, albo stworzyć coś konkretnego, na przykład tekst lub program. Po zakończeniu pracy nie trzeba już nosić w pamięci wielu drobnych informacji, ponieważ zostały one wykorzystane i utracą znaczenie do kolejnych działań.

Podobny mechanizm działa przy podziale pracy. Gdy zespół tworzy złożony projekt, nikt nie jest w stanie utrzymać w głowie całej wiedzy potrzebnej do jego realizacji. Każda osoba pracuje więc na swoim fragmencie kontekstu, odpowiednim do własnych zadań. Programista operuje na wymaganiach technicznych, projektant korzysta z mood boardów i makiet, a osoba odpowiedzialna za strategię skupia się na danych i założeniach biznesowych. Każdy z nich posiada tylko część pełnego obrazu, lecz ta część jest wystarczająca, żeby podejmować trafne decyzje i przesuwać projekt do przodu. Wspólne artefakty, takie jak dokumenty, diagramy czy krótkie podsumowania, pozwalają zespołowi zsynchronizować indywidualne okna kontekstowe, tak aby całość działała spójnie bez konieczności przechowywania wszystkiego w pamięci każdego człowieka.

Problem „gubienia zawartości” (lost in the middle).

Czym jest zjawisko „lost in the middle”?

Modele językowe, mimo imponujących możliwości technicznych, wykazują specyficzną słabość w przetwarzaniu długich tekstów. Zjawisko to, nazwane przez badaczy „lost in the middle”, polega na systematycznym pomijaniu lub niedokładnym analizowaniu informacji umieszczonych w środkowych fragmentach długich sekwencji.

Mechanizm działa w sposób paradoksalny: model technicznie „widzi” wszystkie tokeny w swoim oknie kontekstowym, ma do nich dostęp i teoretycznie może je przetwarzać równie efektywnie. W praktyce jednak jakość zrozumienia nie jest równomierna. Kluczowe dane ukryte między początkiem a końcem dokumentu mogą zostać praktycznie zignorowane, mimo że matematycznie znajdują się w pełni w zakresie attention.

To nie jest przypadkowa niedoskonałość, jest to systematyczny wzorzec, który pojawia się we wszystkich większych modelach językowych testowanych pod tym kątem. Niezależnie od konkretnej architektury czy rozmiaru modelu, efekt pozostaje zauważalny, a jego nasilenie rośnie proporcjonalnie do długości kontekstu.

Empiryczne dowody na istnienie problemu

Badania przeprowadzone przez zespoły z wiodących laboratoriów AI przyniosły niepokojące odkrycia. W eksperymentach, gdzie w różnych miejscach długiego kontekstu umieszczano kluczową informację niezbędną do odpowiedzi na pytanie, modele radziły sobie znacznie gorzej, gdy ta informacja znajdowała się w środku.

W jednym z testów badacze stworzyli dokumenty zawierające około 20 000 tokenów i ukryli w nich konkretny fakt, na przykład numer telefonu czy datę spotkania. Gdy informacja ta pojawiała się w pierwszych 10% lub ostatnich 10% dokumentu, modele odzyskiwały ją z dokładnością przekraczającą 90%. Jednak gdy ta sama informacja była umieszczona gdzieś między 40% a 60% długości tekstu, skuteczność spadała nawet do 30-40%.

Co więcej, problem ten nasila się proporcjonalnie do długości kontekstu. W sekwencjach liczących 4000 tokenów efekt jest zauważalny, ale umiarkowany. Przy 32 000 tokenów staje się już poważnym ograniczeniem. A gdy mówimy o eksperymentalnych modelach operujących na 100 000 czy 200 000 tokenów, środkowa część kontekstu może być praktycznie „niewidzialna” dla modelu.

Szczególnie wymowne są testy z dokumentami typu „igła w stogu siana”, gdzie jeden konkretny fakt jest ukryty w morzu irelewantnych informacji. Modele z łatwością odnajdują „igłę” na początku lub końcu „stogu”, ale gdy znajduje się ona dokładnie w środku, wskaźnik sukcesu spada dramatycznie – niekiedy nawet o 60-70 punktów procentowych.

Dlaczego modele tracą koncentrację?

Przyczyny tego zjawiska są wielowarstwowe i wynikają zarówno z architektury modeli, jak i ze sposobu ich trenowania.

Bias treningowy odgrywa tutaj kluczową rolę. Podczas treningu modele uczą się na milionach dokumentów, ale większość naturalnych tekstów ma określoną strukturę: ważne informacje pojawiają się na początku (wprowadzenie, tezy) i na końcu (podsumowanie, wnioski). Środek często wypełniają szczegóły, rozwinięcia i dygresje. Model uczy się więc statystycznego wzorca: „początki i końce są ważniejsze”. Ten wzorzec zostaje zahartowany przez miliardy przykładów i staje się trudny do przełamania, nawet gdy konkretny dokument ma inną strukturę.

Ograniczenia mechanizmu attention również mają swój udział. Chociaż teoretycznie każdy token może „spojrzeć” na każdy inny token, w praktyce wagi attention muszą zostać znormalizowane – muszą sumować się do 1. Przy bardzo długich sekwencjach „budżet uwagi” rozkłada się na coraz więcej tokenów, przez co pojedyncze, nawet ważne fragmenty, otrzymują coraz mniejszą wagę. Każdy token w sekwencji 100 000 elementów dostaje średnio zaledwie 0,001% całkowitej dostępnej uwagi.

Degradacja gradientu w trakcie backpropagacji to kolejny czynnik. Podczas uczenia sygnał błędu musi „przepłynąć” przez całą sieć wstecz. Im dłuższa sekwencja, tym trudniej sygnałowi dotrzeć do środkowych tokenów z wystarczającą mocą, by skorygować błędy. Model skuteczniej uczy się na tokenach bliskich początku i końcu sekwencji, gdzie sygnał jest silniejszy.

Efekt rozcieńczenia informacji stanowi dodatkowy problem. W długich sekwencjach proporcja szumu do sygnału wzrasta, model musi przedzierać się przez setki czy tysiące tokenów, z których większość jest mniej istotna. Mechanizmy attention, choć zaawansowane, nie potrafią idealnie oddzielić kluczowych informacji od wypełniacza, szczególnie gdy są one rozmieszczone równomiernie w całym tekście.

Praktyczne konsekwencje dla użytkowników

To zjawisko ma realne implikacje dla każdego, kto pracuje z dużymi modelami językowymi. Jeśli wklejasz do modelu długi dokument i zadajesz pytanie o informację, która znajduje się gdzieś w środku, ryzykujesz, że odpowiedź będzie nieprecyzyjna lub całkowicie pominie kluczowy fragment.

Dla analityków przetwarzających długie raporty oznacza to konieczność świadomego strukturyzowania promptów. Umieszczanie najważniejszych informacji na początku lub końcu kontekstu zwiększa prawdopodobieństwo, że model je zauważy. Niektórzy użytkownicy stosują technikę „kanapki” – powtarzają kluczowe fragmenty zarówno na początku, jak i na końcu długiego tekstu.

W zastosowaniach takich jak podsumowywanie dokumentów czy ekstrakcja informacji problem jest jeszcze bardziej widoczny. Model może stworzyć podsumowanie zawierające elementy z pierwszego i ostatniego rozdziału, całkowicie pomijając istotne wątki z środkowych części. Dla osoby niezorientowanej w oryginalnym dokumencie takie podsumowanie może wydawać się kompletne, podczas gdy w rzeczywistości brakuje w nim krytycznych elementów.

W kontekście analizy prawnej czy medycznej konsekwencje są jeszcze poważniejsze. Pominięcie kluczowego zapisu z środka umowy lub ważnego symptomu z środkowej części dokumentacji medycznej może prowadzić do błędnych wniosków o potencjalnie poważnych skutkach. Profesjonaliści korzystający z AI muszą być świadomi tego ryzyka i nie polegać ślepo na analizach generowanych przez model.

Czy istnieją rozwiązania?

Społeczność badawcza intensywnie pracuje nad złagodzeniem tego problemu, choć uniwersalne rozwiązanie wciąż pozostaje nieuchwytne.

Jednym z podejść jest trening z rozmieszczonymi informacjami – celowe umieszczanie podczas treningu kluczowych danych w różnych miejscach długich sekwencji, ze szczególnym naciskiem na środkowe fragmenty. Wymaga to jednak przeprojektowania całych datasetów treningowych i drastycznego zwiększenia kosztów obliczeniowych. Niektóre nowsze modele, jak Claude 3 czy GPT-4, pokazują poprawę w tym zakresie, choć problem nie został całkowicie wyeliminowany.

Hierarchiczne przetwarzanie stanowi inną ścieżkę. Zamiast przetwarzać cały tekst jednocześnie, model najpierw dzieli go na segmenty, przetwarza każdy lokalnie, a następnie łączy wyniki na wyższym poziomie abstrakcji. To pozwala uniknąć sytuacji, gdzie środkowe fragmenty giną w morzu tokenów, ale wprowadza nowe wyzwania związane z utratą kontekstu między segmentami.

Mechanizmy sliding window attention (przesuwane okno uwagi) ograniczają zakres attention do lokalnego sąsiedztwa, co zmniejsza efekt rozmycia uwagi, choć kosztem możliwości przechwycenia długodystansowych zależności. Modele takie jak Mistral wykorzystują tę technikę z pewnym sukcesem.

Najbardziej obiecujące wydają się nowe architektury attention, takie jak Sparse Attention, Longformer czy rozwiązania oparte na State Space Models (SSM). Inteligentnie wybierają one, które tokeny powinny ze sobą „rozmawiać”, zamiast próbować porównywać każdy z każdym. To jednak wciąż obszar aktywnych badań, a wdrożenie tych rozwiązań w produkcyjnych systemach wymaga czasu i znacznych zasobów.

Jak radzić sobie z problemem już dziś?

Dopóki nie pojawią się lepsze modele, użytkownicy mogą stosować praktyczne strategie minimalizujące wpływ zjawiska „lost in the middle”.

Przemyślana struktura promptów to podstawa. Umieszczaj najważniejsze instrukcje i kontekst na początku i końcu promptu. Jeśli musisz przekazać długi dokument, dodaj na końcu krótkie przypomnienie kluczowych punktów lub bezpośrednie pytanie odnoszące się do konkretnych fragmentów.

Dzielenie zadań na mniejsze części często przynosi lepsze rezultaty niż próba przetworzenia wszystkiego jednocześnie. Zamiast prosić model o analizę 50-stronicowego dokumentu w jednym promptcie, można go podzielić na rozdziały i przetworzyć sekwencyjnie, a następnie zsyntezować wyniki.

Technika map-reduce sprawdza się przy bardzo długich tekstach: najpierw przetwarzasz każdy fragment osobno (map), a następnie łączysz wyniki w spójną całość (reduce). To dodaje krok pośredni, ale dramatycznie zwiększa jakość przetwarzania środkowych części dokumentu.

Wyraźne wskazówki w prompcie mogą pomóc modelowi. Sformułowania typu „zwróć szczególną uwagę na środkową część dokumentu” lub „kluczowe informacje znajdują się w paragrafach 15-20″ zwiększają szanse, że model właściwie rozłoży swoją uwagę. Można także używać znaczników jak „[WAŻNE]” czy „[KLUCZOWA INFORMACJA]” przy krytycznych fragmentach.

Iteracyjne dopytywanie to kolejna skuteczna metoda. Zamiast zadawać jedno szerokie pytanie o cały dokument, zadaj serię bardziej precyzyjnych pytań odnoszących się do konkretnych sekcji. To zmusza model do skupienia uwagi na określonych fragmentach, a nie na próbie ogarnięcia całości jednocześnie.

Zrozumienie zjawiska „lost in the middle” to klucz do efektywnej pracy z dużymi modelami językowymi. Nie oznacza to, że długie konteksty są bezużyteczne – przeciwnie, pozostają niezwykle wartościowe. Trzeba jednak pamiętać o ich ograniczeniach i świadomie projektować interakcje z modelem, by maksymalnie wykorzystać jego możliwości przy jednoczesnej minimalizacji słabych punktów.

Jak badacze pracują nad powiększaniem okna kontekstowego.

Wyścig o coraz większe okna kontekstowe trwa, ale nie jest to jedyna droga rozwoju. Badacze pracują nad modelami ze zmiennym rozdzielczością uwagi, potrafiącymi automatycznie decydować, które fragmenty kontekstu wymagają szczegółowej analizy, a które można potraktować powierzchownie.

Inne obiecujące podejście to pamięć długoterminowa, modele, które potrafią zapisywać i odwoływać się do informacji z poprzednich sesji, podobnie jak ludzie pamiętają wcześniejsze rozmowy. To wymagałoby jednak fundamentalnej zmiany architektury. Nie chodzi tu o samo dodanie RAG-a, i zwykłego mechanizmu „dodatkowej pamięci”. Chat GPT funkcję pamięci wielowątkowej ma już od dawna. Tak jak pisałem wcześniej, RAG może rozwiązać część problemów wynikających wynikających z ograniczeń okna kontekstowego, natomiast nie jest on w stanie naprawić wszystkiego. W tym >>kontekście<< RAG jest po prostu prowizorycznym rozwiązaniem.

Prawdopodobnie przyszłość należy do hybrydowych rozwiązań: modele z rozsądnie dużymi oknami (10 000 – 50 000 tokenów) wspierane przez inteligentne systemy wyszukiwania i pamięci zewnętrznej. Nie każdy problem wymaga okna miliona tokenów, czasem wystarczy mądrzejszy sposób zarządzania informacją.

Jedno jest pewne: ograniczenia okna kontekstowego to fundamentalny problem, który definiuje możliwości i ograniczenia współczesnej AI. Zrozumienie go pozwala lepiej projektować systemy i nie oczekiwać od modeli niemożliwego. Bo czasem mniej znaczy więcej, jeśli wiesz, jak to wykorzystać.