Rozwój sztucznej inteligencji nie zwalnia. Przełomowe aktualizacje, etyczne dylematy i rosnąca obecność AI w codziennym życiu pokazują, że stoimy w obliczu zmian porównywalnych z rewolucją przemysłową. W sierpniu 2025 roku na pierwszy plan wysuwają się innowacje edukacyjne, zaawansowane agenty, niepokojące porównania do projektu Manhattan i próby walki o umysły badaczy.

Spis treści

Praktyczne nowości w sztucznej inteligencji. Sierpień 2025.

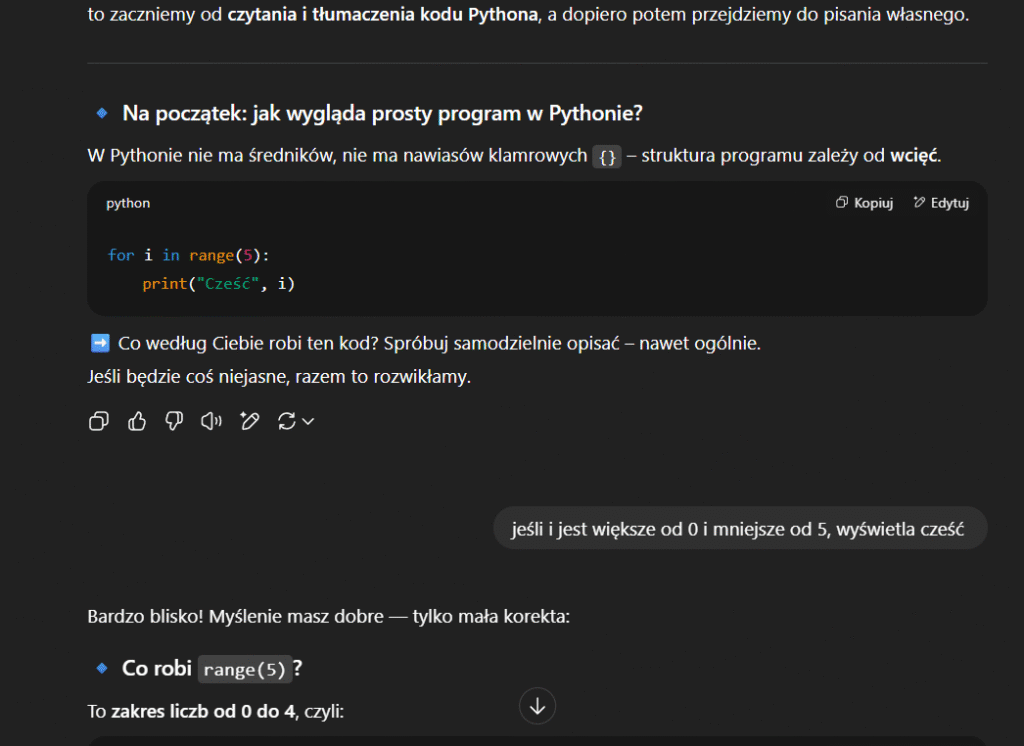

Nowa funkcja w Chat GPT: tryb nauki.

OpenAI uruchomiło nowy tryb nauki w ChatGPT, który ma ambicję stać się cyfrowym korepetytorem z prawdziwego zdarzenia. W odróżnieniu od klasycznego trybu pytanie–odpowiedź, nowa funkcja prowadzi użytkownika przez materiał krok po kroku: zadaje pytania pomocnicze, dopasowuje poziom trudności, zachęca do refleksji. Twórcy współpracowali z pedagogami, stosując zasady takie jak metakognicja czy zarządzanie obciążeniem poznawczym.

Celem nie jest szybkie udzielanie odpowiedzi, lecz uczenie się myślenia. To reakcja na rosnący problem oszustw edukacyjnych – tylko w Wielkiej Brytanii w zeszłym roku zanotowano prawie 7000 przypadków nadużyć związanych z AI. OpenAI przyznaje, że nie rozwiąże to całkowicie problemu; niezbędna jest też zmiana podejścia do oceniania w edukacji.

Studentka Maggie Wang przyznała, że po trzygodzinnej sesji z tym trybem wreszcie zrozumiała sinusoidalne kodowanie pozycyjne – temat, który wcześniej był dla niej zupełnie niezrozumiały. Porównała go do niestrudzonego, cierpliwego nauczyciela.

Nowy tryb agenta w Chat GPT

Nowy tryb Agentów w ChatGPT to znaczący krok w stronę realnej autonomii sztucznej inteligencji. OpenAI udostępniło tę funkcję w lipcu 2025 roku użytkownikom planów Pro, Plus i Team. W praktyce oznacza to, że ChatGPT nie tylko odpowiada na pytania, ale potrafi samodzielnie realizować złożone zadania – od przeglądania internetu i wypełniania formularzy, po przygotowywanie prezentacji i analizę danych. Tryb Agent nie jest osobnym modelem, lecz rozszerzeniem istniejących modeli (takich jak GPT‑4o), które zyskują dostęp do narzędzi, przeglądarki i wirtualnego komputera. Całość działa w czasie rzeczywistym i umożliwia użytkownikowi śledzenie postępów na ekranie.

Działanie tego trybu przypomina pracę wirtualnego asystenta. Użytkownik zleca zadanie w naturalnym języku, może to być np. „zaplanuj podróż do Lizbony i znajdź trzy hotele z oceną powyżej 8” – a Agent przechodzi do działania: otwiera strony, analizuje dane, porównuje opcje, a następnie prezentuje rezultat, nierzadko w formie pliku czy tabeli. Jeśli zadanie wymaga decyzji lub działania, które może mieć konsekwencje (np. dokonania zakupu, wysłania maila), Agent wstrzymuje się i prosi użytkownika o potwierdzenie. Można go w każdej chwili zatrzymać, przejąć kontrolę lub zmodyfikować instrukcję.

Funkcja Agentów integruje się także z popularnymi usługami, takimi jak Gmail, Google Drive czy GitHub, co umożliwia tworzenie dokumentów, analizowanie arkuszy kalkulacyjnych lub zarządzanie projektami bezpośrednio z poziomu ChatGPT. Możliwości są szerokie – można zautomatyzować codzienne czynności, tworzyć spersonalizowane raporty, harmonogramy, a nawet listy zakupów. W testach agent potrafił np. przygotować plan posiłków na tydzień, wygenerować listę zakupów, porównać oferty sklepów i przedstawić wszystko w przejrzystej tabeli.

Najprostsze zastosowanie: Webscraping, i zbieranie informacji z wielu użytecznych miejsc. Z tworzeniem ładnych raportów, tryb agenta nie radzi sobie najlepiej.

Tworzenie spójnych postaci z jednego zdjęcia

Startup Ideogram zaprezentował narzędzie, które potrafi wygenerować spójne postacie na podstawie jednego zdjęcia – zachowując twarz, fryzurę, kąt padania światła. Przydatne m.in. dla twórców komiksów, gier czy awatarów. To rozwiązanie zbliża nas do epoki hiperpersonalizowanej grafiki.

Microsoft Edge z Copilotem

Nowy tryb Copilot w przeglądarce Edge analizuje wszystkie otwarte karty, tworzy podsumowania i porównania. Umożliwia sterowanie głosem i posiada ujednolicony pasek interakcji. To kolejny krok w kierunku „przeglądarki asystującej” – czyli miejsca pracy wspomaganego przez AI.

Google AI Search i mobilna kamera na żywo

Google rozwija swój AI Search, umożliwiając przesyłanie obrazów i wkrótce plików PDF. Nowe narzędzie Canvas pozwala planować zadania w sposób wizualny. Na urządzeniach mobilnych dostępne jest wyszukiwanie na żywo przy pomocy kamery – to realny krok ku rozpoznawaniu otaczającego świata w czasie rzeczywistym.

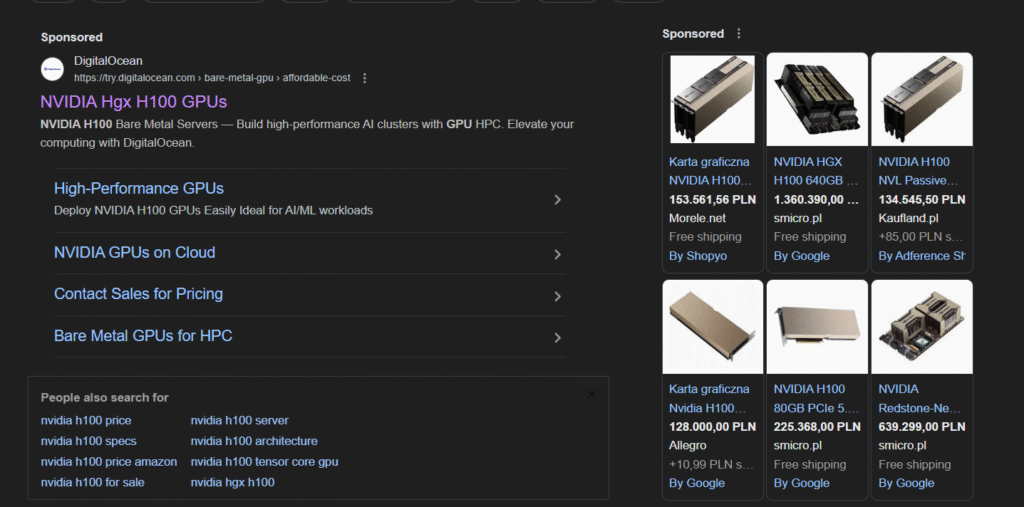

Nvidia Llama Neotron Super 1.5 – lider w benchmarkach

Nowa wersja modelu Llama Neotron Super 1.5 osiąga rekordowe wyniki w benchmarkach z matematyki, rozumowania, kodowania i czatu. Co ważne – działa wydajnie na pojedynczym GPU Nvidia H100. To potencjalnie ogromna zmiana dla firm, które chcą rozwijać własne modele lokalnie, bez potrzeby korzystania z gigantycznych superkomputerów. Choć komputer korzystający z kart graficznych kosztujących ponad 100 tys. zł, nie jest tanim rozwiązaniem, natomiast średnie i większe firmy mogą sobie na to pozwolić.

Adobe Photoshop – AI pomagające modyfikować zdjęcia.

Photoshop otrzymał trzy znaczące funkcje AI:

- Harmonize – automatyczne dopasowanie oświetlenia i tonów obiektów wstawianych do obrazu;

- Generative Upscale – poprawa jakości zdjęć do 8 megapikseli;

- Ulepszone usuwanie obiektów – teraz skuteczniejsze i szybsze.

Ai newsy

AI Agents: sztuczna inteligencja przechodzi testy CAPTCHA. Jak bardzo „ludzka” już jest?

W eksperymencie z udziałem agentów ChatGPT osadzonych w bezpiecznym środowisku testowym z dostępem do internetu, AI zdołała przejść test CAPTCHA chroniący witryny przy pomocy systemu Cloudflare Turnstyle. Agenci kliknęli pole „Weryfikuj, że jesteś człowiekiem”, a system nie zakwestionował ich tożsamości – nie uruchomił dodatkowych zadań obrazkowych.

Turnstyle analizuje subtelne sygnały: sposób poruszania myszą, odcisk przeglądarki, historię IP. Agenci AI zachowywali się wystarczająco naturalnie, by nie wzbudzić podejrzeń. Co więcej, z powodzeniem wykonywali później złożone zadania, np. zamawiali artykuły spożywcze.

To nie tylko techniczny przełom, to sygnał, że linia między „człowiekiem” a „botem” zaczyna się zacierać.

Sam Altman: „Testowanie GPT-5 to jak projekt Manhattan”

Szef OpenAI, Sam Altman, porównał testowanie modelu GPT-5 do prac nad bronią jądrową. Według niego, GPT-5 nie tylko odpowiada szybciej – on rozumie. Wskazuje na rosnącą „świadomość kontekstową” modeli i potrzebę radykalnego zwiększenia nadzoru.

Altman ubolewa nad tym, że „nie ma dorosłych w pokoju” – instytucje regulacyjne nie nadążają za tempem rozwoju AI. Jego wypowiedź jest ostrzeżeniem: wchodzimy na teren, który może przynieść nie tylko korzyści, ale i realne ryzyko dla społeczeństwa.

Z drugiej strony, Sam Altman znany jest z wyolbrzymiania znaczenia i możliwości aktualnych modeli sztucznej inteligencji.

1 miliard dolarów? Nie wystarczy. Meta odbija się od ściany wartości

Mark Zuckerberg i Meta Labs chcieli przeciągnąć do siebie czołowych badaczy AI, oferując im nawet miliard dolarów w ciągu kilku lat. Na celowniku znaleźli się m.in. członkowie zespołu Mery Morati z Thinking Machines Lab. Wszyscy odrzucili ofertę.

To pokazuje, że w świecie badaczy AI pieniądze przestały być jedyną walutą. Ważniejsze są zaufanie, wartości i autonomia naukowa. W czasach, gdy technologia wkracza w sfery etyki, decyzje personalne nabierają głębszego sensu.

Apple „killer quarter” firma kupuje czas na strategię AI

Apple opublikowało raport za trzeci kwartał fiskalny 2025 roku, bijąc oczekiwania analityków: przychód przekroczył 94 mld USD, dzięki 13‑procentowemu wzrostowi sprzedaży iPhone’ów (44,6 mld USD), przy czym usługi osiągnęły rekordowe 27,4 mld USD. Długofalowy kurs akcji skrócił się po publikacji tylko o 2‑3 proc, co dało sygnał, że rynek uznał tę stabilność, choć z rezerwą co do dalszych inwestycji w AI. CEO Tim Cook zapowiedział znaczące wydatki na sztuczną inteligencję, a także potencjalne przejęcia: w grę wchodzi startup Perplexity AI. Analitycy ostrzegają jednak: Apple nadal pozostaje w tyle za Nvidia i Microsoftem w kluczowych rozwiązaniach AI, m.in. w opóźnionym wdrożeniu nowego, LLM‑owego Siri. Zwracają uwagę, że choć firma ma mocny kwartalny wynik, to dalsze sukcesy zależą od szybkości integracji AI i jasności strategii

Reklamy w rozmowach z Alexą? Kontrowersyjna wizja CEO Amazona

TechCrunch donosi (data: 31 lipca 2025 r.), że CEO Amazona rozpoczął przygotowania do wdrożenia reklam bezpośrednio w rozmowach z Alexą, generowanych przez użytkowników poleceń głosowych. Chodzi o sytuacje, gdy system wygłasza odpowiedź lub podpowiada: w tych momentach pojawiałyby się reklamy dostosowane do kontekstu interakcji, np. „Najbliższa lodziarnia: poprzez sponsorowaną wiadomość”. Firma argumentuje, że to naturalne przedłużenie modelu monetyzacji usługi, jednak eksperci wskazują ryzyko pogorszenia jakości doświadczenia użytkownika i erozji zaufania, zwłaszcza w kontekście prywatności i użycia danych głosowych.

Google AI wprowadza TTD‑DR – Test‑Time Diffusion Deep Researcher

Zespół Google Cloud AI Research (m.in. Rujun Han, Yanfei Chen i inni) opublikował ramy nowego frameworku TTD‑DR, który modeluje tworzenie raportu badawczego jako proces dyfuzji testowej. System rozpoczyna od „szorstkiego” szkicu wniosku, a następnie iteracyjnie go udoskonala każdorazowo wykonując wyszukiwanie brakujących informacji (retrieval), analizując lukę (gap analysis), a potem dopracowując szkic. Cały pipeline optymalizuje sam siebie poprzez algorytm samorozwoju (self‑evolution), który generuje, oceniania i łączy lepsze warianty planów badawczych, zapytań, odpowiedzi i finalnego tekstu. W porównaniu z innymi agentami DRA (np. OpenAI Deep Research), TTD‑DR osiąga co najmniej statystycznie istotnie lepsze wyniki w złożonych benchmarkach wymagających wieloetapowego rozumowania.

Czy nazwa odnosi się do słynnego skróty Tl;Dr (too loong, don’t read)? Nie wiem, ale się domyślam.

Co to wszystko oznacza?

Nowości, które wprowadzają OpenAI, Google, Microsoft, Nvidia, Adobe czy Ideogram, łączy jeden wspólny mianownik: przesunięcie AI z pozycji narzędzia do roli współpracownika. AI przestaje być tylko wsparciem. Coraz częściej staje się podmiotem – doradcą, nauczycielem, negocjatorem.

Z drugiej strony pojawia się rosnąca potrzeba refleksji i regulacji. Altman nieprzypadkowo mówi o projekcie Manhattan – GPT-5 i jego potomkowie mogą wpłynąć na społeczeństwo równie głęboko jak wynalezienie bomby atomowej.

Równocześnie obserwujemy powrót do wartości w nauce – pieniądze przestają być jedynym argumentem. Badacze chcą wpływać na kierunek rozwoju technologii, a nie tylko liczyć zyski.

Sztuczna inteligencja nie jest już czymś, co „kiedyś może zmieni świat”. Ona już go zmienia – codziennie, po cichu, ale nieodwracalnie.

Jako użytkownicy i twórcy musimy nauczyć się nie tylko korzystać z AI, ale i rozumieć, co znaczy być człowiekiem w czasach, gdy maszyna potrafi przejść test CAPTCHA.

Źródła: