Po Chat GPT 3.5 w Listopadzie 2022 roku, wydawało się że Google zostało w tyle w wyścigu o sztuczną inteligencje. Odpowiedź Googla na działania Open AI, czyli ChatBot Bard, był po prostu kiepski, a AI Overviews (czyli streszczenia stron wyświetlane w wyszukiwarce) radziły ludziom np. dodawać klej do pizzy.

To jak kiepsko radziło sobie Google, było dla wielu ludzi sporym zaskoczeniem. W końcu to firma której istnienie od początku było oparte na algorytmach, uczeniu maszynowym i sztucznej inteligencji. To badacze Google w 2017 roku stworzyli legendarny papier: „Sttention is all you need”, będący podstawą architektury transformerów i LLM-ów (czyli modeli językowych). Pojawiały się nawet głosy że Chatboty zastąpią wyszukiwarkę Google, i że samo SEO (optymalizacja strony firmy pod Google) już nie wystarczy , i trzeba rozwijać GEO (Generative Engine Optimization) czy AISEO, czyli dbać o to żeby chatboty polecały daną firmę. Wielu ludzi zakładało że Google jest zbyt dużą, zbyt skostniałą firmą, żeby odpowiednio zareagować na zaistniała sytuacje.

Parę miesięcy temu pisałem o tym że Google w końcu robi dobre AI. Gemini, czyli następna Barda, działało dużo lepiej, a na szczególną uwagę zasługuje Notebook LM, czyli nowy typ produktu AI, bazujący na modelach językowych, ale skonfigurowany pod przetwarzanie danych które użytkownik dostarczy.

Obecnie okazuje się że Google nie tylko dogoniło czołówkę, ale znalazło się na czele wyścigu, i jest na dobrej drodze żeby zostać niekwestionowanym liderem. Kluczowa była premiera modelu Gemini 3, który okazał się lepszym modelem niż Chat GPT 5, mający premierę niewiele wcześniej.

Na czym polega przewaga Google? Ekosystem, którego nie ma Open AI.

Google nie wygrało dzięki jednemu chatbotowi ani efektownym premierom. Jego przewaga jest strukturalna i wielowarstwowa. Firma kontroluje cały stos AI, od projektowania własnych chipów TPU,(opartych na tensorach, a nie kartach graficznych) przez centra danych i usługi chmurowe, aż po modele językowe i gotowe produkty używane codziennie przez miliardy ludzi. Dzięki temu obniża koszty tam, gdzie konkurenci muszą płacić zewnętrznym dostawcom, optymalizuje całość systemu zamiast pojedynczych elementów i szybciej wdraża nowe funkcje w skali globalnej.

Do tego dochodzi ogromny ekosystem, Gmail, Wyszukiwarka, YouTube, Android, Mapy, który sprawia, że AI staje się naturalnym dodatkiem do narzędzi już używanych, a nie osobną aplikacją za którą trzeba dodatkowo płacić.

Mechanizm działa następująco: jeśli ktoś już płaci za Google Workspace (czyli bardziej profesjonalny Dysk Google), i ma od razu dostęp do Gemini również w aplikacjach biurowych, to po co ma płacić osobno za Chat GPT?

Wyszukiwarka Google, YT, Mapy, autonomiczne samochody Waymo dostarczają Google ogromne ilości danych, które mogą być użyte do trenowania modeli.

W połączeniu z własną infrastrukturą, rosnącą rentownością Google Cloud, zapleczem badawczym i finansowym oraz uwolnieniem się od najcięższych ograniczeń antymonopolowych, tworzy to przewagę, której dziś żadna inna firma nie jest w stanie łatwo podważyć.

Gemini 3, Veo 3.2., Nano Banana Pro Pokazały że Google nie tylko dorównuje Chatowi GPT, ale potrafi go przewyższyć. Co prawda regularnie rożne modele znajdują się na szczytach benchmarków, Claude czy Grok też ma takie osiągnięcia, ale w tym wypadku efekt był dużo większy, a zmiana bardziej trwała. Gemini 3 szczególnie skuteczne jest przy projektowaniu graficznego wyglądu programów (UX), a takie prototypowanie jest jednym z lepszych zastosowań vibecodowania.

Ai od Google przede wszystkim jest szybsze, i tańsze od rozwiązań tworzonych przez Open Ai.

Hardware projektowane pod AI

Procesory Google do AI, czyli TPU (tensor processing unit), różnią się od kart graficznych tym, że są projektowane wyłącznie do jednego zadania: masowych obliczeń tensorowych używanych w modelach AI. Nie obsługują grafiki ani szerokiego zestawu zastosowań jak GPU, za to wykonują dokładnie te operacje, które dominują w trenowaniu i uruchamianiu modeli.

GPU są elastyczne i świetnie nadają się do eksperymentów oraz rozwoju nowych modeli, dlatego są standardem w startupach i badaniach. TPU wchodzą do gry wtedy, gdy AI działa w skali przemysłowej: musi być tania, szybka, energooszczędna i stabilna. Dzięki ścisłej integracji z centrami danych Google pozwalają uruchamiać modele taniej niż na kartach kupowanych od zewnętrznych dostawców.

GPU to uniwersalne narzędzie do pracy i testów, a TPU to wyspecjalizowana infrastruktura do masowego użycia AI w gotowych produktach.

Jak Chat GPT uratował Google

Paradoksalnie, popularność Chata GPT, pomogła Google. W 2020 roku firma stanęła przed federalnym procesem antymonopolowym, oskarżona o nielegalne monopolizowanie rynku wyszukiwania. Groźba rozbicia koncernu była realna, Chrome, Android, możliwe oddzielenie kluczowych aktywów mogło na zawsze zmienić kształt firmy.

Paradoksalnie, pojawienie się ChatGPT w listopadzie 2022 roku stało się dla Google nieoczekiwanym wybawicielem. Po raz pierwszy od lat pojawił się realny konkurent dla podstawowego biznesu wyszukiwania, który generuje ponad 100 miliardów dolarów rocznie z reklam. Gdy sędzia w 2024 roku rozważał środki zaradcze, krajobraz konkurencyjny był radykalnie inny niż dwa lata wcześniej. Ostatecznie zrezygnowano z podziału firmy, uznając że AI wniosła wystarczającą konkurencję.

Efekt? Google wyszło z procesu wzmocnione, z zachowaną pełną integracją pionową i wolnością strategicznego manewru, której konkurenci mogą tylko pozazdrościć.

Stos sztucznej inteligencji (stack AI) Pięć kluczowych składników modeli językowych.

Żeby zrozumieć, dlaczego niektóre firmy dominują w erze sztucznej inteligencji, a inne zostają w tyle, trzeba spojrzeć na AI nie jak na pojedynczy produkt, lecz jako na złożony stos technologiczny składający się z pięciu fundamentalnych warstw.

Warstwa 1: Projektowanie chipów (Silicon)

Na samym dole znajdują się specjalistyczne układy scalone zaprojektowane do obliczeń AI. To nie są zwykłe procesory – to chipy zoptymalizowane pod konkretne operacje matematyczne (mnożenie macierzy, obliczenia tensorowe), które stanowią rdzeń uczenia maszynowego. Nvidia z GPU A100 i H100 dominowała tu przez lata, ale pojawiają się alternatywy jak TPU Google, Trainium Amazona czy chipy projektowane przez Apple.

Kto kontroluje projekt chipów, kontroluje ekonomikę całego stosu, może obniżać koszty i optymalizować wydajność w sposób niedostępny dla firm kupujących sprzęt od zewnątrz.

Warstwa 2: Centra danych (Infrastructure)

Tysiące tych chipów trzeba umieścić w ogromnych halach, zapewnić im zasilanie (często setki megawatów na obiekt), chłodzenie, łączność. To infrastruktura fizyczna wymagająca miliardowych inwestycji i lat budowy. Microsoft Azure, Amazon AWS, Google Cloud, Oracle to firmy wynajmujące tę moc obliczeniową innym.

Warstwa 3: Modele bazowe (Foundation Models)

To właściwe „mózgi” AI – wielkie modele językowe jak GPT, Claude, Gemini, Llama. Ich trenowanie kosztuje dziesiątki lub setki milionów dolarów i wymaga miesięcy obliczeń na tysiącach chipów. Model to nie tylko kod, lecz „zakodowana wiedza” wyekstrahowana z terabajtów danych treningowych.

Trenowanie najlepszych modeli wymaga dostępu do warstwy 1 i 2, ogromnych zasobów danych i najlepszych zespołów badawczych. Bariera wejścia rośnie z każdym rokiem.

Warstwa 4: Produkty i aplikacje (Applications)

To poziom, który widzi użytkownik końcowy, chatboty, asystenci, narzędzia do tworzenia treści, funkcje AI wbudowane w aplikacje. ChatGPT, Claude, Gemini, Copilot to najpopularniejsze przykłady, ale są też tysiące wyspecjalizowanych aplikacji wykorzystujących API dużych modeli.

Produkt decyduje o adopcji. Najlepszy model świata jest bezwartościowy, jeśli nikt nie potrafi z niego wygodnie korzystać. UX, integracje, ekosystem mają tu fundamentalne znaczenie.

Warstwa 5: Sprzęt konsumencki (Devices)

Fizyczne urządzenia, przez które ludzie uzyskują dostęp do AI, smartfony, laptopy, tablety, przyszłe okulary AR czy inne urządzenia noszone. Apple z iPhone’ami, Samsung z Galaxy, Google z Pixelami, kontrola hardware’u daje kontrolę nad tym, jak i kiedy użytkownik wchodzi w kontakt z AI.

Warstwy 0: Energia i Talenty

Gdy mówimy o infrastrukturze AI, nie możemy zapominać o dwóch kluczowych składnikach, czyli Energii, oraz o Naukowcach. W kontekście dużych firm technologicznych, zapewnienie energii dla swoich fabryk AI, nie jest wielkim wyzwaniem. Przykładowo, Elon Musk w celu szybkiego uruchomienia Groka, postawił na szybko elektrownie opartą na turbinach gazowych. Choć koszty takich doraźnych działań są większe, to dają firmom czas na budowanie bardziej efektywnych, tańszych źródeł prądu do swoich fabryk.

Dużo większym wyzwaniem jest pozyskanie talentów, czyli naukowców potrafiących tworzyć sztuczną inteligencję. Jest ich stosunkowo mało, bo przez ostatnich kilkanaście lat, w porównaniu do innych gałęzi informatyki, ten temat był niszowy.

Pięć fundamentalnych przewag Google w erze AI

Podczas gdy świat koncentruje się na pojedynku ChatGPT z Gemini, prawdziwa przewaga Google leży znacznie głębiej , w strukturze, którą budowało przez ostatnie dwie dekady. To nie jest historia o lepszym chatbocie, lecz o systematycznej dominacji na każdym poziomie technologicznego stosu AI.

Przewaga 1: Pełna kontrola nad infrastrukturą obliczeniową

Google jest jedyną wielką firmą technologiczną, która zaprojektowała i wdraża własne chipy AI na skalę przemysłową. TPU (Tensor Processing Units) to nie eksperyment – to podstawa wszystkich operacji AI w Google. Podczas gdy OpenAI płaci Microsoftowi (który płaci Nvidii) za każdą sekundę treningu, Google wykorzystuje własne układy scalone, eliminując pośredników i ich marże. Ekonomika jest brutalna: tam gdzie konkurenci wydają miliardy na sprzęt, Google inwestuje w R&D i rozbudowę własnych mocy.

Przewaga 2: Globalna sieć centrów danych zbudowana latami

Infrastruktura fizyczna to coś, czego nie da się szybko skopiować. Google posiada dziesiątki centrów danych na sześciu kontynentach, połączonych własnymi kablami światłowodnymi biegnącymi po dnach oceanów. Ta sieć powstała przez 25 lat i pochłonęła setki miliardów dolarów. OpenAI może mieć genialne modele, ale nie ma miejsc, gdzie mogłoby je efektywnie trenować bez wynajmowania cudzej infrastruktury. Microsoft i Amazon mają centra danych, ale nie mają własnych chipów. Google ma oboje.

Przewaga 3: Dekady doświadczenia w machine learningu

To Google wynalazło architekturę Transformer w słynnym artykule „Attention Is All You Need” z 2017 roku – technologię, która napędza wszystkie współczesne wielkie modele językowe, włącznie z GPT. Podczas gdy OpenAI musiało budować expertise od zera po 2015 roku, Google ma zespoły, które zajmują się uczeniem maszynowym od początku lat 2000. Google Brain i DeepMind to instytucje zatrudniające laureatów nagród Turinga, autorów najbardziej cytowanych publikacji AI, twórców AlphaGo i AlphaFold. Ten kapitał intelektualny i instytucjonalny to przewaga niemożliwa do szybkiego nadrobienia.

Przewaga 4: Dostęp do danych treningowych w bezprecedensowej skali

Każdego dnia przez serwery Google przepływa więcej danych niż przez jakąkolwiek inną firmę na świecie. YouTube to największa baza wideo na planecie. Google Search przetwarza 8,5 miliarda zapytań dziennie, ujawniając intencje, pytania i potrzeby ludzi w czasie rzeczywistym. Gmail, Maps, Chrome – każdy z tych produktów generuje sygnały o ludzkim zachowaniu na niespotykaną skalę. Dane to paliwo AI, a Google siedzi na największym złożu ropy na świecie. Co więcej, większość tych danych jest unikalna – nikt poza Google nie ma dostępu do historii wyszukiwania miliardów użytkowników.

Przewaga 5: Finansowa potęga pozwalająca inwestować setki miliardów

Google generuje ponad 300 miliardów dolarów przychodów rocznie, z zyskiem operacyjnym przekraczającym 80 miliardów. To daje firmie luksus długoterminowego myślenia i możliwość inwestowania dziesiątek miliardów rocznie w AI bez presji na natychmiastową rentowność. OpenAI, mimo spektakularnego sukcesu, wciąż traci miliardy dolarów rocznie i zależy od kolejnych rund finansowania. Anthropic jest w podobnej sytuacji. Google może spokojnie inwestować, eksperymentować i przeczekać konkurencję – to przewaga, której nie da się przecenić w wyścigu wymagającym kapitału na niespotykaną skalę.

Te pięć przewag tworzy system wzajemnie się wzmacniających elementów. Własne chipy obniżają koszty infrastruktury, co pozwala na większe inwestycje w badania, co prowadzi do lepszych modeli, co przyciąga więcej użytkowników, co generuje więcej danych, co poprawia modele. To klasyczne koło zamachowe – i Google ma je już w pełnym ruchu, podczas gdy konkurenci dopiero próbują je rozkręcić.

Jak Google podkopuje imperium Nvidii.

Przez ostatnią dekadę Nvidia była niekwestionowanym królem sprzętu AI. Jej GPU H100 i A100 napędzają niemal każdy znaczący model językowy na świecie. Marże sięgające 70 procent czyniły z niej najbardziej dochodową firmę półprzewodnikową w historii.

Google metodycznie podkopuje tę pozycję. TPU v5 i v6 nie tylko dorównują GPU Nvidii w wydajności, ale oferują lepszą efektywność energetyczną i integrację z infrastrukturą Google. Fakt, że Gemini 3 trenowano wyłącznie na TPU, to sygnał dla całej branży: alternatywa nie tylko istnieje, lecz działa na najwyższym poziomie.

Co więcej, Google wchodzi na tradycyjny teren Nvidii, sprzedając TPU zewnętrznym klientom. Umowa na milion chipów z Anthropic to dopiero początek. Plotki sugerują rozmowy z Meta i nawet OpenAI – strategicznymi klientami Nvidii. Jeśli Google przejmie znaczącą część tego rynku, marże Nvidii nieuchronnie spadną, a dominacja ulegnie erozji.

Google Cloud, czyli cicha maszynka do zarabiania pieniędzy

Podczas gdy świat obserwuje pojedynek chatbotów, prawdziwa walka toczy się w chmurze. Trenowanie dużych modeli językowych wymaga ogromnej mocy obliczeniowej, GPT-4 kosztowało prawdopodobnie ponad 100 milionów dolarów, a przyszłe modele będą jeszcze droższe.

Firmy takie jak Microsoft Azure czy Oracle Cloud wynajmują moc obliczeniową firmom AI. Problem w tym, że muszą kupować drogie chipy od Nvidii, płacić za energię, chłodzenie, personel, i dopiero potem dodać własną marżę. Ekonomika jest brutalna, marże w chmurze są notorycznie cienkie, a konkurencja cenowa bezlitosna.

Google gra według innych zasad. Projektując własne TPU, eliminuje marżę Nvidii. Kontrolując cały stos, optymalizuje każdą warstwę pod współpracę z pozostałymi, osiągając efektywności niemożliwe dla konkurentów kupujących komponenty z zewnątrz. Rezultat? Google Cloud może oferować AI compute taniej niż ktokolwiek inny, zachowując jednocześnie lepsze marże.

Liczby mówią same za siebie: przychody Google Cloud rosną w tempie 30 procent rocznie i stanowią już prawie 20 procent całkowitych przychodów firmy.

Ekosystem Google, system który zapewnia im przewagę.

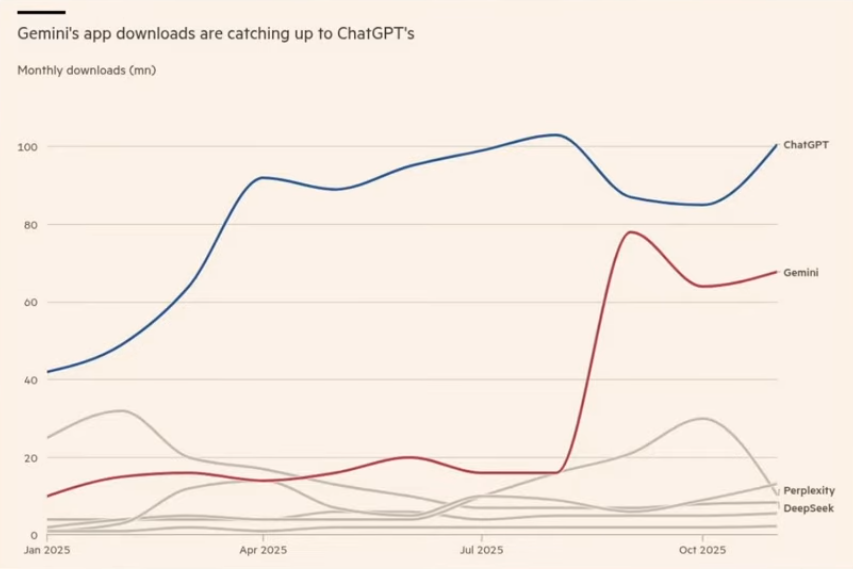

ChatGPT może mieć 900 milionów użytkowników tygodniowo, Gemini 650 milionów miesięcznie. Liczby robią wrażenie, ale koncentracja na samych chatbotach mija się z istotą strategii Google.

Prawdziwa przewaga nie leży w osobnej aplikacji, lecz w miliardy razy powielonym nawyku. Według danych z 2024 roku, Chrome ma ponad 60 procent udziału w rynku przeglądarek, Gmail obsługuje 1,8 miliarda użytkowników, Android działa na 70 procentach światowych smartfonów, YouTube przyciąga 2,5 miliarda użytkowników miesięcznie, a Wyszukiwarka Google przetwarza 8,5 miliarda zapytań dziennie.

Jest to zintegrowany ekosystem, w którym każda usługa wzmacnia pozostałe. Gdy Google wplata AI w Gmail (pomoc w pisaniu emaili), Docs (automatyczne formatowanie), Search (bezpośrednie odpowiedzi), Maps (sugestie tras uwzględniające kontekst), produkt staje się „lepki”. Koszt przejścia na konkurencję nie ogranicza się do zmiany chatbota, wymagałby opuszczenia całego, starannie skonstruowanego świata cyfrowego, co dla większości użytkowników jest praktycznie niemożliwe.

OpenAI może mieć lepszego chatbota. Nie ma jednak szans na odtworzenie dekad inwestycji w ekosystem, z którego korzysta dosłownie połowa ludzkości.

Krytyczna perspektywa: Czy Google naprawdę wygrało?

Mimo przekonującej tezy o dominacji Google, warto zachować zdrowy sceptycyzm. Historia technologii pełna jest przykładów gigantów, którzy wydawali się niewzruszeni, IBM w mainframe’ach (sprzęcie), Microsoft w systemach operacyjnych, Nokia w telefonach, a ostatecznie zostali zdetronizowani przez zwinniejszych rywali.

Potencjalne słabości strategii Google:

Paradoks innowacji: Duże firmy z ustabilizowanymi strumieniami przychodów często mają problem z rewolucyjnymi innowacjami. Google zarabia 100+ miliardów rocznie na reklamach w wyszukiwaniu. Czy naprawdę chce zastąpić to modelem konwersacyjnym, który może zredukować klikalność reklam? Ten konflikt interesów może hamować radykalne innowacje.

Kultura korporacyjna: Google ma reputację firmy, która uruchamia setki projektów, by później je porzucać (Google+, Google Wave, Stadia, niezliczone komunikatory). Czy ta kultura eksperymentowania jest odpowiednia dla epoki, która wymaga długoterminowego zaangażowania w jedną wizję AI?

Wyzwania regulacyjne: Mimo złagodzenia sprawy antymonopolowej w USA, Google wciąż boryka się z regulatorami w Europie, procesami dotyczącymi Google Play, Android, czy dominacji w reklamie online. Pionowa integracja, która jest ich siłą, może stać się celem kolejnych interwencji regulacyjnych.

OpenAI i Microsoft: OpenAI, mimo braku własnej infrastruktury, ma jedno kluczowe: uwagę deweloperów. API GPT obsługuje miliony aplikacji. Microsoft, jako partner, oferuje dystrybucję przez Office 365 (400+ milionów płacących użytkowników) i Azure.

Z drugiej strony, możliwe jest tez że Open AI stworzy własny ekosystem biurowy.

Antropic i Claude: Choć mniejszy, Anthropic (twórca Claude) przyciąga najlepsze talenty i wyróżnia się naciskiem na bezpieczeństwo AI, co może być przewagą w epoce rosnących obaw o alignment. Claude cieszy się wyjątkowo pozytywną reputacją wśród zaawansowanych użytkowników i programistów.

Czy istnieje jakakolwiek firma AI, która naprawdę może grać na poziomie Google?”

Odpowiedź zależy od tego, jak definiujemy „grę”. Jeśli chodzi o kontrolę całego stosu technologicznego, prawdopodobnie tylko Apple ma podobne możliwości, choć dotychczas nie wykorzystało tego potencjału w AI. Sztuczna Inteligencja od Apple, nazwana szumnie: „Apple Inteligencje”, okazała się katastrofą. Co więcej, Apple zamierza w swoich produktach umieścić chatboty od Google. I być może wymagało by to odejścia od dość zamkniętego ekosystemu, gdzie część ograniczeń była celowo budowana przez Apple.

Meta ma sprzęt i ogromną sieć społecznościową, ale brakuje jej warstwy produktów użytkowych poza Facebookiem i Instagramem. Microsoft ma Azure i Office, ale nie kontroluje (na taką skalę) sprzętu ani chipów.

Jeśli jednak pytamy o możliwość stworzenia lepszego modelu językowego lub zbudowania bardziej użytecznego narzędzia AI, historia pokazuje, że przełomy często przychodzą z niespodziewanych miejsc. Google samo było kiedyś małym startupem, który pokonał gigantów takich jak Yahoo czy Microsoft.

Być może prawdziwe pytanie nie brzmi „czy ktoś może konkurować z Google”, lecz „czy pionowa integracja jest rzeczywiście optymalną strategią dla ery AI”. Otwarte modele (Llama od Meta, Mistral), specjalizacja (Anthropic w bezpieczeństwie, Perplexity w wyszukiwaniu), czy zupełnie nowe paradygmaty interakcji mogą okazać się bardziej odpowiednie niż uniwersalny ekosystem kontrolowany przez jedną firmę.

Wnioski. Google ma strukturową przewagę, przydatną w długiej grze

Niezależnie od przyszłych zwrotów akcji, obecna pozycja Google jest imponująca i trudna do podważenia. Pięciowarstwowa integracja pionowa tworzy samonapędzający się system: własne chipy obniżają koszty chmury, co czyni trenowanie modeli tańszym, co pozwala na lepsze produkty, co przyciąga więcej użytkowników, co generuje więcej danych, co poprawia modele. To klasyczne koło zamachowe strategiczne.

Dodajmy do tego dziesięciolecia doświadczenia w machine learningu (Google wynalazło architekturę Transformer, która napędza wszystkie współczesne LLM), światowej klasy zespoły badawcze (Google DeepMind), i praktycznie nieograniczone zasoby finansowe.

Czy wyścig AI dobiegł końca? Prawdopodobnie nie. Ale Google bezsprzecznie ma pole position, najlepszy samochód i największy team mechaników. W długiej grze o dominację w erze AI, Mountain View ma wszystkie karty, a konkurencja dopiero się dowiaduje, że gra toczy się na pięciu różnych frontach jednocześnie.

Pozostaje pytanie, czy to dobrze dla innowacji, użytkowników i społeczeństwa jako całości. Historia technologii sugeruje, że koncentracja władzy, nawet w rękach sprawnej firmy, rzadko prowadzi do najlepszych wyników długoterminowych. Ale to już temat na zupełnie inny artykuł.

Tekst w istotnej części bazuje na tym filmie, choć dodałem tam trochę własnych rozkmin.