Pod koniec 2022 roku stało się coś dziwnego. Miliony ludzi na całym świecie, po raz pierwszy w historii, zaczęły prowadzić swobodne rozmowy z nieludzką inteligencją. Nazywała się ChatGPT i w ciągu kilku tygodni stała się globalnym fenomenem, najszybciej adoptowaną technologią w dziejach ludzkości. Dla wielu był to szok – nagłe pojawienie się czegoś, co do tej pory należało do sfery science fiction. Jednak to, co wyglądało na rewolucję z dnia na dzień, w rzeczywistości było kulminacją snu starego jak sama cywilizacja: marzenia o stworzeniu sztucznego umysłu.

Historia sztucznej inteligencji (AI) to nie jest prosta, linearna opowieść o postępie technologicznym. To raczej burzliwa saga pełna cykli, w której filozoficzne marzenia rozbijają się o inżynieryjną rzeczywistość, a kilka kluczowych przełomów raz po raz na nowo definiuje to, co niemożliwe. To podróż, która prowadzi nas od glinianych olbrzymów z antycznych mitów, przez gabinety filozofów i zakurzone laboratoria uniwersyteckie, aż po serwerownie wielkości miast, które dziś napędzają nasz cyfrowy świat.

Aby zrozumieć, jak dotarliśmy do tego momentu, musimy cofnąć się w czasie – nie o dekady, ale o tysiąclecia. Prześledzimy starożytne echa tej idei, poznamy ojców założycieli, którzy w akcie niemal zuchwałego optymizmu ochrzcili nową dziedzinę nauki, przeżyjemy bolesne „zimy AI”, kiedy entuzjazm zamarzał, a finansowanie wysychało, i wreszcie przyjrzymy się trzem wielkim falom rewolucji XXI wieku, które doprowadziły do obecnej eksplozji. To opowieść o tym, jak ludzkość próbowała zamknąć ducha w maszynie.

Spis treści

| Okres | Kamień Milowy | Znaczenie |

| Starożytność | Mity o Golemie i Talosie; logika Arystotelesa | Ustanowienie pragnienia stworzenia sztucznego życia i pierwszych prób sformalizowania myślenia. |

| 1843 | Prace Ady Lovelace | Przewidzenie, że maszyny analityczne mogą manipulować symbolami, a nie tylko liczbami – narodziny koncepcji programowania. |

| 1950 | Test Turinga | Alan Turing proponuje praktyczny test na inteligencję maszyn, omijając filozoficzną debatę o świadomości. |

| 1956 | Konferencja w Dartmouth | Oficjalne narodziny dziedziny i ukucie terminu „sztuczna inteligencja” przez Johna McCarthy’ego. |

| 1966 | ELIZA | Stworzenie pierwszego chatbota, który ujawnił, jak łatwo ludzie antropomorfizują maszyny. |

| 1974–1980 | Pierwsza „zima AI” | Niespełnione obietnice i cięcia w finansowaniu prowadzą do załamania badań nad AI. |

| 1997 | Deep Blue pokonuje Kasparowa | Superkomputer IBM wygrywa z mistrzem świata w szachach, co symbolizuje triumf mocy obliczeniowej nad ludzką intuicją. |

| 2012 | Przełom AlexNet w konkursie ImageNet | Sieć neuronowa głębokiego uczenia deklasuje rywali w rozpoznawaniu obrazów, rozpoczynając rewolucję deep learning. |

| 2017 | Publikacja „Attention Is All You Need” | Wprowadzenie architektury Transformer, która stała się fundamentem dla nowoczesnych dużych modeli językowych. |

| 2022 | Publiczne udostępnienie DALL-E 2 i ChatGPT | Eksplozja generatywnej AI, która po raz pierwszy w historii trafia na masową skalę do rąk zwykłych użytkowników. |

Starożytność i średniowiecze: mity, logika i pierwsze Automaty

Talos i Golem

Zanim powstał pierwszy tranzystor, a nawet zanim ludzkość okiełznała elektryczność, idea sztucznej inteligencji żyła już w opowieściach. Starożytni Grecy snuli mity o Talosie – gigantycznym automacie z brązu, który strzegł brzegów Krety, rzucając głazami w statki najeźdźców. W żydowskim folklorze zrodziła się legenda o Golemie, istocie ulepionej z gliny i ożywionej mistycznym słowem, by chronić praską gminę. Te opowieści, choć fantastyczne, ujawniają fundamentalne ludzkie pragnienie: chęć powołania do życia bytu na nasze podobieństwo, obdarzonego siłą i celem, lecz stworzonego, a nie zrodzonego.

Jednak historia AI toczyła się dwoma równoległymi, przez wieki nieprzecinającymi się torami. Podczas gdy mity i legendy eksplorowały ideę sztucznego ciała, starożytna filozofia zaczęła kłaść podwaliny pod mechaniczny umysł. Arystoteles, przechadzając się po ateńskim Lykeionie, jako pierwszy podjął próbę sformalizowania ludzkiego rozumowania. Jego system sylogizmów był rewolucyjną koncepcją: zestawem ścisłych reguł, które pozwalały wyciągać logiczne wnioski z przesłanek, niezależnie od tego, kto je stosował. Była to pierwsza próba oddzielenia procesu myślenia od myślącego – stworzenia algorytmu dedukcji.

Pierwsze kalkulatory

Przez ponad dwa tysiąclecia te dwa nurty – wyobrażenie o sztucznym bycie i formalizacja myślenia – płynęły osobno. Dopiero w XVII wieku zaczęły się powoli zlewać. Blaise Pascal i Gottfried Wilhelm Leibniz, dwaj genialni matematycy, zbudowali pierwsze mechaniczne kalkulatory. Maszyna Leibniza była szczególnie przełomowa, ponieważ opierała się na systemie binarnym – języku zer i jedynek, który ponad 250 lat później stał się fundamentem ery cyfrowej. Te wczesne automaty po raz pierwszy dały fizyczną formę procesom logicznym.

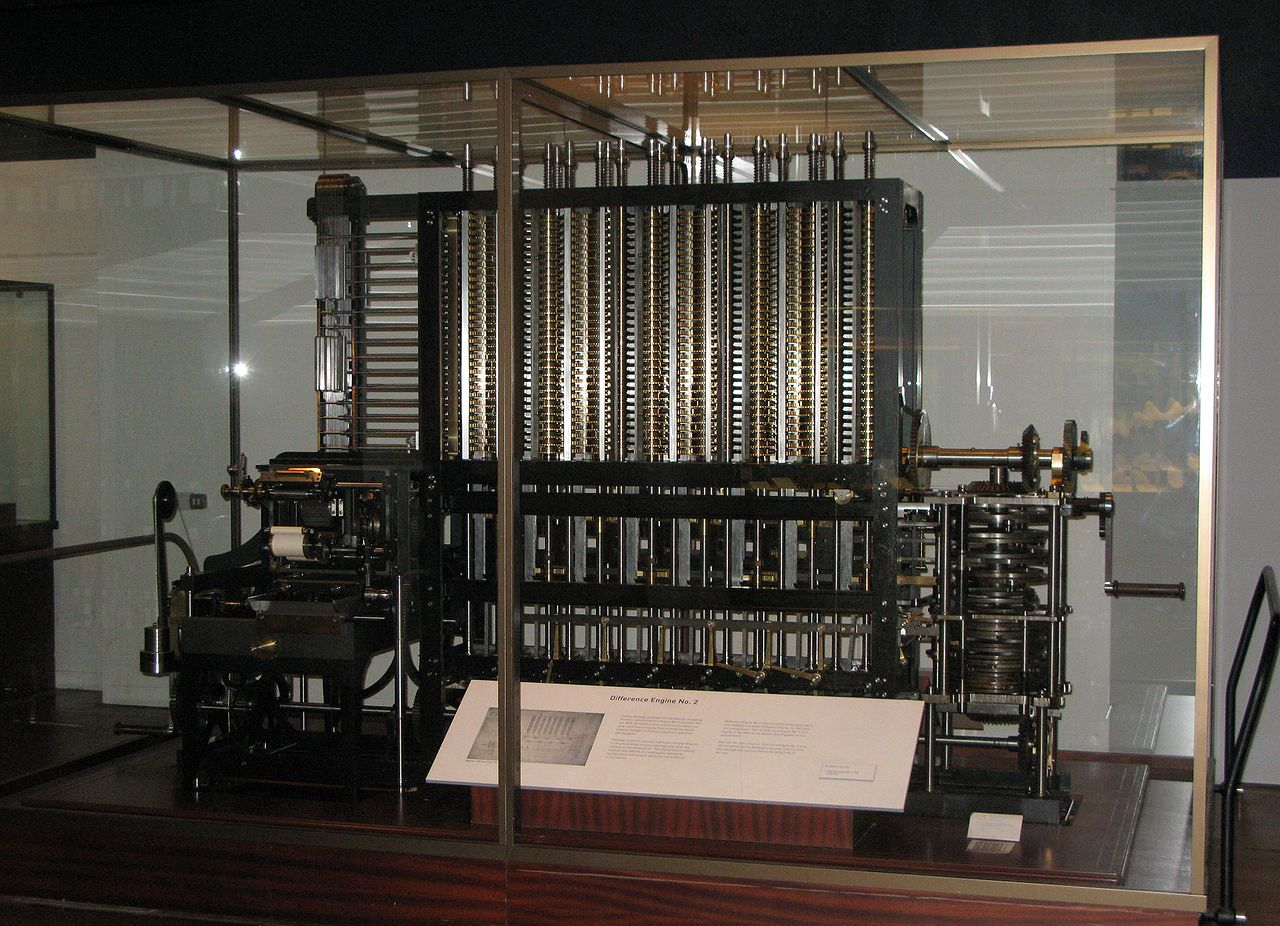

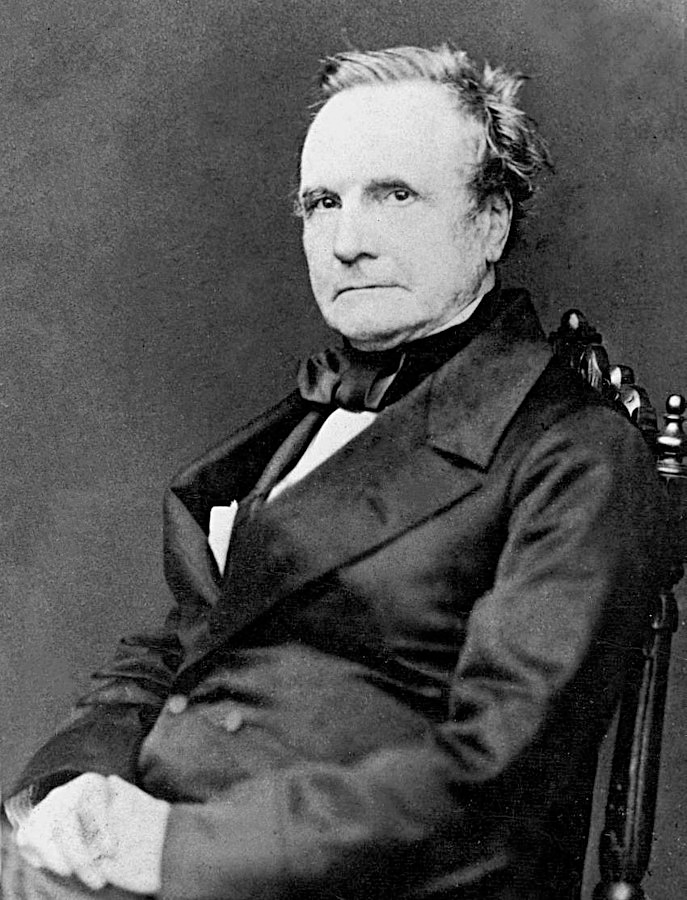

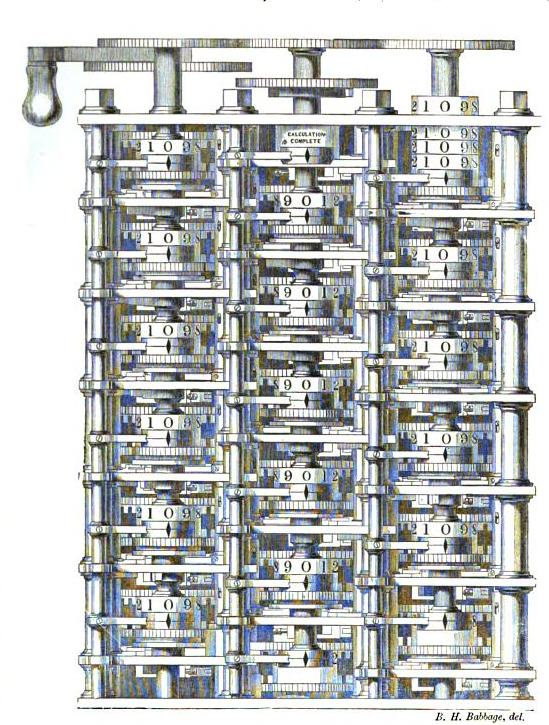

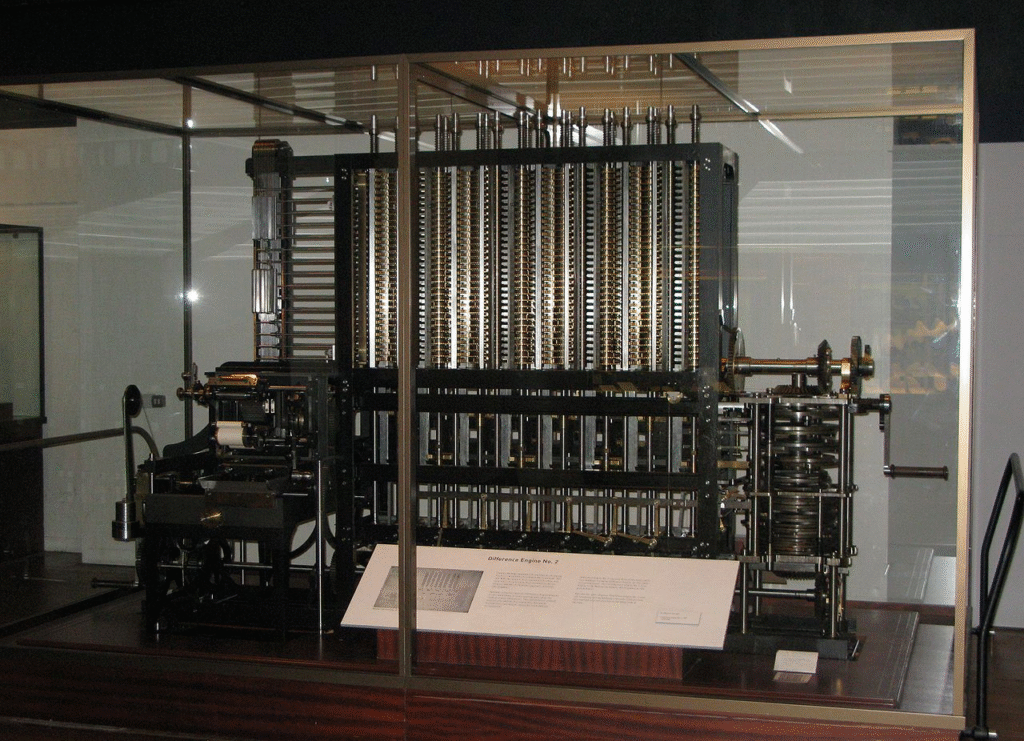

Kulminacją tej wczesnej ery mechanicznej była niedokończona praca Charlesa Babbage’a w XIX wieku. Jego maszyna analityczna, napędzana parą i programowana za pomocą kart perforowanych, była de facto projektem pierwszego komputera. To jednak jego współpracowniczka, Ada Lovelace, dostrzegła prawdziwy, rewolucyjny potencjał tego urządzenia. Zrozumiała, że maszyna Babbage’a może manipulować nie tylko liczbami, ale dowolnymi symbolami – literami, nutami, obrazami. W swoich notatkach z 1843 roku przewidziała, że takie urządzenie będzie mogło „tworzyć misterne i naukowe utwory muzyczne o dowolnym stopniu złożoności”. Była to pierwsza w historii wizja komputera ogólnego przeznaczenia – maszyny, która mogłaby symulować procesy umysłowe. Sen o Golemie i logika Arystotelesa wreszcie znalazły wspólny język.

Ojcowie Założyciele – Turing i Dartmouth. Burzliwe historia sztucznej inteligencji

Dopiero wstrząs II wojny światowej i narodziny komputera elektronicznego przekształciły te wczesne idee w realną dyscyplinę naukową. W centrum tej transformacji stał jeden człowiek: Alan Turing, brytyjski matematyk, którego genialny umysł ukształtował XX wiek. Jego praca przy złamaniu niemieckiego kodu Enigma nie tylko pomogła aliantom wygrać wojnę, ale także dała mu unikalne spojrzenie na możliwości maszyn obliczeniowych. Już w 1936 roku, na długo przed zbudowaniem pierwszego komputera, Turing opisał w teorii „uniwersalną maszynę obliczeniową” – abstrakcyjne urządzenie, które, mając odpowiedni program, mogłoby wykonać każde zadanie obliczeniowe. Był to teoretyczny dowód na to, że możliwe jest stworzenie maszyny, która może rozwiązać dowolny problem.

W 1950 roku, w artykule zatytułowanym „Maszyny liczące a inteligencja”, Turing postawił pytanie, które zdefiniowało całą dziedzinę: „Czy maszyny mogą myśleć?”. Zdając sobie sprawę, że definicje „myślenia” i „inteligencji” są grząskim gruntem filozoficznym, zaproponował genialnie proste obejście problemu: „grę w imitację”, znaną dziś jako test Turinga. W teście sędzia prowadzi rozmowę tekstową z dwiema ukrytymi postaciami – człowiekiem i maszyną. Jeśli po pięciu minutach sędzia nie jest w stanie z całą pewnością wskazać, która z nich jest maszyną, to maszynę należy uznać za inteligentną. Podejście to znane jest też testem Turinga. Turing nie pytał o świadomość czy duszę; pytał o zdolność do przekonującej konwersacji. Był też optymistą, przewidując, że do roku 2000 komputery będą w stanie oszukać sędziów w 30% przypadków.

Choć Turing dostarczył filozoficznych i teoretycznych ram, sztuczna inteligencja jako dziedzina nauki narodziła się sześć lat później, w upalne lato 1956 roku na kampusie Dartmouth College. To nie była typowa konferencja z wykładami i prezentacjami, ale raczej wielotygodniowa, swobodna „burza mózgów” zwołana przez czterech wizjonerów: Johna McCarthy’ego, Marvina Minsky’ego, Nathaniela Rochestera i Claude’a Shannona.

Samo powstanie dziedziny było świadomym aktem kreacji, a nawet marketingu. John McCarthy, młody matematyk, celowo ukuł termin „sztuczna inteligencja”, aby odróżnić swoje przedsięwzięcie od już istniejącej i zdominowanej przez postać Norberta Wienera cybernetyki. Cybernetyka skupiała się na pętlach sprzężenia zwrotnego i mechanizmach sterowania, podczas gdy McCarthy i jego koledzy mieli znacznie ambitniejszy cel: odtworzenie wyższych funkcji ludzkiego umysłu, takich jak kreatywność, abstrakcja i język. Nazwa „sztuczna inteligencja” była chwytliwa, futurystyczna i doskonale nadawała się do pozyskania funduszy.

W swoim wniosku do Fundacji Rockefellera, grupa sformułowała zdanie, które stało się credo i jednocześnie przekleństwem całej dziedziny na następne dekady: „Badanie będzie prowadzone w oparciu o przypuszczenie, że każdy aspekt uczenia się lub jakakolwiek inna cecha inteligencji może być w zasadzie tak precyzyjnie opisana, że można zbudować maszynę, która ją symuluje”. To był szczyt optymizmu. Ojcowie założyciele wierzyli, że w ciągu jednego lata, w gronie dziesięciu naukowców, uda im się poczynić znaczące postępy w rozwiązaniu problemu inteligencji. Nie mogli się bardziej mylić co do skali trudności, ale ich zuchwała wizja zapaliła iskrę, która płonie do dziś.

Złote Lata sztucznej inteligencji i pierwsze Rozczarowania – ELIZA, Shakey i zderzenie z rzeczywistością

Po konferencji w Dartmouth nastała złota era AI. Napędzani optymizmem i hojnym finansowaniem, głównie z amerykańskiego Departamentu Obrony, naukowcy zaczęli tworzyć programy, które wydawały się potwierdzać śmiałe tezy założycieli. Powstał Logic Theorist Allena Newella i Herberta Simona, który samodzielnie dowodził twierdzeń matematycznych, wprawiając w zdumienie samych autorów. John McCarthy stworzył LISP, elegancki język programowania, który na dekady stał się podstawowym narzędziem badaczy AI. Wydawało się, że maszyny rzeczywiście zaczynają myśleć.

W 1966 roku na scenę wkroczył program, który na zawsze zmienił publiczne postrzeganie AI. Joseph Weizenbaum z MIT stworzył chatbota o imieniu ELIZA. Jej mechanizm był zwodniczo prosty. Program udawał psychoterapeutę rogeriańskiego, stosując technikę aktywnego słuchania. Identyfikował w zdaniach użytkownika słowa kluczowe (np. „ojciec”, „problem”) i przekształcał je w otwarte pytania („Opowiedz mi więcej o swojej rodzinie”) lub powtarzał fragmenty wypowiedzi rozmówcy. ELIZA nie rozumiała ani słowa z prowadzonej konwersacji.

Reakcja przerosła najśmielsze oczekiwania Weizenbauma – i wprawiła go w przerażenie. Ludzie, w tym wykształceni pracownicy MIT, zaczęli traktować ELIZĘ jak prawdziwego powiernika. Dzielili się z nią najgłębszymi lękami i sekretami, spędzali godziny na „terapeutycznych” sesjach. Słynna stała się anegdota o sekretarce Weizenbauma, która po krótkiej rozmowie z programem poprosiła go, by wyszedł z pokoju, ponieważ chciała zostać z ELIZĄ sam na sam. Weizenbaum stworzył ELIZĘ, by zdemaskować powierzchowność komunikacji człowiek-maszyna, a zamiast tego odkrył „efekt ELIZY”: głęboko zakorzenioną ludzką tendencję do przypisywania maszynom zrozumienia i empatii, nawet jeśli nie ma ku temu żadnych podstaw. Zszokowany swoim dziełem, stał się jednym z najzagorzalszych krytyków AI, argumentując, że istnieją sfery ludzkiego doświadczenia, takie jak terapia, które nigdy nie powinny być automatyzowane.

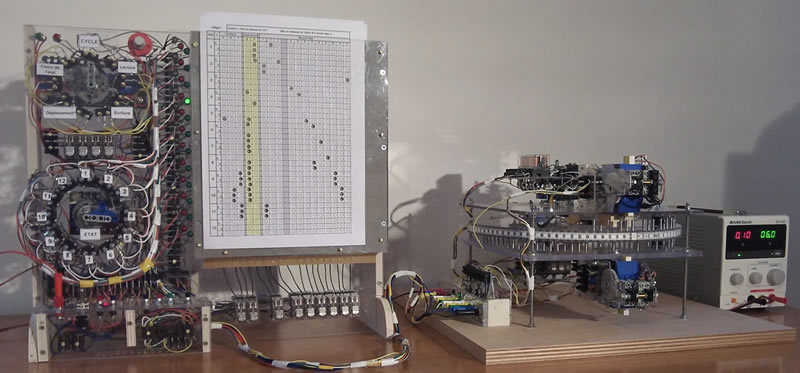

W tym samym czasie, gdy ELIZA z łatwością symulowała ludzką rozmowę w sterylnym świecie tekstu, inny projekt pokazywał, jak monumentalnie trudne jest przeniesienie inteligencji do świata fizycznego. Był to Shakey, pierwszy mobilny robot zdolny do postrzegania i rozumowania na temat swojego otoczenia, zbudowany w Stanford Research Institute (SRI) w latach 1966–1972. Shakey, którego nazwa wzięła się od jego trzęsącego się, niepewnego ruchu („it shakes like hell” – „trzęsie się jak diabli”) , był wyposażony w kamerę telewizyjną i czujniki dotykowe. Potrafił analizować swoje otoczenie, tworzyć wewnętrzną mapę pokoju z klockami i rampami, a następnie, korzystając z oprogramowania do planowania o nazwie STRIPS, wykonywać złożone, wieloetapowe polecenia, takie jak „przesuń klocek z platformy”.

Te dwa równoległe projekty obnażyły fundamentalny problem wczesnej AI. Okazało się, że symulowanie inteligentnej konwersacji jest relatywnie proste, jeśli można ograniczyć się do manipulacji symbolami. Natomiast wykonanie nawet najprostszych zadań w realnym świecie wymagało rozwiązania niezwykle złożonych problemów percepcji, planowania i radzenia sobie z nieprzewidywalnością. Ludzie z łatwością dawali się nabrać na iluzję umysłu w ELIZIE, podczas gdy powolne, niezdarne ruchy Shakey’a pokazywały, jak wielka przepaść dzieli „zabawkowe światy” wczesnych programów od złożoności rzeczywistości. Ta przepaść między obietnicami a realnymi możliwościami wkrótce miała doprowadzić do pierwszej wielkiej zapaści w dziedzinie AI.

Długie Zimy i krótkie Lata – cykle hype’u i upadku

Pod koniec lat 60. początkowy, niemal bezgraniczny optymizm zaczął ustępować miejsca rozczarowaniu. Okazało się, że metody, które świetnie sprawdzały się w rozwiązywaniu prostych, logicznych problemów, kompletnie zawodziły w konfrontacji z bardziej złożonymi wyzwaniami. Głównym winowajcą była tzw. „eksplozja kombinatoryczna”

Eksplozja kombinatoryczna

W miarę wzrostu złożoności problemu, liczba możliwych do przeanalizowania ścieżek rosła w astronomicznym tempie, przekraczając możliwości ówczesnych komputerów. Obietnice stworzenia w pełni inteligentnej maszyny w ciągu dekady okazały się mrzonką.

Możemy to zilustrować na przykładzie gry w szachy:

- W początkowych etapach gry, liczba możliwych ruchów jest relatywnie mała.

- Z każdym kolejnym ruchem liczba możliwych kontynuacji gry rośnie w ogromnym tempie. Po zaledwie kilku ruchach liczba potencjalnych ścieżek jest już tak duża, że nawet dzisiejsze, superkomputery mają trudności z ich pełnym przeanalizowaniem.

W dużym skrócie, wczesne AI opierało się na ścieżkach wyboru.

W efekcie, próby stworzenia sztucznej inteligencji, która opierałaby się na pełnym przeszukiwaniu wszystkich możliwych rozwiązań, okazały się niewykonalne dla ówczesnych komputerów. To zjawisko było jedną z głównych przyczyn, dla których obietnice szybkiego stworzenia w pełni inteligentnych maszyn w latach 50. i 60. XX wieku nie zostały spełnione. Dopiero rozwój algorytmów heurystycznych (które nie analizują wszystkich opcji, lecz wybierają te najbardziej obiecujące) i wzrost mocy obliczeniowej umożliwił radzenie sobie z tym problemem w niektórych, bardziej ograniczonych obszarach.

W 1973 roku brytyjski rząd, zaniepokojony brakiem praktycznych rezultatów, zlecił matematykowi Sir Jamesowi Lighthillowi przygotowanie raportu o stanie badań nad AI. Jego konkluzje były druzgocące. Lighthill stwierdził, że AI nie spełniła swoich szumnych zapowiedzi i nie ma szans na rozwiązanie realnych problemów w dającej się przewidzieć przyszłości. Raport, w połączeniu z podobną presją ze strony Kongresu USA, doprowadził do drastycznych cięć w finansowaniu badań. Nastała pierwsza „zima AI” – okres stagnacji, w którym entuzjazm opadł, a pieniądze na badania niemal całkowicie zniknęły.

Systemy ekspercie oparte na sztucznej inteligencji.

Odwilż nadeszła na początku lat 80. wraz z komercyjnym sukcesem „systemów ekspertowych”. Było to pragmatyczne odejście od marzeń o ogólnej, ludzkiej inteligencji na rzecz tworzenia programów wyspecjalizowanych w wąskich dziedzinach. Systemy te, takie jak MYCIN do diagnozowania infekcji bakteryjnych czy XCON do konfigurowania systemów komputerowych, opierały się na setkach, a nawet tysiącach reguł typu „jeśli-to” (if-then), które kodowały wiedzę ludzkich ekspertów. Po raz pierwszy AI stała się dochodowym biznesem, a rynek ten w połowie dekady był wart ponad miliard dolarów.

Jednak ten krótki okres prosperity również opierał się na kruchych fundamentach. Systemy ekspertowe okazały się „kruche” (brittle) – potrafiły popełniać absurdalne błędy, gdy natrafiały na sytuacje spoza ich ścisłych reguł. Były też niezwykle drogie w tworzeniu i aktualizacji, wymagając żmudnej pracy „inżynierów wiedzy”. Równocześnie na rynku pojawiły się potężne i relatywnie tanie stacje robocze firm takich jak Sun Microsystems, które sprawiły, że specjalistyczne, drogie komputery do AI, tzw. maszyny LISP-owe, stały się przestarzałe niemal z dnia na dzień. W 1987 roku rynek maszyn LISP-owych załamał się, pociągając za sobą całą branżę. Nadeszła druga, choć mniej dotkliwa, zima AI.

Te cykle boomu i kryzysu nie były jedynie wynikiem problemów technologicznych czy finansowych. Były one symptomem porażki całego dominującego paradygmatu, znanego jako „Dobra, Staromodna AI” (Good Old-Fashioned AI, GOFAI). Podejście to, wywodzące się wprost z konferencji w Dartmouth, zakładało, że inteligencję można osiągnąć poprzez ręczne programowanie symbolicznych reprezentacji świata i logicznych reguł. Zimy AI były bolesnym dowodem na to, że ten model ma swoje fundamentalne ograniczenia. Ręczne kodowanie wiedzy o świecie jest zadaniem niewykonalnym, a systemy oparte na sztywnych regułach nie potrafią uczyć się, adaptować ani radzić sobie z niejednoznacznością realnego świata. Te porażki zmusiły pole do bolesnego, ale koniecznego zwrotu w kierunku zupełnie nowej idei: zamiast programować inteligencję, można by pozwolić maszynom, aby uczyły się jej same.

Punkt zwrotny – Kasparow kontra Deep Blue

W maju 1997 roku świat wstrzymał oddech. W Nowym Jorku do rewanżowego pojedynku zasiedli Garri Kasparow, panujący mistrz świata w szachach i przez wielu uważany za największego gracza w historii, oraz jego przeciwnik – superkomputer IBM o nazwie Deep Blue. To nie była zwykła partia szachów. To był starannie wyreżyserowany spektakl, starcie człowieka z maszyną, symboliczny pojedynek ludzkiej intuicji, kreatywności i strategicznej głębi z zimną, nieubłaganą logiką krzemu.

Deep Blue nie był inteligentny w ludzkim rozumieniu tego słowa. Nie „rozumiał” szachów, nie czuł piękna kombinacji, nie miał intuicji. Był za to potworem obliczeniowym, maszyną zbudowaną w jednym celu: do analizy pozycji szachowych. Dzięki swojej masywnie równoległej architekturze był w stanie ocenić do 200 miliardów pozycji na sekundę. Jego „inteligencja” polegała na brutalnej sile obliczeniowej, na zdolności do zajrzenia w przyszłość partii na tyle głęboko, by wybrać ruch o najwyższej statystycznej wartości.

Rok wcześniej, w 1996 roku, Kasparow wygrał pierwszy mecz, wykorzystując swoją nieprzewidywalność i zmieniając styl gry, by zdezorientować maszynę. Jednak w rewanżu IBM znacznie ulepszył swój program. Mecz był niezwykle zacięty i pełen dramaturgii. Kasparow był pod ogromną presją psychologiczną. W pewnym momencie oskarżył zespół IBM o oszustwo, gdy komputer wykonał ruch, który wydawał mu się zbyt „ludzki”, zbyt subtelny jak na maszynę. Kulminacja nastąpiła w szóstej, decydującej partii. Po zaledwie 19 ruchach, w pozycji, która zdaniem wielu analityków wciąż była do obrony, Kasparow, wyraźnie zdemoralizowany, poddał partię. Po raz pierwszy w historii panujący mistrz świata w szachach został pokonany przez komputer w warunkach turniejowych.

Zwycięstwo Deep Blue było symbolicznym trzęsieniem ziemi. Dla opinii publicznej był to dowód, że sztuczna inteligencja dogania, a nawet przewyższa ludzką. W rzeczywistości jednak to wydarzenie oznaczało coś innego. Było symbolicznym końcem romantycznej wizji AI jako próby stworzenia maszyny, która myśli i rozumuje jak człowiek. Deep Blue nie wygrał, bo był mądrzejszy od Kasparowa w ludzkim sensie. Wygrał, bo był niewyobrażalnie szybszy w liczeniu.

Ten moment na zawsze zmienił metrykę sukcesu w AI. Pytanie przestało brzmieć: „Czy maszyna myśli jak człowiek?”, a zaczęło: „Czy maszyna jest w stanie pokonać człowieka w danym zadaniu?”. To pragmatyczne przesunięcie uwagi z procesu na wynik otworzyło drzwi dla zupełnie nowego podejścia, które miało zdominować XXI wiek. Przyszłość AI nie leżała już w eleganckich systemach logicznych, ale w potędze danych i mocy obliczeniowej. Po upadku szachów, ostatniego bastionu ludzkiego intelektu, badacze wyznaczyli sobie nowy cel – starożytną chińską grę Go, o rzędach wielkości bardziej złożoną od szachów, uważaną za niemożliwą do złamania przez maszyny. Nie wiedzieli jeszcze, że jej zdobycie zajmie im mniej niż dwie dekady.

Rewolucja XXI Wieku – Trzy Ery, które zmieniły wszystko

Po latach stagnacji i fałszywych świtów, na początku XXI wieku zaczęły dojrzewać warunki do prawdziwej rewolucji. Trzy potężne siły zbiegły się w czasie, tworząc idealną burzę, która na zawsze zakończyła zimy AI. Po pierwsze, Wielkie Dane (Big Data): eksplozja internetu, mediów społecznościowych i urządzeń mobilnych wygenerowała niewyobrażalne wcześniej ilości cyfrowych danych – tekstu, obrazów, dźwięków – które mogły posłużyć jako paliwo dla algorytmów. Po drugie,

Ogromna Moc Obliczeniowa: karty graficzne (GPU), pierwotnie projektowane z myślą o grach komputerowych, okazały się idealne do równoległego przetwarzania operacji matematycznych leżących u podstaw sieci neuronowych, dając badaczom dostęp do taniej supermocy obliczeniowej. Po trzecie,

Lepsze Algorytmy: koncepcje sieci neuronowych, które przez lata leżały odłogiem, zostały udoskonalone i były gotowe do skalowania.

Era I: Głębokie uczenie (deep learning) (ok. 2010–2017)

Przełom nastąpił w 2012 roku i miał bardzo konkretną nazwę: ImageNet. Był to coroczny konkurs w rozpoznawaniu obiektów na milionach zdjęć, swoiste mistrzostwa świata w dziedzinie widzenia komputerowego. Tego roku zespół z Uniwersytetu w Toronto, kierowany przez jednego z „ojców chrzestnych” AI, Geoffreya Hintona, zgłosił do konkursu sieć neuronową o nazwie AlexNet. Jej wynik był szokiem. AlexNet osiągnął wskaźnik błędu na poziomie 15,3%, podczas gdy drugi najlepszy zespół, korzystający z tradycyjnych metod, uzyskał 26,2%. To nie była niewielka poprawa; to była deklasacja. W jednej chwili cała dziedzina widzenia komputerowego, a wkrótce cała AI, zmieniła kurs.

Tym, co odróżniało AlexNet, była technika zwana głębokim uczeniem (deep learning). W przeciwieństwie do symbolicznej AI, gdzie reguły były ręcznie programowane przez człowieka, głębokie uczenie opiera się na wielowarstwowych sieciach neuronowych, które same uczą się rozpoznawać wzorce na podstawie ogromnej liczby przykładów. Można to porównać do sposobu, w jaki dziecko uczy się rozpoznawać kota: nie poprzez naukę definicji („ma futro, cztery łapy, wąsy”), ale poprzez obejrzenie tysięcy różnych kotów, aż jego mózg sam wyodrębni kluczowe cechy. Sieci neuronowe działają podobnie, automatycznie ucząc się hierarchii cech – od prostych krawędzi i kolorów w pierwszych warstwach, po złożone kształty, takie jak oczy czy uszy, w warstwach głębszych.

Rewolucja głębokiego uczenia nie była w swej istocie przełomem filozoficznym w rozumieniu inteligencji. Był to przede wszystkim przełom inżynieryjny i zasobowy. Udowodnił on, że przy wystarczającej ilości danych i mocy obliczeniowej, stosunkowo proste, skalowalne architektury mogą przewyższyć dekady pracy ludzkich ekspertów próbujących ręcznie zakodować wiedzę o świecie. To było ostateczne potwierdzenie drogi, którą wskazał Deep Blue: ilość danych ma swoją własną, unikalną jakość. Najważniejszą umiejętnością w nowej erze AI przestało być tworzenie sprytnych reguł, a stało się gromadzenie gigantycznych zbiorów danych i budowanie potężnych klastrów obliczeniowych.

Era II: Transformery (2017–2022)

Głębokie uczenie zrewolucjonizowało zadania związane z percepcją, takie jak rozpoznawanie obrazów i mowy. Jednak przetwarzanie języka naturalnego (NLP) wciąż stanowiło wyzwanie. Starsze modele, takie jak sieci rekurencyjne (RNN), przetwarzały tekst sekwencyjnie, słowo po słowie, co utrudniało im radzenie sobie z zależnościami na długich dystansach i uniemożliwiało efektywne wykorzystanie mocy GPU.

W 2017 roku grupa badaczy z Google opublikowała artykuł o proroczym tytule: „Attention Is All You Need” („Uwaga/skupienie to wszystko, czego potrzebujesz”). Zaprezentowali w nim nową architekturę sieci neuronowej nazwaną

Transformer. Jej sercem był mechanizm „uwagi własnej” (self-attention), który pozwalał modelowi, przetwarzając jedno słowo, jednocześnie analizować i ważyć znaczenie wszystkich innych słów w zdaniu lub nawet całym dokumencie. Dzięki temu model zyskiwał głębokie, kontekstowe zrozumienie języka. W zdaniu „Kurczak nie przeszedł przez ulicę, ponieważ on był zbyt zmęczony”, mechanizm uwagi pozwalał modelowi zrozumieć, że „on” odnosi się do „kurczaka”, a nie do „ulicy”.

Transformer okazał się nie tylko kolejnym modelem, ale nowym, fundamentalnym klockiem Lego dla nowoczesnej AI. Jego skalowalność i wydajność w przetwarzaniu relacji w danych były tak rewolucyjne, że stał się domyślną architekturą nie tylko dla języka, ale także dla obrazów, dźwięku i innych typów danych. To właśnie ten architektoniczny przełom umożliwił budowę coraz większych modeli i doprowadził bezpośrednio do kolejnej ery.

Z architektury Transformer wyłoniły się dwie główne ścieżki rozwoju, które zdominowały krajobraz NLP:

- BERT (Google, 2018): Model oparty wyłącznie na enkoderze Transformera, zaprojektowany do rozumienia języka. Jego kluczową cechą była dwukierunkowość – analizował całe zdanie naraz, patrząc zarówno na słowa poprzedzające, jak i następujące po danym słowie. Uczyniło go to niezwykle skutecznym w zadaniach takich jak wyszukiwanie informacji, analiza sentymentu czy odpowiadanie na pytania.

- GPT (OpenAI, 2018 i później): Model oparty wyłącznie na dekoderze, zaprojektowany do generowania języka. Działał w sposób autoregresywny, czyli przewidywał kolejne słowo w sekwencji na podstawie poprzednich. To uczyniło go potężnym narzędziem do pisania tekstów, od prostych zdań po złożone eseje i fragmenty kodu.

Odkrycie głębokiego uczenia dostarczyło metody (uczenie z danych), a architektura Transformer dostarczyła narzędzia – wysoce wydajnej i skalowalnej struktury, która pozwoliła tę metodę zastosować na niewyobrażalną wcześniej skalę.

Era III: Eksplozja generatywna (2022–Obecnie)

Technologia, która napędzała dzisiejszą rewolucję, dojrzewała przez kilka lat (model GPT-3 powstał już w 2020 roku), ale była dostępna głównie dla badaczy i deweloperów. Rok 2022 zmienił wszystko, ponieważ AI po raz pierwszy w historii trafiła pod strzechy. Stało się to za sprawą dwóch przełomowych produktów: DALL-E 2, generatora obrazów, który potrafił tworzyć fotorealistyczne i artystyczne grafiki na podstawie prostych poleceń tekstowych, oraz ChatGPT, chatbota opartego na modelu językowym GPT-3.5.

Sukces ChatGPT nie był jedynie triumfem technologii, ale przede wszystkim triumfem projektowania interfejsu użytkownika. OpenAI opakowało potężną, ale skomplikowaną technologię dużych modeli językowych (LLM) w najbardziej naturalny i intuicyjny interfejs, jaki można sobie wyobrazić: rozmowę. To był „moment iPhone’a” dla sztucznej inteligencji. Tak jak iPhone nie wynalazł ekranu dotykowego czy internetu mobilnego, ale połączył je w produkt, który każdy potrafił obsłużyć, tak ChatGPT obniżył barierę wejścia do zaawansowanej AI do zera. Każdy, kto umiał pisać na klawiaturze, mógł teraz korzystać z jednego z najpotężniejszych modeli AI na świecie.

Efektem była społeczna i ekonomiczna fala uderzeniowa. W ciągu kilku miesięcy ChatGPT stał się narzędziem pracy dla milionów ludzi, pomagając w pisaniu maili, tworzeniu treści marketingowych, programowaniu i edukacji. Wywołało to bezprecedensowy boom inwestycyjny i zapoczątkowało korporacyjny wyścig zbrojeń między gigantami technologicznymi, takimi jak Microsoft, Google i Meta.

Jednocześnie ta nagła demokratyzacja AI zmusiła społeczeństwo do konfrontacji z jej mroczną stroną. Rozgorzała globalna debata na temat etyki i zagrożeń: masowego bezrobocia w zawodach kreatywnych i umysłowych, dezinformacji napędzanej przez realistyczne deepfake’i, problemów z prawami autorskimi do danych treningowych, utrwalania uprzedzeń zawartych w tych danych oraz kwestii prywatności. Sztuczna inteligencja przestała być abstrakcyjnym pojęciem z laboratoriów badawczych. Stała się potężnym, wszechobecnym i głęboko kontrowersyjnym narzędziem kształtującym naszą rzeczywistość.

Podsumowanie

Historia sztucznej inteligencji zatoczyła pełne koło. Starożytne marzenia o myślących automatach i zuchwałe wizje ojców założycieli z Dartmouth wreszcie, w dziwny i nieoczekiwany sposób, zaczęły się materializować. Nie stało się to jednak dzięki eleganckiej logice i precyzyjnemu odwzorowaniu ludzkiego umysłu, jak pierwotnie zakładano, ale poprzez statystyczne przybliżenia, uczone na zbiorach danych wielkości kontynentów i przetwarzane przez farmy serwerów zużywające energię małych miast.

W tej historii powraca też inny, niepokojący motyw: skrucha twórcy. W latach 60. Joseph Weizenbaum z przerażeniem odwrócił się od swojego dzieła, ELIZY, widząc, jak łatwo ludzie dają się zwieść iluzji zrozumienia. Pół wieku później jego obawy powracają w znacznie potężniejszej formie. Pionierzy głębokiego uczenia, tacy jak Geoffrey Hinton, publicznie wyrażają żal i ostrzegają przed egzystencjalnym zagrożeniem, jakie ich praca może stanowić dla ludzkości. Okazuje się, że najwięksi prorocy AI są często jej najgłębszymi sceptykami.

Paradoks współczesnej AI polega na tym, że w miarę jak maszyny stają się coraz bardziej zdolne, nasze zrozumienie ich wewnętrznego działania staje się coraz bardziej mętne. Wczesne systemy symboliczne były przejrzyste; można było prześledzić ich logiczne rozumowanie krok po kroku. Dzisiejsze gigantyczne sieci neuronowe to „czarne skrzynki”. Nawet ich twórcy nie potrafią do końca wyjaśnić, dlaczego model podjął taką, a nie inną decyzję. Tworzymy systemy, które przewyższają nas w coraz większej liczbie dziedzin, nie rozumiejąc w pełni, jak to robią.

Ta nieprzejrzystość prowadzi do głębokiego rozłamu wśród samych ekspertów. Optymizm założycieli z lat 50. był niemal jednomyślny. Dziś pole jest rozdarte – jedni wieszczą technologiczną utopię, inni, jak Hinton, ostrzegają przed wyginięciem. Mimo niewiarygodnego postępu, fundamentalne pytania pozostają bez odpowiedzi. Jesteśmy bliżej niż kiedykolwiek do zdania testu Turinga, ale czy jesteśmy bliżej zrozumienia, czym jest inteligencja, świadomość i co to znaczy być człowiekiem? Długa, zakulisowa historia sztucznej inteligencji dobiegła końca. Publiczny rozdział tej opowieści dopiero się zaczyna.