Sztuczna inteligencja (ang. Artificial Intelligence, w skrócie AI) to pojęcie, które w ostatnich latach zyskało olbrzymią popularność. Mówi się o niej w kontekście rewolucji technologicznej, automatyzacji pracy, tworzenia kreatywnych treści, a nawet zagrożeń cywilizacyjnych. Jednocześnie wokół tego pojęcia narosło wiele mitów i uproszczeń. Czym tak naprawdę jest sztuczna inteligencja? Jak działa? Co ją odróżnia od zwykłego programu komputerowego? W jakich dziedzinach znajduje zastosowanie? Jakie niesie ze sobą szanse i ryzyka?

Odpowiedzi na te pytania wymagają cofnięcia się do podstaw: zarówno historycznych, jak i logicznych. Zrozumienie AI to nie tylko kwestia znajomości algorytmów, lecz także refleksji nad tym, czym jest „inteligencja” – nie tylko w maszynach, ale także w nas samych.

Czemu warto jest wiedzieć jak działa sztuczna inteligencja?

Na początku wiele można nauczyć się po prostu korzystając z narzędzi takich jak ChatGPT; eksperymentując, zadając pytania, obserwując odpowiedzi. To intuicyjny sposób poznawania możliwości sztucznej inteligencji. Jednak gdy zaczynamy wykorzystywać te systemy do bardziej złożonych zadań, pojawiają się ograniczenia i nieoczywiste zachowania. Wtedy dobrze jest wiedzieć, jak AI działa pod spodem: skąd biorą się jej błędy, dlaczego coś „nie działa” tak, jak się spodziewaliśmy, i co można zrobić, by to obejść lub poprawić. Świadomość tych mechanizmów daje większą kontrolę i pozwala wyciągać z AI znacznie więcej.

Spis treści

Najprostsza analogia: Autokorekta i podopowiedzi.

Zanim przejdziemy do bardziej złożonych zagadnień, takich jak warstwy i tokeny, najlepiej jest zrozumieć analogię do autokrekty.

ChatGPT działa na podobnej zasadzie jak autokorekta w telefonie, ale w znacznie bardziej zaawansowanej formie. Zamiast podpowiadać jedno słowo, potrafi generować całe zdania i spójne wypowiedzi, dopasowane do kontekstu rozmowy. Model został wytrenowany na ogromnych zbiorach tekstów pochodzących z internetu, książek, artykułów i rozmów, dzięki czemu nauczył się przewidywać, jakie słowa i frazy pojawiają się w określonych sytuacjach językowych.

Gdy zadajesz pytanie, Chat GPT nie przeszukuje gotowych odpowiedzi, lecz na bieżąco przewiduje kolejne słowa, budując wypowiedź krok po kroku.

Nie posiada wiedzy w tradycyjnym sensie ani zrozumienia świata, ale dzięki zdolności do rozpoznawania wzorców językowych potrafi formułować odpowiedzi, które są logiczne i dopasowane do treści wejściowej.

Jak działa autokorekta?

Autokorekta w telefonie analizuje Twoje słowa i na ich podstawie przewiduje, co chciałeś napisać. Robi to, korzystając z bazy danych najczęściej używanych słów i ich kombinacji. Gdy wpiszesz np. „dziękue”, system rozpozna to jako literówkę i zaproponuje „dziękuję”, ponieważ to słowo częściej występuje i pasuje do kontekstu.

Czym jest odległość Levenshteina?

Odległość Levenshteina, znana też jako odległość edycyjna, to metryka, która mierzy różnicę między dwiema sekwencjami (np. dwoma słowami). Definiuje się ją jako minimalną liczbę pojedynczych operacji, by przekształcić jedną sekwencję w drugą.

Operacje te to:

- Wstawienie: dodanie znaku (np. z „dom” na „domek”).

- Usunięcie: usunięcie znaku (np. z „dobre” na „dobr”).

- Zamiana: zmiana jednego znaku na inny (np. z „kot” na „kit”).

Każda z tych operacji ma „koszt” równy 1. Suma tych kosztów daje nam odległość Levenshteina. Im mniejsza odległość, tym bardziej słowa są do siebie podobne.

Podpowiedzi – modele n-gramowe)

Podpowiedzi kolejnych słów w autokorekcie działają na podstawie modeli językowych, które szacują prawdopodobieństwo wystąpienia danego słowa na podstawie poprzedzającego kontekstu. Im większy i bardziej zaawansowany model, tym dokładniejsze są przewidywania.

Najprostszym mechanizmem są modele n-gramowe, które analizują, jak często dane słowo występuje po innym.

- Bigramy: system bierze pod uwagę ostatnie wpisane słowo. Jeśli napiszesz „pójdę na”, model sprawdzi, które słowa najczęściej pojawiają się po „na”. Przykładowo, może zasugerować „zakupy”, „spacer”, „obiad”, ponieważ w treningowych korpusach tekstowych te połączenia są bardzo częste.

- P(zakupy∣na)>P(spacer∣na)

- Trigramy: algorytm bierze pod uwagę dwa poprzedzające słowa. Jeśli napiszesz „pójdę na długi”, model przewidzi, że kolejnym słowem będzie „spacer”, „weekend” lub „spacer”, bo takie frazy są częste w języku polskim.

- P(spacer∣na długi)>P(weekend∣na długi)

Problem z modelami n-gramowymi: uwzględnianie dwóch, czy nawet czterech ostatnich słów, nie pozwala przewidywać spójnych wypowiedzi. Skalowanie tej technologii jest bardzo kosztowne, i nieefektywne. Każde kolejne uwzględnianie słowo, to dodatkowe miliony kombinacji. Wiele, jeśli nie większość, kombinacji 10 słów nigdy nie wystąpi w naturalnym języku, co sprawi, że model będzie miał zerowe prawdopodobieństwo dla nowych sekwencji.

Modele n-gramowe nie są w stanie zrozumieć, że słowo na początku akapitu wpływa na wybór słowa na jego końcu. Nie rozumieją tez że np. w ostatnich 10 słowach, słowo nr 2 odnosi się do słowa nr 4 itd.

Jak działa ChatGPT?

ChatGPT działa na zasadzie przewidywania kolejnych słów, przy czym każde następne słowo jest wybierane na podstawie prawdopodobieństwa, które zależy od wcześniejszych słów w wypowiedzi. Można to opisać tak:

- Najpierw analizuje kontekst, czyli wszystko, co zostało już powiedziane lub napisane w danym fragmencie tekstu.

- Dla danego miejsca w zdaniu (czyli np. po słowie „Chciałbym pojechać…”) model oblicza prawdopodobieństwa wszystkich możliwych słów, które mogłyby się pojawić jako następne – np. „na”, „do”, „z”, „tam” itd.

- Wybiera to słowo, które ma najwyższe prawdopodobieństwo, choć czasami, w zależności od ustawień (np. temperatury), może też wybrać mniej oczywiste opcje, by brzmieć bardziej kreatywnie.

- Po dodaniu tego słowa, cały proces powtarza się, z tym że nowy kontekst uwzględnia już kolejne słowo, więc zmienia się „pole widzenia” modelu i jego przewidywania dla następnych pozycji.

Czyli: model krok po kroku przewiduje każde słowo, a to, co już wygenerował wcześniej, wpływa na wybór następnych. W efekcie powstaje spójna całość: zdanie, akapit albo nawet cała rozmowa.

Mając tę podstawę, możemy przejść do bardziej złożonych rzeczy.

Jak działa uczenie maszynowe?

Do zrozumienia jak działa chat GPT, dobrze jest wiedzieć czym jest uczenie maszynowe, które jest podstawą działania modeli językowych.

Zbudowanie modelu językowego od zera, jest bardzo trudne, ale stworzenie programu do rozpoznawania np. obrazków czy grania w gry, jest już prostsze.

W przypadku rozpoznawaniu zdjęć, łatwiej jest zobaczyć działanie sztucznej inteligencji, w przypadku generowaniu tekstu, trudniejsze jest zobaczenie momentu gdzie tekst zaczyna mieć sens.

Uczenie maszynowe to metoda, w której model komputerowy uczy się zadania na podstawie danych treningowych. Nie mówi mu się wprost, co ma robić, lecz pokazuje się przykłady.

Przykład: chcemy, by komputer rozpoznawał koty na zdjęciach. Zamiast pisać reguły („kot ma uszy, ogon, futro”), pokazujemy mu tysiące zdjęć podpisanych jako „kot” i „nie kot”. Algorytm uczy się wyodrębniać cechy charakterystyczne i potem potrafi rozpoznać kota na nowym zdjęciu.

Najlepszym przykładem jest rozpoznawanie liter i cyfer, ponieważ takie programy są najprostsze do zrobienia, i mają one praktyczne zastosowanie.

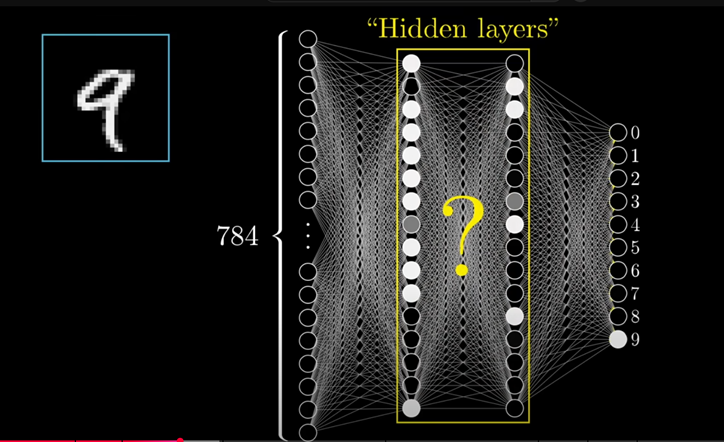

Jak sztuczna inteligencja rozpoznaje ręcznie pisane cyfry?

Na obrazku: pierwsza warstwa odpowiada za kodowanie grafiki na język maszyny (tworzy matrycę pixeli), ostatnia warstwa wskazuje konkretną cyfrę. Środkowe warstwy wykonują analizę, i to co się dzieje w środku, jest najbardziej ciekawe.

Całość opiera się na dwóch mechanizmach:

- Konwolucji (wyszukiwaniu określonych wzorców, np. krawędzi, pętli, kresek, łuków). Polega to na prezsuwaniu małego okienka, np. mające 3×3 pixeli, i wyliczaniu głównych cech

- Poolingu – zmniejszania wymiarów obrazu, zachowując jego cechy. Polega to na dzieleniu grafiki na mniejsze fragmenty, np. 2×2 pixeli, i wybieraniu z nich pixela z największą wartością, z których potem składany jest nowy, mniejszy obraz.

W przypadku grafiki mającej 100×100 pixeli, ilość możliwych kombinacji to 2 do potęgi 10 000, jest to liczba tak wielka, że niemożliwe jest porównanie wszystkich kombinacji. Jeśli jednak zmniejszymy obraz do kwadratu mające bok długości 4 pixeli, czyli składającego się łącznie z 16 pixeli, ilość kombinacji to 2 do 16, czyli 65536. Co zajmuje 128 KB, lub 1 MB, w zależności jak to zapiszemy.

Proces uczenia się

Początkowo, każdy neuron z jednej warstwy, jest połączony z każdym neuronem z drugiej warstwy. W miarę uczenia się, program przydziela jednym połączeniom większe wagi, a innym mniejsze, dzięki czemu wytrenowany model działa wydajniej.

Jak działają neurony sztucznej inteligencji?

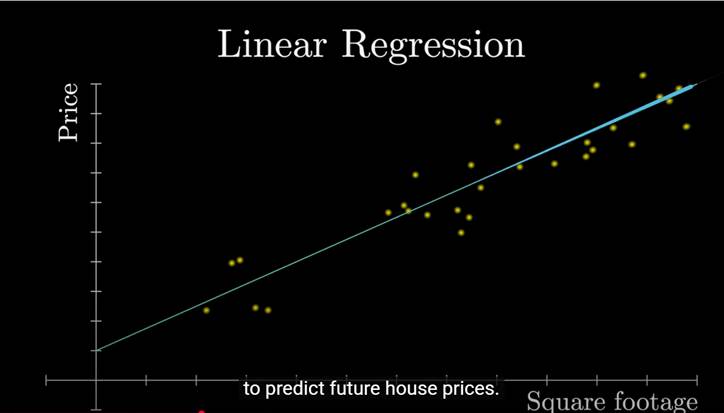

Głównym zadaniem neuronów jest znajdywanie funkcji opisujących dany obraz (albo opisujących dane działanie). Najłatwiejszą funkcją do ilustracji tego, jest funkcja liniowa, czylu y=ax+b . Pojedyńczy neuron sprawdza jaka jest odległość między wykresem funkcji, a konkretnymi danymi, i następnie zmienia parametry a oraz b. Kolejny neuron robi to z innym punktem, i tak przesuwa /obraca linię wykresu, żeby jak najlepiej opisywała rzeczywistość.

Jak działa uczenie maszynowe?

Uczenie maszynowe to metoda, w której model komputerowy uczy się zadania na podstawie danych treningowych. Nie mówi mu się wprost, co ma robić, lecz pokazuje się przykłady.

Przykład: chcemy, by komputer rozpoznawał koty na zdjęciach. Zamiast pisać reguły („kot ma uszy, ogon, futro”), pokazujemy mu tysiące zdjęć podpisanych jako „kot” i „nie kot”. Algorytm uczy się wyodrębniać cechy charakterystyczne i potem potrafi rozpoznać kota na nowym zdjęciu.

Wyróżniamy trzy główne typy uczenia:

Uczenie nadzorowane (supervised learning)

Model otrzymuje dane wejściowe wraz z etykietami (np. obraz + kategoria). Jego zadaniem jest nauczyć się przewidywać etykietę dla nowych danych. Przykłady:

- rozpoznawanie twarzy,

- diagnoza medyczna (np. guz łagodny/złośliwy),

- klasyfikacja wiadomości jako spam/niespam.

Uczenie nienadzorowane (unsupervised learning)

Model dostaje dane bez etykiet i sam ma odkryć struktury (np. grupowanie klientów wg zachowań zakupowych). Wykorzystuje się to m.in. w:

- segmentacji rynku,

- kompresji danych,

- wykrywaniu anomalii.

Uczenie ze wzmocnieniem (reinforcement learning)

Agent (program) podejmuje decyzje w środowisku i otrzymuje nagrody lub kary. Na tej podstawie uczy się strategii działania. Przykłady:

- gry (szachy, Go, StarCraft),

- sterowanie robotem,

- optymalizacja reklam.

Głębokie uczenie.

Głębokie uczenie (deep learning) to odmiana uczenia maszynowego oparta na głębokich sieciach neuronowych. Sieci te mają wiele warstw przetwarzania, które uczą się coraz bardziej abstrakcyjnych reprezentacji danych. Przykład: pierwsza warstwa wykrywa krawędzie obrazu, kolejne – kształty, potem obiekty (np. oczy, ogon), aż do rozpoznania kota.

Dzięki głębokiemu uczeniu powstały systemy rozpoznające mowę (np. Siri), tłumaczenia maszynowe (np. DeepL), modele językowe (np. ChatGPT) i generatory obrazów (np. DALL·E). Ich trenowanie wymaga jednak ogromnych danych, mocy obliczeniowej i wielomilionowych nakładów.

Warstwy: jak AI przetwarza informacje

Co to jest warstwa w modelu AI?

Warstwa to jeden poziom przetwarzania informacji wewnątrz modelu. Każda warstwa dostaje dane od poprzedniej i przekształca je – wykonuje pewne operacje matematyczne, które wydobywają cechy z danych. Potem przekazuje wynik do kolejnej warstwy.

Przykład z rozpoznawaniem obrazów:

- pierwsza warstwa wykrywa krawędzie,

- druga łączy je w kształty,

- trzecia rozpoznaje obiekty (np. oczy, ogon),

- ostatnia decyduje, czy to kot.

W modelach językowych (np. GPT), warstwy analizują tekst token po tokenie, wyłapując zależności składniowe, semantyczne, kontekstowe.

Co oznacza, że model ma np. 96 warstw?

To znaczy, że dane przechodzą przez 96 poziomów przekształceń. Każda warstwa to zestaw neuronów (czyli prostych funkcji matematycznych), które „uczą się” różnych aspektów danych. Im więcej warstw, tym bardziej złożonych zależności model może się nauczyć – ale też tym więcej potrzeba mocy obliczeniowej i danych.

Tokeny: jak AI dzieli tekst

Czym jest token?

Token to fragment tekstu, na którym operuje model językowy. Może to być:

- całe słowo (np. „kot”),

- część słowa (np. „kota”, „kotka” dzielone na „kot” + końcówkę),

- pojedynczy znak (np. „k”, „o”, „t”).

System tokenizacji zależy od konkretnego modelu. GPT-3.5 i GPT-4 używają tokenizera opartego na tzw. Byte Pair Encoding. Dzięki temu model może efektywnie obsługiwać wiele języków i radzić sobie ze słowami, których nigdy wcześniej nie widział.

Dlaczego tokeny są ważne?

- Model nie czyta zdań jak człowiek; dostaje ciąg tokenów (np. 1500 tokenów).

- Tokeny mają wpływ na długość wypowiedzi, koszty użycia (np. w API), a także na jakość odpowiedzi.

- Jedno zdanie może mieć 10 tokenów albo 25 – zależnie od języka i struktury.

Wiedząc że Chat GPT operuje na tokenach, łatwiej jest zrozumieć dlaczego długo miał on problem z liczeniem liter w danym słowie, czego słynnym przykładem jest „Strawberry” (Truskawka).

Chat GPT nie „widzi” liter, tylko tokeny – czyli fragmenty słów. Dla modelu „Strawberry” to nie jedna całość, lecz np. kilka tokenów: „Str”, „aw”, „berry”. Model nie liczy liter jak człowiek, tylko przewiduje odpowiedź na podstawie tego, co zna z danych. Czasem trafi, czasem nie.

Liczenie liter w słowach, to bardzo dobry przykład pokazujący czemu dobrze jest znać ogólne zasady działania sztucznej inteligencji. Pozwala to zrozumieć, czemu AI może jednocześnie nie radzić sobie z zadaniami banalnymi dla człowieka, a jednocześnie być niesamowicie skuteczna w bardzo złożonych zadaniach, wymagających wiedzy eksperckiej.

Jak to naprawiono?

W nowszych wersjach (jak GPT-4-turbo) model lepiej rozpoznaje, kiedy pytanie dotyczy znaków, a nie znaczenia całego zdania. W takim przypadku, model nadaje osobny token każdej literce w słowie o które pytamy.

Embeddingi: wektory znaczeń

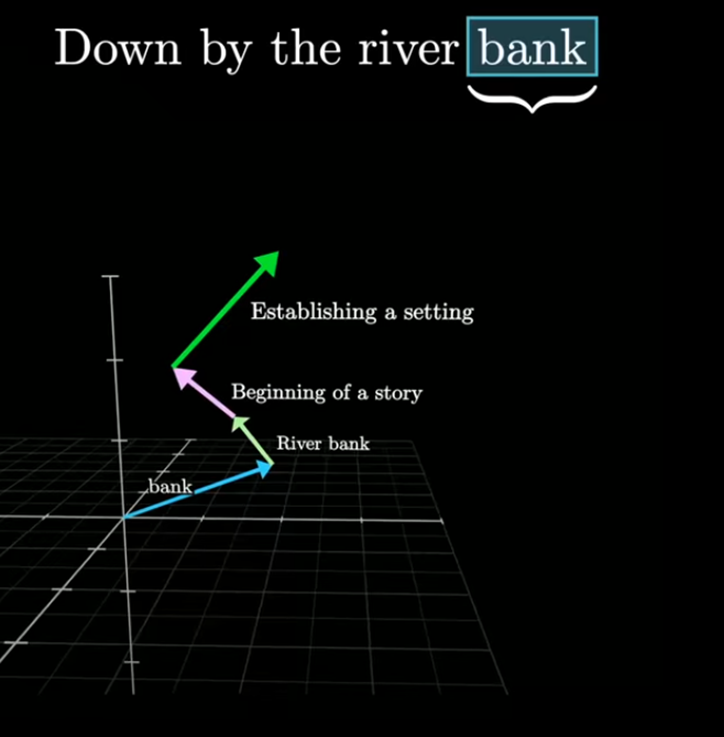

Jak AI „rozumie” znaczenie słów?

Model nie rozumie słów w ludzkim sensie. Zamiast tego przekształca każdy token w wektor – ciąg liczb, np. 153 liczb zmiennoprzecinkowych. To tzw. embedding. Wektor ten reprezentuje znaczenie słowa w kontekście innych słów.

Przykład:

- embedding słowa „król” będzie bliski embeddingowi słowa „królowa”,

- ale różni się w sposób zbliżony do różnicy między „mężczyzna” a „kobieta”.

Dzięki embeddingom model „wie”, że „pies” i „kot” są bliżej siebie niż „pies” i „łopata” – mimo że nie zna tych słów jako takich.

Wektor, którego używa Chat GPT, to zwykły wektor znany z układy współrzędnych. Dwu wymiarowe wektory mają postać dwóch liczb, gdzie jednak oznacza długość, a druga wysokość, np. (3, 4). Łatwe jest też wyobrażenie sobie trójwymiarowych wektorów, które mają po prostu trzy składowe (współrzędne). Choć wyobrażenie sobie czterowymiarowych wektorów jest już trudniejsze, to z punktu widzenia matematycznego, dodawanie nowego wymiaru nie jest żadnym problemem, łatwe jest tworzenie wektorów mających dowolną ilość wymiarów, podobnie proste jest dokonywanie na nich operacji podobnych do tych znanych z dwuwymiarowych wektorów.

Dzięki wektorom, widzimy odległości pomiędzy słowami.

Czemu wektory są tak istotne?

Wektory pozwalają zrozumieć zależności między słowami. Przykładowo (w dużym uproszczeniu), odległość między słowem król i królowa, jest podobna do odległości pomiędzy słowem mężczyzna i kobieta.

Podczas przetwarzania tekstu przez warstwy, model analizuje każdy token pod kątem innych tokenów w tekście, i tworzy nową wersje tokenu, która niesie więcej informacji. Jeśli w tekście opisywaliśmy że „król miał na sobie purporową szatę”, to token króla po przetworzeniu, będzie zawierał w sobie informacje o ubiorze. A token szaty, będzie miał informacje że znajdowała się ona na królu. Dokładniej opisuje to mechanizm uwagi.

Attention: uwaga modelu

Czym jest mechanizm uwagi (attention)?

Mechanizm uwagi pozwala modelowi „skupić się” na istotnych fragmentach tekstu. Niektóre słowa mają większe znaczenie niż inne – model uczy się, które z nich warto w danym kontekście brać pod uwagę.

Przykład zdania:

„Ania dała książkę Basi, bo jej się znudziła.”

Człowiek rozumie, że „jej” odnosi się do Ani. Dla modelu to trudne. Mechanizm uwagi pozwala mu analizować zależności i nadawać wagę różnym tokenom.

Transformer i self-attention

Współczesne modele językowe oparte są na architekturze transformerów. Kluczowym elementem jest self-attention – mechanizm, w którym każdy token „patrzy” na inne tokeny i ocenia, jak są ze sobą powiązane. To pozwala uchwycić kontekst i znaczenie nie tylko lokalnie (słowo po słowie), lecz także globalnie (np. cały akapit).

Logity i macierz wag.

Na podstawie przetworzonych wektorów z tekstu, model buduje wektor kontekstowy, i porównuje go z macierzą wag (czyli z tą samą macierzą, która jest używana do embedingu, czyli zamieniania tokena (liczby) na wektor z współrzędnymi). Niektóre modele korzystają z tej samej macierzy przy wejściu oraz wyjściu, choć można stosować różne macierze, to zasada działania jest podobna.

Model językowy wykonuje więc iloczyn skalarny pomiędzy wektorem kontekstowym, a tokenami z wyjściowej macierzy wag. Następnie tworzona jest lista odległości danych słów (tokenów), od tokena wyjściowego do tokenów z macierzy. Teraz konieczne jest określenie prawdopodobieństwa.

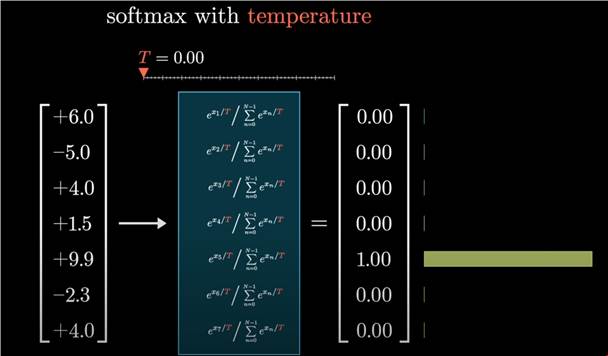

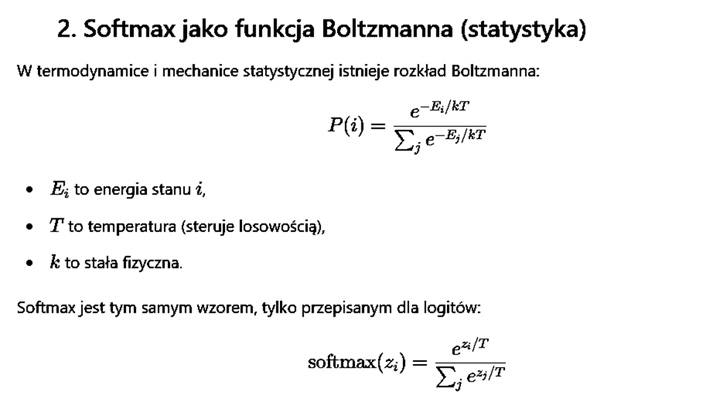

Softmax

Otrzymaliśmy listę słów, wraz z ich odległością od wektora wyjściowego. Suma tych odległości rzadko kiedy wynosi 100, niektóre słowa mogą mieć wartość ujemną. Teraz konieczne jest zamienienie tych wartości, na procenty, upewniając się że suma punktów procentowych wynosi 100%

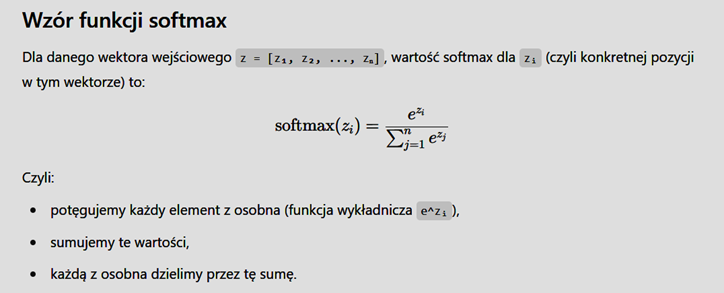

Czym jest softmax?

W gruncie rzeczy, jest to prosta funkcja, która zamienia wektor liczb w procenty prawdopodobieństwa. Działa ona podobnie do normalizacji liniowej, ale w porównaniu do niej, zwiększa różnice między wynikami. Nie musisz rozumieć jak funkcja działa, można traktować ją jak czarną skrzynkę, ale jej zrozumienie przydaje się poznania tematu temperatury.

Normalizacja liniowa

Możliwe że nie pamiętasz tego pojęcia, natomiast dobrze wiesz jak to działa. Przykładowo: mamy 9 kul białych, i jedną czarną, jakie jest prawdopodobieństwo wylosowania kuli czarnej?

Dzielimy ilość kul czarnych (1), przez sumę kul białych i czarnych (10), wychodzi nam 0,1, czyli 10%

Jeśli do liczenia tego użyjemy Sofmaxa, szansa na wylosowanie czarnego słowa wyniesie ok 0,00035%. Przypadku losowania kul, nie ma ona sensu, ale jest ona używana w termodynamice i mechanice statystycznej, znaną pod nazwą funkcji Boltzmanna.

Jak działa Softmax?

Funkcję Softmax ma następujący wzór:

Jest to matematyka na poziomie liceum, ale wiele osób może mieć z tym problem:

e – to stała matematyczna, coś typu liczba Pi (π), liczba „e” to w przybliżeniu to 2,71828

Z – to cały wektor, w uproszczeniu zbiór

Z i – softmax tla tego wektora

Σ – to sigma, czyli suma wielu wielu elementów

Σn – suma n-elementów

j – to indeks bieżącego elementu

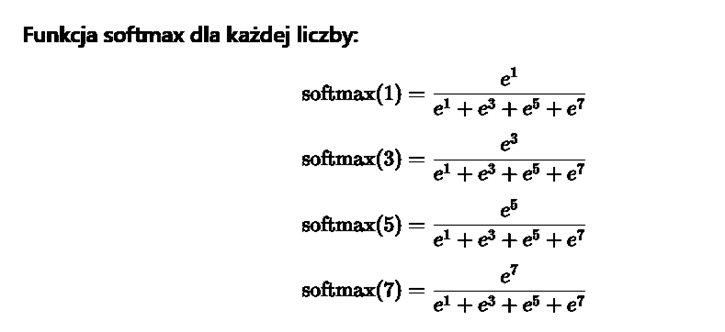

Przykładowo:

Mamy liczby 1, 3, 5, 7,

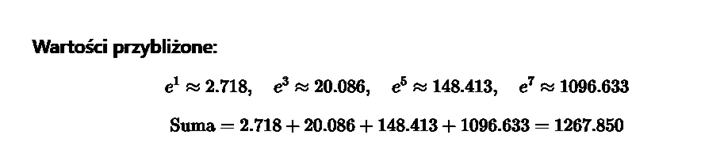

Wartości przybliżone:

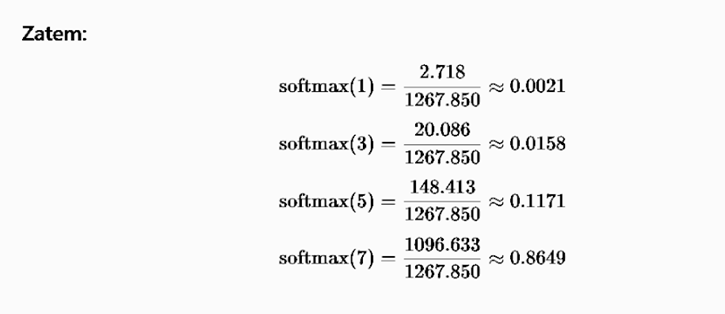

Suma wszystkich sofmaxów wynosi 1 – czyli 100%

Jak sprawić żeby różnice prawdopodobieństwa pomiędzy poszczególnymi liczbami (słowami/wektorami/tokenami) były mniejsze? Należy wprowadzić liczbę T, przez którą dzielimy każdy element wektora. Dzięki temu różnicę między potęgami liczb są mniejsze, bo liczba e do potęgi 1, jest mniejsza niż liczba e do potęgi 3. A taki efekt uzyskujemy gdy liczymy softmax dla liczby 3, a T=3

Temperatura w sztucznej inteligencji: kontrolowanie kreatywności

Temperatura to parametr, który wpływa na losowość odpowiedzi generowanej przez model. Potocznie nazywane jest to kreatywnością, bo czasami wyższa temperatura, daje wrażenie większej kreatywności.

Niska temperatura (np. 0,1) – odpowiedzi są przewidywalne, zachowawcze, spójne.

- Wysoka temperatura (np. 1,0 lub więcej) – odpowiedzi są bardziej zróżnicowane, kreatywne, ale mogą być chaotyczne lub błędne.

Model zawsze „wie”, jakie są najbardziej prawdopodobne następne tokeny. Temperatura decyduje, czy wybierze najpewniejszy, czy pozwoli sobie na mniej typowy wybór.

Kiedy zmieniać temperaturę?

- Pisanie kodu – niska temperatura, by unikać błędów.

- Pisanie opowiadań, poezji, sloganów – wyższa temperatura dla większej różnorodności.

- Analiza danych lub podsumowania – niska, by zachować precyzję.

Nazwa temperatura, wzięła się z podobieństwa do równań dotyczących zjawisk fizycznych.

Technicznie, temperatura to liczba przez jaką dzielimy składniki funkcji softmaxa, dzięki czemu wynik jest „bardziej płaski”, czyli różnice pomiędzy prawdopodobieństwami wystąpienia konkretnych słów, są mniejsze.

„Ale przecież dzielenie przez 1 nic nie zmienia, a wiele suwaków, np. w Google Ai studio, , pozwala ustalać temperaturę od poziomu 0, do np. 1 lub 2” – tu działa proste przekształcenie i uproszczenie, W rzeczywistości przesuwanie poziomu temperatury od 0 do 2, oznacza zmianę parametru T z 1 do 3.

Czym jest top-p sampling? (nucleus sampling)

To alternatywa dla temperatury. Zamiast wybierać losowo z wszystkich dostępnych tokenów, top-p wybiera tylko te tokeny, które razem mają np. 90% łącznego prawdopodobieństwa. Potem losuje z tego zbioru.

- top-p = 0.1 – tylko bardzo pewne odpowiedzi.

- top-p = 1.0 – pełna losowość (wszystkie możliwości w grze).

Temperatura i top-p mogą być używane razem, ale często stosuje się tylko jedno z nich.

Inne pojęcia techniczne

Prompt

Prompt to tekst wejściowy, który podajemy modelowi. Może to być pytanie, polecenie, fragment tekstu; wszystko, co model ma wziąć pod uwagę przy generowaniu odpowiedzi.

Context window (okno kontekstowe)

Okno kontekstowe maksymalna liczba tokenów, które model może „przeczytać” jednocześnie. GPT-3.5 ma 4096 tokenów, GPT-4 do 128k. Jeśli przekroczymy limit, model „zapomni” starsze fragmenty. Należy rozróżnić kontekst wejściowy, czyli ile tekstu Chat GPT jest w stanie przeczytać, oraz kontekst wyjściowy, czyli ile tekstu Chat GPT może napisać.

Fine-tuning

Fine tunning dostrajanie modelu do konkretnego zastosowania. Zamiast budować AI od zera, bierze się gotowy model i trenuje go dalej na danych specyficznych dla firmy, dziedziny lub języka.

Inference

To moment, w którym model generuje odpowiedź. Trwa ułamki sekundy, ale może być kosztowne obliczeniowo – zwłaszcza przy dużych modelach.

Parametry wag (ang. weights)

Parametry wag to podstawowe składniki matematyczne każdej sieci neuronowej – czyli także takich modeli jak ChatGPT. W skrócie: to liczby, które decydują o tym, jak silnie jeden element wpływa na drugi w trakcie przetwarzania informacji.

Wracamy do autokorekty

Gdy znamy już podstawowe pojęcia dotyczące sztucznej inteligencji, dobrze jest wrócić do podstawowych zasad autokorekty.

Odległość Levenshteina (tzw. edytorska)

To jedna z najstarszych i najczęściej używanych miar. Określa, ile operacji (wstawień, usunięć lub zamian znaków) trzeba wykonać, aby przekształcić jedno słowo w inne. Im mniejsza odległość, tym bardziej podobne są słowa.

Przykład:

„kot” → „koń” → odległość = 1 (zamiana „t” na „ń”)

Model n-gramowy

Model statystyczny, który przewiduje słowo na podstawie jego otoczenia. W klasycznym modelu n-gramowym szacuje się prawdopodobieństwo wystąpienia słowa na podstawie wcześniejszych n-1 słów.

Przykład (bigram, czyli 2-gram):

Jeśli użytkownik pisze „chciałbym zjeść pi”, system ocenia, które słowo częściej pojawia się po „zjeść”: „pizza” czy „pierogi”.

Wzór:

P(wₙ | wₙ₋₁) ≈ częstotliwość(wₙ₋₁, wₙ) / częstotliwość(wₙ₋₁)

Autokorekty korzystają obecnie z wielu innych mechanizmów, w tym uczenia maszynowego (analizującego najczęstsze błędy), ale w podstawowej wersji podstawą są wspomniane wcześniej mechanizmy, wraz z uwzględnieniem odległości liter na klawiaturze. Choć obecnie, coraz częściej używane są proste i szybkie modele językowe.

Odległość Levenshteina można traktować jako uproszczoną wersję mechanizmu tokenów i zależności między tokenami (choć technicznie jest to zupełnie inna metoda), natomiast mechanizm transformerów i self-attention jest wprost rozwinięciem modeli n-gramowych.

Drzewa decyzyjne i lasy losowe – proste metody uczenia maszynowego.

Choć wspomniane rozwiązania nie są wykorzystywane w Chacie GPT, to warto jest je znać, ponieważ występują często w zagadnieniach sztucznej inteligencji. Mają zastosowanie tam, gdzie wymagana jest prostota, szybkość, i dysponujemy małą mocą obliczeniową.

Drzewo decyzyjne to model, który podejmuje decyzje na zasadzie „jeśli… to…”. Każdy jego węzeł sprawdza warunek, np. czy słowo jest w słowniku, różni się jedną literą od innego wyrazu, albo czy poprzedza je konkretne słowo. Na końcu gałęzi znajduje się decyzja: popraw, albo zostaw bez zmian. Takie drzewa można budować automatycznie, ucząc je na dużej liczbie przykładów z rzeczywistych błędów.

Pojedyncze drzewo bywa jednak zawodne, dlatego tworzy się ich wiele – to tzw. las losowy (random forest). Każde drzewo dostaje nieco inne dane i cechy, a następnie niezależnie proponuje rozwiązanie. Ostateczną decyzję podejmuje system na podstawie głosowania. Dzięki temu model jest odporny na błędy, szybki i nadaje się do działania nawet na słabszych urządzeniach.

Podstawy AI: podsumowanie

Model językowy to nie mózg

Warto na koniec przypomnieć: AI nie rozumie świata jak człowiek. Nie ma świadomości, emocji, intencji. Model językowy nie „wie”, że Ty istniejesz. Jedyne, co robi, to przewiduje kolejne słowo w oparciu o dane, na których był trenowany.

Ale dzięki złożoności sieci, ogromnej liczbie parametrów (miliardy), wieloetapowemu przetwarzaniu i zastosowaniu mechanizmów takich jak embeddingi, attention i warstwy transformujące – potrafi generować odpowiedzi, które wydają się sensowne, trafne, a czasem wręcz błyskotliwe.

Szybki skrót najważniejszych pojęć:

warstwy – poziomy przetwarzania informacji,

tokeny – podstawowe jednostki tekstu w modelu,

embeddingi – liczby opisujące znaczenie słów,

attention – mechanizm skupiania się na ważnych fragmentach,

temperatura i top-p – parametry wpływające na kreatywność odpowiedzi,

Sztuczna inteligencja to nie tylko modele językowe czy rozpoznawanie obrazów.

W tym tekście skupiłem się na modelach językowych i rozpoznawaniu obrazów , dzięki czemu ten artykuł jest stosunkowo krótki. Wiedzę z tego tekstu jest już przydatna przy praktycznym korzystaniu z Chat GPT czy innych modeli, i daje największe możliwości „bawienia się”. W następnym tekście poruszę temat rozpoznawania zdjęć, oraz tego jak działa generowanie grafik.

Jeśli chodzi o budowanie sztucznej inteligencji, to najprostsze jest rozpoznawanie grafik (i już proste modele mają praktyczne zastosowanie), później jest generowanie tekstu, a następnie generowanie grafik.

Trzeba jednak pamiętać że AI to nie tylko generowanie tekstów i obrazków.

Sztuczna inteligencja jest obecna w wielu technologiach, z których korzystamy na co dzień, często nie zdając sobie z tego sprawy.

- Asystenci głosowi: Siri, Alexa czy Asystent Google używają AI do rozumienia mowy, przetwarzania zapytań i wykonywania poleceń.

- Systemy rekomendacji: Platformy takie jak Netflix, Spotify czy YouTube analizują twoje preferencje i na podstawie algorytmów uczenia maszynowego proponują ci filmy, muzykę czy wideo, które mogą ci się spodobać.

- Autonomia pojazdów: Samochody autonomiczne wykorzystują AI do analizy danych z czujników (radaru, LiDAR, kamer) i podejmowania w czasie rzeczywistym decyzji dotyczących kierowania, hamowania i unikania przeszkód.

- Opieka zdrowotna: AI pomaga w diagnozowaniu chorób, analizując zdjęcia rentgenowskie i tomograficzne, a także w odkrywaniu nowych leków poprzez symulacje chemiczne.

- Finanse: Banki i instytucje finansowe stosują AI do wykrywania oszustw, analizowania ryzyka kredytowego i prognozowania trendów rynkowych.

Przyszłość AI to nie tylko udoskonalanie istniejących narzędzi, ale także rozwój w dziedzinach, które jeszcze niedawno wydawały się niemożliwe. To na przykład robotyka (zrobotyzowane ramiona w fabrykach, roboty sprzątające), ochrona środowiska (analiza danych satelitarnych do monitorowania zanieczyszczeń) czy nauka (symulacje kosmiczne i klimatyczne).

Krótko mówiąc, AI to potężne narzędzie do analizy danych i optymalizacji procesów, a jej zastosowania wykraczają daleko poza to, co widzimy na ekranach naszych komputerów.