Zrozumienie działania sztucznej inteligencji może wydawać się bardzo trudne, a często nawet niepotrzebne. W końcu większość ludzi raczej nie będzie budowało własnych modeli od zera. Takie podejście jest jednak błędne. Zrozumienie technicznych podstaw działania sztucznej inteligencji pozwala nie tylko lepiej z niej korzystać, ale też trafniej oceniać jej wyniki i rozumieć, dlaczego czasem się myli. To trochę jak z samochodem – nie musisz być mechanikiem, by nim jeździć, ale warto wiedzieć, czym różni się hamulec od sprzęgła.

Spis treści

Zacznijmy od autokerekty

Najprostszym sposobem, by zrozumieć działanie sztucznej inteligencji, jest spojrzenie na coś, z czego korzysta każdy z nas: autokorektę w telefonie lub przeglądarce. Mechanizm który sprawia, że gdy piszesz wiadomość, system podpowiada kolejne słowo, działa podobnie w modelach językowych. Nie rozumie on znaczenia zdań w ludzkim sensie, ale potrafi przewidywać, które słowo powinno pojawić się dalej, na podstawie tysięcy przykładów. Po napisaniu pierwszego słowa w nowej wypowiedzi, sztuczna inteligencja analizuje komendę użytkownika+ pierwsze słowo które napisała, i na tej podstawie generuje kolejne słowo. Istotnym pojęciem jest odległość edycyjna – sprawdzanie ile liter trzeba zmienić, żeby zamienić jedno słowo inne.

To dobrze pokazuje zasady uczenia maszynowego (machine learning) – model nie zna zasad gramatyki, ale uczy się wzorców z danych. Jeśli wystarczająco często widzi, że po „dzień” występuje „dobry”, zaczyna z dużym prawdopodobieństwem sugerować właśnie tę kombinację.

Przewidywanie jednego słowa, na podstawie trzech ostatnich słów, jest dość proste, bo możemy po prostu spisać wszystkie kombinacje. Jeśli chcemy przewiedzieć dwa, trzy słowa do przodu, musimy analizować więcej słów wstecz, ilość możliwości znacząco wzrasta. Nie wystarczy więc po prostu dodawać mocy obliczeniowej, żeby zamienić autokorektę w Chat GPT.

Podstawy uczenia maszynowego

Uczenie maszynowe można zrozumieć jako proces, w którym komputer nie otrzymuje gotowych reguł, ale sam je odkrywa, analizując dane. Zamiast mówić mu, że kot ma cztery łapy i wąsy, pokazujemy mu tysiące zdjęć kotów, aż sam zauważy cechy wspólne.

Ten proces dzieli się zwykle na trzy etapy:

- Zbiór danych (dataset) – to zestaw przykładów, na podstawie których system się uczy. Może to być tekst, obraz, dźwięk lub kombinacja tych form.

- Model (model) – to matematyczna struktura, która przetwarza dane. W modelach językowych ma ona postać sieci neuronowej.

- Trening (training) – to etap, w którym model analizuje dane, dokonuje błędnych przewidywań, a następnie je koryguje, by stopniowo uczyć się trafnych zależności.

Najważniejszy moment w całym procesie to tzw. backpropagation – mechanizm, który pozwala modelowi samodzielnie korygować błędy. Kiedy system „pomyli się”, oblicza, jak bardzo jego przewidywanie odbiegało od prawidłowej odpowiedzi, i dostosowuje wagi połączeń między neuronami. Dzięki temu z każdą iteracją staje się odrobinę mądrzejszy.

Sieci neuronowe – jak uczą się maszyny

Współczesna sztuczna inteligencja opiera się głównie na sztucznych sieciach neuronowych, inspirowanych działaniem ludzkiego mózgu. W praktyce to nie są neurony biologiczne, tylko funkcje matematyczne, które przetwarzają liczby.

Każdy neuron odbiera dane (wejście), przetwarza je, a następnie przekazuje wynik dalej (wyjście). Sieć składa się z wielu warstw takich neuronów. Pierwsze warstwy uczą się prostych rzeczy – w przypadku obrazów może to być wykrywanie krawędzi, kolorów lub punktów. Głębsze warstwy uczą się coraz bardziej złożonych pojęć, takich jak kształt oka, twarzy czy całej postaci.

W modelach językowych wygląda to podobnie. Początkowe warstwy uczą się rozpoznawać strukturę zdań i gramatykę, kolejne analizują znaczenie słów, a najwyższe warstwy potrafią już generować sensowne, logiczne zdania.

Każdy neuron ma swoją „wagę”, która określa, jak silny jest jego wpływ na końcowy wynik. Trening polega właśnie na dopasowywaniu tych wag – milionów, a w największych modelach miliardów – aż sieć zacznie działać optymalnie.

Jak działa ChatGPT – przetwarzanie języka krok po kroku

ChatGPT i inne modele językowe to przykład tzw. transformerów – architektury, która zrewolucjonizowała uczenie maszynowe. Ich kluczowym elementem jest mechanizm attention (uwagi), który pozwala modelowi analizować kontekst całego zdania, a nie tylko słowa obok siebie.

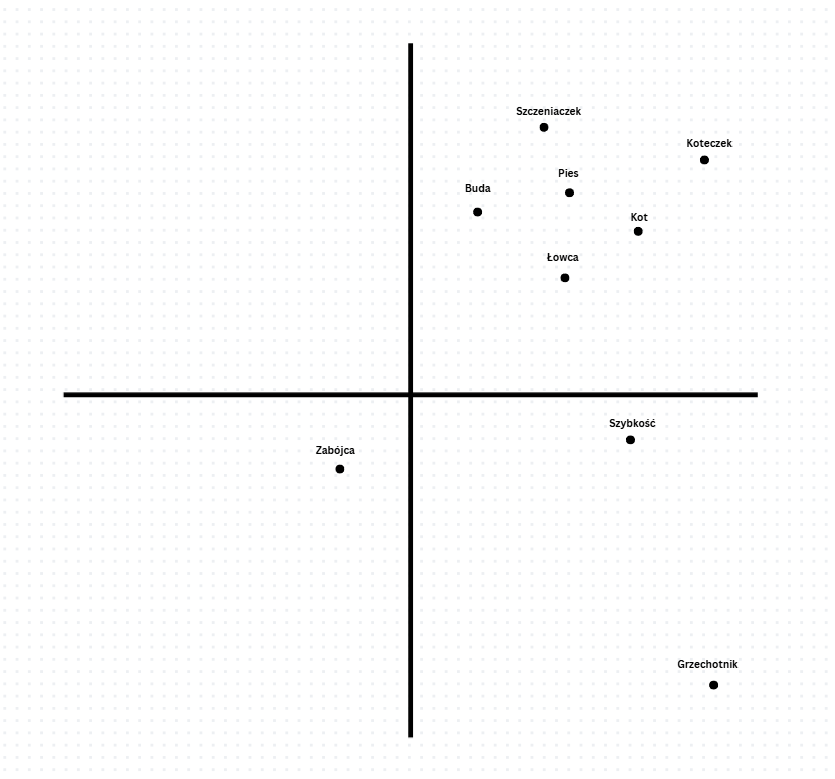

Gdy piszesz pytanie, model dzieli je na małe fragmenty zwane tokenami – najczęściej są to pojedyncze słowa, sylaby lub nawet litery. Następnie każdy token jest przekształcany w wektor liczb, które reprezentują jego znaczenie w kontekście. Stosuje się do tego macierz embedingu, która każdemu słowu (tokenowi), przypisuje określone miejsce w układzie współrzędnym. Skąd wiemy jak te słowa powinny być rozmieszczone? Do tego służy właśnie trenowanie modeli językowych.

Następnie sieć analizuje, które słowa w zdaniu są ze sobą powiązane i w jakim stopniu wpływają na swoje znaczenie. Weźmy zdanie: „Kiedy pies, który uciekł z podwórka, goni kota siedzącego na płocie, wszyscy domownicy wybiegają na zewnątrz.”

Tutaj słowo „pies” wiąże się z „goni”, „uciekł” i pośrednio z „domownicy”, ponieważ to jego zachowanie powoduje dalsze zdarzenia. Słowo „kot” ma natomiast silne powiązanie z „siedzącego na płocie” oraz również z „goni”, choć z innej perspektywy.

W architekturze transformerów każdy token „patrzy” na inne tokeny w zdaniu, analizując kontekst, w jakim występują. Model jest trenowany tak, by już na starcie mieć intuicję, które słowa zwykle tworzą sensowne zależności (np. że czasownik łączy się z podmiotem lub dopełnieniem).

Jest to osobna grupa wiedzy którą ma dany model. Słowa – kot i pies są bliżej siebie w macierzy embedingu niż pies i goni, ale model jezykowy umie wykryć które słowa „częściej na siebie patrzą”.

W miarę przechodzenia przez kolejne warstwy sieci, to „spojrzenie” staje się coraz bardziej precyzyjne — model zaczyna wychwytywać nie tylko bezpośrednie relacje między słowami, ale też znaczenia pośrednie, np. że „ucieczka psa” i „reakcja domowników” są częścią jednego ciągu przyczynowo-skutkowego. Dzięki temu sztuczna inteligencja potrafi nie tylko rozpoznawać strukturę zdania, ale także jego sens w kontekście całego fragmentu.

Na końcu, po przejściu przez wiele warstw, model przewiduje, jaki token powinien pojawić się dalej. W rzeczywistości każde słowo, które widzisz w odpowiedzi ChatGPT, jest wynikiem tysiąca prawdopodobieństw – a model wybiera to, które najlepiej pasuje do kontekstu.

Robi się to poprzez budowanie wielkiego wektora kontekstowego. Model znając zależności pomiędzy słowami, tworzy wektor całej wypowiedzi. Następnie szuka które tokeny są najbliżej współrzędnych tego wektora.

To właśnie dlatego AI potrafi pisać naturalnie, tłumaczyć teksty i odpowiadać na pytania – nie dlatego, że „rozumie” treść w ludzkim sensie, ale dlatego, że matematycznie przewiduje najbardziej prawdopodobne ciągi słów.

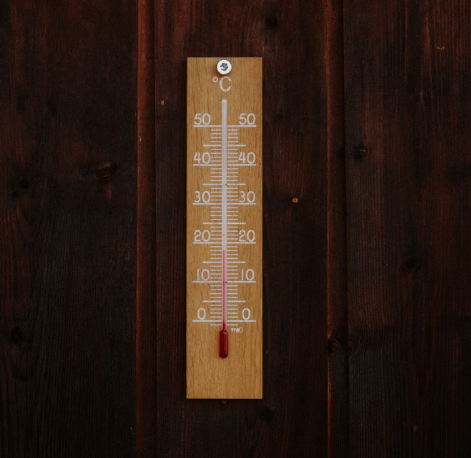

Czym jest temperatura i jak wpływa na odpowiedzi

W modelach językowych istnieje pojęcie temperatury, które decyduje o poziomie losowości modelu, co często daje wrażenie większej „kreatywności”.

Temperatura to liczba między 0 a 2 (czasem więcej), która kontroluje losowość generowanych odpowiedzi:

- Przy temperaturze 0 model wybiera zawsze najbardziej prawdopodobne słowo. Odpowiedzi są precyzyjne, ale przewidywalne – dobre do zadań technicznych.

- Przy temperaturze 1 pojawia się pewien stopień swobody – model może czasem wybrać drugą lub trzecią najbardziej prawdopodobną opcję. Teksty stają się bardziej naturalne i elastyczne.

- Przy temperaturze 1,5 lub 2 odpowiedzi bywają zaskakujące, czasem nawet chaotyczne, bo model częściej wybiera mniej oczywiste ścieżki.

To dlatego ten sam model może brzmieć jak poważny analityk albo jak poeta – wszystko zależy od temperatury.

Od strony matematycznej temperatura działa w ramach funkcji softmax, która przekształca surowe wyniki modelu (tzw. logity) w rozkład prawdopodobieństwa. Każdy token w zdaniu ma przypisaną wartość liczbową – dodatnią lub ujemną – która odzwierciedla, jak dobrze pasuje do kontekstu. Te wartości to w istocie odległości między wektorem reprezentującym aktualny kontekst a wektorami poszczególnych słów z tablicy słownikowej.

Softmax zamienia te liczby na wartości między 0 a 1, które można interpretować jako prawdopodobieństwa. Wcześniej można by to zrobić prościej – na przykład przez normalizację min–max (skalowanie wszystkich liczb tak, by mieściły się w zakresie od 0 do 1) albo przez dzielenie każdej wartości przez ich sumę. Jednak takie metody nie oddają dobrze relacji między silnie ujemnymi i silnie dodatnimi wynikami.

Softmax robi to lepiej, bo używa funkcji wykładniczej – podnosi każdą wartość do potęgi „e”, dzięki czemu nawet niewielkie różnice w logitach zamieniają się w duże różnice w prawdopodobieństwach. Temperatura w tym równaniu kontroluje „stromość” tej krzywej. Gdy jest niska, softmax mocno faworyzuje najwyższy wynik (model jest pewny siebie). Gdy jest wysoka, wykres się spłaszcza i nawet słabsze kandydaty mają szansę zostać wybrane.

W skrócie: temperatura to suwak, który w matematycznym sensie reguluje, jak bardzo model „rozprasza” swoją uwagę między możliwymi słowami. Dzięki połączeniu funkcji softmax i pojęcia temperatury AI potrafi balansować między precyzją a kreatywnością – między matematycznym chłodem a literacką improwizacją.

Czym różni się AI od zwykłych programów

Tradycyjny program komputerowy działa według reguły „jeśli – to”. Na przykład: jeśli liczba jest większa od 10, wyświetl komunikat. Sztuczna inteligencja działa inaczej – nie ma gotowych instrukcji, tylko nauczyła się ich pośrednio z danych.

Dzięki temu potrafi działać w sytuacjach, których wcześniej nie widziała. To właśnie kluczowa różnica między klasycznym oprogramowaniem a uczeniem maszynowym.

W klasycznym kodzie każda decyzja jest przewidziana przez programistę. W AI decyzje są wynikiem statystycznych wzorców. Dlatego model potrafi przewidzieć, jakiego słowa użyjesz, ale czasem się myli, bo nigdy nie „rozumie” świata tak, jak człowiek.

Dlaczego sztuczna inteligencja czasem się myli

Błędy AI to naturalny efekt tego, jak się uczy. Jeśli w danych treningowych pojawiły się nieścisłości lub brakowało kontekstu, model może błędnie wyciągnąć wnioski. Przykładem są tzw. halucynacje – sytuacje, w których AI tworzy informacje brzmiące wiarygodnie, ale całkowicie nieprawdziwe.

Dlaczego tak się dzieje? Bo model nie ma dostępu do rzeczywistości – operuje tylko na prawdopodobieństwie. Jeśli wiele podobnych zdań kończyło się określonym wnioskiem, uzna go za prawdziwy.

To trochę jak autokorekta, która potrafi zamienić „sztuczna” na „sztuczka”, bo takie słowo występuje częściej. Z matematycznego punktu widzenia to logiczna decyzja, ale z perspektywy człowieka – absurdalna.

Skąd modele językowe czerpią wiedzę

Kiedy model językowy generuje odpowiedź, wydaje się, że rozumie pytanie. W rzeczywistości to efekt skomplikowanych zależności między tokenami i wagami neuronów.

Naukowcy porównują to do mapy znaczeń – każde słowo jest punktem w przestrzeni wielowymiarowej, a ich wzajemne odległości odpowiadają podobieństwom semantycznym. Dlatego model „wie”, że słowa „król” i „królowa” są powiązane, a różnica między nimi jest podobna jak między „mężczyzną” i „kobietą”.

To zjawisko nosi nazwę embedding – i właśnie ono sprawia, że AI może tworzyć logiczne zdania i trafne analogie, mimo że nie ma świadomości.

Cała wiedza modelu jest zakodowana, i nie widoczna.

Cała wiedza modelu jest ukryta w tablicach i macierzach:

- W embeddingach – znajdują się ogólne relacje między słowami (np. „król” – „mężczyzna” + „kobieta” ≈ „królowa”).

- W wagach warstw transformera – tam model uczy się zależności składniowych, znaczeniowych, logicznych i faktograficznych. Te warstwy pozwalają przetwarzać kontekst i łączyć informacje z różnych miejsc tekstu.

- W macierzy wyjściowej (output projection) – częściowo powiela strukturę embeddingu wejściowego, ale jest dostrojona do przewidywania kolejnego tokenu, więc zawiera też „odwróconą” wiedzę o tym, jak dane fakty są reprezentowane w słowach.

Oznacza to że wiedza jest mocno rozproszona, i przeglądając kod danego modelu, nie jesteśmy w stanie znaleźć konkretnych miejsc, np. z informacjami o tym że woda wrze w temperaturze 100 stopni Celsjusza. Nie da się więć błędnej wiedzy łatwo poprawić.

Jeśli chcemy mieć pewność danej wiedzy, musimy korzystać z systemu RAG (Retrieval-Augmented Generation). W takim wypadku, przed wygenerowaniem odpowiedzi, model wyszukuje wiedzę w systemie… wiedzy, a następnie używa jej do generowanie odpowiedzi. Chat GPT wyszukujący informacje w sieci, czy w udostępnionych plikach, korzysta z RAGa.

Jak uczą się modele takie jak ChatGPT

Największe modele językowe uczą się w dwóch etapach:

- Pre-training – model analizuje ogromne zbiory tekstów (książki, artykuły, strony internetowe), by nauczyć się ogólnych wzorców języka.

- Fine-tuning – po wstępnym treningu model jest dopracowywany na mniejszych, starannie dobranych danych. Często z udziałem ludzi, którzy oceniają jakość odpowiedzi i pomagają modelowi rozumieć intencje użytkowników.

Ten drugi etap jest kluczowy, bo pozwala modelowi nie tylko mówić poprawnie, ale też sensownie reagować na pytania. To właśnie wtedy AI uczy się, jak unikać niebezpiecznych odpowiedzi czy nieprawdziwych informacji.

Jak działa pre-training?

Na początku model językowy startuje z losowo ustawionymi macierzami embedingu, wag, i warst wyjściowej.

Do systemu wrzuca się wiele tekstów. Następnie program dzieli go na mniejsze, fragmenty, a potem model próbuje zgadnąć kolejne słowa, i porównuje swój wynik z oczekiwanym, i na tej podstawie dostosowuje parametry wag. Tak więc po otrzymaniu tekstu: „Paryż jest stolicą” model musi napisać – „Francji”

Jak działa fine-tuning?

Po etapie pre-treningu, w którym model uczy się ogólnej struktury języka i zależności między słowami, następuje fine-tuning, czyli dopracowanie jego zachowania. W tym procesie model nie uczy się już języka jako takiego, lecz sposobu reagowania na konkretne sytuacje. Dostaje zestaw starannie wybranych przykładów — pytań i oczekiwanych odpowiedzi — które pokazują mu, jak powinien formułować wypowiedzi w rozmowie z człowiekiem. To coś w rodzaju kursu dobrych manier: model poznaje, jak być pomocnym, precyzyjnym i uprzejmym asystentem.

Technicznie fine-tuning przebiega podobnie jak trening wstępny. Model otrzymuje fragment rozmowy (np. pytanie użytkownika) i ma przewidzieć poprawną kontynuację (czyli odpowiedź). Porównuje swoją odpowiedź z tą zapisaną w danych i dostosowuje wagi, by zbliżyć się do pożądanego stylu. Dane są mniejsze, ale o wiele lepszej jakości — pokazują, jak odpowiadać logicznie, konkretnie i bezpiecznie.

Często etap ten rozszerza się o tzw. RLHF (Reinforcement Learning from Human Feedback), czyli uczenie przez wzmacnianie na podstawie opinii ludzi. W tym wariancie model generuje kilka odpowiedzi na jedno pytanie, a ludzie oceniają, która jest najlepsza. Na tej podstawie tworzy się dodatkowy model nagrody, który uczy główny system rozpoznawać lepsze zachowania. Dzięki temu ChatGPT i podobne modele potrafią nie tylko mówić poprawnie, ale też rozumieć ton rozmowy, kontekst i intencję rozmówcy.

Funkcja straty.

W obu przypadkach model stosuje podobne zasady matematyczne. Najpierw porównuje się różnicę pomiędzy oczekiwaną odpowiedzią, a tym co model napisał. Na tej podstawie modyfikuje się parametry funkcji. Najłatwiej jest to zrozumieć na podstawie prostego problemu, np. zgadywania wykresu funkcji liniowej, gdy zna się parę parametrów.

Backpropagacja

Model językowy korzysta z wielu warstw. Po puszczeniu zapytania w modelu językowym, i porównaniu go z modelową odpowiedzią, znamy wielkość błędu, na podstawie którego musimy potem zmodyfikować wagi (parametry funkcji). Ale jest tu pewna pułapka- musimy zmienić parametry w wielu warstwach. Pomaga w tym mechanizm propagacji wstecznej.

Rozpoznawanie obrazów przez sztuczną inteligencję.

Rozpoznawanie obrazów jest najprostszą użyteczną rzeczą, jaką można robić przy po mocy sztucznej inteligencji. Model językowy, żeby był użyteczny, musi być wszechstronny, natomiast narzędzie które rozpoznaje osoby, komórki raka, litery i cyfry, może być dużo mniejsze. Dlatego naukę tworzenia sztucznej inteligencji, dobrze jest zacząć od rozpoznawania obrazów.

Jak komputer rozpoznaje obrazy.

Rozpoznawanie obrazów w sztucznej inteligencji zaczyna się od przekształcenia zdjęcia w dane liczbowe. Każdy piksel obrazu jest reprezentowany przez wartości liczbowe, które opisują jego kolor i jasność. Aby ułatwić pracę modelowi, obraz jest często zmniejszany do niższej rozdzielczości. Nie chodzi o usunięcie informacji, ale o usunięcie nadmiaru szczegółów – sieć nie potrzebuje 8 milionów pikseli, by rozpoznać kota. W praktyce polega to na tym, że kilka sąsiednich pikseli (na przykład 2×2 lub 4×4) zamienia się w jeden, którego wartość stanowi średnią tych czterech punktów. W efekcie model wciąż „widzi” ogólny kształt i układ obiektów, ale bez nadmiaru szczegółów. To trochę jak spojrzenie na fotografię z daleka – mniej detali, lecz proporcje i kontury pozostają czytelne. Taki zredukowany obraz staje się wejściem dla sieci neuronowej.

W pierwszych warstwach sieć wykrywa krawędzie i kontrasty, czyli najprostsze elementy wizualne. Działa to poprzez tzw. konwolucje – małe filtry przesuwające się po obrazie i obliczające różnice jasności między sąsiednimi pikselami. Dzięki temu sieć potrafi odróżnić granicę między np. sierścią a tłem. Te filtry (zwane też jądrami) reagują na linie pionowe, poziome czy ukośne – podobnie jak neurony w ludzkim oku.

Połączenie tych dwóch metod, czyli wykrywania krawędzi oraz zmniejszanie rozdzielczości, umożliwia komputerowi przekształcenie zdjęcia cyfry mającego wymiary 1000 x 1000 pixeli, do obrazka mającego np. 4×4 pixeli. Program jest w stanie zapamiętać wszystkie możliwe układy takiego obrazka, w przypadku dwóch kolorów jest to dwa do potęgi szesnastej.

Kolejne warstwy łączą te podstawowe cechy w bardziej złożone kształty – np. uszy, oczy czy kontury twarzy. Im głębsza warstwa, tym bardziej abstrakcyjne wzorce rozpoznaje. W końcowych etapach sieć tworzy tzw. mapę cech, która opisuje, jakie elementy wizualne występują w obrazie i z jakim prawdopodobieństwem należą do danej klasy (np. kot, pies, samochód). Model nie widzi więc „zdjęcia kota”, ale wzorzec kształtów i kontrastów, który w milionach przypadków okazał się kotem.

Taki proces pozwala sieci nie tylko rozpoznać obiekt, ale też rozumieć jego kontekst. Dzięki zmniejszaniu rozdzielczości i analizie krawędzi model może działać szybko i skutecznie, bez konieczności przetwarzania ogromnych ilości surowych danych. W efekcie AI potrafi patrzeć na obraz w sposób zbliżony do ludzkiego — rozumiejąc, że to nie zbiór kolorowych punktów, ale spójny obraz świata.

Jak uczy się program rozpoznawać obrazki?

Uczenie programu rozpoznawania obrazków w gruncie rzeczy przypomina sposób, w jaki modele językowe uczą się rozumieć tekst, choć zamiast słów analizuje się tu piksele. Podobnie jak model językowy przewiduje następny wyraz, model wizualny próbuje odtworzyć strukturę obrazu i rozpoznać, jakie elementy na nim występują. W czasie treningu program dostaje tysiące zdjęć wraz z opisami (np. „kot”, „samochód”, „drzewo”). Każdy obraz jest rozbijany na liczby – wartości pikseli – a następnie przetwarzany przez kolejne warstwy sieci neuronowej.

W pierwszych warstwach sieć uczy się rozpoznawać proste wzorce: krawędzie, kontrasty, linie poziome i pionowe. Potem, w głębszych warstwach, łączy te elementy w coraz bardziej złożone struktury, takie jak kształt oka, koło samochodu czy kontur twarzy. W efekcie powstaje coś w rodzaju mapy cech obrazu – matematycznego zapisu tego, co sieć „widzi”.

Model po każdym przewidywaniu porównuje swoją odpowiedź z prawdziwą etykietą i oblicza, jak bardzo się pomylił. Ten błąd, zwany funkcją straty, jest podstawą do korekty wag połączeń między neuronami. Po milionach takich korekt sieć zaczyna rozpoznawać obiekty coraz precyzyjniej. Podobnie jak model językowy, który uczy się zależności między słowami, sieć wizualna uczy się zależności między kształtami i kolorami – tyle że nie przewiduje kolejnego słowa, lecz to, co przedstawia obraz.

Jakie są ograniczenia sztucznej inteligencji

Choć AI potrafi pisać teksty, tworzyć obrazy i rozwiązywać problemy, wciąż ma swoje granice. Nie ma świadomości, emocji ani kontekstu kulturowego. Nie wie, czym jest prawda – potrafi tylko oszacować, co brzmi jak prawda.

Nie potrafi też uczyć się w sposób ciągły – każdy nowy model to efekt ponownego treningu na świeżych danych. Dlatego ChatGPT nie „pamięta” poprzednich rozmów poza bieżącą sesją, chyba że zostanie do tego specjalnie przystosowany.

Zrozumienie tych ograniczeń pozwala z niej korzystać mądrzej: jako narzędzia, a nie źródła absolutnej wiedzy.

Co z tego wynika dla użytkownika

Zrozumienie działania sztucznej inteligencji nie wymaga matematyki, ale świadomości, że model to system probabilistyczny. Jeśli to zaakceptujesz, łatwiej Ci będzie interpretować jego wyniki.

Kiedy AI odpowiada na pytanie, nie mówi: „to prawda”, tylko „to najbardziej prawdopodobna odpowiedź według moich danych”. Dlatego zawsze warto zachować odrobinę krytycznego myślenia – tak jak sprawdzasz wynik autokorekty przed wysłaniem wiadomości.

Podsumowanie

Sztuczna inteligencja nie jest magią, tylko statystyką w skali planety. Każde zdanie generowane przez ChatGPT to matematyczna prognoza, a każda poprawka w autokorekcie – miniaturowa wersja tego samego procesu.

Uczenie maszynowe to fundament, który pozwala modelom samodzielnie znajdować wzorce w danych. Temperatura, mechanizm uwagi i sieci neuronowe to jego narzędzia.

Zrozumienie tych elementów daje nie tylko większą kontrolę nad korzystaniem z AI, ale też pozwala docenić, jak ogromny postęp technologiczny dokonał się w ciągu zaledwie kilku lat. A zaczęło się od prostego pytania: jak sprawić, żeby komputer nauczył się przewidywać, co chcemy napisać dalej.