Na blogu TJsoft jest już kilkadziesiąt artykułów opisujących temat sztucznej inteligencji. Część z nich skupia się na praktycznym zastosowaniu, część to szybkie newsy (które dość szybko są przeterminowane). Sporo tekstów opisuje ogólne zasady działania sztucznej inteligencji, artykuły te będą użyteczne jeszcze przez wiele lat, i są one dobrym uzupełnieniem dowolnych tekstów o AI. Jeśli nowy model językowy ma większe okno kontekstowe, to dobrze jest rozumieć czym to okno w ogóle jest.

Poniższy tekst ma ułatwić wyszukiwanie użytecznych treści, jest to wstępna próba stworzenia Wikipedii od sztucznej inteligencji.

Spis treści

Podstawowe artykuły

Jak działa sztuczna inteligencja? Podstawą jest uczenie maszynowe, a autokorekta pozwala to intuicyjnie zrozumieć.

W tym tekście wyjaśniam, jak działa sztuczna inteligencja, od prostych przykładów takich jak autokorekta, aż po złożone mechanizmy stosowane w modelach językowych. Artykuł jest pisany w taki sposób, żeby osoby które nie mają pojęcia o sztucznej inteligencji, mogły go zrozumieć. Choć przed jego przeczytaniem, dobrze jest mieć jakąś styczną np. z Chatem GPT.

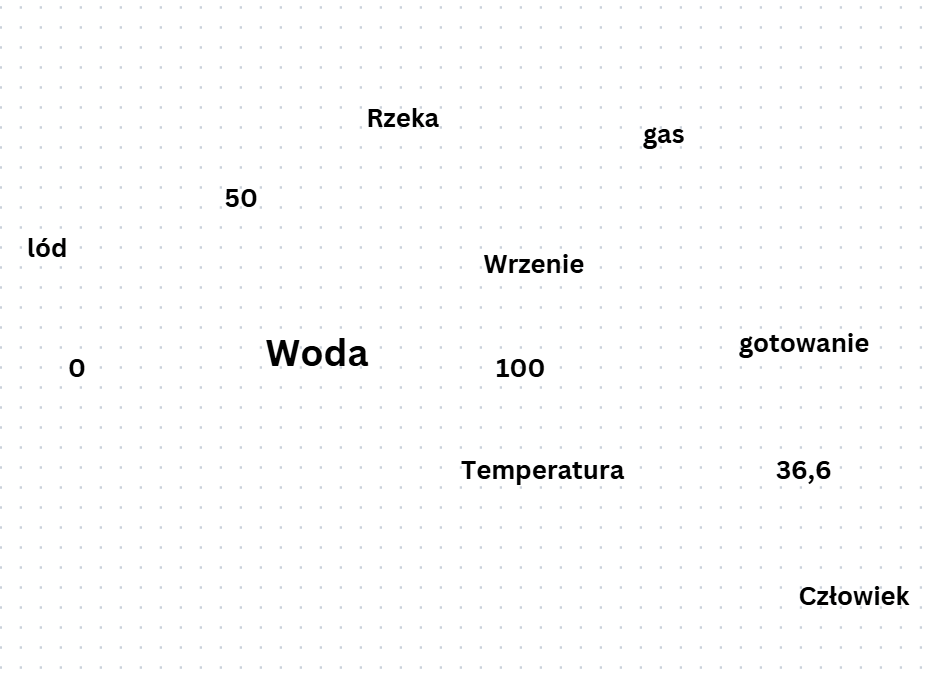

Pokazuję, czym jest uczenie maszynowe, jak funkcjonują sieci neuronowe, jak modele przewidują kolejne słowa i czym różnią się od zwykłych programów. Opisuję też pojęcia takie jak temperatura, oraz etapy trenowania modeli (pre-training i fine-tuning).

Tłumaczę, w jaki sposób AI rozpoznaje obrazy i jakie ma ograniczenia. Tekst prowadzi czytelnika krok po kroku, aby zrozumiał, skąd biorą się odpowiedzi modeli i dlaczego czasem popełniają błędy, a także co to oznacza dla użytkownika w praktyce.

Jak zacząć korzystać ze sztucznej inteligencji w 2025 roku, jeśli wcześniej tego nie robiłeś

Jeśli myślisz o sztucznej inteligencji jak o czymś trudnym, skomplikowanym albo „nie dla Ciebie”, to właśnie dlatego warto przeczytać ten tekst. Pokazuje on, że w 2025 roku korzystanie z AI jest równie proste, jak wpisanie czegoś w Google. Nie musisz nic instalować, nie musisz znać angielskiego, nie musisz nawet zakładać konta. Wystarczy kliknąć i zapytać.

Co znajdziesz w środku?

- Jak zacząć od zera: bez stresu, bez wiedzy technicznej.

- Pierwsze praktyczne zastosowania: poprawianie tekstów, wyszukiwanie rzeczy, których nazw nie znasz, pomoc w naprawach, gotowaniu, nauce i organizacji pracy.

- Najlepsze modele i narzędzia: ChatGPT, Grok, Gemini, Notebook LM, co wybrać i kiedy.

- Jak pisać do AI, żeby dostawać sensowne odpowiedzi, i czego unikać.

- Grafiki, filmy, dźwięk, transkrypcje, czyli jak wycisnąć z AI więcej niż tylko tekst.

- Bezpieczne korzystanie z AI: jak nie dać się halucynacjom, i jak dbać o swoje dane, oraz bezpieczeństwo prawne.

Dlaczego warto intersować się sztuczną inteligencją?

Sztuczna inteligencja może realnie zaoszczędzić Ci czas, pieniądze i nerwy. Możesz szybciej uczyć się nowych rzeczy, tworzyć, naprawiać i ogarniać codzienne sprawy. Jeśli podejdziesz do tego z głową i luzem, sztuczna inteligencja stanie się Twoim drugim mózgiem. A wszystko zaczyna się od jednego kliknięcia.

Ten tekst to nie suchy poradnik, tylko przystępne wprowadzenie dla każdego. Nawet jeśli jesteś na etapie „nie mam pojęcia, o co tu chodzi”.

Artykuły na temat technicznych podstaw AI

Sztuczna inteligencja pojęcia. Część druga.

Ten tekst pełni rolę praktycznego przewodnika, który pomaga uporządkować słownictwo związane ze sztuczną inteligencją i łatwiej odnaleźć się w świecie modeli językowych. Powstał jako materiał towarzyszący innym artykułom, dlatego najlepiej sprawdza się jako uzupełnienie podstawowej wiedzy. Jeśli dopiero zaczynasz przygodę z AI, warto wcześniej sięgnąć po wprowadzenie opisujące, jak działają modele językowe, w którym krok po kroku wyjaśniam takie pojęcia jak tokeny, wektory, embeddingi, warstwy i temperatura. Dzięki temu ten słownik stanie się naturalnym przedłużeniem tamtego artykułu i pomoże Ci szybciej odnaleźć sens technicznych określeń, które pojawiają się w świecie sztucznej inteligencji.

Podstawowe pojęcia AI – hasła związane z sztuczną inteligencją. Część pierwsza.

Haseł związanych z sztuczną inteligencją jest tak dużo, że ciężko jest się zmieścić to wszystko w jednym artykule, nawet jeśli każde pojęcie jest opisywane jednym akapitem. W tym przypadku, artykuł skupia się na bardziej podstawowych zagadnieniach.

Transformery w sztucznej inteligencji: jak działają i dlaczego zmieniły świat

W tym artykule na tłumaczę, czym są transformery i dlaczego to one zrobiły największą rewolucję w sztucznej inteligencji. Pokazuję, jak działają pod spodem mechanizm uwagi, tokeny, embeddingi, BERT i GPT, oraz jak z laboratoriów trafiły do wyszukiwarek, tłumaczy, chatbotów i modeli multimodalnych. Pojawia się tu pytanie, czy transformery naprawdę „rozumieją” język, czy tylko bardzo sprytnie udają, że to robią.

Czym właściwie jest neuron w sztucznej inteligencji?

Każdy kto w nawet mininalnym stopniu interesuje się sztuczną inteligencją, słyszał zapewne o głębokim uczeniu, czy sieciach neuronowych. Tu pojawia się tytułowe pytanie, czym właściwie jest ten neuron w AI? W skrócie, neuron to zwykła funkcja matematyczna, która ocenia jakie informacje przekazać dalej.

Odległość edycyjna Levenshteina w kontekście sztucznej inteligencji i autokorekty

Odległość edycyjna to niewinnie wyglądające narzędzie jest jednym z fundamentów tego, jak działa autokorekta, wyszukiwarki czy systemy NLP. Gdy wpiszesz „komputerz”, nie dzieje się magia — to właśnie algorytm próbuje ocenić, które słowo jest najbliżej Twojego błędu i podpowiedzieć właściwą formę. Znając mechanizm poprawiania literówek, oraz mechanizm podpowiadanie kolejnego słowa przez klawiaturę smartfona, można łatwiej zrozumieć działanie dużych modeli językowych.

Propagacja wsteczna, backpropagation, algorytm wstecznej propagacji błędów, backpropagacja

Modele językowe korzystają z wielu warstw. Podczas uczenia sztucznej inteligencji, po przepuszczeniu zadania przez wszystkie warstwy, otrzymujemy wynik. Następnie ten wynik jest porównywalny z modelowym (sprawdzonym ręcznie) wynikiem, i w ten sposób otrzymujemy wielkość błędu. Znając ten błąd, trzeba zmodyfikować parametry w wielu warstwach, tak żeby dawały one lepsze wyniki. Proces ten nazywamy właśnie propagacją wsteczną.

RAG (Retrieval-Augmented Generation)

RAG to technika, która sprawia, że sztuczna inteligencja przestaje „zgadywać”, a zaczyna korzystać z realnych informacji. Zanim model wygeneruje odpowiedź, najpierw wyszukuje potrzebne dane w dokumentach, a dopiero potem tworzy odpowiedź na ich podstawie. Dzięki temu jest dokładniejszy, bardziej wiarygodny i unika halucynacji. Artykuł wyjaśnia, jak działa ten mechanizm i dlaczego stał się jednym z najważniejszych elementów nowoczesnych systemów AI.

Domyślnie cała wiedza modeli językowych jest ukryta w zakodowanych połączeniach między słowami. Dopóki nie zapytamy się AI, nie wiemy tego co „on wie”

Czym jest metoda gradientu prostego (gradient descent)?

Gradient descent to jedna z podstawowych technik stosowanych w uczeniu maszynowym i sztucznej inteligencji. Pozwala modelom stopniowo poprawiać parametry tak, aby ich przewidywania stawały się coraz trafniejsze.

Dzięki tej metodzie model uczy się na błędach: najpierw zgaduje odpowiedź, porównuje ją z poprawną i koryguje swoje parametry, by następnym razem trafić lepiej. Proces powtarza się tysiące razy, a każda zmiana jest małym krokiem „w dół” ,w stronę najlepszego możliwego wyniku. Ponieważ obliczenia są zbyt złożone, by znaleźć idealne parametry od razu, gradient descent opiera się na przybliżeniach i stopniowym doskonaleniu.

Okno kontekstowe

Zastanawiałaś się kiedy, czemu Chat GPT dość dobrze sobie radzi z krótkimi odpowiedziami, ale przy dłuższych tekstach pisze kiepsko? Przyczyną tego problemu jest okno kontekstowe, i to że powiększanie okna wymaga gigantycznej mocy obliczeniowej.

Jak właściwie uczy się sztuczna inteligencja? Trenowanie sztucznej inteligencji dla osób nietechnicznych

Do pełnego zrozumienia tego jak działają modele językowe, dobrze jest wiedzieć w jaki sposób się je trenuje. Trenowanie modeli zużywa dużo więcej energii i mocy obliczeniowej, niż korzystanie z gotowych modeli. W skrócie, tworzenie sztucznej inteligencji polega na dodawaniu odpowiednich parametrów do słów (a dokładniej, tokenów). Chodzi o to żeby słowa mające podobne znaczenie, były „blisko siebie”.

Dla osób nietechnicznych to świetny punkt wyjścia do zrozumienia takich pojęć jak wektory, fine-tuning czy mechanizm uwagi. Tekst tłumaczy też, czemu AI potrafi zmyślać, skąd się biorą nietypowe skojarzenia i jaką rolę odgrywa baza wiedzy (RAG) w dostarczaniu aktualnych informacji.

Załóżmy że istniejące modele językowe się nam nie podobają, i chcemy zrobić coś własnego, od zera. Stworzenie nowego modelu, dorównującemu modelowi GPT 5.2 w warunkach domowych jest praktycznie niemożliwe. Ale już dostosowanie istniejących modeli (fine tuning), oraz dodanie własnej bazy wiedzy (RAG), jest stosunkowo proste, i w przypadku wąskich zastosowań, każdy może stworzyć narzędzie które będzie działało lepiej niż najnowszy Chat GPT czy Grok.

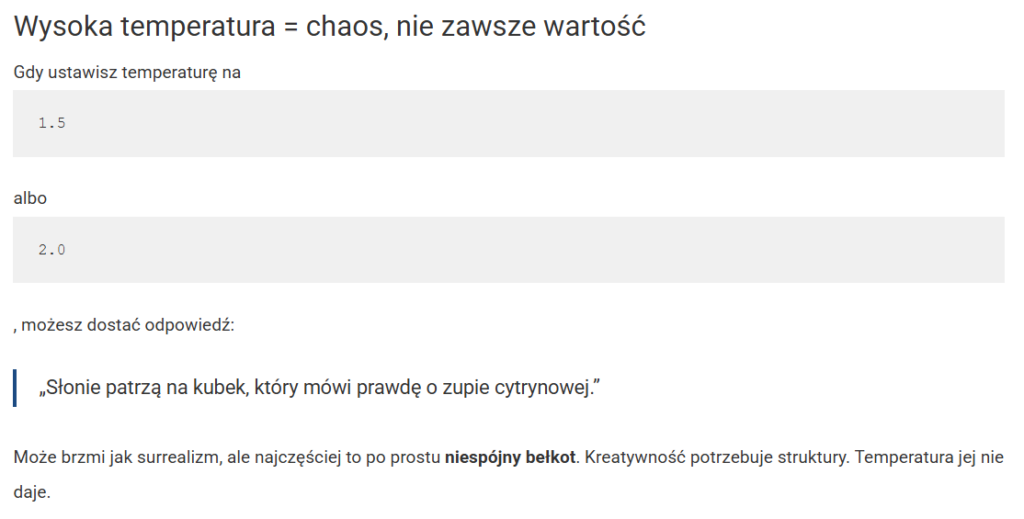

Czym właściwie jest temperatura w sztucznej inteligencji?

Ten artykuł wyjaśnia, czym naprawdę jest temperatura w modelach językowych i dlaczego popularne porównanie do „suwaka kreatywności” może wprowadzać w błąd. Temperatura to parametr techniczny regulujący losowość wyboru słów przez model – przy niskiej temperaturze AI wybiera najbardziej prawdopodobne słowa (przewidywalne odpowiedzi), a przy wysokiej dopuszcza mniej oczywiste opcje (większy chaos). Problem w tym, że wysoka temperatura nie oznacza prawdziwej kreatywności – model nie tworzy niczego nowego, tylko wybiera z już wyuczonych opcji według zmienionego rozkładu prawdopodobieństwa. W przeciwieństwie do ludzkiej kreatywności, która wymaga intencji, celu i świadomości kontekstu, temperatura po prostu zwiększa szansę na nietypowe połączenia słów, co często prowadzi do nonsensów zamiast wartościowych pomysłów.

Innymi słowy, kreatywność to coś więcej niż sam styl pisania. Wybór tego czy tekst ma być formalny czy luźny, można łatwo dokonać za pomocą odpowiednich komend. Łatwe było by tez zrobienie nakładki z suwakami do określania tego (choć nie było by to zbyt praktyczne). Natomiast sama kreatywność wynika z jakości modelu – im bardziej zaawansowany model, tym bardziej jest on kreatywny. Kreatywność to nie tylko baśniowa wyobraźnia, poezja i motylki, przy żmudnych i technicznych zadaniach, kreatywność też jest istotna.

Praktyczne zastosowania AI

Chat GPT – praktyczny poradnik i budowa programu.

Większość poradników dotyczących Chata GPT skupia się na opisywaniu samego modelu językowego. W tym tekście wziąłem na cel samą budowę programu, i jego funkcję (czyli np. funkcję projektów, wgrywania plików, Kanwy, funkcję DeepSearch, skróty klawiaturowe itd.

Jak zacząć korzystać z sztucznej inteligencji w 2025 roku?

Ten artykuł o tym jak zacząć korzystać z ai opisywałem w wstępie artykułu który właśnie czytasz. Uznałem że dobrze żeby był on również w tym segmencie, tak żeby wszystkie teksty z tej kategorii, były w jednym miejscu.

W 2025 roku korzystanie z AI jest równie proste jak wpisanie czegoś w Google. Nie potrzebujesz instalacji, kont ani znajomości angielskiego. Wystarczy wejść na chatgpt.com lub grok.com i zacząć pisać. Ten przewodnik pokazuje, jak przejść od zupełnego braku doświadczenia do praktycznego wykorzystania sztucznej inteligencji w życiu codziennym.

Od czego zacząć:

- Traktuj AI jak wszechwiedzącego asystenta, któremu musisz dostarczyć kontekst

- Zacznij od prostych zadań: poprawa tekstów, wyszukiwanie rzeczy (zwłaszcza gdy nie znasz nazwy), przepisy, naprawy

- Dodawaj zdjęcia gdy nie chce ci się czegoś opisywać lub nie wiesz jak

- Pytaj o to, ile czasu zajmie samodzielna naprawa i czy warto to robić samemu

Praktyczne zastosowania:

- Gotowanie: znajdź przepis na danie którego nazwy nie znasz, modyfikuj go pod swoje składniki

- Naprawy: zrób zdjęcie usterki, opisz swoje umiejętności, dowiedz się czy dasz radę sam

- Pisanie: pokonuj blokady dyktując myśli, poprawiaj teksty, skracaj/wydłużaj fragmenty

- Nauka: tryb Deep Search przeszuka dziesiątki stron i da ci gotowe opracowanie w 10-20 minut

- Notebook LM: wgraj filmy z YouTube i „rozmawiaj” z nimi, twórz notatki i fiszki

Grafika i wideo:

- Generowanie zdjęć: wystarczy „stwórz zdjęcie” w ChatGPT, Groku czy Gemini

- Grok tworzy filmy z dźwiękiem za darmo (kilkanaście dziennie)

- Nano Banana Pro (Google) świetnie radzi sobie z wykresami i danymi

- Możesz modyfikować prawdziwe zdjęcia, np. umieścić produkt w nowym otoczeniu

Bezpieczeństwo:

- Zawsze weryfikuj fakty – AI może halucynować (wymyślać informacje)

- Nie wklejaj haseł ani prywatnych danych do modeli w chmurze

- Unikaj pytań sugerujących odpowiedź („co się wydarzyło w firmie X 5 marca?”)

- Dodawaj w promptach: „jeśli czegoś nie wiesz, napisz to, nie wymyślaj”

Pomocne triki:

- Poproś AI o napisanie prompta dla siebie – działa zaskakująco dobrze

- Użyj formuły: Rola + Temat + Forma („Jesteś nauczycielem matematyki, opisz całki, w formie artykułu”)

- Dyktuj teksty w ChatGPT – świetnie radzi sobie z interpunkcją

- W nowym wątku wklej odpowiedź AI i zapytaj „czy to prawda?” – prosty sposób na weryfikację

Python – język sztucznej inteligencji, i użyteczne narzędzie

Ten artykuł pokazuje, jak Python stał się fundamentem współczesnej AI i dlaczego każdy może dziś z niego korzystać.

Artykuł tłumaczy fenomen Pythona w świecie sztucznej inteligencji. To połączenie prostoty z mocą – kod przypomina naturalny angielski, a jednocześnie daje dostęp do potężnych narzędzi. Biblioteki jak NumPy, Pandas czy TensorFlow sprawiają, że naukowcy mogą skupić się na tworzeniu algorytmów, zamiast męczyć się ze skomplikowaną składnią.

Kluczowa jest tu rola AI, która całkowicie zmieniła sposób pracy z Pythonem. Dziś każdy, nawet bez znajomości programowania, może w kilkanaście minut stworzyć użyteczny program. Potrzebujesz skryptu sortującego pliki? Bota sprawdzającego ceny w sklepach? Programu do automatycznego wysyłania maili? Wystarczy opisać AI co chcesz osiągnąć, a otrzymasz gotowy kod. To jak posiadanie osobistego programisty, który nigdy się nie męczy.

Artykuł przeprowadza przez konkretne zastosowania – od automatyzacji nudnych zadań biurowych, przez przetwarzanie danych, po tworzenie inteligentnych botów. Pokazuje, że nie trzeba być geniuszem, by zacząć. Wystarczy trzy godziny na podstawy i można już tworzyć rozwiązania dla realnych problemów. Python przestał być domeną wybranych – stał się narzędziem dostępnym dla każdego.

Vibecoding

Przewodnik po tworzeniu programów i automatyzacji zadań za pomocą AI, skierowany do osób bez doświadczenia programistycznego.

Tekst wyjaśnia, że prawdziwa siła vibecodingu nie leży w tworzeniu skomplikowanych aplikacji komercyjnych, ale w usprawnianiu nudnych, powtarzalnych zadań – zwłaszcza w arkuszach kalkulacyjnych. Większość ludzi korzysta z Excela, a dzięki AI można tworzyć zaawansowane formuły i makra, które oszczędzają dziesiątki godzin miesięcznie.

Przedstawiona jest stopniowa ścieżka nauki. Zaczyna się od zabawy – tworzenia prostych gier w ChatGPT, żeby zobaczyć możliwości. Potem przechodzi się do tego, co naprawdę zmienia pracę: arkusze kalkulacyjne. AI pomoże stworzyć formułę rozdzielającą kolumny, wykres Gantta czy system planowania obecności. Zadania, które wcześniej zajmowały godziny, teraz można zrobić w kilkanaście minut. Kluczowa jest świadomość, że coś w ogóle da się zautomatyzować – resztę zrobi ChatGPT.

Kolejne etapy obejmują tworzenie stron WWW, instalację Pythona i pisanie lokalnych programów, a w końcu używanie narzędzi jak Bolt czy Figma do budowania pełnoprawnych aplikacji. Artykuł zawiera praktyczne wskazówki: zapisuj działające wersje, jedna komenda – jedna zmiana, a jeśli coś nie działa po trzech próbach – cofnij się.

Najważniejsza lekcja? Nie trzeba być programistą. Wystarczy wiedzieć, że coś jest możliwe i poprosić AI o pomoc.

Google Gemini może tworzyć prezentacje AI. Jest to duży gamechanger.

Tworzenie prezentacji przez sztuczną inteligencję to jedno z najlepszych praktycznych zastosowań AI. Google Gemini oferuje funkcję automatycznego generowania prezentacji, która może znacząco przyspieszyć pracę, szczególnie gdy mamy już opracowany tekst i research.

Jak to działa? Wystarczy wybrać w Gemini tryb „Canvas” i poprosić o stworzenie prezentacji. Ważne: musimy zacząć w Gemini, a nie w narzędziu Prezentacje Google. Gemini nie jest jeszcze w stanie tworzyć prezentacji bezpośrednio w Google Slides, nawet w wersji premium.

Główne wady:

- Czasami pojawiają się drobne błędy techniczne, jak nakładający się tekst

- AI może błędnie interpretować treść i pomijać istotne informacje

- Prezentacje mają schematyczny, powtarzalny układ

- Problem z licencjami zdjęć – Google używa obrazów z różnych źródeł, co może uniemożliwiać publiczne udostępnianie prezentacji bez podmiany grafik

Kluczowe zalety:

- Ogromna oszczędność czasu przy tworzeniu pierwszej wersji

- Możliwość edycji w Google Slides

- Idealne do prezentacji wewnętrznych lub jako narzędzie do nauki (tworzenie notatek wizualnych)

- Dzięki szybkości tworzenia, sensowne staje się robienie prezentacji dla samego siebie jako pomocy w nauce

Narzędzie najlepiej sprawdza się jako punkt wyjścia – AI tworzy solidną bazę, którą można potem dopracować ręcznie. Inne opcje to Gamma.app, Napkin.ai, czy funkcje w ChatGPT i Claude.

Jak rozmawiać z ChatGPT i czy warto uczyć się promptów

Najważniejsza zasada: korzystanie z AI to zwykła rozmowa, nie zaklęcia. Uczenie się gotowych promptów z list to strata czasu, lepiej po prostu gadać z modelem i doprecyzowywać, czego potrzebujesz.

Dlaczego chat GPT popełnia błędy.

Większość problemów wynika z braku kontekstu. Prosta formuła – kim jestem + czego potrzebuję + kto ma mi pomóc – załatwia sprawę w 90% przypadków. Możesz dodać formę (email, lista), styl (luźny, formalny) i czego unikać.

Co naprawdę działa

Kilka sprawdzonych sposobów:

- Buduj scenę: „Jesteś mechanikiem naprawiającym samochód od podstaw – opisz proces”

- Miksuj style: „Pisz jak Ludwig von Mises spotkał współczesnego dziennikarza”

- Dodaj motywację: „Postaraj się, dostaniesz 50 zł” (tak, są badania potwierdzające, że to działa)

- Użyj wzmocnień: „upewnij się”, „pamiętaj”

- Poproś o prompt: „Chcę osiągnąć X – napisz dla mnie dobry prompt”

Najszybsza metoda? Napisz coś sam, nawet chaotycznie, i poproś AI o poprawienie. 4-godzinne zadanie zmienia się w 20 minut. Nie przejmuj się gramatyką – model rozumie nawet bałagan.

Co z „prompt engineeringiem”?

To przeżytek z czasów, gdy modele były słabe. Dziś to głównie tytuł dla ludzi, którzy nie wiedzą, jak się nazywać. Jeśli testujesz narzędzia AI, ale nie budujesz systemów – jesteś raczej „operatorem AI”. Typowy promt enginerring ma zastosowanie gdy tworzysz konkretne, złożone rzeczy – np. zaawansowane grafiki w AI, gdzie każde zdjęcie jest opisane za pomocą kilkunastu parametrów.

Sztuczna Inteligencja na Studiach – krótki przewodnik

Dla współczesnego studenta AI to nie narzędzie do ściągania, a porządne narzędzie wspierające naukę. Wykonuje czarną robotę: przeszukuje źródła, formatuje przypisy, pisze skrypty, dając czas na myślenie i kreatywność. Kluczem jest korzystanie z narzędzi podpiętych do wiarygodnych źródeł.

Deep Search w ChatGPT czy Perplexity pomaga szybko rozeznać się w nowym temacie. Consensus.app przeszukuje tylko recenzowane publikacje naukowe, pokazując czy w danej kwestii panuje zgoda. NotebookLM od Google pracuje wyłącznie na plikach, które mu dostarczysz, możesz wrzucić link do wykładu i „rozmawiać” z filmem bez przewijania. AI świetnie sprawdza się też jako redaktor: wklejasz brudnopis i prosisz o poprawę stylu, nie zmieniając swoich tez. Dzięki „vibecodingowi” nawet humanista stworzy zaawansowane formuły w Excelu czy skrypty w Pythonie, opisując problem po polsku.

Najważniejsza zasada to transparentność. Użycie AI jako asystenta jest akceptowalne, o ile się do tego przyznasz: ukrywanie lub oddawanie pracy wygenerowanej w całości przez maszynę to proszenie się o kłopoty. Bezpieczne użycie to korekta własnego tekstu, wyjaśnianie trudnych pojęć, pomoc w strukturze pracy czy research przez dedykowane narzędzia. Ryzykowne to generowanie całych rozdziałów metodą „kopiuj-wklej”, cytowanie niesprawdzonych źródeł czy przypisywanie sobie wniosków wymyślonych przez maszynę.

Istnienie AI sprawia że nieco zmienia się zastosowanie ludzkiej pamięci. Do wielu zadań, oraz mniej potrzebne są same informacje, ważniejszy jest kontekst potrzebny do ich znalezienia. Z drugiej strony, tworzy to pewną pułapkę, bo czasem konkretne informacje, czy nawet twarde dane, lepiej jest mieć w głowie, bo każdorazowe pytanie się o nie Chata GPT to marnowanie czasu. Dlatego fizyczne notowanie na papierze nadal sprzyja kreatywności, więc nie wyrzucaj tradycyjnego notatnika. Ciekawość pozostaje najważniejsza: AI odpowie na każde pytanie, ale to Ty musisz wpaść na pomysł, by zapytać.

Google w końcu robi dobre AI

Ten artykuł śledzi powrót Google do czołówki sztucznej inteligencji . Choć Google było pionierem w dziedzinie AI (neuronowe tłumaczenie, Asystent Google), pierwsze odpowiedzi na ChatGPT – Bard i wczesne wersje Gemini – okazały się rozczarowujące. Przełom nastąpił na początku 2025 roku, gdy Google przestało naśladować ChatGPT i zaczęło tworzyć unikalne rozwiązania wykorzystujące swoją przewagę: integrację z ekosystemem usług (Drive, YouTube, Mapy, Gmail) oraz rozwój własnych, coraz potężniejszych modeli tekstowych. Kluczem do sukcesu było nie tylko doganianie konkurencji, ale wytyczanie własnych ścieżek rozwoju – tworzenie specjalizowanych narzędzi zamiast jednego uniwersalnego chatbota.

Artykuł szczegółowo omawia trzy główne produkty Google AI. Notebook LM to asystent researchu przyjmujący do 50 źródeł (PDF, Google Docs, linki, filmy YouTube) z możliwością wyboru aktywnych materiałów przy każdym pytaniu, oferujący generowanie podcastów, mapy myśli, streszczenia i FAQ. Google AI Studio to darmowa platforma deweloperska doskonale nadająca się do przetwarzania audio i wideo na transkrypcje. Gemini oferuje Deep Research tworzący długie, spójne teksty oraz unikalne integracje z YouTube (przeszukiwanie kanałów), Dyskiem i Mapami (planowanie tras z kryteriami typu „restauracja z placem zabaw”), a także Canvas – edytor tekstów do 2000 słów z eksportem do Google Docs, lepszy od wersji ChatGPT. Strategia Google polega na tworzeniu wielu wyspecjalizowanych narzędzi zamiast jednej aplikacji uniwersalnej, co daje większą funkcjonalność, ale utrudnia integrację między produktami.

Tekst ten dodałem w maju 2025 roku. Od tego czasu Google znacząco się rozwinęło. Gemini 3 przegoniło najnowszy model Chata GPT, i sprawiło że Open AI odpaliło kod czerwony, i na szybko wypuściło model GPT 5.2. Nie chodzi tu o samo znalezienie się na szczycie w jakimś benchmarku, tu regularnie Grok, Claude, i Gemini udawało się czasem wyprzedzić Chat GPT, tu chodzi o szereg benchmarków, opinie użytkowników i liczbę pobrań aplikacji. Gemini 3 znacząco lepiej radzi sobie od Chata GPT w kodowaniu frontendu, zwłaszcza gdy użyjemy do tego narzędzia Antigravity. Dodatkowo usługi Google są coraz lepiej zintegrowane.

Ekosystem AI

Do pełnego zrozumienia sytuacji związanej z sztuczną inteligencją, dobrze jest znać kulisy działań firm. Rozwój ma miejsce na całym świecie, nie tylko w USA. AI to nie tylko Chat GPT.

Polskie firmy AI

Ten artykuł prezentuje przegląd polskiego ekosystemu firm tworzących rozwiązania oparte na sztucznej inteligencji, podzielony na pięć głównych kategorii branżowych. W medycynie i biotechnologii wyróżniają się wrocławska Infermedica (platformy do triażu lekarskiego z aplikacją mającą 500 tys. pobrań), warszawska Molecule.one (generatywna AI do projektowania syntezy leków), DeepFlare (szczepionki mRNA) oraz Labplus (automatyzacja analiz laboratoryjnych). W finansach i cyberbezpieczeństwie kluczowe są Authologic (cyfrowa weryfikacja tożsamości), Nethone (wykrywanie oszustw przez analizę behawioralną, blokujące 95% prób nieautoryzowanego dostępu), chatbot Kaspro oraz System STIR (zablokował 180 mln zł podejrzanych transakcji). Przemysł i logistykę reprezentują Nomagic (inteligentne roboty magazynowe z wizją komputerową), AI Clearing (monitoring budów przez drony i skany 3D) oraz Surveily (computer vision do BHP).

W obsłudze klienta i marketingu dominują krakowskie Synerise (analiza zachowań klientów w czasie rzeczywistym, wycenione na ponad 100 mln euro), warszawskie Cosmose AI (analiza zachowań offline przez dane z telefonów i WiFi, obsługuje 20 mln lokalizacji dla LVMH i L’Oréal, wycenione na 2 mld zł), szczecińskie Tidio (system AI do e-commerce z finansowaniem ponad 100 mln zł) oraz SentiOne i VoiceLab (voiceboty i NLP). W generatywnej AI wyróżnia się Eleven Labs – założony przez Polaków w USA, wyceniany na 3,3 mld dolarów, tworzący zaawansowaną syntezę mowy z głównym zespołem R&D w Polsce. Artykuł dowodzi, że polska scena AI przekształciła się w dynamiczny ekosystem konkurujący globalnie – od medycyny przez przemysł 4.0 po technologie głosowe, z wieloma firmami osiągającymi międzynarodowy sukces komercyjny i technologiczny.

State of the Warsaw AI podsumowanie

State of The Warsaw AI 2024 to kompleksowy raport o sztucznej inteligencji w Warszawie, który pokazuje stolicę jako lidera AI w regionie Europy Środkowo-Wschodniej.

Kluczowe liczby:

- W Polsce działa ok. 1000 firm AI, z czego 46% w Warszawie

- 15% polskich firm wdraża technologie AI (ok. 45 000 przedsiębiorstw w Warszawie)

- Polska planuje przeznaczyć 119,8 mln euro na rozwój AI w latach 2024-2030

- W Warszawie pracuje ok. 6500 specjalistów AI, ich liczba rośnie o 54% rocznie

Główne wnioski: Większość firm AI (60%) ma mniej niż 5 lat, 70% nie jest jeszcze gotowa na ekspansję. Sektor jest młody i dynamiczny, zdominowany przez startupy. Główne obszary rozwoju to analiza danych, uczenie maszynowe i generatywna AI.

Wyzwania: Największym problemem jest brak współpracy między sektorem publicznym i prywatnym (65,5% wskazań). Tylko 29% firm korzysta z pomocy publicznej z powodu biurokracji i braku informacji.

Skąd czerpać wiedzę o sztucznej inteligencji?

„Skąd czerpać wiedzę o sztucznej inteligencji, gdy ma się mało czasu?” to przewodnik po najlepszych źródłach wiedzy o AI dla osób z ograniczonym czasem.

Artykuł wskazuje sprawdzone miejsca, gdzie można szybko nadrobić zaległości. Wśród polskich źródeł wyróżnia kanały YouTube – Adrian Kilar i Netgonet oferują co dwa tygodnie zwięzłe przeglądy nowości, a społeczność Bielik na Discordzie skupia pasjonatów tworzących polski model językowy. Z oficjalnych portali poleca gov.pl/ai oraz Haimagazine.com/pl.

Po stronie anglojęzycznej wyróżnia Bush AI Cave – najlepszy agregat newsów publikujący codziennie jednozdaniowe streszczenia najważniejszych wydarzeń. Dla chcących głębszego zrozumienia poleca Two Minute Papers (kilkuminutowe omówienia badań naukowych) oraz AI Explained (analiza kluczowych wydarzeń). Matt Wolfe pokazuje praktyczne narzędzia, a Lex Fridman prowadzi wielogodzinne wywiady z liderami branży jak Sam Altman czy Yann LeCun.

Artykuł wymienia też niezbędne narzędzia: LLM Arena do testowania modeli AI bez zakładania kont, There is an AI for That jako bazę tysięcy aplikacji AI, oraz The Rundown AI – codzienny pięciominutowy newsletter z najważniejszymi wiadomościami.

Historia sztucznej inteligencji

Historia AI zaczyna się od starożytnych legend – greckiego Talosa z brązu czy żydowskiego Golema z gliny – które ujawniają odwieczne ludzkie pragnienie stworzenia sztucznego życia. Arystoteles położył fundamenty, formalizując logiczne myślenie, a Leibniz stworzył system binarny. Ada Lovelace w 1843 roku przewidziała, że maszyny mogą manipulować nie tylko liczbami, ale dowolnymi symbolami – była to pierwsza wizja komputera ogólnego przeznaczenia.

Prawdziwa rewolucja zaczęła się od Alana Turinga, który w 1950 roku zaproponował swój słynny test: jeśli nie potrafisz odróżnić maszyny od człowieka w rozmowie, to maszyna jest inteligentna. W 1956 roku na konferencji w Dartmouth narodziła się oficjalnie dziedzina AI, a jej ojcowie założyciele wierzyli, że w rok rozwiążą problem inteligencji. Grubo się mylili.

Nastały złote lata, potem bolesne rozczarowania. ELIZA w 1966 udowodniła, jak łatwo oszukać ludzi prostym chatbotem, podczas gdy robot Shakey pokazał, jak trudne jest działanie w realnym świecie. Przyszły „zimy AI” – okresy, gdy entuzjazm zamarzał, a pieniądze wysychały. Punktem zwrotnym był 1997 rok, gdy Deep Blue pokonał Kasparowa – nie dzięki inteligencji, ale brutalnej sile obliczeniowej.

XXI wiek przyniósł trzy fale rewolucji: głębokie uczenie (2012, przełom AlexNet), architektura Transformer (2017, „Attention Is All You Need”) i wreszcie eksplozja generatywna (2022), gdy ChatGPT trafił pod strzechy. Było to „moment iPhone’a” dla AI – technologia owinięta w prosty interfejs rozmowy.

Ironią historii jest to, że twórcy AI, jak Weizenbaum czy Hinton, stali się jej największymi krytykami, przerażeni mocą własnych dzieł.