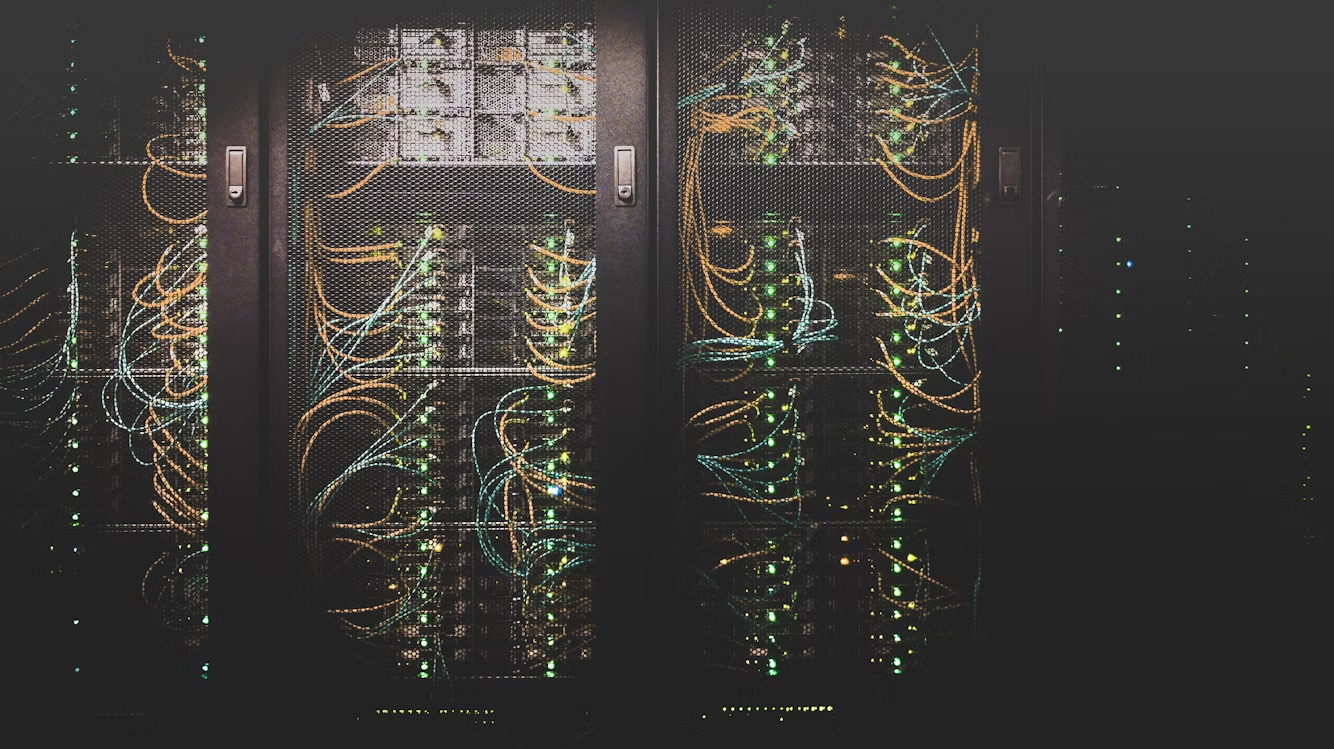

Kiedy ludzie myślą o sztucznej inteligencji, zwykle widzą przed oczami ChatGPT, Geminiego lub Groka. Później pojawiają się skojarzenia z modelami, warstwami, parametrami i całą tą skomplikowaną matematyką. Rzadko kto zastanawia się nad tym, że te wszystkie narzędzia nie działają w próżni. Potrzebują serwerów, ogromnych ilości energii, pamięci oraz centrów danych, które podtrzymują ich pracę przez całą dobę.

To właśnie nowoczesne centra danych są fundamentem współczesnej sztucznej inteligencji. Bez nich nie byłoby możliwości trenowania modeli, przechowywania danych ani obsługi użytkowników w czasie rzeczywistym. W Polsce ten obszar rozwija się wyjątkowo szybko. Powstają nowe obiekty, inwestują globalni gracze, a polskie firmy coraz częściej budują własne zaplecze obliczeniowe.

Dzięki temu kraj staje się jednym z ważniejszych punktów infrastrukturalnych w regionie. Dobra energetyka, rosnący popyt biznesowy i dostęp do wykwalifikowanych specjalistów tworzą warunki, które pozwalają rozwijać projekty AI w firmach prywatnych, instytucjach publicznych i startupach. A każda z tych technologii, od diagnostyki medycznej po generatywne modele językowe, zaczyna się w tym samym miejscu: w serwerowniach i centrach danych.

Centra danych to infrastruktura, ich wielkość mierzymy nie ilością dostępnej pamięci czy mocy obliczeniowej, a powierzchnią serwerowni i ilości mocy jaką mogą obsłużyć. W dużym skrócie, zależności od potrzeb, przestrzeń można wypełnić pamięcią, albo procesorami.

Widać też duże znaczenie energetyki i elektrowni.

W dalszej części tekstu znajdziesz przegląd najważniejszych polskich centrów danych oraz ich znaczenie dla rozwoju sztucznej inteligencji.

Spis treści

Ile jest serwerowni w Polsce?

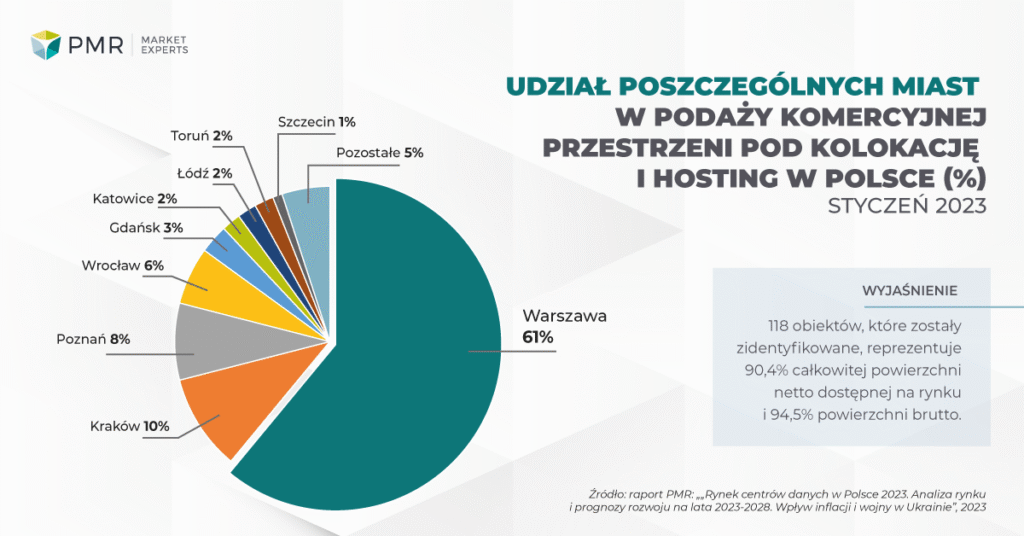

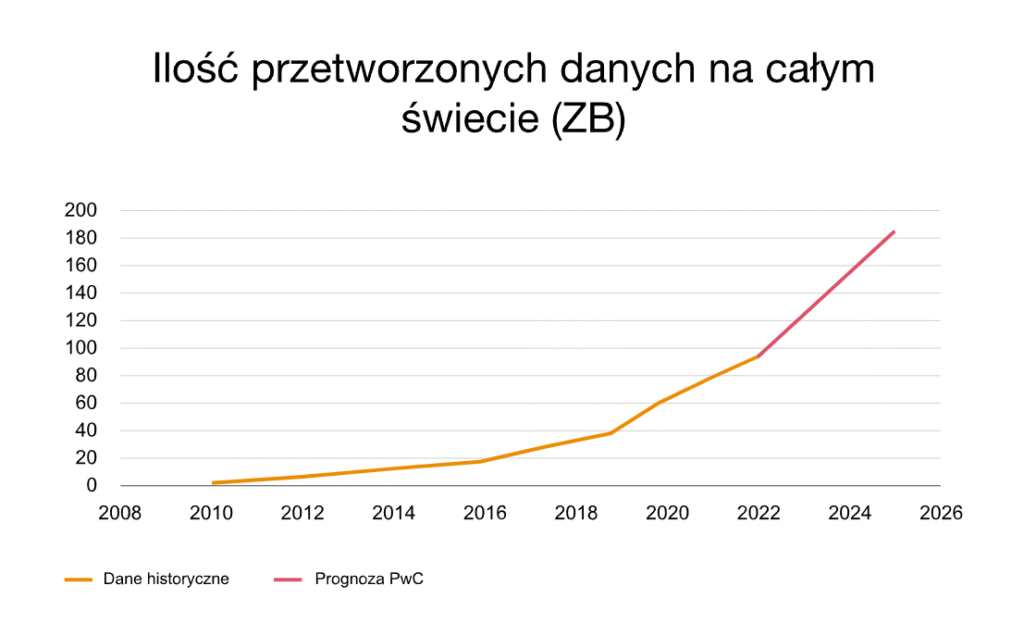

Polski rynek centrów danych rozwija się niezwykle dynamicznie, nie tylko przybywa nowych obiektów, ale także rośnie ich skala w postaci dostępnej mocy i powierzchni technicznej. Według raportu przygotowanego przez PwC na koniec 2022 roku działało w Polsce blisko 140 obiektów zaprojektowanych jako centra przetwarzania danych cyfrowych. W samej Warszawie podaż komercyjnych mocy osiągnęła około 130 MW (czyli tyle, ile zużywałoby jednocześnie ponad dwadzieścia tysięcy domowych kuchni podczas gotowania obiadu) Dodatkowo analizy firm takich jak PMR Market Experts wskazują, że moc polskich centrów danych komercyjnych może do 2030 roku przekroczyć 500 MW, co oznacza przyrost o ponad 400 MW w porównaniu z początkiem dekady.

Jeśli chodzi o powierzchnię techniczną, dane również robią wrażenie. Jednym z najnowszych raportów wskazano, że całkowita komercyjna powierzchnia centrów danych w Polsce przekroczyła już 119 000 m², a kolejne ponad 50 000 m² jest aktualnie w fazie budowy. Łącznie to ok 24 pełnowymiarowe boiska piłkarskie. W praktyce największe obiekty w kraju mierzą się z setkami tysięcy metrów kwadratowych lub dziesiątkami megawatów mocy przeznaczonej na sprzęt IT, co świadczy o wejściu Polski w erę centrów „hiperskalowych”.

Większość tych obiektów znajduje się w Warszawie i okolicach, to tu zlokalizowanych jest 61% centr danych. Na drugim miejscu jest Kraków (10%), podium zamyka Poznań (8%).

Takie liczby mówią o zmianie jakościowej rynku: to już nie tylko wiele małych serwerowni, ale coraz częściej duże kampusy, przygotowane z myślą o wymaganiach systemów sztucznej inteligencji, chmury publicznej i hurtowej kolokacji. Oznacza to, że infrastruktura musi być zdolna do obsługi ogromnych obciążeń, zarówno pod względem mocy energetycznej, jak i przestrzeni technicznej, i że Polska staje się coraz bardziej atrakcyjną lokalizacją dla globalnych inwestorów.

Gdzie jest Polska na tle innych państw?

Polska wypada zaskakująco dobrze na tle innych krajów Europy Środkowo-Wschodniej i coraz śmielej goni największe rynki zachodnie. Nie jesteśmy jeszcze „ligą mistrzów” centrów danych takich jak Holandia, Niemcy czy Francja, ale w regionie należymy do absolutnej czołówki i rozwijamy się szybciej niż wiele państw Europy Zachodniej.

Polska na tle Europy Środkowo-Wschodniej

W naszym regionie państwa z największą ilością centr danych to:

- Polska,

- Czechy,

- Austria.

Z tej trójki to Polska ma największą podaż powierzchni technicznej i najszybszy przyrost mocy energetycznej. Szacuje się, że jesteśmy liderem wzrostu w całej Europie Środkowej. Węgry, Rumunia czy Słowacja pozostają daleko w tyle pod względem zarówno mocy dostępnej dla klientów, jak i liczby nowych inwestycji.

Polska na tle Europy Zachodniej

Tutaj różnice są większe, ale dystans szybko się zmniejsza.

Największe rynki to tzw. FLAP:

- Frankfurt,

- Londyn,

- Amsterdam,

- Paryż.

Każde z tych miast dysponuje mocą liczona w gigawatach, a pojedyncze nowe kampusy osiągają 100, 200, a nawet 300 MW mocy. To kilka razy więcej niż obecnie cały rynek polski. Dodatkowo, Niemcy, UK, Holandia i Francja mają centra danych również w innych miastach. Jednak różnica polega nie tylko na skali, ale na dojrzałości rynku: tamte obiekty obsługują globalnych usługodawców chmurowych i największe firmy z branży technologicznej.

Mimo to Polska nadrabia bardzo szybko. Szacunki wskazują, że nasz rynek może przekroczyć 500 MW do 2030 roku, co wprowadziłoby nas do europejskiej „górnej ligi średniej”, obok Hiszpanii, Włoch czy Szwecji.

Polska jako strategiczna lokalizacja na mapie Europy

Jest kilka powodów, dla których Polska stała się atrakcyjna dla inwestorów:

- stabilne zasilanie i dobre decyzje energetyczne,

- położenie między Niemcami a krajami bałtyckimi,

- duży wewnętrzny rynek IT i telekomunikacyjny,

- wzrost zapotrzebowania na AI oraz chmurę,

- korzystne koszty operacyjne w porównaniu do Europy Zachodniej.

To dlatego coraz więcej firm (zarówno polskich, jak i zagranicznych) planuje budowę dużych kampusów w okolicach Warszawy, Poznania i Krakowa.

Na tle Europy Środkowo-Wschodniej Polska jest wyraźnym liderem i rozwija się najszybciej, zarówno pod względem przyrostu mocy, jak i liczby nowych inwestycji. W porównaniu z Europą Zachodnią wciąż gonimy największych graczy, a różnica w skali pozostaje zauważalna, choć dystans stopniowo się zmniejsza. Jednocześnie w globalnym łańcuchu rozwoju sztucznej inteligencji Polska zyskuje coraz większe znaczenie, ponieważ nowoczesne centra danych stają się kluczowym fundamentem dla systemów AI, które potrzebują stabilnej infrastruktury, dużej mocy i niezawodności.

Fizyczna infrastruktura danych jest krytyczna dla sztucznej inteligencji

Aby zrozumieć, dlaczego serwerownie są fundamentem rozwoju sztucznej inteligencji, warto spojrzeć na to, jak działają współczesne modele uczenia maszynowego. Każdy model wymaga trzech podstawowych zasobów:

- danych,

- pamięci

- oraz mocy obliczeniowej.

Im bardziej zaawansowany model, tym większe są wymagania. Systemy generatywne przetwarzają terabajty danych i działają w czasie rzeczywistym, co stawia wysokie wymagania wobec infrastruktury. Bez stabilnych i wysoko wydajnych centrów danych nie da się utrzymać takich usług ani ich rozwijać.

Kiedy firma wdraża algorytm personalizacji produktów, diagnostykę obrazu medycznego, analizę wideo, rozpoznawanie mowy lub model do przewidywania popytu, to wszystkie te zadania wymagają szybkich operacji na dużych zbiorach danych. Centrum danych musi zapewnić nie tylko stabilność, lecz także odpowiednią przepustowość, chłodzenie, zaplecze energetyczne oraz fizyczne zabezpieczenia. W tym sensie serwerownia jest fundamentem każdego przełomu technologicznego.

W kontekście Polski jest to szczególnie ważne, ponieważ rodzime firmy rozwijają wiele rozwiązań z zakresu sztucznej inteligencji. Branża medyczna korzysta z usług takich firm jak Infermedica, Deepflare czy Labplus. Branża finansowa inwestuje w systemy antyfraudowe rozwijane przez Nethone. Branża e commerce korzysta z koszykowych algorytmów rekomendacyjnych tworzonych przez Synerise. Wszystkie te firmy potrzebują infrastruktury zdolnej do obsługi dużego obciążenia, a część z nich, ze względów prawnych lub strategicznych, wymaga lokalizacji przetwarzania danych w Polsce.

Trzy rodzaje podmiotów budujących polską infrastrukturę danych

Krajowy rynek centrów danych można podzielić na trzy główne grupy:

- prywatne polskie firmy budujące nowoczesne serwerownie i usługi chmurowe

- instytucje państwowe, które rozwijają własne zasoby obliczeniowe oraz projekty cyfryzacyjne

- globalni operatorzy inwestujący w Polsce poprzez budowę kampusów centrum danych oraz regionów chmurowych

Wszystkie te podmioty współtworzą ekosystem, który staje się fundamentem rozwoju sztucznej inteligencji w Polsce. Każdy z nich ma nieco inne priorytety, jednak rosnąca skala projektów AI wymusza na całym rynku coraz większą wydajność i odporność.

Czym właściwie jest serwerownia i centrum danych

Serwerownia to pojedyncze, specjalnie przygotowane pomieszczenie, w którym działają serwery, macierze dyskowe i urządzenia sieciowe. Takie miejsce ma własne chłodzenie, zasilanie awaryjne, system przeciwpożarowy oraz kontrolę dostępu, dzięki czemu sprzęt może pracować nieprzerwanie przez całą dobę. Centrum danych to obiekt znacznie większy, składający się z wielu takich serwerowni, uzupełnionych o rozbudowane zaplecze energetyczne, chłodnicze i bezpieczeństwa.

Aby opisać skalę centrum danych, zwykle patrzy się na trzy kluczowe parametry. Pierwszym jest powierzchnia techniczna, czyli realna przestrzeń przeznaczona pod szafy serwerowe. Drugim dostępna moc energetyczna, która pokazuje, ile energii można wykorzystać i jaki jest potencjał rozbudowy obiektu. Trzecim klasa bezpieczeństwa, określająca poziom redundancji i odporności na awarie, opisana tak zwanymi tierami. Od podstawowego Tier I, przez najczęściej spotykany w Polsce Tier III, aż po wyjątkowo wymagający Tier.

Redundancja to zapasowe elementy lub całe systemy, które wchodzą do pracy wtedy, gdy podstawowy komponent ulegnie awarii lub wymaga serwisu. Jej celem jest zapewnienie ciągłości działania.

Centrów danych nie opisujemy ilością pamięci jaką mogą one pomieścić, czy tym jaką mocą dysponują. Wynika to z tego że ilość dostępnych petabajtów pamięci lub PFLOPS-ów mocy, zależy od sprzętu jaki jest w centrum danych wstawiony. Firmy potrzebują różnych konfiguracji, czasami ważniejsza jest moc, czasami ważniejsza jest pamięć.

Polskie prywatne firmy jako filar infrastruktury obliczeniowej

Polska branża centrów danych opiera się w dużej mierze na firmach prywatnych, które od dwóch dekad rozwijają lokalne ośrodki. Wśród nich znajdują się między innymi Atman, Beyond.pl, Comarch, Netia czy T-Mobile Polska. Każda z tych firm ma własne podejście do roli centrum danych i własną historię rozwoju.

Atman: największy polski operator centrum danych

Atman to jedna z najważniejszych firm w Polsce pod względem infrastruktury serwerowej. Jej dwa główne obiekty w Warszawie, oznaczone jako WAW 1 i WAW 2, należą do najbardziej zaawansowanych w kraju. WAW 2 wyróżnia się możliwością rozbudowy do kilkudziesięciu megawatów mocy. To poziom, który pozwala obsługiwać duże projekty związane z modelami uczenia maszynowego oraz przetwarzaniem strumieniowym.

Dla polskich firm korzystających z lokalnej infrastruktury Atman jest często pierwszym wyborem. Utrzymywanie danych w kraju jest szczególnie ważne dla branż regulowanych, takich jak finanse, zdrowie, energetyka czy sektor publiczny. Wiele usług związanych z analizą danych oraz projektami AI korzysta z serwerów Atmana, ponieważ operator zapewnia szerokie możliwości konfiguracji i wysoką dostępność.

Beyond.pl: jedyne centrum Rated 4 w Europie Środkowej

W Poznaniu znajduje się jeden z najbardziej zaawansowanych technologicznie obiektów w tej części kontynentu. Beyond.pl Data Center 2 jako jedyny w regionie uzyskał certyfikację Rated 4, co jest odpowiednikiem najwyższego poziomu odporności na awarie. Oznacza to, że centrum może działać nawet przy całkowitej awarii części infrastruktury energetycznej lub chłodniczej.

Beyond.pl od kilku lat rozwija również ogromny kampus serwerowy w Piotrkowie Trybunalskim, który ma docelowo osiągnąć kilkadziesiąt megawatów mocy. Tego typu inwestycja jest odpowiedzią na rosnące potrzeby obliczeniowe projektów AI, zwłaszcza tych, które wymagają lokalnego przetwarzania danych.

Comarch Data Center: infrastruktura dla rozwiązań korporacyjnych

Krakowski Comarch od lat rozwija własne centrum danych, które obsługuje liczne instytucje finansowe, ubezpieczeniowe oraz przemysłowe. Firma działa zarówno jako dostawca usług chmurowych, jak i jako operator infrastruktury dostosowanej do dużych systemów biznesowych.

Centrum danych Comarchu pełni ważną rolę w projektach analitycznych i algorytmicznych, ponieważ integruje się z szeroką ofertą oprogramowania firmy. W Polsce widać wyraźny trend tworzenia hybrydowych środowisk chmurowych, w których lokalna serwerownia stanowi warstwę kontrolną dla wrażliwych danych, a chmura publiczna obsługuje moduły skalowalne.

Netia i T Mobile Polska: operatorzy telekomunikacyjni w roli dostawców danych

Infrastruktura operatorów telekomunikacyjnych odgrywa istotną rolę w rozwoju AI w Polsce. Netia oraz T Mobile Polska prowadzą własne centra danych w Warszawie, Krakowie, Katowicach oraz Wrocławiu. Te serwerownie są często wybierane przez firmy poszukujące infrastruktury powiązanej bezpośrednio z usługami sieciowymi. Operatorzy telekomunikacyjni oferują zazwyczaj kompleksowe rozwiązania, łącząc serwerownie z transmisją danych oraz usługami bezpieczeństwa.

W praktyce oznacza to, że firmy rozwijające systemy sztucznej inteligencji mogą łączyć moc obliczeniową z bezpośrednim dostępem do sieci, co ma znaczenie przy projektach wymagających przetwarzania strumieniowego.

Instytucje państwowe i projekty rządowe wspierające rozwój infrastruktury AI

Polska posiada również własne zasoby obliczeniowe budowane w ramach instytucji publicznych. W ostatnich latach rośnie świadomość znaczenia mocy obliczeniowej dla rozwoju nauki, administracji i bezpieczeństwa narodowego. W efekcie powstają inicjatywy związane z krajową chmurą, danymi medycznymi oraz narzędziami wspierającymi prace badawcze.

Ośrodki akademickie i superkomputery

W Polsce działa kilka superkomputerów wykorzystywanych w nauce oraz w projektach opartych na dużych zbiorach danych. Wśród najważniejszych ośrodków znajdują się Poznańskie Centrum Superkomputerowo Sieciowe oraz Interdyscyplinarne Centrum Modelowania UW. Do tej grupy należy również Cyfronet AGH w Krakowie, gdzie pracuje superkomputer Helios, jeden z najnowocześniejszych systemów obliczeniowych w kraju.

Helios powstał jako część europejskiej infrastruktury EuroHPC i został zaprojektowany do obsługi zadań wymagających bardzo dużej mocy obliczeniowej. Jego kluczowym zastosowaniem są obliczenia naukowe, takie jak modelowanie zjawisk fizycznych, symulacje środowiskowe, analiza danych medycznych oraz projekty związane z genomiką. System został zbudowany w oparciu o architekturę przyspieszaną przez procesory graficzne, co sprawia, że znakomicie radzi sobie również z trenowaniem modeli sztucznej inteligencji oraz innymi zadaniami wymagającymi równoległego przetwarzania.

Cyfronet od lat pełni rolę jednego z filarów polskiej infrastruktury HPC, a Helios jest naturalnym rozwinięciem tej tradycji. Jego moc obliczeniowa liczona w petaflopsach stawia go w czołówce superkomputerów dostępnych w Europie Środkowo Wschodniej. Jednocześnie ośrodek zapewnia środowisko pracy dla zespołów naukowych, laboratoriów medycznych oraz projektów wykorzystujących modele głębokiego uczenia, co sprawia, że Kraków umacnia swoją pozycję jako jedno z najważniejszych centrów wysokowydajnych obliczeń w Polsce.

Superkomputer Helios był użyty między innymi przy tworzeniu polskiego modelu językowego Bielik.

Krajowy Operator Chmury Krajowej

Ciekawym przykładem współpracy publiczno-prywatnej jest Chmura Krajowa. Projekt powstał jako inicjatywa państwa i sektora finansowego, a obecnie integruje usługi lokalne z rozwiązaniami globalnych dostawców. W ramach tego ekosystemu instytucje publiczne mogą utrzymywać dane w Polsce oraz korzystać z międzynarodowych narzędzi sztucznej inteligencji.

Państwowe instytucje przetwarzające dane medyczne i administracyjne

W Polsce działa kilka dużych projektów związanych z analizą danych publicznych. Najbardziej znane z nich to rejestry medyczne, systemy e zdrowia, baza PESEL oraz narzędzia statystyczne GUS. Dane te są często wykorzystywane w pracach badawczych oraz w usługach wspierających sektor publiczny. Budowa komercyjnych oraz państwowych centrów danych ma duże znaczenie dla bezpieczeństwa tego typu zasobów.

Globalni operatorzy i tworzenie polskich regionów chmurowych

Obok polskich firm oraz instytucji państwowych ogromne znaczenie mają inwestycje gigantów technologicznych, którzy budują w Polsce własne kampusy centrum danych. Dzięki nim kraj stał się jednym z głównych punktów obliczeń w Europie Środkowej.

Google Cloud: jeden z najważniejszych regionów w regionie CEE

W 2021 roku Google uruchomił region chmurowy w Polsce. Oznacza to, że dane mogą być przetwarzane na terenie kraju, co jest kluczowe dla firm działających w branżach regulowanych. Wraz z regionem powstała infrastruktura kilku centrów danych rozmieszczonych na Mazowszu. Choć ich dokładne lokalizacje nie są publicznie podawane, wiadomo, że jest to jedna z największych inwestycji technologicznych w Polsce.

Dzięki temu polskie firmy mogą korzystać z usług takich jak BigQuery, Vertex AI, Cloud Run czy narzędzia do trenowania modeli uczenia maszynowego, bez konieczności przesyłania danych poza kraj.

Microsoft Azure Poland Central

Microsoft poszedł podobną drogą, uruchamiając region Azure Poland Central. Otworzył również kilka centrów danych, które mają obsługiwać zarówno sektor prywatny, jak i publiczny. To istotna zmiana jakościowa, ponieważ umożliwia korzystanie z zaawansowanych narzędzi sztucznej inteligencji bez konieczności przekazywania danych poza polską jurysdykcję.

Equinix: globalna sieć połączeń i kampus WA3

Equinix jest jednym z największych operatorów centrów danych na świecie. Jego obiekty WA1 i WA2 w Warszawie funkcjonują od lat, natomiast nowy kampus WA3 w okolicach Nadarzyna będzie jednym z największych ośrodków w Europie. Equinix jest szczególnie ważny dla firm rozwijających sztuczną inteligencję, ponieważ umożliwia szybkie łączenie różnych środowisk chmurowych i lokalnych w ramach jednej sieci.

Znaczenie centrów danych dla rozwoju polskich firm AI

Rosnąca liczba krajowych i międzynarodowych serwerowni ma bezpośredni wpływ na rozwój polskiego ekosystemu sztucznej inteligencji. Polskie firmy technologiczne, takie jak Synerise, Infermedica, Nethone, SentiOne, Nomagic, Surveily oraz Eleven Labs, mogą działać na światowym poziomie dzięki dostępowi do stabilnej i skalowalnej infrastruktury obliczeniowej.

Lokalne przetwarzanie danych jako wymóg regulacyjny i przewaga konkurencyjna

W niektórych branżach, takich jak medycyna, bankowość, energetyka czy ubezpieczenia, przetwarzanie danych w Polsce jest koniecznością. Dzięki temu rodzime firmy AI mogą trenować modele na danych wrażliwych, bez konieczności korzystania z zagranicznych lokalizacji.

Szybsze eksperymenty i niższe koszty testowania

Dostęp do lokalnej infrastruktury sprawia, że koszty trenowania modeli są niższe. Opóźnienia sieciowe są mniejsze, a dostęp do technik równoległego przetwarzania jest prostszy. W rezultacie polskie firmy mogą szybciej eksperymentować i wdrażać nowe rozwiązania.

Rozwój usług generatywnych i rozpoznaniowych

Firmy takie jak Eleven Labs, które rozwijają zaawansowane modele syntezy mowy, wymagają infrastruktury zdolnej do przechowywania i przetwarzania dużych zbiorów audio. Podobnie Surveily, które analizuje obraz z kamer przemysłowych, potrzebuje połączenia niskich opóźnień z dużą mocą obliczeniową.

Energia, chłodzenie i zrównoważony rozwój jako nowe wyzwania

Każde centrum danych potrzebuje energii i chłodzenia. W przypadku dużych obiektów wartości te osiągają skalę porównywalną z małymi zakładami produkcyjnymi. Wraz ze wzrostem zapotrzebowania na sztuczną inteligencję rośnie również zużycie energii. Dlatego polscy operatorzy inwestują w nowoczesne systemy odzysku ciepła, wodne technologie chłodzenia oraz instalacje fotowoltaiczne.

Największe centra danych w Polsce są projektowane tak, aby ich efektywność energetyczna była jak najwyższa. Firma Beyond.pl chwali się jednym z najniższych wskaźników PUE w Europie. Atman oraz Equinix inwestują w instalacje wykorzystujące odnawialne źródła energii oraz w hybrydowe systemy zasilania. Te działania mają znaczenie nie tylko z perspektywy ekologicznej, lecz także biznesowej, ponieważ koszty energii są jednym z głównych czynników wpływających na cenę usług serwerowych.

Piramidka technologiczna sztucznej inteligencji

Piramidka technologiczna sztucznej inteligencji pokazuje coś, o czym wiele osób zapomina: cały proces działa od góry do dołu, choć infrastruktura, którą widzimy, powstaje od dołu do góry.

Jak działa ten proces w praktyce

Na samym szczycie jest problem do rozwiązania: firma, naukowcy albo instytucja chcą stworzyć system, który będzie przewidywać popyt, analizować obrazy medyczne, generować tekst, tłumaczyć mowę, sterować produkcją, tworzyć symulacje. To właśnie od tej potrzeby wszystko się zaczyna.

Dopiero potem pojawia się kolejne pytanie:

jakie algorytmy i programy będą potrzebne, żeby ten problem rozwiązać?

Trzeba zaprojektować modele, dobrać architektury, przygotować środowiska do trenowania, stworzyć kod.

Kolejny etap to dane, bo bez nich sztuczna inteligencja nie istnieje. Zbiera się je, przetwarza i przygotowuje tak, aby system umiał się uczyć. Dopiero wtedy dochodzimy do warstwy sprzętowej, czyli decyzji:

ile mocy obliczeniowej potrzeba? jakiej pamięci? ilu GPU?

Następnie kupuje się odpowiedni sprzęt. W małych projektach zakup komputerów, serwerów czy kilku akceleratorów to kwestia tygodni lub kilku miesięcy. Tutaj najważniejsze ograniczenia to budżet oraz organizacja.

Kiedy jednak potrzeby rosną, sytuacja się zmienia.

Sprzęt musi gdzieś pracować, więc trafia do serwerowni, a przy dużej skali do profesjonalnych centrów danych. To już nie są zwykłe pomieszczenia z klimatyzacją, tylko obiekty z wielotorowym zasilaniem, wieloma systemami chłodzenia, ochroną fizyczną i redundancją.

I tu pojawia się największe wyzwanie:

duża skala AI wymaga ogromnej ilości energii.

Gdzie zaczynają się prawdziwe ograniczenia

Budowa centrum danych trwa długo i kosztuje bardzo dużo. W Polsce powstanie nowoczesnego obiektu o mocy 20–40 MW to projekt mierzący czas w latach, a nie w miesiącach. Trzeba:

- pozyskać działkę,

- uzyskać pozwolenia,

- zaprojektować obiekt,

- zapewnić przyłącza energetyczne,

- zbudować infrastrukturę techniczną,

- wdrożyć systemy chłodzenia i bezpieczeństwa.

To wszystko zajmuje czas, nawet jeśli inwestor działa bardzo sprawnie. Jeszcze większym wyzwaniem jest ostatnia warstwa piramidy technologicznej: energia.

Budowa nowych elektrowni, modernizacja bloków gazowych, źródeł OZE czy sieci przesyłowych to inwestycje wieloletnie, często przekraczające dekadę. Koszty idą w miliardy złotych lub euro. Jeśli potrzeby obliczeniowe rosną szybciej niż zdolność kraju do rozbudowy energetyki, pojawia się ograniczenie, którego nie da się przeskoczyć pieniędzmi ani dobrą wolą.

Odwrócona logika piramidy

Piramidka działa więc w dwóch kierunkach:

- od góry do dołu: potrzeba → algorytmy → dane → sprzęt → serwerownie → centra danych → energia,

- od dołu do góry: realna zdolność infrastruktury ogranicza to, ile AI można w praktyce zbudować.

W małej skali wszystko idzie szybko i sprawnie, bo wystarczy dokupić kilka serwerów. W skali dużej, tej która jest potrzebna do trenowania modeli językowych, rozpoznawania obrazu czy analityki na poziomie globalnym, główne ograniczenia nie leżą w programowaniu, lecz w betonie, kablach, chłodzeniu i megawatach.

Dlatego rozwój sztucznej inteligencji jest w dużej mierze uzależniony od infrastruktury, która stoi najniżej w piramidzie: centrów danych i energetyki. Wszystko, co widzi użytkownik na górze (modele, aplikacje, rozwiązania), jest możliwe tylko dzięki stabilnej, potężnej i długoterminowo zaplanowanej warstwie u fundamentu.

Jak szybko zaspokoić wzrost zapotrzebowania na energię?

Wzrost zapotrzebowania na energię, zwłaszcza gdy trzeba szybko zasilić nowy sprzęt lub infrastrukturę, można pokrywać tańszymi i szybciej budowanymi źródłami. Przykładowo farma fotowoltaiczna o mocy 50 MW powstaje zwykle w mniej niż rok i kosztuje około 150–180 mln zł (i można również budować mniejsze, tańsze i szybsze w budowie farmy), a nowoczesna elektrownia gazowa o mocy 400–600 MW to wydatek rzędu 2–5 mld zł przy czasie budowy wynoszącym około dwóch-trzech lat. Takie rozwiązania pozwalają elastycznie zwiększać moce, choć energia z nich bywa droższa, ponieważ koszt produkcji zależy od paliwa lub warunków pogodowych.

Zupełnie inaczej wyglądają inwestycje najbardziej kapitałochłonne, przede wszystkim elektrownie jądrowe. Budowa jednego bloku o mocy 1–1,6 GW kosztuje zazwyczaj 25–45 mld zł i trwa nawet dziesięć lat. Po uruchomieniu taki blok pracuje niemal nieprzerwanie, dostarczając tanią energię przez kilkadziesiąt lat. Koszt samego wytworzenia prądu jest tu wyjątkowo niski, ponieważ udział paliwa w całości wydatków jest minimalny. Z tego powodu system energetyczny zwykle łączy szybkie, tańsze w budowie źródła do pokrywania bieżącego wzrostu zapotrzebowania z drogimi, ale stabilnymi elektrowniami, które zapewniają długoterminową przewidywalność i niską cenę energii.

Naukowcy i specjaliści to istotny element układanki

W piramidzie technologicznej sztucznej inteligencji naukowcy i specjaliści stoją obok wszystkich warstw, ponieważ ich praca dotyczy każdego etapu tworzenia i utrzymywania systemu. Dotyczy to nie tylko osób od algorytmów i danych, ale także zespołów zajmujących się infrastrukturą: administratorów serwerów, inżynierów energetycznych, specjalistów od chłodzenia i sieci, a nawet zespołów bezpieczeństwa fizycznego i cybernetycznego. Część zadań mogą wykonywać zdalnie, jednak wiele operacji wymaga ich obecności na miejscu, przy samej infrastrukturze. Konfiguracja klastrów GPU, testy sprzętu, konserwacja systemów zasilania, prace przy chłodzeniu, inspekcje serwerowni, audyty energetyczne i bezpieczeństw, to wszystko wymaga ludzi, czasu, zaplecza technicznego oraz stałych kosztów utrzymania. Dlatego w tej piramidzie eksperci nie są tylko jedną warstwą, lecz stałym wsparciem dla całej konstrukcji, od pierwszych koncepcji modelu aż po fizyczne działanie obiektu, który musi ten model utrzymać.

Czym właściwie jest serwerownia i centrum danych

Tak jak pisałem wcześniej, serwerownia to pojedyncze pomieszczenie lub niewielka przestrzeń, w której pracują serwery, macierze dyskowe i urządzenia sieciowe. Takie miejsce musi mieć stałą temperaturę, zapasowe zasilanie, odpowiednie chłodzenie, ochronę przeciwpożarową oraz monitoring. Wszystko po to, aby sprzęt mógł działać stabilnie przez całą dobę.

Centrum danych to obiekt znacznie większy. Można powiedzieć, że składa się z wielu serwerowni, do których dochodzi pełne zaplecze energetyczne, chłodnicze i bezpieczeństwa. To nie jest tylko zbiór komputerów, lecz cała infrastruktura zaprojektowana tak, aby przetwarzać dane w sposób szybki, ciągły i bezpieczny. W kontekście sztucznej inteligencji ma to ogromne znaczenie, ponieważ nowoczesne modele są bardzo wymagające obliczeniowo i energetycznie.

Jak określić wielkość centr danych?

Skalę centrum danych określa się za pomocą trzech podstawowych parametrów:

- Powierzchnia techniczna czyli realna przestrzeń przeznaczona na szafy serwerowe.

- Moc energetyczna która wskazuje, ile energii obiekt może zużyć i na ile pozwala rozbudowa.

- gęstość energetyczna ile kilowatów można podłączyć do jednej szafy (kluczowe dla AI)

- Klasa bezpieczeństwa potwierdzona certyfikatami określającymi odporność na awarie i poziom redundancji.

Właśnie ten trzeci element jest kluczowy. To on decyduje o tym, jak obiekt zachowa się w sytuacji kryzysowej. W Polsce najwięcej jest centrów danych klasy Tier III, ponieważ oferują bardzo wysoką dostępność i jednocześnie nie generują gigantycznych kosztów utrzymania.

Dlaczego nie mówimy o dostępnej pamięci czy mocy obliczeniowej w kontekście centrów danych?

Centrum danych nie opisuje się wielkością pamięci ani mocą obliczeniową, ponieważ nie jest ono jednym komputerem, lecz infrastrukturą, która dopiero umożliwia instalowanie sprzętu obliczeniowego. Klienci wstawiają tam własne serwery, macierze dyskowe i urządzenia GPU, a ich parametry mogą się zmieniać w dowolnym momencie. Gdyby centrum danych opisano liczbą terabajtów lub TFLOPS, wartość ta byłaby niestabilna i zależałaby wyłącznie od tego, jaki sprzęt akurat stoi w środku.

Zamiast tego centrum danych opisuje się tym, co jest stałe: powierzchnią techniczną, dostępną mocą energetyczną oraz klasą bezpieczeństwa. To parametry infrastruktury, a nie komputerów. Dopiero na tej bazie klienci budują środowiska obliczeniowe dopasowane do swoich potrzeb.

Możesz myśleć o centrum danych jak o:

- garażu dla samochodów

nie opisujemy go mocą silników w autach, tylko tym, ile miejsc parkingowych ma i jakie ma instalacje, - hali logistycznej

nie opisuje się jej wagą towaru, tylko powierzchnią, udźwigiem i infrastrukturą, - centrum handlowym

nie mówi się, ile sklepów sprzeda tam towaru, tylko jaką ma powierzchnię i media.

Powierzchnia techniczna

Powierzchnia techniczna to jedno z najważniejszych pojęć w świecie centrów danych, choć na pierwszy rzut oka brzmi bardzo prosto. W praktyce oznacza ona realną, dostępną przestrzeń przeznaczoną na szafy serwerowe i infrastrukturę, która bezpośrednio obsługuje sprzęt obliczeniowy. Nie chodzi więc o cały budynek, lecz tylko tę jego część, w której faktycznie stoją urządzenia działające przez całą dobę.

To właśnie powierzchnia techniczna określa, ile sprzętu można zainstalować w obiekcie oraz jak bardzo można go rozbudować w przyszłości. Jej wielkość przekłada się na liczbę możliwych do ustawienia szaf RACK, na gęstość instalacji i na to, czy centrum danych nadaje się do obsługi zaawansowanych systemów sztucznej inteligencji. W przypadku AI ma to wyjątkowe znaczenie, ponieważ serwery GPU zużywają znacznie więcej energii i produkują więcej ciepła niż klasyczne maszyny. Im większa i lepiej zaprojektowana powierzchnia techniczna, tym łatwiej zbudować środowisko zdolne do utrzymania takich obciążeń.

Warto pamiętać, że sama powierzchnia to nie tylko puste metry kwadratowe. Muszą być wyposażone w odpowiednie podłogi techniczne, systemy chłodzenia, trasy kablowe oraz zasilanie doprowadzone w taki sposób, aby każde urządzenie miało pewne i stabilne warunki pracy. Dlatego powierzchnia techniczna jest traktowana jako zasób premium. To element, który decyduje o tym, czy dane centrum danych może obsługiwać zaawansowane projekty, oraz jak dużo infrastruktury można jeszcze dołożyć bez przebudowy całego obiektu.

W dużym uproszczeniu: im większa powierzchnia techniczna, tym większa elastyczność, skalowalność i zdolność centrum danych do obsługi rosnących potrzeb obliczeniowych, zwłaszcza w projektach związanych ze sztuczną inteligencją.

Moc energetyczna

Moc energetyczna to parametr, który decyduje o tym, jak dużo energii centrum danych jest w stanie dostarczyć do działającego w nim sprzętu. W praktyce mówi, jaką maksymalną ilość energii można równocześnie zasilać serwerami, macierzami dyskowymi, systemami chłodzenia oraz całą infrastrukturą towarzyszącą. To jeden z najważniejszych wskaźników, ponieważ nowoczesne środowiska obliczeniowe, zwłaszcza te wykorzystywane w projektach sztucznej inteligencji, są bardzo energochłonne.

Gdy patrzymy na moc energetyczną, nie chodzi jedynie o to, czy obiekt ma wystarczająco silne przyłącze. Liczy się również możliwość stabilnego dostarczania energii do każdej szafy serwerowej, redundancja linii zasilających oraz to, jak obiekt zachowa się w sytuacji skokowych obciążeń. Serwery GPU potrafią w jednej chwili pobierać kilkukrotnie więcej energii niż tradycyjne maszyny, dlatego centra danych muszą mieć odpowiednio zaprojektowaną infrastrukturę, aby sprostać takim wahaniom bez ryzyka przestoju.

Wysoka moc energetyczna przekłada się na możliwość instalowania gęstych szaf obliczeniowych, które mogą osiągać wartości od kilkunastu do nawet kilkudziesięciu kilowatów na pojedynczą szafę. To właśnie takie konfiguracje są wymagane przy trenowaniu modeli generatywnych, analizie wideo czy przetwarzaniu danych w czasie rzeczywistym. Bez odpowiedniej mocy centrum danych nie jest w stanie zapewnić stabilnej pracy serwerów ani utrzymać odpowiedniej temperatury, ponieważ systemy chłodzenia również pobierają energię i pracują proporcjonalnie do obciążenia.

Dlatego moc energetyczna jest jednym z kluczowych elementów przy porównywaniu centrów danych. Im większa i lepiej zarządzana, tym większe możliwości rozwoju, skalowania

Poziomy bezpieczeństwa danych.

Uptime Institute wprowadził cztery klasy opisujące odporność infrastruktury na awarie.

Tier I

Najprostszy poziom. Zapewnia podstawowe zasilanie i chłodzenie, lecz nie ma pełnej redundancji. Odpowiedni dla małych lokalnych serwerowni.

Cechy:

- brak redundancji,

- ryzyko przestojów przy serwisie.

Tier II

To poziom z częściową nadmiarowością. Dodaje zapasowe elementy, takie jak dodatkowe chłodzenie lub linie energetyczne.

Cechy:

- podstawowa redundancja,

- krótszy czas przestoju przy awariach.

Tier III

Najpopularniejszy poziom w Polsce. Umożliwia serwisowanie infrastruktury bez przerywania pracy systemów.

Cechy:

- pełna redundancja kluczowych elementów,

- możliwość pracy nawet przy awarii jednego systemu,

- wysoka dostępność.

Dlatego właśnie Tier III jest standardem wybieranym przez firmy pracujące nad AI.

Tier IV

Najwyższy poziom. Obiekt działa nawet wtedy, gdy jeden z głównych elementów infrastruktury przestanie funkcjonować.

Cechy:

- pełna i wielowarstwowa redundancja,

- minimalny czas przestoju,

- bardzo wysokie koszty budowy i operacji.

W Polsce występują rzadko. Najczęściej spotyka się rozbudowane rozwiązania Tier III, zbliżające się funkcjonalnie do Tier IV.

Dlaczego klasy tierów są tak ważne dla sztucznej inteligencji

Projekty AI wymagają stabilności, niskiego opóźnienia i dużej mocy obliczeniowej. Modele generatywne potrzebują silnych GPU, analiza wideo musi działać w czasie rzeczywistym, a systemy predykcyjne nie mogą się zatrzymywać.

Dlatego centrum danych musi zapewniać:

- pewne zasilanie,

- wydajne chłodzenie,

- odporność na awarie,

- możliwość szybkiej rozbudowy mocy.

Z tego powodu firmy rozwijające narzędzia AI wybierają obiekty Tier III lub Tier IV. Tylko takie centra danych są w stanie sprostać rosnącym wymaganiom obliczeniowym.

Rodzaje serwerowni i podstawowe różnice

Serwerownie różnią się skalą, konstrukcją i przeznaczeniem. Najczęściej dzieli się je na dwa główne typy.

Serwerownie lokalne

To małe pomieszczenia w firmach lub instytucjach. Służą do obsługi podstawowych potrzeb, takich jak:

- działanie systemów wewnętrznych,

- przechowywanie lokalnych danych,

- podstawowa infrastruktura sieciowa.

Takie serwerownie są ważne, ale nie nadają się do dużych projektów sztucznej inteligencji. Brakuje im redundancji, odpowiedniej mocy energetycznej oraz możliwości skalowania.

Profesjonalne centra danych

To obiekty stworzone od początku z myślą o pracy ciągłej. Wyróżniają je:

- wielotorowe, niezależne zasilanie,

- redundantne systemy chłodzenia,

- zaawansowane zabezpieczenia fizyczne,

- możliwość łatwej rozbudowy mocy i przestrzeni.

To właśnie w takich centrach danych uruchamia się systemy sztucznej inteligencji, od analityki biznesowej po generatywne modele językowe.

Słowniczek pojęć związanych z serwerami i centrami danych

Serwer

Komputer zaprojektowany do pracy bez przerwy. Udostępnia zasoby innym urządzeniom, na przykład aplikacje, pliki lub bazę danych.

Serwerownia

Pojedyncze pomieszczenie przygotowane do pracy serwerów. Ma własne chłodzenie, zasilanie awaryjne i systemy bezpieczeństwa.

Centrum danych (data center)

Duży obiekt składający się z wielu serwerowni, z rozbudowaną infrastrukturą energetyczną, chłodniczą i bezpieczeństwa.

RACK / szafa serwerowa

Metalowa szafa, w której montuje się serwery i urządzenia sieciowe. Ma standardową szerokość i wysokość podawaną w jednostkach „U”.

Jednostka U (rack unit)

Jednostka wysokości w szafach serwerowych. 1U to 4,445 cm. Standardowe serwery mają 1U lub 2U wysokości.

UPS (zasilacz awaryjny)

Urządzenie podtrzymujące zasilanie przy krótkotrwałych przerwach. Chroni serwery przed nagłym wyłączeniem.

Redundancja

Zapasowe elementy, które przejmują pracę w razie awarii. Może dotyczyć zasilania, chłodzenia lub łączy sieciowych.

Tier (klasa bezpieczeństwa)

Podział centrów danych według Uptime Institute. Określa odporność obiektu na awarie: Tier I to najniższy poziom, Tier IV najwyższy.

PUE (Power Usage Effectiveness)

Wskaźnik efektywności energetycznej. Informuje, ile energii trafia do serwerów, a ile zużywa reszta infrastruktury.

Chłodzenie precyzyjne

System chłodzenia serwerów zapewniający stabilną temperaturę i wilgotność. Wydajniejszy niż tradycyjne klimatyzatory.

Kontrola dostępu

System zabezpieczeń fizycznych, taki jak karty, biometria, monitoring i rejestry wejść.

Gęstość energetyczna

Ilość energii, którą można dostarczyć do jednej szafy serwerowej. Kluczowe w projektach AI, gdzie szafy GPU potrzebują nawet 40 kW.

Kolokacja (colocation)

Usługa polegająca na udostępnianiu miejsca w centrum danych na sprzęt klienta. Centrum zapewnia prąd, chłodzenie i zabezpieczenia.

Chmura publiczna

Zestaw usług obliczeniowych udostępnianych przez globalnych dostawców, na przykład Google, AWS lub Microsoft. Sprzęt znajduje się w ich centrach danych.

Hiperskala (hyperscale)

Centra danych bardzo dużej skali, najczęściej budowane przez firmy chmurowe. Mają setki tysięcy metrów kwadratowych i setki megawatów mocy.

HPC (High Performance Computing)

Obliczenia wysokowydajne wykonywane na superkomputerach lub klastrach. Wykorzystywane w nauce, fizyce, analizie danych i AI.

GPU server

Serwer wyposażony w procesory graficzne przystosowane do obliczeń równoległych, niezbędny do trenowania modeli AI.

Failover

Automatyczne przełączenie pracy na zapasowy system w przypadku awarii głównego.

Load balancing

Równomierne rozkładanie obciążenia między wieloma serwerami, aby zwiększyć wydajność i uniknąć przeciążeń.

Polska jako rosnący hub sztucznej inteligencji

Połączenie krajowych centrów danych z regionami chmurowymi Google i Microsoft oraz globalnymi sieciami takimi jak Equinix sprawia, że Polska stała się jednym z najważniejszych punktów obliczeń w Europie Środkowej. Ten rozwój infrastruktury powoduje, że polskie startupy mogą konkurować na rynku globalnym, a instytucje państwowe mają dostęp do narzędzi analitycznych najwyższej jakości.

W efekcie powstaje struktura, która umożliwia szybkie wdrażanie nowych technologii. Modele językowe, systemy analityczne, generatywne narzędzia dla biznesu, systemy antyfraudowe i algorytmy medyczne rozwijają się w tempie wynikającym w dużej mierze z dostępności infrastruktury obliczeniowej. To dlatego właśnie serwerownie stają się fundamentem nowego etapu cyfrowej transformacji w Polsce.

Podsumowanie

Największe serwerownie w Polsce odgrywają kluczową rolę w rozwoju sztucznej inteligencji. To one umożliwiają trenowanie modeli, przetwarzanie ogromnych zbiorów danych oraz działanie aplikacji w czasie rzeczywistym. Polskie prywatne firmy, instytucje państwowe oraz globalni operatorzy wspólnie tworzą ekosystem, który stawia kraj w centrum europejskiej rewolucji technologicznej.

Jeśli chcesz, mogę przygotować także drugą część tego artykułu o przyszłości serwerowni w Polsce, o chłodzeniu cieczą, o przewidywanych inwestycjach do 2030 roku lub o tym, jak zmieni się architektura centrów danych w erze gen AI.