Artykuł możesz traktować jako mapę pojęć ai, czyli punkt odniesienia, do którego warto wracać podczas nauki z innych materiałów o sztucznej inteligencji.

Celem tego artykułu jest uporządkowanie wiedzy o AI w prosty i praktyczny sposób. Tekst ma służyć jako pomoc przy nauce z innych źródeł: pokazuje podstawowe pojęcia, mechanizmy działania modeli oraz najważniejsze obszary zastosowań.

Zaczynamy od wyjaśnienia, czym jest sztuczna inteligencja i jak działają modele, sieci neuronowe czy zjawiska takie jak halucynacje. Następnie przyglądamy się dużym i małym modelom językowym, rozpoznawaniu obrazów i mowy, systemom rekomendacyjnym oraz generowaniu treści. Dalej omawiamy, jak modele są trenowane i używane, jakie wymagają zaplecze technologiczne oraz gdzie rozwijają się huby AI w Polsce i na świecie.

Pojęć związanych z sztuczną inteligencją jest bardzo dużo. W tym tekście skupiam się na podstawach, poszczególne zagadnienia będą opisywane w osobnych artykułach i odpowiednio linkowane. Dodatkowo większą listę haseł związanych z AI znajdziesz tutaj.

Spis treści

Podstawy Podstaw

Czym jest sztuczna inteligencja

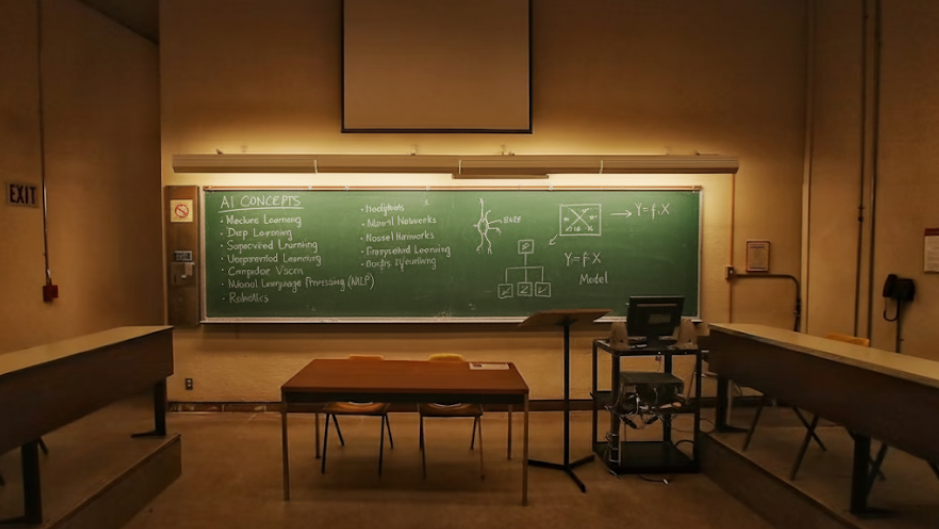

Sztuczna inteligencja, znana szerzej jako Artificial Intelligence (AI), to zbiór metod, które pozwalają maszynom wykonywać zadania kojarzone dotąd z ludzką inteligencją. Chodzi tu o rozumienie języka, rozpoznawanie obrazów czy planowanie. Ponieważ nie ma jednej definicji ludzkiej inteligencji, opis AI ma charakter ogólny i służy głównie jako kontekst do zrozumienia zjawiska.

Uczenie maszynowe

Podstawowym podzbiorem AI jest Machine Learning (ML), czyli uczenie maszynowe. W tym podejściu model nie jest programowany krok po kroku, lecz uczy się wzorców bezpośrednio z danych. Dzięki temu potrafi lepiej reagować na nowe sytuacje.

Uczenie głębokie

Szczególną odmianą ML jest Deep Learning (DL), oparte na wielowarstwowych sieciach neuronowych. Takie modele świetnie skalują się na ogromne zbiory danych i leżą u podstaw współczesnych rozwiązań, takich jak systemy rozpoznawania mowy czy obrazu.

Model i jego działanie

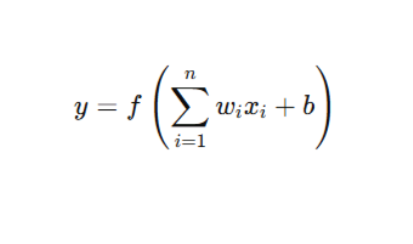

Model w uczeniu maszynowym to funkcja matematyczna z zestawem parametrów. W przypadku sieci neuronowych są to wagi oraz biasy. Waga określa siłę połączenia między neuronami, natomiast bias wprowadza przesunięcie, które pozwala lepiej dopasować się do danych. To właśnie parametry decydują o tym, jak skutecznie model rozpoznaje wzorce i jakie przewidywania potrafi generować.

Halucynacje w AI

W kontekście modeli językowych często mówi się o halucynacjach. To sytuacje, w których model tworzy odpowiedzi brzmiące wiarygodnie i pewnie, ale mijające się z faktami. Wynika to z probabilistycznej natury działania: model przewiduje kolejne słowa na podstawie wzorców, które zna, i dąży do „domknięcia” wypowiedzi. Jeśli dane treningowe były niepełne lub polecenie jest niejednoznaczne, łatwo o błędne treści.

Główne tematy AI

LLM – Large Language Models (duże modele językowe)

LLM to modele sztucznej inteligencji trenowane na ogromnych zbiorach tekstu, które potrafią rozumieć i generować język naturalny. Dzięki nim możliwe jest odpowiadanie na pytania, tłumaczenie, streszczanie czy tworzenie nowych treści. W praktyce wspierają edukację, biznes, programowanie i komunikację. Przykładami są Claude, ChatGPT czy Grok.

Małe modele językowe

Stanowią uproszczone wersje dużych modeli, które działają szybciej i wymagają mniej zasobów. Choć mają ograniczoną zdolność rozumienia i generowania tekstu, świetnie sprawdzają się w zadaniach specjalistycznych – na przykład na urządzeniach mobilnych lub w aplikacjach biznesowych. Co ważne, można je uruchomić nawet na zwykłym laptopie czy zegarku elektronicznym. Kilka lat temu były istotnym etapem rozwoju, dziś ich miejsce częściowo przejęły nowsze, wydajne LLM.

Computer vision (rozpoznawanie obrazów)

To obszar AI, który pozwala maszynom analizować obrazy i wideo. Systemy tego typu rozpoznają twarze, obiekty, tekst czy całe sceny, a także śledzą ruch i klasyfikują obrazy. Znalazły zastosowanie w medycynie (na przykład analiza zdjęć rentgenowskich), motoryzacji (auta autonomiczne) oraz w codziennych aplikacjach, takich jak odblokowywanie telefonu twarzą. Rozwój tej dziedziny okazał się prostszy niż stworzenie dużych modeli językowych i to ona otworzyła drogę wielu innym zastosowaniom AI.

AI którego nie widać

ChatGPT był pierwszym szeroko dostępnym systemem AI, który pozwolił zwykłym użytkownikom realnie wykorzystywać możliwości sztucznej inteligencji. Dzięki temu każdy mógł doświadczyć czegoś, co wcześniej było domeną ekspertów. Warto jednak pamiętać, że obok widocznych aplikacji istnieje cała warstwa „niewidzialnej” AI – działającej w tle wyszukiwarek, systemów rekomendacyjnych czy narzędzi biznesowych – która kształtuje nasze codzienne doświadczenia.

Rozpoznawanie mowy (speech recognition)

To technologia zmieniająca mowę na tekst. Dzięki niej możliwa jest komunikacja głosowa z asystentami (Siri, Alexa), automatyczne napisy w filmach czy obsługa komend głosowych w urządzeniach.

Systemy rekomendacyjne (recommendation systems)

To algorytmy analizujące dane o użytkownikach i ich wyborach. Na tej podstawie proponują treści dopasowane do preferencji: filmy na Netflixie, produkty w e-sklepie czy muzykę w Spotify.

Generowanie obrazów

To dziedzina AI, w której modele tworzą grafiki na podstawie opisu tekstowego lub innych danych. Dzięki temu możliwe jest tworzenie ilustracji, zdjęć i projektów graficznych bez udziału człowieka. Technologia ta ma zastosowania w sztuce, marketingu czy projektowaniu.

AI robiące konkretne zadania, symulacje, grające w gry

Sztuczną inteligencję można wytrenować do bardzo praktycznych celów, jak sterowanie robotami, ale też do rozrywki – na przykład do kontrolowania postaci w grach czy symulacji różnych scenariuszy.

Jak działają (modele językowe)

Nawet powierzchowne zrozumienie działania modeli językowych ułatwia korzystanie z nich. Budowanie modelu od zera jest bardzo trudne (trudniejsze niż rozpoznawanie obrazów), ale już dostosowywanie go przez finetuning, RAG czy inne techniki jest w zasięgu wielu osób.

Generowanie obrazów to osobna dziedzina AI, w której modele tworzą grafiki na podstawie opisu tekstowego lub innych danych. Dzięki temu można uzyskać ilustracje, zdjęcia czy projekty graficzne bez udziału człowieka-artysty. Technologia ta znalazła zastosowanie w sztuce, marketingu i projektowaniu.

Transformer

Transformer to ogólna, abstrakcyjna nazwa sposobu przetwarzania danych opartego na warstwach, mechanizmie Attention oraz sieciach Feed Forward. Nie jest to element fizyczny, jak tranzystor czy bramka logiczna. Można go rozumieć jako architekturę modelu językowego, a nie pojedynczy komponent. To właśnie ta koncepcja sprawiła, że powstały systemy takie jak ChatGPT.

Warstwa (Layer)

Warstwa to blok obliczeń, który przekształca tensor wejściowy w tensor wyjściowy. Niższe warstwy wychwytują relacje między słowami, a wyższe między zdaniami czy akapitami. W modelach typu Transformer spotykamy różne warstwy, na przykład odpowiedzialne za mechanizm uwagi, przekształcenia wektorów czy normalizację wartości. Każda działa jak funkcja matematyczna: przyjmuje dane i zwraca wynik.

Token (Token)

Tokeny to najmniejsze jednostki tekstu przetwarzane przez model. Mogą być pojedynczymi znakami, fragmentami słów (subwyrazami, sylabami), a czasem całymi słowami.

Macierz osadzeń (Embedding Matrix)

Modele językowe nie operują na zwykłych liczbach, lecz na wektorach wielowymiarowych. Na przykład liczba przypisana do słowa „kot” (np. 5432) jest zamieniana na wektor [0.12, -0.87, 0.33, …]. Takie mapowanie wykonuje macierz osadzeń, która przypisuje każdemu tokenowi odpowiedni wektor.

Parametry (Parameters)

Parametry to liczby sterujące zachowaniem modelu. W sieciach neuronowych są to wagi oraz biasy, które decydują o tym, jak model uczy się rozpoznawać wzorce i jakie sygnały uważa za istotne.

Tensor

Tensor w sztucznej inteligencji to wielowymiarowa tablica liczb. Jest uogólnieniem znanych z matematyki obiektów, jak macierze czy wektory, i stanowi podstawowy sposób przechowywania danych w modelach.

Sieć neuronowa

Sieć neuronowa to system wzorowany na działaniu mózgu. Składa się z warstw połączonych „neuronów”, które przetwarzają dane krok po kroku. Dzięki temu sieć potrafi rozpoznawać wzorce i wykonywać złożone zadania, takie jak rozumienie języka, analiza obrazów czy podejmowanie decyzji.

Neuron

Neuron w sztucznej inteligencji to podstawowa jednostka obliczeniowa. Otrzymuje dane wejściowe, mnoży je przez przypisane wagi, dodaje bias, a następnie przepuszcza wynik przez funkcję aktywacji. W praktyce oznacza to proste równanie matematyczne, które decyduje o przekazaniu sygnału dalej.

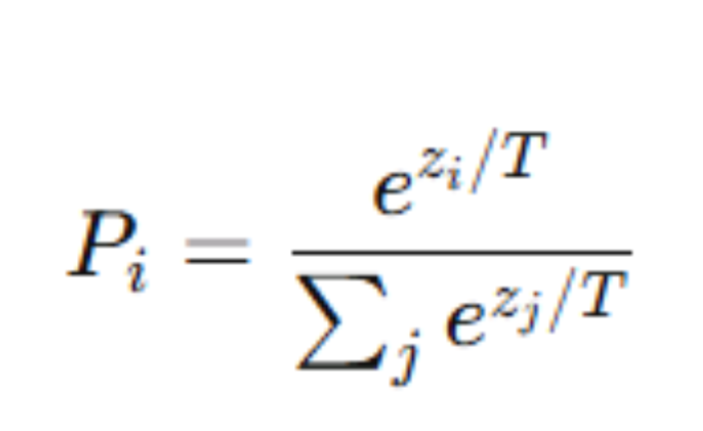

Temperatura

Temperatura to parametr w modelach językowych regulujący losowość odpowiedzi. Wyższa temperatura zwiększa różnorodność i kreatywność generowanych treści, niższa sprawia, że są bardziej przewidywalne i zachowawcze. Na końcu działania modelu wartości liczbowe (logity) są przekształcane w rozkład prawdopodobieństwa za pomocą funkcji softmax, która wzmacnia różnice między wynikami.

Pojęcia AI związane z rozpoznawaniem obrazów)

W przeciwieństwie do modeli językowych, z funkcji rozpoznawania obrazów większość ludzi korzysta całkowicie biernie, traktując model jako czarną skrzynkę, na zasadzie „albo działa, albo nie działa”.

Działanie rozpoznawania obrazów jest prostsze niż generowanie tekstu i każdy, kto ma trochę czasu, jest w stanie je zrozumieć. Wymaga to jednak podstaw programowania.

Wiedza o tym, jak działa rozpoznawanie obrazów, przydaje się nie tylko jako ćwiczenie pozwalające lepiej zrozumieć sztuczną inteligencję. W wielu sytuacjach AI można wykorzystać także do kontroli jakości.

Konwolucja (convolution)

Podstawowa operacja w sieciach konwolucyjnych. Polega na przesuwaniu filtra (małej macierzy) po obrazie i obliczaniu wartości. Dzięki temu możliwe jest wykrywanie krawędzi, kształtów oraz innych cech wizualnych.

Filtr / kernel

Macierz liczb stosowana w konwolucji. Określa, jakie cechy obrazu są wzmacniane, a jakie tłumione (na przykład krawędzie poziome, pionowe czy tekstury).

Pooling

Operacja zmniejszająca rozdzielczość obrazu w sieci. Najczęściej stosuje się „max pooling”, który wybiera największą wartość z małego fragmentu obrazu, zachowując kluczowe informacje i redukując ilość danych.

Mapa cech (feature map)

Wynik działania filtrów na obrazie. Każda mapa cech pokazuje, które fragmenty obrazu zostały aktywowane przez dany filtr – na przykład miejsca z krawędziami lub powtarzającym się wzorem.

Pojęcia AI związane z trenowaniem sztucznej inteligencji.

Najwięcej energii i mocy obliczeniowej zużywa trenowanie sztucznej inteligencji. Sam model po wytrenowaniu nie wymaga już tak dużych zasobów, ale stworzenie matryc połączeń między słowami to proces kosztowny i czasochłonny. Wiedza o tym, jak zbierać dane i je oczyszczać, by były użyteczne w uczeniu modeli, jest bardzo praktyczna i często ważniejsza niż sama znajomość technik trenowania.

Fine-tuning

Dodatkowe trenowanie modelu na mniejszym, specjalistycznym zbiorze danych, aby lepiej sprawdzał się w konkretnym zastosowaniu, np. w medycynie czy prawie.

Korpus treningowy

Ogromny zbiór tekstów, na którym model się uczy. Mogą to być książki, artykuły, strony internetowe czy dokumenty techniczne. Jakość i różnorodność korpusu wprost przekładają się na możliwości modelu.

Pre-trening (pretraining)

Pierwsza faza trenowania modelu na bardzo dużych i ogólnych zbiorach danych. Umożliwia nauczenie go podstawowych zasad języka, zanim zostanie dostosowany do konkretnych zadań.

Instruction tuning

Proces dostrajania modelu za pomocą zestawów instrukcji i przykładów pytań-odpowiedzi, tak aby reagował w sposób bardziej zgodny z oczekiwaniami użytkowników.

RLHF (Reinforcement Learning from Human Feedback)

Metoda, w której ludzie oceniają odpowiedzi modelu, a ich oceny służą do dalszego trenowania. Dzięki temu model lepiej odpowiada zgodnie z preferencjami użytkowników.

Overfitting (przeuczenie)

Sytuacja, gdy model zapamiętuje dane treningowe zamiast uczyć się je uogólniać. Skutkuje to bardzo dobrymi wynikami na znanych przykładach, ale słabymi na nowych danych.

Batch i epoch

Batch to porcja danych, na której model uczy się w jednym kroku. Epoch oznacza przejście przez cały zbiór treningowy. Liczba epok i wielkość batcha mają duży wpływ na jakość uczenia.

Learning rate

Parametr określający, jak dużym krokiem model aktualizuje swoje wagi podczas uczenia. Zbyt wysoki powoduje chaos, a zbyt niski znacząco spowalnia naukę.

Regularizacja

Zestaw technik (np. dropout, ograniczanie wag), które zapobiegają przeuczeniu i poprawiają zdolność modelu do generalizacji.

Tokenizer treningowy

Algorytm dzielący tekst na najmniejsze jednostki (tokeny), które model wykorzystuje. Przy trenowaniu trzeba go dobrze zaprojektować i dopasować do języka oraz danych, z jakimi model będzie pracować.

Używanie AI

Pojęcia związane z używaniem, testowaniem, oraz ewaluowaniem/ocenianiem sztucznej inteligencji.

Komenda (Prompt)

Prompt o instrukcja lub pytanie, które podajesz modelowi. Od jego treści i precyzji zależy, jaką odpowiedź wygeneruje sztuczna inteligencja. Obecne modele językowe są na tyle dobre, że najczęściej bardziej przydatne są ogólne umiejętności rozmawiania z AI.

API AI

Interfejs, który umożliwia podłączenie modeli sztucznej inteligencji do aplikacji i systemów. Dzięki temu AI może działać jako element większego rozwiązania.

Prompt engineering

To umiejętność formułowania promptów tak, aby model dawał trafniejsze, bardziej użyteczne odpowiedzi. W praktyce polega na testowaniu różnych wariantów i wybieraniu najlepszego.

Prompt engineering ma szczególne znaczenie w tych programach które nie mają zbyt dobrze rozwiniętego modułu językowego, np. w zaawansowanych generatorach obrazów.

Jailbreaking

Omijanie zabezpieczeń i cenzury w modelach językowych.

Zero-shot learning

Sytuacja, gdy model rozwiązuje zadanie, którego wcześniej nie widział, jedynie na podstawie opisu w promptcie.

Few-shot learning

Tutaj użytkownik podaje kilka przykładów rozwiązania w promptcie, a model uczy się schematu i lepiej odpowiada na kolejne pytania.

Chain-of-thought

To sposób, w którym model najpierw rozpisuje rozumowanie krok po kroku, a dopiero potem podaje końcową odpowiedź. Dzięki temu jest bardziej dokładny przy złożonych problemach.

Context window

To zakres tekstu (liczony w tokenach), który model bierze pod uwagę w danej interakcji. Jeśli przekroczysz limit, model „zapomina” wcześniejszy kontekst.

Hallucination

Tak określa się sytuację, gdy model wymyśla fakty i przedstawia je tak, jakby były prawdziwe, mimo że nie istnieją w danych.

RAG (Retrieval-Augmented Generation)

Technika, w której model językowy łączy generowanie tekstu z wyszukiwaniem w bazie wiedzy lub dokumentach. Dzięki temu odpowiedzi są bardziej aktualne i wiarygodne.

Latencja

To czas, jaki upływa od momentu wysłania zapytania do otrzymania odpowiedzi od modelu. Niska latencja oznacza szybkie działanie.

Drift danych

Drift danych to zjawisko, w którym dane napływające do modelu w czasie różnią się od tych, na których model był trenowany. Powoduje to spadek jakości predykcji, bo model przestaje dobrze odzwierciedlać rzeczywistość.

Ekosystem AI

Wielkie fabryki AI mają zapotrzebowanie na energię porównywalne z dużymi miastami. Rozmowa o sztucznej inteligencji to nie tylko rozmowa o programach, ale również o zapleczu energetycznym, naukowym, itd.

Serwery GPU

Specjalistyczne maszyny wyposażone w karty graficzne, które znacząco przyspieszają obliczenia niezbędne do trenowania i uruchamiania modeli sztucznej inteligencji.

Chmura obliczeniowa

Usługi takie jak AWS, Azure czy Google Cloud umożliwiają korzystanie z mocy obliczeniowej i pamięci bez potrzeby inwestowania w kosztowną infrastrukturę lokalną.

Edge computing

Przetwarzanie danych bliżej miejsca ich powstania, na przykład na smartfonie, kamerze czy innym urządzeniu końcowym. Dzięki temu możliwe jest ograniczenie opóźnień i kosztów związanych z przesyłaniem danych do chmury.

Data center

Centra danych, w których zlokalizowane są serwery oraz infrastruktura wspierająca przechowywanie i przetwarzanie ogromnych zbiorów danych niezbędnych do działania systemów AI.

Frameworki AI

Biblioteki programistyczne, takie jak TensorFlow czy PyTorch, pozwalają tworzyć, trenować i optymalizować modele sztucznej inteligencji w sposób uporządkowany i powtarzalny.

Bazy danych

Systemy przeznaczone do przechowywania i szybkiego udostępniania danych, wykorzystywanych zarówno do trenowania, jak i obsługi modeli AI. Przykłady to PostgreSQL, MongoDB czy wyspecjalizowane bazy wektorowe, takie jak Pinecone.

MLOps

Zbiór praktyk i narzędzi wspierających pełny cykl życia modeli sztucznej inteligencji: od trenowania, przez wdrożenie, po monitorowanie i aktualizacje w środowisku produkcyjnym.

Konteneryzacja

Technologie takie jak Docker czy Kubernetes pozwalają uruchamiać modele AI w powtarzalny sposób, niezależnie od środowiska sprzętowego czy systemowego.

SDK Software Development Kit

SDK (Software Development Kit) to zestaw narzędzi dla programisty: biblioteki, dokumentacja, przykłady i narzędzia potrzebne do tworzenia aplikacji dla danej platformy.

Przykłady: Android SDK do pisania aplikacji mobilnych, Java SDK (JDK) do programów w Javie, OpenAI SDK do korzystania z modeli AI w aplikacjach.

Monitoring i observability

Systemy służące do śledzenia jakości działania modeli, w tym dokładności, błędów czy kosztów. Wspierają także wykrywanie dryfu danych oraz potencjalnych nadużyć.

ANI (Artificial Narrow Intelligence)

To tzw. wąska sztuczna inteligencja. Działa w określonym zakresie i wykonuje konkretne zadania, np. rozpoznawanie obrazów, tłumaczenie tekstów czy rekomendacje w e-commerce. Jest skuteczna, ale nie potrafi wychodzić poza wyznaczoną dziedzinę. Dodatkowo, można podzielić ANI na np. schematyczną i złożoną. Takie rozróżnienie nie jest powszechnie przyjęte, ale jest bardzo praktyczne. Schematyczna ANI to np. filtr zamieniający twarze, złożona ANI to generator zdjęć, w którym możemy tworzyć różne zdjęcia.

AGI (Artificial General Intelligence)

To ogólna sztuczna inteligencja. W teorii dorównuje człowiekowi w zdolności uczenia się, rozumienia i rozwiązywania problemów w wielu różnych dziedzinach. Na razie pozostaje koncepcją, a badania nad nią są wciąż na wczesnym etapie.

ASI (Artificial Superintelligence)

To hipotetyczny poziom sztucznej inteligencji przewyższający możliwości człowieka we wszystkich dziedzinach. ASI nie tylko wykonywałaby zadania szybciej i dokładniej, ale też sama tworzyłaby nowe idee, technologie i strategie. Na razie jest to wyłącznie koncepcja rozważana w teoriach i prognozach dotyczących przyszłości AI.

Singularity (osobliwość technologiczna)

To pojęcie opisujące hipotetyczny moment, w którym sztuczna inteligencja osiągnie poziom przewyższający ludzki umysł i zacznie samodzielnie się ulepszać. Według tej wizji rozwój technologii stanie się wtedy wykładniczy, a zmiany społeczne, gospodarcze i kulturowe – trudne do przewidzenia. Singularity często wiąże się z koncepcją ASI i budzi zarówno nadzieje, jak i obawy.

Huby AI

Huby AI to miasta i regiony, gdzie firmy, uczelnie i instytucje wspólnie rozwijają sztuczną inteligencję dzięki talentom, inwestycjom i infrastrukturze.

W Polsce należą do nich: Warszawa, Kraków, Wrocław, Poznań, Trójmiasto i Śląsk.

W Europie kluczowe są: Londyn, Berlin, Paryż, Amsterdam, Zurych i Helsinki – z czego Londyn wyróżnia się jako globalne centrum AI łączące naukę, biznes i finanse.

Wpływ AI na społeczeństwo

Automatyzacja pracy

AI zastępuje część zadań wykonywanych przez ludzi, co zwiększa efektywność, ale rodzi obawy o utratę miejsc pracy.

Nierówności cyfrowe

Dostęp do AI nie jest równy – większe firmy i kraje rozwinięte szybciej zyskują przewagę nad mniejszymi i biedniejszymi.

Dezinformacja

Generatywne modele mogą tworzyć fałszywe treści (deepfake, fake news), wpływając na opinię publiczną i politykę.

Prywatność

AI analizuje ogromne ilości danych osobowych, co wiąże się z ryzykiem nadużyć i naruszeń prywatności. Należy zachować pewną ostrożność przy korzystaniu z modeli AI które nie są hostowane na własnym sprzęcie.

Etyka algorytmów

Decyzje podejmowane przez AI mogą być stronnicze, jeśli model został wytrenowany na niepełnych lub uprzedzonych danych.

Wpływ na edukację

AI zmienia sposób nauki i pracy z wiedzą – ułatwia dostęp do informacji, ale może też osłabiać krytyczne myślenie.

Nowe modele pracy

Rozwój AI sprzyja powstawaniu nowych zawodów i specjalizacji (np. prompt engineer, AI auditor).

Zaufanie społeczne

Sposób, w jaki AI jest wdrażana, wpływa na to, czy ludzie ufają technologiom i instytucjom, które je stosują.

Praktyczne rzeczy i podsumowanie

Ten artykuł przewidziany jest dla osób które już w miarę kojarzą działanie sztucznej inteligencji. Jeśli po raz pierwszy zetknąłeś się z tymi pojęciami, to być może będą dla Ciebie użyteczne poniższe teksty.

Przydatne programy AI

Obok popularnych narzędzi AI, takich jak ChatGPT czy Midjourney, istnieje wiele mniej znanych, ale bardzo praktycznych rozwiązań.

Przykładem mniej znanego, a bardzo praktycznego narzędzia jest Notebook LM od Google. To swego rodzaju inteligentny asystent badawczy i notatkowy, który działa w oparciu o twoje własne dokumenty. Możesz wgrać do niego pliki (np. PDF czy Google Docs), a następnie zadawać pytania o ich treść, otrzymywać streszczenia, a nawet generować przeglądy audio. Co więcej, Notebook LM potrafi tworzyć quizy, fiszki i interaktywne materiały edukacyjne, dzięki czemu świetnie sprawdza się zarówno w pracy naukowej, jak i w codziennym porządkowaniu wiedzy.

Innym przykładem jest Gamma App, narzędzie do generowania prezentacji, które łączy sztuczną inteligencję z prostym interfejsem. Wystarczy wprowadzić temat, a aplikacja tworzy spójną strukturę slajdów, dbając o przejrzysty układ i estetykę.

ElevenReader od firmy Eleven Labs to genialne narzędzie, dzięki któremu możesz słuchać dokumentów (i jakość tego dźwięku jest dużo lepsza niż w Chat GPT czy Gemini)

Etapy wdrażania AI w firmie

Znajomość etapów wdrażania AI, pozwala lepiej opracować plan działania. Oczywiście w każdej organizacji może to wyglądać różnie, natomiast często występują następujące etapy.

- Podstawy bezpieczeństwa – ustalenie zasad, czego nie wolno robić (np. nieudostępnianie danych poufnych modelom publicznym, weryfikacja treści generowanych przez AI, oznaczanie materiałów).

- Nauka i eksperymenty – testowanie narzędzi, poznawanie promptowania, dzielenie się doświadczeniami i pierwsze próby w praktyce.

- Zakup narzędzi – wybór odpowiednich licencji, narzędzi zespołowych i wprowadzenie podstawowych procedur bezpieczeństwa.

- Proste rozwiązania wewnętrzne – automatyczne notatki, wyszukiwanie procedur, wsparcie wdrożeń, lokalne modele przy pracy na wrażliwych danych.

- Zaawansowane wdrożenia – tworzenie własnych systemów, rozwiązań dla klientów i dużych projektów opartych o AI, gdy zespół ma już doświadczenie.