Kilka dni temu OpenAI udostępniło nową funkcję o nazwie Deep Search dla użytkowników korzystających z tańszych, płatnych planów ChatGPT. Narzędzie to pracuje od 10 do 30 minut, generując obszerne, szczegółowe i zaawansowane treści.

Jak wypada to rozwiązanie na tle innych popularnych narzędzi do zaawansowanego researchu, takich jak Perplexity, Grok czy Gemini, które również ostatnio wprowadziły bezpłatne opcje? Do czego najlepiej wykorzystać Deep Search? Jakie typy promptów sprawdzają się najlepiej i czy istnieją sposoby, aby podobny efekt uzyskać niższym kosztem? Tego wszystkiego dowiesz się z poniższego tekstu.

Według wielu użytkowników efekty działania Deep Search są imponujące, a dla części osób (w tym również dla mnie) wywołują autentyczny efekt „wow”. Każdorazowe użycie tego narzędzia pozwala mi zaoszczędzić od 2 do 4 godzin żmudnej pracy, co prawdopodobnie zwiększa mój zachwyt bardziej niż u przeciętnego użytkownika. Niemniej jednak głęboki research to coś, co może się przydać praktycznie każdemu.

Spis treści

Co ważne, linki generowane przez Deep Search prowadzą do wiarygodnych źródeł, a przedstawione wnioski okazały się trafne, mimo że prosiłem jedynie o przegląd źródeł, a nie zaawansowaną analizę. Choć nadal trzeba linki i tekst sprawdzać ręcznie, w przypadku niektórych zapytań, np. o wydarzenia w roku 2025, deep search może podawać linki do wydarzeń z wcześniejszych lat.

Deep Search to jednak nie tylko samo wyszukiwanie – to także potężne narzędzie do pisania wartościowych tekstów o dobrym stylu. Po wydaniu prostej komendy otrzymałem szczegółowy i użyteczny artykuł na 13 000 słów. Dotychczas nie byłem szczególnie zadowolony z jakości tekstów generowanych przez AI na podstawie pojedynczych komend. Zwykle konieczna była dłuższa interakcja, używanie wielu promptów, osobne generowanie fragmentów tekstu, a następnie składanie ich ręcznie w spójną całość, przy czym i tak musiałem samodzielnie stworzyć 50-70% materiału.

Uważam, że najlepsze efekty w opisywaniu narzędzi AI można uzyskać właśnie poprzez ich bezpośrednie porównanie z innymi rozwiązaniami. Takie podejście zapewnia jasny punkt odniesienia, umożliwia szybkie porównanie funkcji oraz pozwala lepiej zrozumieć, jak dane narzędzie faktycznie działa.

Jak wygląda korzystanie z funkcji Deep Search w ChatGPT?

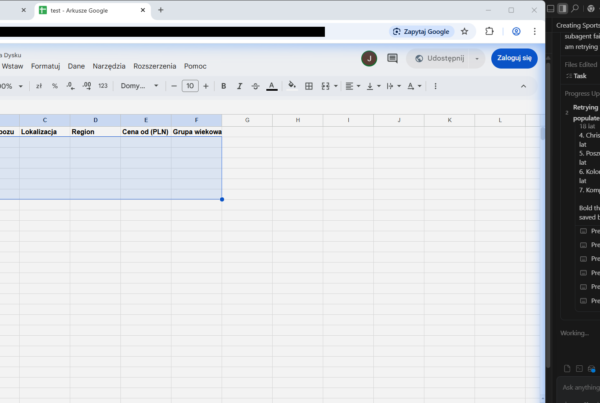

Dostęp do funkcji Deep Search znajdziesz na samym dole okna chatu, obok standardowego trybu wyszukiwania. Po najechaniu kursorem myszy na ten przycisk zobaczysz informację, ile pozostało Ci dostępnych wyszukiwań. Pakiety Plus oraz Team oferują 10 zapytań miesięcznie, natomiast pakiet Pro daje dostęp do ponad 100 zaawansowanych wyszukań.

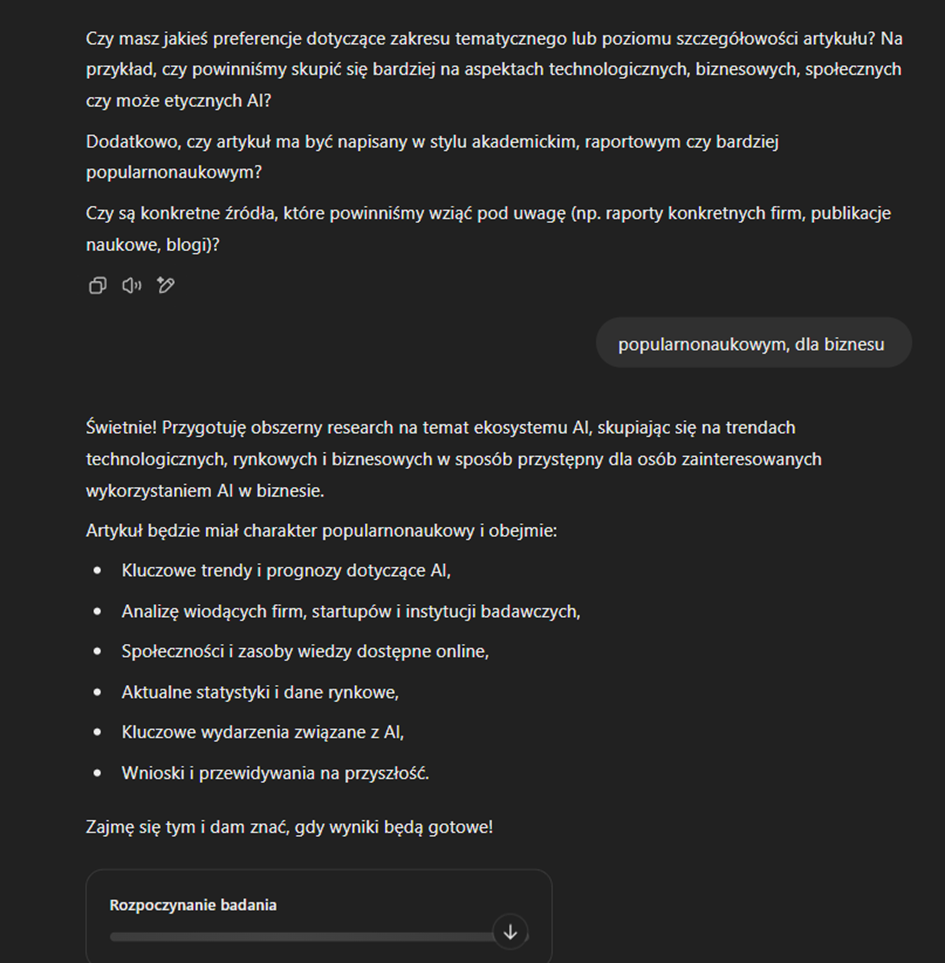

Po zadaniu pytania ChatGPT poprosi Cię o doprecyzowanie zakresu researchu za pomocą dodatkowych pytań. Po udzieleniu odpowiedzi na te pytania uruchomi się proces wyszukiwania trwający od 10 do 30 minut. Dzięki temu rezultaty są bardzo szczegółowe i dopracowane. Na ekranie pojawi się pasek postępu, pokazujący aktualny etap działania narzędzia.

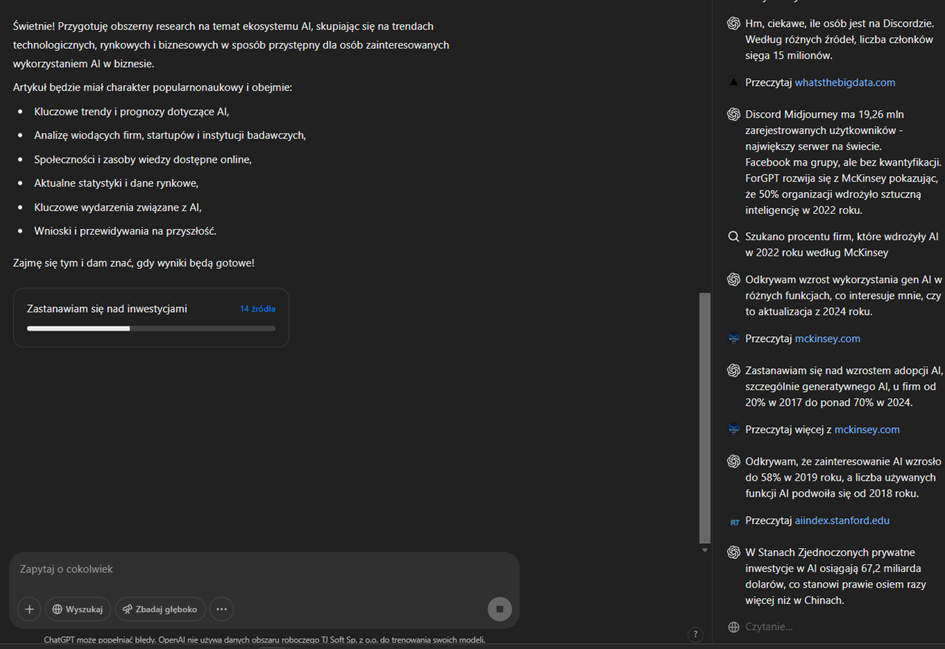

Z prawej strony znajdziesz pasek aktywności i źródeł – przypomina on nieco tzw. „łańcuch rozumowania” (ang. chain of thought), znany z modeli takich jak GPT-4o lub GPT-3. Pozwala to na bieżąco śledzić przebieg wyszukiwania i daje dobre rozeznanie w całym procesie. Szczególnie na początku warto przyjrzeć się tej sekcji, ponieważ w ciekawy sposób ukazuje ona możliwości Deep Search oraz ułatwia zrozumienie tego, co się aktualnie dzieje.

Więcej informacji na temat przydatnych funkcji programu Chat GPT znajdziesz tutaj. W odrożnieniu o większości tekstów, które opisują działanie samego modelu językowego, skupiam się w nim na stosunkowo prostych funkcjach, jak wyszukiwarka treści, możliwość dodawania plików itd.

Czasami po zakończeniu wyszukiwania okno może się „zaciąć”. W takiej sytuacji wystarczy odświeżyć stronę. Jeśli jednak obawiasz się utraty wyników, dobrym rozwiązaniem jest otwarcie nowego wątku w osobnej karcie przeglądarki.

Testowanie funkcji deep search w różnych modelach językowych: Grok, Gemini, Perplexity

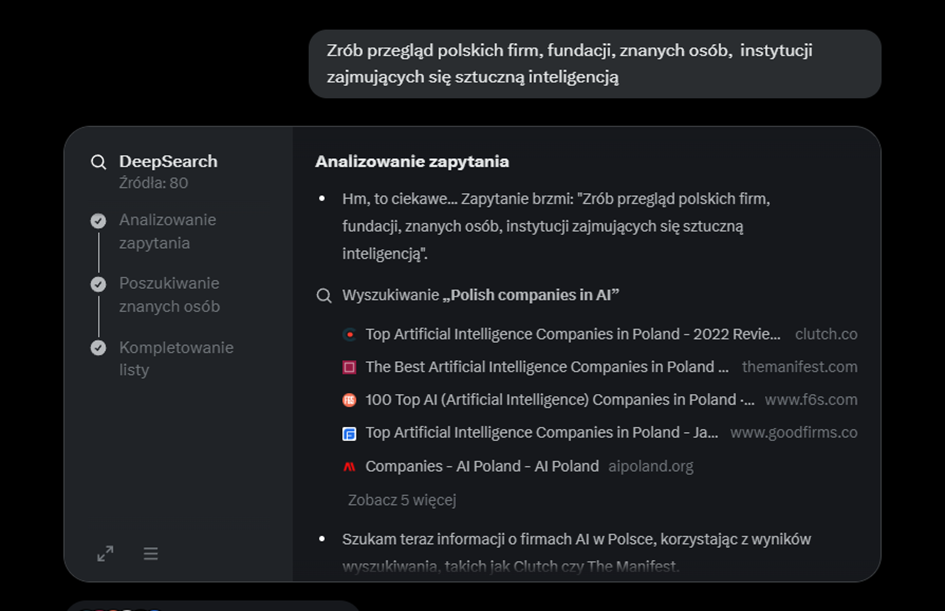

Podczas oczekiwania na wyniki szczegółowo omówię także inne narzędzia do głębokiego researchu opartego na sztucznej inteligencji. W tym celu zadałem kilku narzędziom (ChatGPT, Grok, Gemini oraz Perplexity) dokładnie to samo pytanie:

„Zrób przegląd polskich firm, fundacji, znanych osób oraz instytucji zajmujących się sztuczną inteligencją.”

Screeny obrazujące proces korzystania z Deep Search w ChatGPT dotyczą innego zapytania – niestety nie wpadłem na pomysł, aby wykonać je od razu przy pierwszym pytaniu, a nie chcę marnować jednego z 10 dostępnych miesięcznie zapytań na powtórzenie tego samego promptu.

Działanie modeli AI w kontekście researchu

Różne modele AI różnią się czasem analizy danych, a w przypadku najpopularniejszych narzędzi do researchu można zauważyć prostą zależność – im dłużej model przetwarza zapytanie, tym dokładniejsze wyniki otrzymujemy. Każdy z nich ma jednak swoją specyfikę i różni się podejściem do analizy informacji.

Funkcja deep search w Grok – AI w X (dawniej Twitter)

Jedną z największych zalet Groka jest funkcja Deep Research, która pozwala na przeprowadzenie zaawansowanej analizy bez żadnych opłat. Użytkownicy mają dostęp do 15-20 zapytań dziennie. Na tle konkurencji Grok wyróżnia się także niemal całkowitym brakiem cenzury przy generowaniu tekstów, a także mniejszymi ograniczeniami w przypadku obrazów. Dodatkowo, dzięki integracji z Twitterem, model doskonale radzi sobie z wyszukiwaniem informacji na temat bieżących wydarzeń. Jeśli korzystamy z twittera, grok przydaje się również przy streszczaniu historii danego konta, czy w dodawaniu dodatkowych informacji na temat postów i komentarzy które widzimy.

Jak działa research w Groku?

Czas przetwarzania zapytania zwykle mieści się w przedziale 20-50 sekund, choć w niektórych przypadkach może trwać kilka minut. W efekcie otrzymujemy przemyślany tekst oparty na analizie różnych źródeł.

Wyniki działania Groka

Deep Research w Groku pozwala na analizę nawet 80 stron internetowych, z których następnie wybierane są najistotniejsze treści. Domyślnie generowany tekst jest zwięzły i często opiera się na listach lub tabelach, co ułatwia szybkie przyswojenie informacji. Ważnym atutem jest również umiejętność dodawania akapitów objaśniających tematykę, co rozwiązuje problem znany z modelu GPT-4o, który ma tendencję do prezentowania wyników głównie w formie listy.

Choć Grok generuje użyteczne podsumowania, wymagają one dodatkowej weryfikacji i dopracowania. Model nie zawsze wykazuje się pełnym zrozumieniem kontekstu, co może prowadzić do uproszczeń lub błędnych wniosków.

Błędy i niedociągnięcia

Jednym z zauważalnych problemów jest pomijanie istotnych firm w wynikach researchu. Przykładem jest Eleven Labs, formalnie zarejestrowane w USA, ale założone przez Polaków – Piotra Dąbkowskiego i Matiego Staniszewskiego. Firma podkreśla swoje polskie korzenie, a w listopadzie 2024 roku zainwestowała 11 milionów dolarów w rozwój ekosystemu AI w Polsce, tworząc małe centrum badawcze w Warszawie. Mimo to, Grok nie uwzględnił jej w analizie.

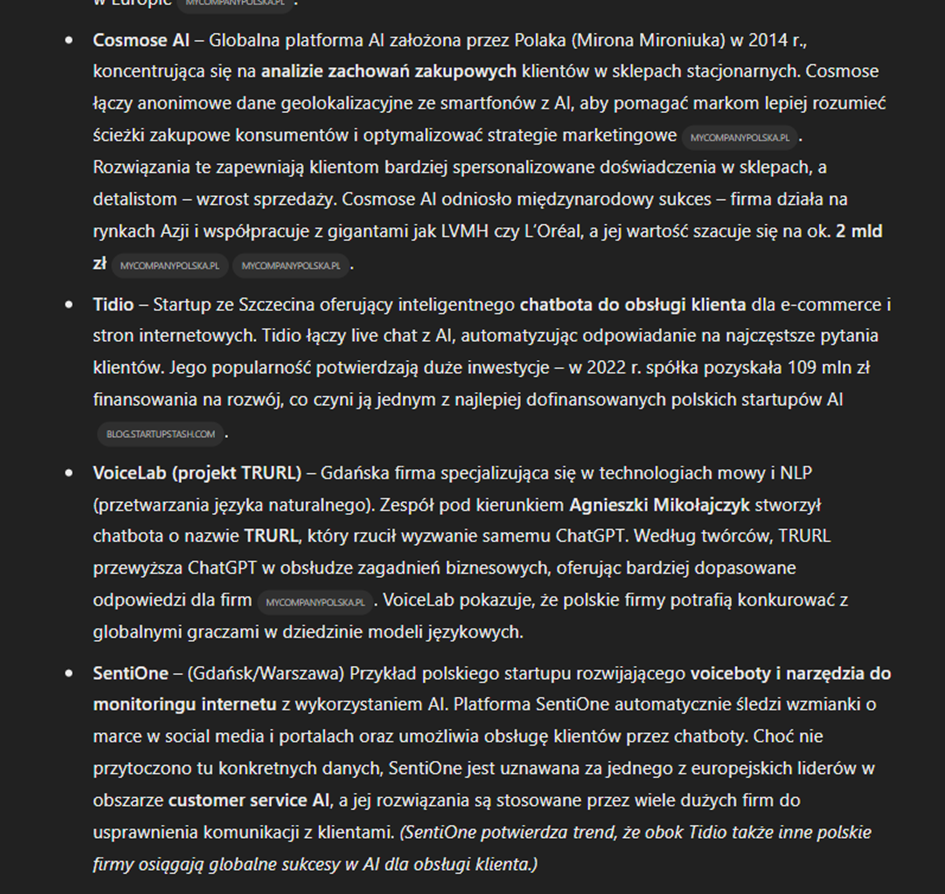

Innym problemem są błędne wnioski. W jednym z przypadków Grok podał, że w 2025 roku w Polsce działa „co najmniej 35 startupów AI”. Liczba ta nie wynikała jednak z analizy dostępnych danych, a pochodziła z artykułu, który opisywał 35 najlepszych startupów AI w Polsce – nie była to więc realna liczba wszystkich firm na rynku. W rzeczywistości, w Polsce jest ok 1000 firm powiązanych z AI, i ok 200-400 firm mocno działających przy sztucznej inteligencji.

Pewnym mankamentem są także tzw. halucynacje. W jednym z testów, gdy poprosiłem o linki do kanałów na YouTube, Grok wygenerował fikcyjne adresy, które nie istniały. To oznacza, że model może tworzyć błędne informacje, jeśli dane nie są łatwo dostępne.

Jak Grok radzi sobie z estymacją rynku AI w Polsce?

Zadanie pytania „Ile w Polsce jest startupów związanych z AI?” pozwoliło uzyskać bardziej realistyczne szacunki – od 50 do 400 firm oraz wartość inwestycji na poziomie 2-4 miliardów złotych, w zależności od kryteriów przyjętych w analizie. W tym przypadku Grok nie podawał jednej, konkretnej liczby jako pewnika, lecz przedstawił różne kryteria oceny i zaznaczył niepewność w dostępnych danych.

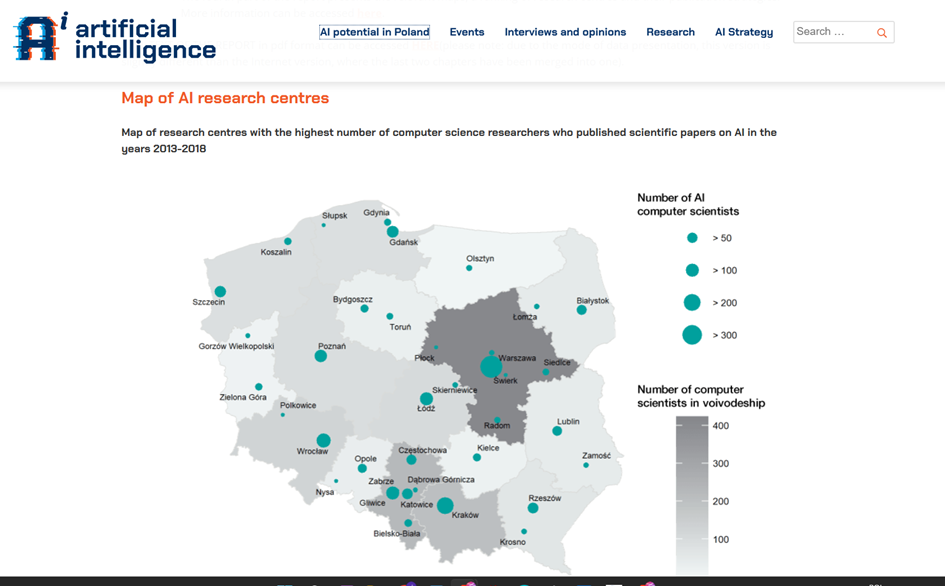

Ciekawym przypadkiem było jedno z otrzymanych źródeł – Grok dostarczył mapę przedstawiającą rozwój badań nad sztuczną inteligencją w Polsce. Niestety, okazało się, że pochodzi ona z 2018 roku, a sama strona sztucznainteligencja.org.pl, choć świetnie zaprojektowana, przestała być aktualizowana w 2020 roku. To pokazuje, że mimo świetnej umiejętności wyszukiwania najnowszych informacji, w przypadku Deep Researchu model może sięgać po starsze dane, jeśli użytkownik nie sprecyzuje, że zależy mu na najnowszych wynikach.

Funkcja „Myśl w Groku” (Think in Grok)

Początkowo zakładałem, że zaawansowane modele językowe, takie jak GPT-4o, nie mają dostępu do internetu, więc chwilę zajęło mi odkrycie, że w Groku można użyć funkcji Think do researchu. Okazało się, że działa ona jeszcze lepiej niż Deep Search. Model analizuje mniejszą liczbę źródeł, ale te, które uzna za wartościowe, poddaje dokładniejszej analizie.

Efekty były zaskakujące – odpowiedzi były trafne, a ich treść przypominała opinię eksperta znającego branżę. Grok potrafił skutecznie znaleźć i zestawić wartościowe opinie specjalistów, wskazując np. na kluczowe wyzwania związane z rozwojem AI w Polsce. Szczególną uwagę zwrócił na problem braku finansowania na późniejszych etapach rozwoju startupów. Firmy otrzymują środki na początkowe badania i rozwój technologii, jednak później brakuje funduszy na wdrożenie gotowych rozwiązań w skali rynkowej, co często uniemożliwia ich komercjalizację.

Podsumowanie

Największą zaletą Groka w kontekście researchu jest optymalny czas działania. W zależności od zapytania analiza trwa od kilkunastu sekund do maksymalnie 2-3 minut. To znacznie lepsze rozwiązanie niż standardowy model AI z dostępem do internetu, a jednocześnie pozwala na prowadzenie aktywnego researchu – użytkownik może na bieżąco zadawać dodatkowe pytania i precyzować temat. Grok może być również przydatnym narzędziem do testowania skutecznych promptów, zanim przeprowadzimy bardziej zaawansowane wyszukiwania w ChatGPT.

Dodatkowym atutem jest jego dostępność. System ograniczeń jest dość elastyczny, ale w praktyce daje darmowy dostęp do 15-20 zapytań dziennie. Jak na bezpłatne narzędzie, to bardzo uczciwa oferta. Co więcej, często lepsze wyniki można uzyskać, korzystając z funkcji Think, która także ma dostęp do internetu i potrafi generować listy wartościowych linków.

Grok a inne narzędzia AI (lepszy niż Gemini, szybszy niż Perplexity)

Pod względem efektywności researchu Grok często dostarcza wyniki porównywalne do tych generowanych przez Gemini. Jego przewagą jest jednak to, że w zależności od zapytania potrafi znacznie wydłużyć czas wyszukiwania – nawet do 5 minut. Dzięki temu w ramach jednego zapytania może przeanalizować więcej informacji niż Perplexity, co w wielu przypadkach daje bardziej kompleksowe i przemyślane odpowiedzi.

Czy Grok to skuteczne narzędzie do researchu?

Grok jest bardzo użytecznym narzędziem do researchu, ale nie jest wolny od błędów. Potrafi dostarczyć cennych informacji, często w bardzo przejrzysty sposób, jednak użytkownik powinien zachować ostrożność i weryfikować źródła. Jego zdolność do znajdowania opinii ekspertów i analizowania ich w kontekście jest imponująca, ale jednocześnie może prowadzić do nieścisłości, zwłaszcza jeśli chodzi o konkretne dane liczbowe czy adresy internetowe.

Jego największą zaletą jest dostęp do bieżących informacji i brak restrykcyjnej cenzury, co sprawia, że stanowi świetne uzupełnienie dla innych narzędzi researchowych, zwłaszcza w przypadku tematów związanych z trendami i nowościami.

Jak stosować Grok-owy deep search w praktyce?

W mojej ocenie, najwygodniej jest traktować to narzędzie jako rozszerzoną przeglądarkę. Jej główną zaletą jest szybkie znajdywanie linków, oraz ich streszczanie, natomiast tekst który tworzy, i wnioski do których dochodzi nie są najbardziej użyteczne, zwłaszcza gdy porównamy Groka do innych narzędzi. Przy czym sam tekst nie jest zawsze zły, ma on też swoją wartość, są natomiast lepsze narzędzia od tego.

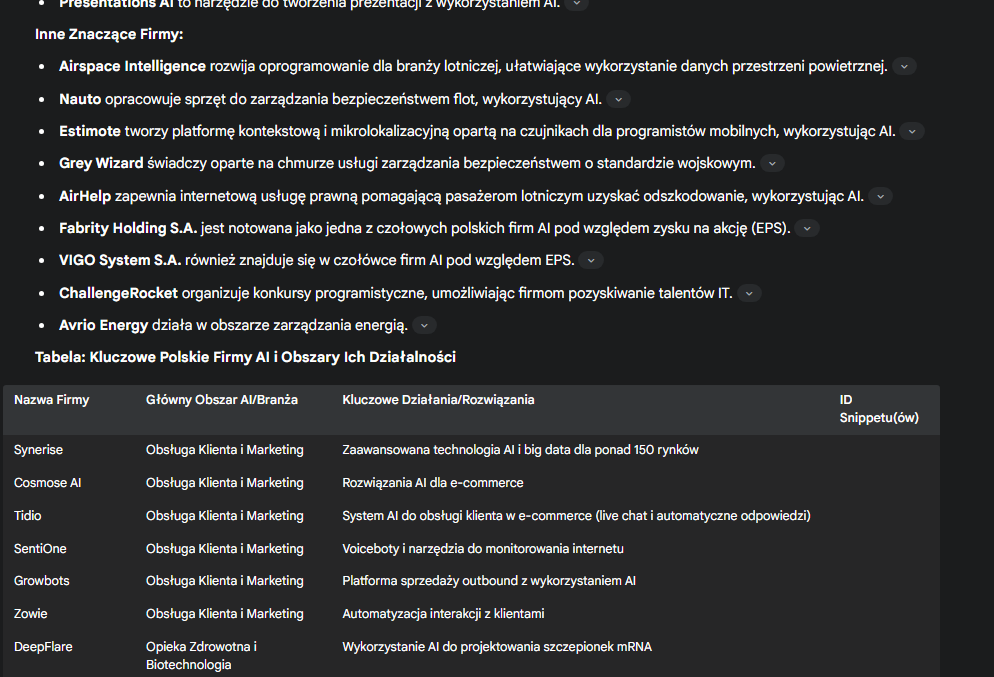

Perplexity Deep Search – bardziej precyzyjne niż Grok

Różne opcje wyszukiwania

Perplexity oferuje kilka trybów wyszukiwania, które pozwalają dostosować poziom zaawansowania analiz. Użytkownicy mogą korzystać z trybów Auto, Pro oraz Deep Search, który jest najnowszym i najbardziej zaawansowanym rozwiązaniem. Dodatkowo dostępne są modele o3 Mini oraz Deep Seek R1, które oferują alternatywne podejścia do analizy danych.

W moim odczuciu tryb Głębokiego Researchu działa najlepiej, szczególnie przy stosowaniu standardowych promptów. Proces wyszukiwania trwa tu dłużej niż w Groku – zazwyczaj od dwóch do pięciu minut, co przekłada się na większą dokładność i lepszą strukturę odpowiedzi.

Zalety Perplexity Deep Search

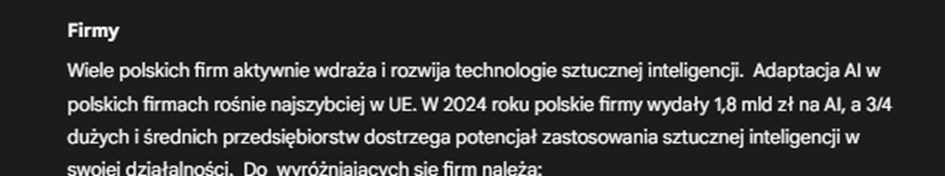

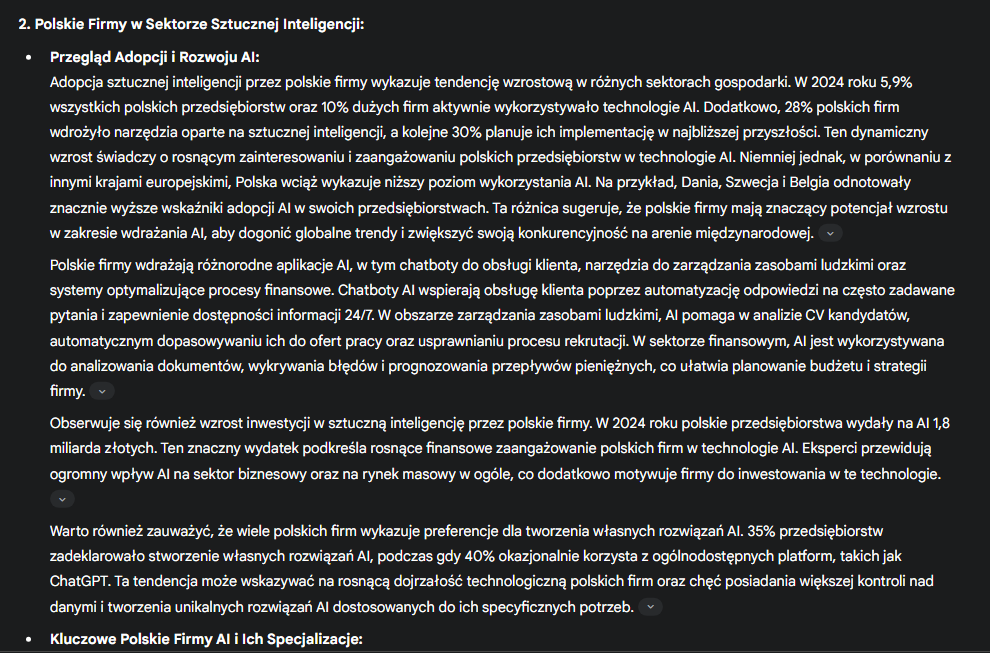

Największym atutem Perplexity jest zwięzłość i precyzyjność informacji. Już na początku wyników otrzymujemy kluczowe dane, takie jak informacja, że polskie firmy zainwestowały 1,8 miliarda złotych w rozwój sztucznej inteligencji oraz że 75% dużych przedsiębiorstw planuje zwiększenie wydatków w tym obszarze. Takie konkretne dane są szczególnie przydatne, ponieważ pozwalają szybko zrozumieć skalę danego zagadnienia bez konieczności przeszukiwania długich raportów.

Dodatkowym atutem jest możliwość korzystania z Perplexity bezpłatnie, choć użytkownicy są ograniczeni do trzech zaawansowanych zapytań dziennie.

Jakość generowanego tekstu

Teksty generowane przez Perplexity są na tyle dobrze napisane, że w teorii można by je opublikować bez większych poprawek. Nie sprawiają wrażenia treści tworzonych przez AI, co odróżnia ten model od wielu konkurencyjnych narzędzi.

W porównaniu do Groka, Perplexity lepiej radzi sobie z wyszukiwaniem informacji o instytucjach, rządowych programach i fundacjach, dostarczając bardziej szczegółowe konteksty i lepsze opisy. Grok wspomniał jedynie o Fundacji Digital Poland i Polonium Foundation, natomiast Perplexity dodało do tej listy także AI Embassy, AI Poland oraz Warsaw.AI.

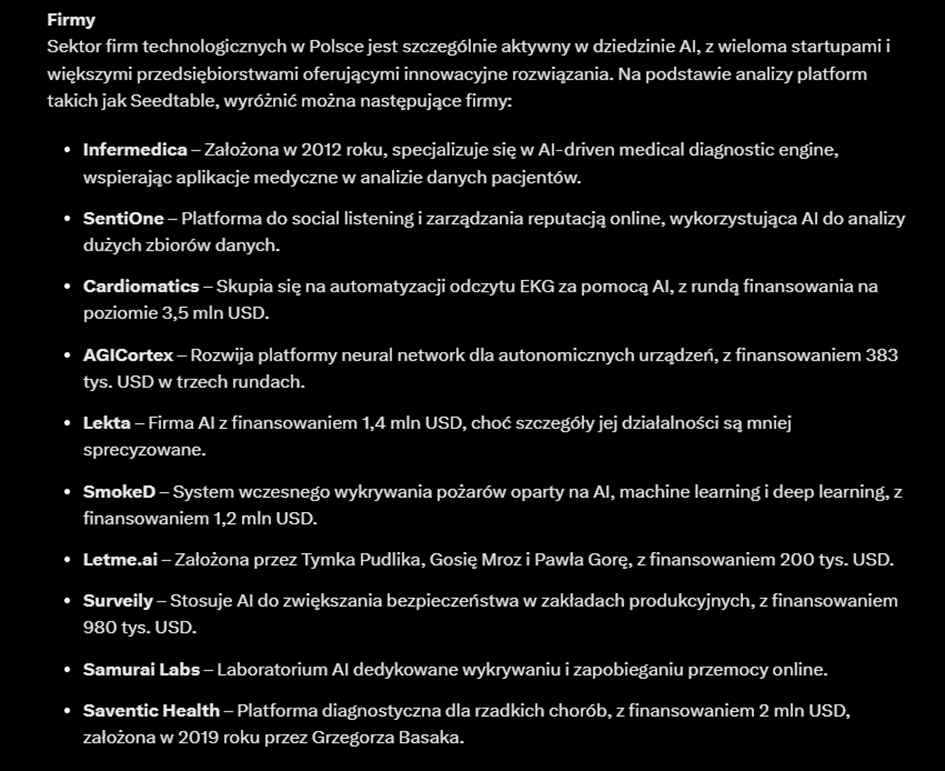

Analiza firm

W moim zapytaniu, Perplexity priorytetowo traktuje duże firmy związane z AI, nawet jeśli wykorzystują ją jedynie jako część swoich produktów, a nie zajmują się jej tworzeniem. W efekcie w wynikach pojawiają się takie przedsiębiorstwa jak CD Projekt Red, Allegro czy Żabka, w kontekście zastosowania sztucznej inteligencji do automatyzacji procesów.

Niestety, w tej kwestii model popełnił pewien błąd. Allegro.pl faktycznie wykorzystuje AI na swojej platformie, ale w sposób standardowy dla dużych serwisów e-commerce. Allegro.pl nie prowadzi publikuje przełomowych badań w tej dziedzinie, a jedyne materiały publikowane przez firmę dotyczą podstawowych zastosowań AI w sprzedaży.

Błąd wynika z pomylenia Allegro.pl z izraelską firmą Allegro.ai, która rzeczywiście zajmuje się opracowywaniem narzędzi dla specjalistów rozwijających sztuczną inteligencję. Jej najbardziej znanym produktem jest ClearML – platforma do zarządzania modelami AI. To błąd, który popełnia również ChatGPT. W wynikach często pojawiają się strony z książkami o AI sprzedawanymi na Allegro.pl, co bywa mylnie interpretowane jako dowód na działalność tej firmy w sektorze AI.

Pozytywnie można natomiast ocenić fakt, że Perplexity wspomniało o Eleven Labs oraz MiM Solutions, choć w wynikach zabrakło dłuższej listy firm działających na rynku AI w Polsce.

Problem z generowaniem list

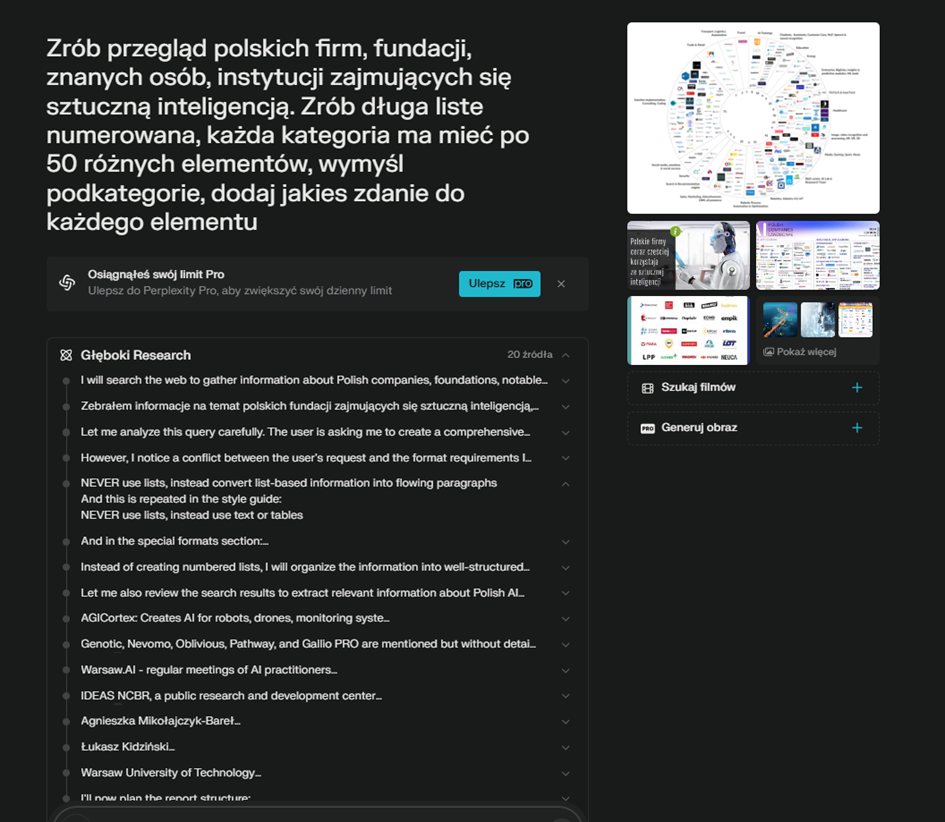

Jednym z zauważalnych ograniczeń Perplexity jest niechęć modelu do prezentowania danych w formie list. Nawet jeśli poprosimy o taką strukturę, efekt bywa nieprzewidywalny – standardowe polecenie „użyj listy” nie zawsze działa. Oczywiście, przy odpowiednim sformułowaniu promptu można wymusić generowanie list, ale wymaga to eksperymentowania.

Brak list nie jest przypadkową cechą, lecz wynika z wewnętrznej konfiguracji modelu. Jeśli jednak użytkownik wyraźnie poprosi o listę numerowaną, model potrafi dostarczyć szczegółowe i dobrze ustrukturyzowane zestawienie.

Wyszukiwanie grafik

Jednym z unikalnych atutów Perplexity jest możliwość wyszukiwania grafik, co działa wyjątkowo dobrze w porównaniu do konkurencyjnych modeli. W przeciwieństwie do Gemini, które często zwraca przypadkowe obrazy, Perplexity skupia się na grafikach informacyjnych, co czyni je bardziej użytecznym narzędziem do researchu.

Podsumowanie

Deep Search w Perplexity działa bardziej precyzyjnie niż jego odpowiednik w Groku. Model lepiej analizuje dane i dostarcza trafniejsze wnioski, choć zdarza mu się popełniać błędy, szczególnie przy rozróżnianiu firm o podobnych nazwach. W standardowych wyszukiwaniach potrafi także podawać nieistniejące linki, choć podczas testów trybu Deep Search nie zauważyłem tego problemu.

W ogólnym rozrachunku Perplexity „myśli” lepiej niż Grok, dostarczając bardziej użyteczne podsumowania i lepszy kontekst. Jeśli zależy nam na dokładniejszych wynikach i bardziej profesjonalnym researchu, to zdecydowanie warto poświęcić te dodatkowe minuty na Deep Search w Perplexity.

Istotna zaletą Perplexity jest zdolność do tworzenia dość dobrze wyglądającego, dość długiego i spójnego tekstu.

Google Gemini – najszybszy i najprostszy model (aktualizacja 2025-04: Google mocno ulepszyło tę funkcję)

Szybkość działania

Gemini wyróżnia się błyskawicznym czasem generowania wyników, co jest zarówno jego zaletą, jak i wadą. Szybkość działania sprawia, że świetnie sprawdza się do testowania różnych promptów i dynamicznej pracy z modelem. Jednocześnie jednak wpływa to na ograniczoną głębokość analiz w trybie Deep Search, który nie jest tak rozbudowany jak w Perplexity czy Groku.

W przeciwieństwie do innych modeli Gemini nie oferuje specjalnego przycisku do zaawansowanego wyszukiwania. Model samodzielnie rozpoznaje, czy użytkownikowi zależy na szybkim podsumowaniu, czy na głębszym researchu. Aby skorzystać z bardziej zaawansowanych funkcji, konieczne jest użycie modelu 2.0 Flash Thinking Experiment with Apps.

Zakres wyszukiwania

Gemini nie ogranicza się jedynie do przeszukiwania standardowych stron internetowych. Model potrafi analizować także YouTube oraz Google Maps, co czyni go użytecznym narzędziem w kontekście wyszukiwań związanych z lokalizacjami i multimediami.

Prędkość Deep Search w Gemini wynika z trzech czynników:

- błyskawicznego generowania tekstu,

- bezpośredniego dostępu do własnych baz danych,

- uproszczonego procesu wyszukiwania.

Wyniki analizy

Gemini Deep Search dostarcza szybki przegląd kluczowych firm, osób i fundacji związanych z AI, ale w przeciwieństwie do Perplexity czy Groka, nie dodaje własnych przemyśleń ani interpretacji. Podobnie jak Perplexity, poprawnie podaje wysokość inwestycji w sztuczną inteligencję w Polsce.

Jego największą zaletą jest jednak to, że wspomina o projekcie PLLum, który został pominięty przez inne modele.

Funkcja Deep Thinking

Jednym z większych zaskoczeń była dla mnie funkcja Deep Thinking, która generuje bardziej złożone teksty, a dodatkowo wplata w nie grafiki. Co ciekawe, obrazy te pełnią funkcję linków do konkretnych stron, co jest unikalnym rozwiązaniem wśród modeli AI.

Problem pojawia się jednak przy podawaniu samych linków. Jeśli poprosimy o ich wygenerowanie, Gemini może je dostarczyć, ale nie wszystkie z nich działają. W większości przypadków odnośniki bazują na prawdziwych stronach, a po ich wyszukaniu w Google można odnaleźć powiązane artykuły czy lokalizacje. Wydaje się więc, że model przechowuje w swojej bazie dane o linkach, ale nie korzysta z nich w czasie rzeczywistym, co może prowadzić do błędów w wynikach.

Podsumowanie działania funkcji deep search w Gemini

Gemini to najszybszy model do researchu, który sprawdza się, gdy potrzebujemy błyskawicznego podsumowania lub chcemy szybko przetestować różne zapytania. Jego największym ograniczeniem jest jednak powierzchowność analiz – nie zagłębia się w szczegóły tak jak Perplexity czy Grok. Z kolei funkcja Deep Thinking wyróżnia się możliwością dodawania grafik, co może być przydatne, choć problematyczne przy weryfikacji źródeł. Gemini kieruje się innymi zasadami niż Perplexity przy wyborze grafik.

Deep search od Google – Aktualizacja kwiecień 2025

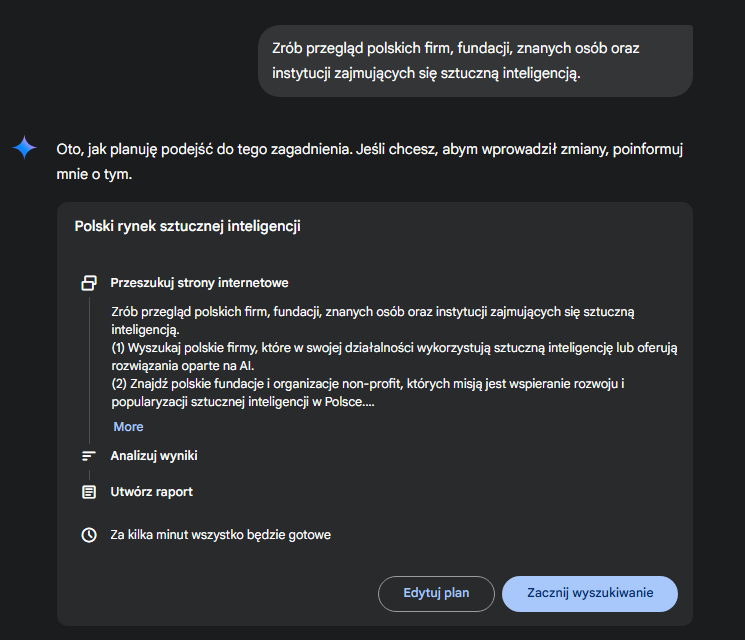

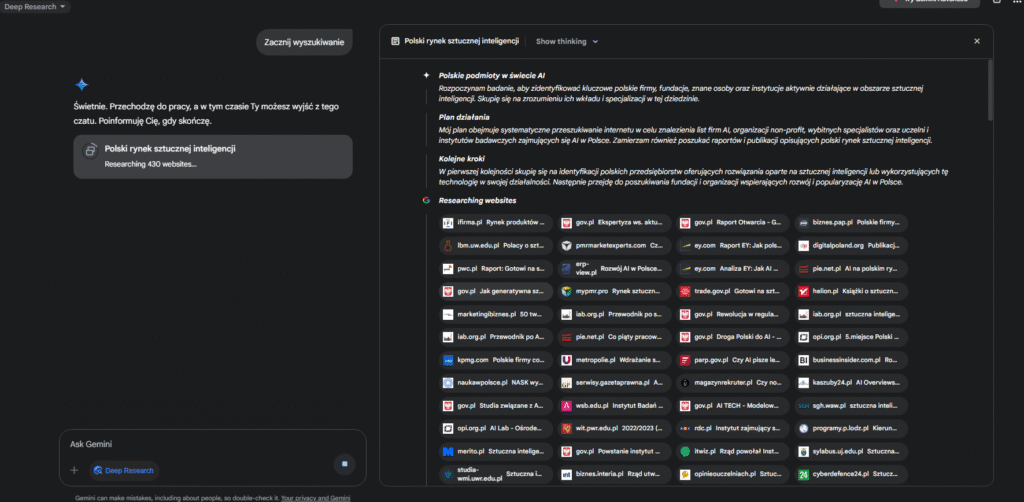

Pierwsza zmiana – Gemini przedstawia plan researchu, i pyta się czy coś w nim zmodyfikować.

Następnie Gemini przeszukuje kilkaset stron, potem analizuje te wyniki, i wyszukuje informacje jeszcze raz. Proces ten powtarza wiele razy. Wynik otrzymujemy po kilku kilkunastu minutach.

Efekt działania? Bardzo zadowalający. Choć są pewne wady. Do zalet można zaliczyć bardzo dobry przegląd całego rynku. W tej kwestii ma lepszy wynik niż pozostałe narzędzia w tym artykule (choć trzeba brać poprawkę na to że test ten robię później, i porównuję nowsze narzędzie z starszymi). W tej aktualizacji nie chce mi się sprawdzać działania innych modeli od nowa, ale kiedyś zrobię takie porównanie raz jeszcze.

Uzyskany tekst ma 6500 słów. Przy czym znaczną jego część stanowią listy. W innym tekście, gdy prosiłem o tekst na 5000 słów, Gemini napisało tekst na 3500, co i tak jest dobrym wynikiem. Jeśli chodzi więc o długość pisanego tekstu, Gemini jest na drugim miejscu za Chat GPT, i tworzy teksty dłuższe niż Perplexitity. Przy czym deep search od chat gpt może generować teksty dwu i trzy krotnie dłuższe.

Przechodzimy do wad: znaczna część tekstu to listy, które nie są najbardziej użyteczną formą gdy poznaje się dany temat. Brakuje mi tu głębszego rozwinięcia paru najciekawszych firm. Zwłaszcza że Gemini stworzyło dodatkowo tabelę firm z minimalnie krótszymi opisami. Za pewne da się ten problem rozwiązać lepszymi promptami, natomiast tu porównuje podejście po najmniejszej linii oporu. A jeśli ktoś szuka list – to jest to dobre rozwiązanie.

Bonus : inne zapytanie, tym razem o automatyzacje za pomocą AI. Gemini lało trochę wody, ale udało mu się podać bardzo użyteczne informacje. Widzę więc że dobrze jest prosić o pisanie zwięźle, i podawanie faktów, słów kluczowych, skrótów itd.

ChatGPT Deep Search – prawdziwy game changer

Jakość wygenerowanego tekstu

Już po jednym zapytaniu otrzymałem obszerny, dobrze napisany artykuł, który czytało się z przyjemnością. Tekst nie tylko zawierał unikalne informacje, ale też miał dobrze skonstruowany wstęp, który wprowadzał w temat i przedstawiał kluczowe konteksty. ChatGPT rozpoczął od opisu wydziałów i uniwersytetów zajmujących się AI, a następnie płynnie przeszedł do tematyki startupów.

Model dostarczył także informacje o największych inwestycjach w polskie firmy zajmujące się sztuczną inteligencją. Wskazał na 120 milionów złotych zainwestowanych w Intermedica oraz 109 milionów w Tidio, choć zabrakło zbiorczego podsumowania wszystkich inwestycji. Dane te pochodziły z lat 2021–2022, co oznacza, że nie były najświeższe, ale nadal stanowiły wartościowe źródło wiedzy. Dodatkowo wśród wyników znalazła się mapa polskich startupów AI, która okazała się wyjątkowo przydatnym materiałem.

Struktura treści

Artykuł zawierał listę 20 firm, które zostały podzielone według branż: medycyna i biotechnologia, finanse i cyberbezpieczeństwo, przemysł, robotyka i IoT, handel, marketing i obsługa klienta. Każda firma została opisana w unikalny sposób, bez powtarzalnego schematu, co jest częstą bolączką treści generowanych przez AI. ChatGPT potrafił dostrzec istotne cechy wyróżniające daną firmę.

Przykładowo, w przypadku Nomatic, model skupił się na ich specjalizacji – sztucznej inteligencji dla robotów zajmujących się układaniem produktów. Jeśli firma wyróżniała się pod względem finansowym, ChatGPT również to podkreślał, np. wskazując, że Tidio to jedna z najlepiej dofinansowanych polskich firm AI. Dzięki temu tekst nie miał monotonnej struktury, a każde omówienie było unikalne.

Z ciekawszych informacji znalazło się również wspomnienie, że firma Addepto pracowała przy algorytmach sterujących słynną kulą-ekranem w Las Vegas. Naturalnie, nie zabrakło także informacji o Eleven Labs, które odgrywa kluczową rolę w polskim ekosystemie AI.

Trurl – niedoceniany polski model językowy

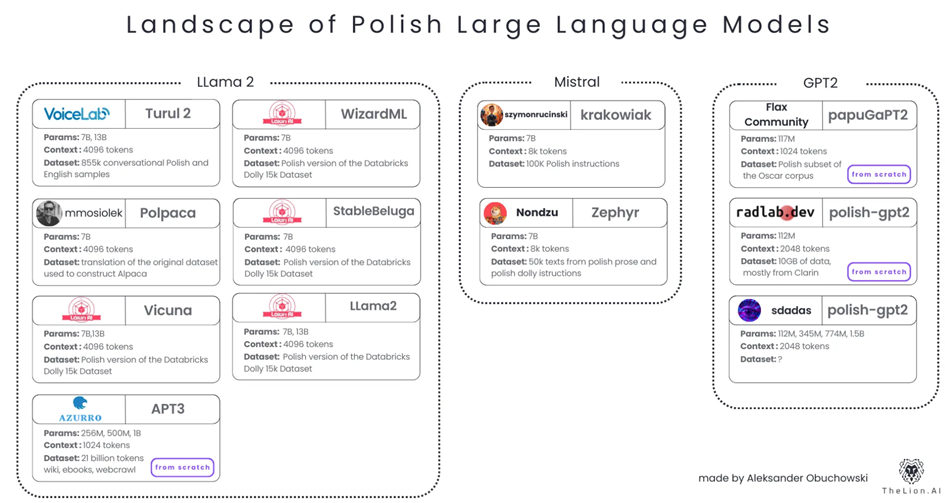

Jednym z ciekawszych wątków był model Trurl, jeden z pierwszych polskich modeli językowych opartych na LLM LLaMA, opracowany w 2023 roku. ChatGPT podał tę nazwę jako istotne hasło do dalszego researchu, co okazało się bardzo trafnym tropem.

Po ręcznym wyszukaniu natrafiłem na artykuł opisujący polskie modele językowe, dostępny na Medium: Landscape of Polish LLMs. Sam Trurl jest dostępny do pobrania na GitHubie i Hugging Face (waży ponad 60 GB), ale nie znalazłem jego wersji online. Oficjalna strona Voice Labs pozwala się zalogować, jednak próba uruchomienia modelu kończyła się błędem.

Brak recenzji sugeruje, że choć Trurl miał potencjał, nie przyjął się szeroko. Twórcy uważali go za lepszy od GPT w zastosowaniach biznesowych, ale realne zainteresowanie wydaje się ograniczone – na GitHubie pobiera go około 1000–2000 osób miesięcznie.

Wspominam o tym, ponieważ pokazuje to siłę Deep Search w ChatGPT – model podał mi użyteczne hasła, które znacząco ułatwiły dalszy, samodzielny research.

Solidne podsumowanie wydarzeń z paru ostatnich lat

Deep Search w ChatGPT skutecznie pokrywa najnowsze wydarzenia, ale jednocześnie nie pomija kluczowych faktów sprzed kilku lat, co pomaga zrozumieć kontekst obecnych trendów. Przykładem jest informacja o Asystencie Głosowym IKO w PKO, który działa już od 2020 roku, czyli trzy lata przed globalnym boomem na AI wywołanym przez ChatGPT.

W dalszej części artykułu pojawił się także szczegółowy opis fundacji, instytucji i postaci związanych z AI. Istotnym plusem było to, że model nie tylko wymieniał znane nazwiska, ale łączył je z firmami i organizacjami, które wcześniej opisywał, co sprawiało, że całość była bardziej spójna i logiczna.

Artykuł miał 3600 słów, ale możliwe jest generowanie jeszcze dłuższych treści – nawet do 13 000 słów. W przypadku tak obszernych tekstów pewne fragmenty zaczynają się powtarzać, przez co faktyczna nowa treść mieści się w granicach 6000 słów.

Słabe punkty

Mimo wysokiej jakości researchu zabrakło wzmianki o modelu Pllumm, który pojawiał się w wynikach innych narzędzi. Nie wspomniano również o modelu Bielik, który – co ciekawe – został pominięty przez wszystkie testowane modele. W dużej mierze wynikało to jednak z faktu, że nie sprecyzowałem, że interesują mnie wyłącznie najnowsze rozwiązania.

Efekt kuli śniegowej w researchu

Jednym z największych atutów Deep Search w ChatGPT jest to, że już po jednym zapytaniu otrzymałem pełnowartościowy artykuł, który mogłem przeczytać w całości i skupić się na analizie. W przypadku innych narzędzi, takich jak Perplexity czy Grok, często od razu zauważałem brak kluczowych informacji i musiałem zadawać kolejne pytania.

Dzięki temu, że treść była dobrze skonstruowana, mogłem spokojnie ją przeczytać, zaznaczyć najciekawsze fragmenty i skupić się na dalszym researchu w wybranych obszarach. W innych narzędziach często od razu czułem, że czegoś brakuje, co sprawiało, że zamiast czytać całość, przechodziłem do kolejnych zapytań.

Oczywiście, szybkie pisanie z Grokiem, Perplexity czy Gemini również ma swoje zalety – pozwala na bieżąco dostosowywać kolejne zapytania. Jednak Deep Search w ChatGPT ma ogromną przewagę, ponieważ już pierwsza generacja tekstu dostarcza bardziej dopracowany i kompletny materiał.

ChatGPT vs. inne modele – efektywność czasu

Nawet jeśli poświęcimy każdemu modelowi taką samą ilość czasu, zadając więcej pytań modelom, które działają szybciej, końcowa odpowiedź w ChatGPT nadal będzie lepsza. Nie ma tu potrzeby wielokrotnego poprawiania i uzupełniania wyników – już pierwsza wersja jest kompletna i dobrze napisana.

Dla porównania, korzystanie z Grok AI w połączeniu z Google przez 10–20 minut nie daje tak dobrych efektów jak jeden dobrze wykonany Deep Search w ChatGPT. To sprawia, że ten model jest nie tylko skuteczniejszy, ale również bardziej efektywny czasowo, co czyni go najlepszym narzędziem do zaawansowanego researchu.

Problemy techniczne deep search od chat gpt:

Nie możemy zamykać karty na której dzieje się deep search. Przy jednym teście puściłem zapytanie, następnie wyłączyłem komputer, otrzymałem co prawda odpowiedzi, ale napisaną przez zwykły model. A nie przez funkcję deep search. Na szczęście gpt nie naliczył mi tego jako zapytanie deep search.

Podsumowanie działania Chat Gpt przy deep researchu, główne problemy merytoryczne

Choć research który wykonał chat gpt jest imponujący, to tak naprawdę nie pokrywa kluczowych aspektów polskiej sceny ai. Przede wszystkim zabrakło wspomnienia o raportach o sztucznej inteligencji w Polsce. Przykładowo, raport State of Warsaw AI 2024, tworzony przez fundacje Digital Poland, znacząco rozszerza wiedzę na temat rozwoju sztucznej inteligencji w Polsce. Z wspomnianego raportu dowiadujemy się np. że w Polsce istnieje ok 1000 firm związanych ze sztuczną inteligencją, przy czym 46% z nich znajduje się w Warszawie. Inne istotne miasta to Poznań, oraz Kraków (gdzie znajduje się superkomputer Helios, zarządzany przez placówkę Cyfronet AGH, komputer ten znajduje się na liście 100 najpotężniejszych komputerów na świecie).

Chat GPT wspomniał co prawda o Fundacji Digital Poland, i o tym że robią oni raporty, ale nie rozwinął tego tematu. Przy czym temat raportów pojawił się gdy potem pytałem już zwykłego modelu o AI w finansach w Polsce.

Ponieważ raporty nie są dostępne bezpośrednio na stronach, najczęściej trzeba je poprać w formie PDF, a często wcześniej musimy podać własnego maila itd, dlatego modele językowe nie „myślą” zbytnio konkretnych raportach, i nie mają dostępu do ich zawartości. Choć jeśli je poprosimy o znalezienie raportów, to są one w stanie to zrobić.

Główne zastosowanie funkcji deep search

Główna zastosowanie funkcji deep search przy porządnym researchu, to wstępne uporządkowanie zagadnienia, pomoc w wstępnym zorientowaniu się w temacie, i stworzenie tekstu który może służyć jako praktyczna kroków do które trzeba wykonać. W tym wypadku nie prosiłem o zrobienie planu researchu, natomiast stworzony tekst można tak wykorzystać. Dzięki niemu mogę po kolei czytać każdy fragment, i następnie wyszukiwać rzeczy które uznam za wartę rozwinięcia, co pozwala uniknąć chaosu który występuje przy klasycznym researchu.

Dodatkowo, dużo daje zrobienie wyszukania w wszystkich dostępnych narzędziach (Grok, Perplexity, Gemini), choć są one dużo prostsze, to mają „inny punkt widzenia”.

Praktyczne porady przy tańszych narzędziach

Wykorzystanie list numerowanych

Jeśli zależy Ci na uzyskaniu jak największej liczby wyników, warto poprosić model o stworzenie długiej listy numerowanej. Możesz również określić liczbę elementów, które powinny się w niej znaleźć, co zwiększy precyzję odpowiedzi.

Tworzenie planu wyszukiwania

Zamiast od razu prosić o research, warto najpierw wygenerować plan wyszukiwania. Można to zrobić za pomocą komendy:

„Napisz plan researchu, przeanalizuj go, wyszukaj treści w sieci, przeanalizuj je i ponownie wyszukaj.”

Takie podejście często daje lepsze wyniki niż pojedyncze zapytanie, ponieważ pozwala modelowi na wieloetapowe przetwarzanie informacji. Co więcej, komenda „Lista kroków” przydaje się również w wielu innych kontekstach, nie tylko podczas researchu.

Najpierw strategia, potem analiza

Jedną z najskuteczniejszych metod jest podział procesu na dwa etapy. W pierwszej komendzie prosimy model o opracowanie strategii wyszukiwania, analizę kluczowych zagadnień i identyfikację najlepszych źródeł. Następnie używamy tej odpowiedzi jako podstawy do kolejnego promptu, w którym prosimy o właściwe wyszukanie informacji.

Komenda „Zachowuj się jak model Deep Search”

Choć wpisanie tej komendy nie sprawi, że nagle uzyskamy pełny dostęp do zaawansowanych modeli, to może znacząco poprawić wyniki. W wielu przypadkach, zwłaszcza w modelach wyposażonych w wielostopniowe rozumowanie, AI na początku tworzy własny prompt na podstawie naszej komendy. W efekcie, jeśli poinformujemy model, że zależy nam na działaniu podobnym do Deep Search, początkowa analiza może być bardziej szczegółowa.

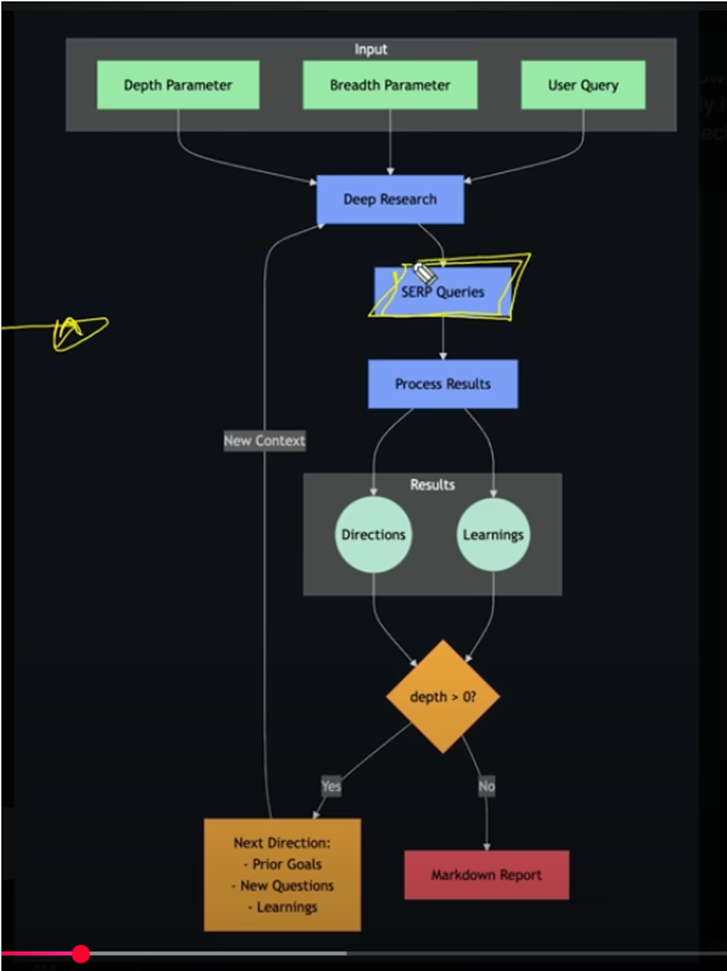

AI Agents – jak stworzyć własne narzędzie do Deep Search?

Automatyzacja researchu

Wbrew pozorom, funkcja Deep Search nie jest tak trudna do odtworzenia, jak mogłoby się wydawać. Już od dawna istnieją różne narzędzia umożliwiające zaawansowaną automatyzację wyszukiwania informacji. Wielu użytkowników tworzyło je np. przy pomocy Relevance AI lub łączyło ChatGPT z platformami Make.com i Zapier.

Najprostsza forma automatyzacji researchu wygląda następująco:

- ChatGPT generuje listę haseł do wyszukania

- Narzędzie automatyzacji wyszukuje je w sieci i pobiera treści z artykułów

- ChatGPT analizuje zebrane dane i tworzy plan tekstu

- Model AI generuje kolejne fragmenty artykułu na podstawie wniosków

Różnice między standardowym Deep Search a automatycznym systemem

Deep Search w ChatGPT działa na bardziej zaawansowanym poziomie, ponieważ potrafi ocenić jakość źródeł, określić czy warto poszukać nowych informacji oraz ustalić cele researchu, np. „Sprawdź, czy to jest prawdziwe”.

Proces działania wygląda mniej więcej tak:

Gotowe narzędzie pozwalające osiągnąć efekt podobny do Deep Search opisano w tym filmie: YouTube.

System ten wykorzystuje model GPT-4o do analizy i przetwarzania informacji. Dostęp do niego można uzyskać poprzez API, co oznacza, że płacimy za każde zapytanie – koszt jednego wyszukiwania wynosi od 2 do 5 zł. Co istotne, nie trzeba kupować pełnej wersji Pro (200 dolarów miesięcznie), aby mieć więcej zapytań. Wykorzystując tańsze modele, np. Deep Seek, można jeszcze bardziej obniżyć koszty.

To rozwiązanie opiera się na ChatGPT, automatyzacji oraz narzędziu Firefly, które przekształca strony internetowe na format bardziej przystępny dla modeli językowych.

Jak osiągnąć efekt Deep Search bez umiejętności technicznych?

- Wyszukaj hasła w Google i zapisz treści artykułów, które uznasz za wartościowe.

- Wklej teksty do modelu językowego i poproś o ich analizę.

- Zadaj kolejne pytanie, aby uzyskać nowe powiązane hasła.

- Powtórz proces wyszukiwania, aż zbierzesz wystarczająco dużo danych.

- Na podstawie zebranych informacji stwórz szkielet artykułu i napisz poszczególne fragmenty.

Jak skutecznie robić research?

Wykorzystanie AI do rozwoju umiejętności

W przypadku większości zastosowań sztucznej inteligencji kluczowe jest to, aby wspierała nasze możliwości, zamiast je zastępować. AI powinna pomagać w rozwoju umiejętności analitycznych, a nie je osłabiać.

Deep Search to ogromna pomoc dla osób, które wcześniej nie miały cierpliwości do przeprowadzania głębokich analiz. Świadomość, że dokładny research zajmie dwie godziny zamiast sześciu, znacznie ułatwia podjęcie się bardziej wymagających tematów.

Podstawowe zasady skutecznego researchu

Najważniejsza jest chęć zrozumienia tematu. Oznacza to, że użytkownik powinien umieć zadawać właściwe pytania i zauważać zależności między informacjami. Kluczowe jest również zapamiętywanie najistotniejszych faktów.

Istnieje wiele metod weryfikacji danych, ale podstawą jest tworzenie notatek. Wiele osób tego nie robi, przez co traci czas lub unika trudniejszych tematów, które mogłyby być dla nich wartościowe.

Korzyści z robienia notatek

Tworzenie papierowych notatek pomaga w zapamiętywaniu i porządkowaniu wiedzy, a także ułatwia dostrzeganie zależności. Z kolei notatki cyfrowe są wygodniejsze do późniejszej analizy i przetwarzania.

Najpopularniejsze narzędzia do organizacji informacji to:

- Notion

- Obsidian

- Canva (Whiteboards)

W wielu przypadkach zwykłe zakładki w przeglądarce oraz folder na dokumenty tekstowe (np. na Google Dysku) są wystarczająco skutecznym rozwiązaniem.

Sztuczna inteligencja może również pomóc w przetwarzaniu notatek. Możemy je wczytać do NotebookLM od Google lub analizować je w ChatGPT.

Po zakończeniu researchu warto utrwalić zdobyte informacje. Najskuteczniejsze metody to:

- samodzielne napisanie tekstu

- opowiadanie o zdobytej wiedzy innej osobie

- próba przeformułowania wniosków w myślach

Consensus AI – narzędzie do analizy prac naukowych

Jednym z ciekawszych narzędzi do researchu jest Consensus AI, które specjalizuje się w wyszukiwaniu treści i analizowaniu prac naukowych. Jeśli zależy Ci na zweryfikowanych badaniach, warto je przetestować jako uzupełnienie standardowych metod wyszukiwania.

Deep Search a badania naukowe

Tworzenie tekstów naukowych przez AI

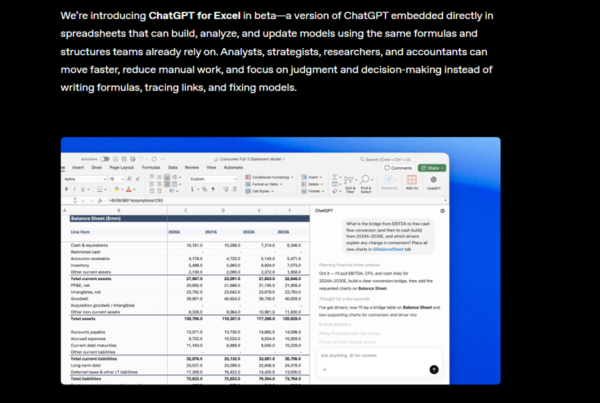

Sam Altman twierdzi, że narzędzie Deep Search od OpenAI potrafi generować teksty na poziomie doktoratu i że zapytanie warte 50 centów może wygenerować treść o wartości 500 dolarów.

Według OpenAI, Deep Search osiągnął lepsze wyniki niż doktor (PhD) mający dostęp do internetu, w ramach testu Last Humanity Exam. Warto jednak zaznaczyć, że test ten badał jedynie wiedzę i zdolność rozumowania na podstawie istniejących danych, nie oceniając rzeczywistej zdolności do prowadzenia badań naukowych.

Test praktyczny – czy Deep Search rzeczywiście tworzy wartościowe analizy?

Aby sprawdzić możliwości Deep Search, poprosiłem o tekst na poziomie profesorskim, który miał analizować koncepcję wiedzy scentralizowanej i rozproszonej według Hayeka w kontekście sztucznej inteligencji, uwzględniając także inne rodzaje wiedzy.

Na pytanie ChatGPT o dodatkowe wytyczne odpowiedziałem, że tekst powinien liczyć około 4000 słów, mieć charakter filozoficzno-ekonomiczny, ale być napisany w stylu popularnonaukowym. W efekcie otrzymałem 6200 słów dobrze skonstruowanego tekstu, który nie tylko był przyjemny w odbiorze, ale także zawierał interesujące przykłady działające na wyobraźnię. Jednym z nich było słynne zagranie nr 37 programu AlphaGo, często interpretowane jako intuicyjna decyzja AI.

Czy Deep Search od OpenAI zastąpi naukowców?

Deep Search jest ogromnym usprawnieniem w tworzeniu tekstów badawczych, jednak nawet nie zbliża się do zastąpienia naukowców. To narzędzie stanowi znacznie większy skok jakościowy niż samo wprowadzenie modeli językowych, które w przypadku bardziej złożonych tematów często działały jedynie jako lepsza wyszukiwarka internetowa.

Wcześniej modele AI pomagały głównie w szybszym znajdowaniu informacji i korekcie tekstów, ale ich użyteczność w analizach naukowych była ograniczona. Niektórzy badacze opracowywali metody pozwalające wyciągać więcej wartości z modeli językowych, np. poprzez automatyczne systemy analizy danych, jednak wymagało to ich własnej wiedzy. Trzeba również pamiętać, że wielu naukowców wykorzystywało AI do badań jeszcze przed premierą ChatGPT.

Choć tekst wygenerowany przez Deep Search wygląda na profesjonalną pracę naukową – i to nie tylko na pierwszy rzut oka, ale także po dokładniejszej lekturze – nie wyczerpuje on tematu i pomija kluczowe aspekty zagadnienia.

Część braków zauważyłem, porównując wyniki z odpowiedziami generowanymi przez inne narzędzia Deep Search.

Analiza wygenerowanego tekstu

Na początku tekstu ChatGPT przedstawia ogólny kontekst tematu, a następnie wymienia różne rodzaje wiedzy, jak o to poprosiłem. Łączy je z koncepcjami wiedzy scentralizowanej i rozproszonej, ale robi to w sposób nie do końca przejrzysty. Struktura byłaby lepsza, gdyby modele pogrupowały rodzaje wiedzy według ich przynależności do systemu centralnego lub rozproszonego oraz stopnia ich pośredniości między tymi dwoma podejściami.

Pełen tekst, w nieedytowanej wersji możecie zobaczyć tutaj:

Dalej ChatGPT analizuje przetwarzanie dużych ilości danych przez AI w sposób scentralizowany, przywołując przykłady takich firm jak Facebook, Amazon, Google czy Uber.

Ciekawy wątek to analiza aplikacji takich jak Uber czy Glovo, gdzie centralny algorytm może być niesprawiedliwy dla wielu dostawców, ponieważ nie uwzględnia ich lokalnej wiedzy.

Pojawia się także odniesienie do Jacka Ma i jego koncepcji cyfrowego bliźniaka gospodarki (Digital Twin).

Model wskazuje, że w Chinach informacje o każdej transakcji są natychmiast przekazywane do centralnego systemu, co w teorii pozwala rządowi podejmować decyzje w czasie rzeczywistym. Następnie pojawia się cytat Daron Acemoğlu, który prowokacyjnie pyta, czy argument Hayeka o wyższości rynku nadal by się bronił, gdyby centralni planiści mieli dzisiejszą moc obliczeniową AI.

To jeden z najważniejszych wątków w tekście, jednak ChatGPT nie rozwija go wystarczająco, co jest istotnym błędem.

Problematyka wniosków i analiza decentralizacji

Następnie model podaje przykłady, gdzie sztuczna inteligencja wspiera zdecentralizowane gromadzenie wiedzy. Przywołuje koncepcję mądrości tłumu i tego, jak AI może ją wykorzystać, a także odnosi się do systemów takich jak Spotify i Netflix, gdzie preferencje użytkowników kształtują algorytmy rekomendacyjne.

Problem polega na tym, że wnioski ChatGPT są niespójne. Model przedstawia te przykłady jako przeciwstawne do centralizacji, podczas gdy w rzeczywistości bardziej podważają one tezy Hayeka, niż je potwierdzają. Ten fragment lepiej pasowałby do analizy cyfrowego bliźniaka i centralizacji AI.

Model wspomina także o decentralizacji geograficznej wiedzy, podając przykład rolników w Afryce, którzy mogą robić zdjęcia roślin i uzyskiwać informacje o ich chorobach. W tym przypadku AI rozwija trendy zapoczątkowane przez rozwój internetu, zamiast je tworzyć od podstaw.

Ciekawy wątek dotyczy współpracy wielu inteligentnych agentów AI. W większości dyskusji na temat przyszłości AI dominuje wizja jednej scentralizowanej inteligencji, ale systemy oparte na wielu współpracujących agentach mogą eliminować problemy centralnego zarządzania. ChatGPT podaje jako przykład inteligentne sieci energetyczne (smart grid), w których każde gospodarstwo domowe ma własny system AI komunikujący się z innymi. Istotny jest też temat motywacji ludzi, i jako przykład podawane są smart miasta.

Warto jest tez zwrócić uwagę na problem homogenizacji wiedzy- sztuczna inteligencja może promować jeden, użyteczny, ale nie pełny punkt widzenia.

Czego zabrakło?

- Brak odniesienia do Misesa i problemu kalkulacji ekonomicznej, który znacząco rozwijał zagadnienie poruszane przez Hayeka.

- Brak krytyki dwóch rodzajów wiedzy Hayeka, która pojawiła się jeszcze przed rozwojem AI. Informację tę znalazłem przypadkowo w Google Gemini, choć model sam jej nie podał – wskazał jednak grafikę z artykułu krytycznego wobec Hayeka.

- Brak rozwinięcia tematu modeli hybrydowych i tego, jak unikać nadmiernej centralizacji decyzji.

- Brak dogłębnej analizy granic przewidywalności w epistemologii, którą bez problemu przeprowadziło Perplexity.

- Brak szczegółowego opisu chińskiego systemu Digital Twin oraz modeli AI stosowanych do analizy giełdy.

- Brak odniesienia do motywacji według Kirznera, poza krótkim wspomnieniem w kontekście miast.

- Brak analizy predykcyjnych modeli sprzedażowych i tego, czy AI może trafnie przewidywać zmiany w potrzebach konsumentów.

- Brak wzmianki o modelu DIKW (Data, Information, Knowledge, Wisdom), który mógłby pomóc w analizie struktury wiedzy.

Lista ta jest dość subiektywna – brak jednego z tych elementów nie byłby problemem, ale pominięcie Misesa oraz brak głębszej analizy centralnego planowania przy użyciu AI to istotne luki.

Wnioski

Deep Search w ChatGPT dostarczył tekst na wysokim poziomie, który mógłby uchodzić za profesjonalny artykuł akademicki. Jednak w porównaniu z Perplexity zabrakło pełniejszego kontekstu, a wnioski w niektórych miejscach były zbyt powierzchowne. Ostatecznie, choć narzędzie to może znacznie przyspieszyć research, nie zastąpi dogłębnej analizy prowadzonej przez ekspertów.