Ważniejsze niż konkretne komendy, jest nauczenie się rozmawiania z AI. Całość sprowadza się do analizy tego jakie efekty przynosi każda komenda, i dostosowania treści za pomocą kolejnej komendy. Zamiast tworzyć magiczne prompty które mają przynieść odpowiedni efekt, dużo łatwiej jest osiągnąć cel za pomocą serii komend. Podstawą jest ogólna intuicja, i wyobraźnia. Są oczywiście pewne sztuczki, i skuteczne techniki (czasami użycie, bądź nie użycie konkretnego słowa, znacząco zmienia efekt), natomiast co do zasady, uczenie się 100 czy 1000 użytecznych promtów, nie ma sensu. Istotą modeli językowych jest to, że rozmawia się z nimi za pomocą naturalnego języka. Ale obecnie nie są one idealne i w takich sytuacjach specjalne prompty mają znaczenie. Dochodzi tu jeszcze kwestia samej techniki rozmawiania z ludźmi, o czym na ogół się nie myśli. Uniwersalne zasady, dotyczące opisywanie potrzeb i problemów, przydają się zarówno przy rozmowie z ludźmi, jak i z chatem GPT. Rozpowszechnienie się hasła „prompt engineer” wynika w dużej mierze z wcześniejszych faz rozwoju AI. Umiejętności te są przydatne w pewnych sytuacjach, ale dla większości ludzi nie są one użyteczne.

Spis treści

Podstawy korzystania z modeli językowych

Dostarczenie kontekstu

Gdy rozmawiamy z człowiekiem, domyślnie dostarczamy mu kontekst, nawet bez wypowiedzenia ani jednego słowa. Sztuczna inteligencja tego kontekstu nie ma. Tak więc jeśli uzyskanie odpowiedniego efektu za pomocą serii promptów nie przynosi oczekiwanych efektów, najprostsze jest wrzucenie modelowi odpowiednich przykładów, np. wgrywając plik PDF, albo wklejając odpowiednie zdjęcie, opisując na jakich aspektach nam zależy, a których nie powinien uwzględniać. Przykładowo, jeśli zależy nam na formie tekstu, to czasem należy podkreślić żeby nie „odgapiał” treści.

Różnice pomiędzy działaniem AI, a ludzi.

Wracając do kontekstu. Jeśli prowadzisz jakąś firmę w Polsce, np. organizujesz wyjazdy, i potrzebujesz kogoś kto stworzy stronę WWW, to najprawdopodobniej osoba z którą rozmawiasz, o tym wszystkim wie. W przypadku AI, cały kontekst trzeba dostarczyć. Podczas rozmowy z innymi ludźmi, nie myślimy o tym.

Inny przykład: pytanie o to czym zastąpić sól. Jeśli pytamy o to innego człowieka, to domyślnie dana osoba wie, że chodzi o zastąpienie soli w kuchni. Chat GPT może podać chemiczną instrukcję, co miało fatalne skutki.

Częsta struktura promptów:

Jeśli zwykła rozmowa z chatem GPT nie działa, najczęstszym rozwiązaniem jest prosta komenda, składająca się z trzech elementów:

- Jestem [tu opisujesz swoją sytuacje]

- Potrzebuję [tu opisujesz problem]

- Zachowuj się jak [tu opisujesz jak chat GPT ma się zachowywać]

Dodatkowo, prompt można rozbudować o:

- Formę, np. jeśli potrzebujemy wstępnej wersji wiadomości e-mail. Forma wpływa też na treść.

- Styl (np. luźny, formalny, itd.)

- Czego należy unikać.

Wracając do przykładu solą, komenda powinna brzmieć mniej więcej tak: Jestem 60 letnim mężczyzną, mam nadciśnienie, chciałbym ograniczyć spożycie soli, zachowuj się ekspert dietetyki.

Wyobraźnia i lista kroków, na przemian rozmowa i długi tekst, poradniki promptowania od twórców modeli.

Kolejne potężne tryby pisania promtów. Lista kroków jest przydatna, jeśli osiągnięcie jakiegoś efektu sprawia nam problem.

Lista kroków i instrukcje.

Poniżej oficjalna wskazówka z poradnika Open AI, która ma postać listy kroków.

Cel: Szybko zdobyć wystarczający kontekst. Prowadzić odkrywanie równolegle i zatrzymać się, gdy tylko można podjąć działanie.

Metoda:

- Zacznij szeroko, a następnie przechodź do bardziej szczegółowych podzapytań.

- Równolegle uruchamiaj różne zapytania; czytaj najwyżej oceniane wyniki dla każdego zapytania. Usuwaj duplikaty i pamiętaj wyniki; nie powtarzaj tych samych zapytań.

- Unikaj nadmiernego poszukiwania kontekstu. Jeśli trzeba, uruchom celne wyszukiwania w jednej równoległej serii.

Kryteria wczesnego zatrzymania:

- Potrafisz wskazać dokładną treść do zmiany.

- Najważniejsze wyniki zbiegają się (~70%) w jednym obszarze lub ścieżce.

Eskalacja raz:

- Jeśli sygnały są sprzeczne lub zakres jest niejasny, wykonaj jedną dopracowaną równoległą serię wyszukiwań, a następnie przejdź dalej.

Głębokość:

- Śledź tylko symbole, które będziesz modyfikować albo kontrakty, na których się opierasz; unikaj rozszerzeń tranzytywnych, chyba że to konieczne.

Pętla:

- Wyszukiwanie zbiorcze → minimalny plan → wykonanie zadania.

- Szukaj ponownie tylko wtedy, gdy walidacja się nie powiedzie albo pojawią się nowe niewiadome. Preferuj działanie zamiast kolejnych poszukiwań.

Czasami przydatne jest ponumerowanie kolejności, i podkreślenie żeby czegoś nie używać/albo żeby upewnić się że tekst jest dobrze napisany.

Oficjalne poradniki

Twórcy modeli językowych dostarczają poradniki promptowania. Są one robione głównie z technicznej perspektywy, bazują na wiedzy wynikającej z tego jak działa dany model.

Link do poradnika od Open AI jest został już podatny, wskazówki od Google (Gemini) znajdziesz tutaj. Przy czym znalezienie tych rzeczy jest bardzo łatwe.

Wyobraźnia i budowanie scen, ai persony

Przy tworzeniu promptów, wyobraźnia jest bardzo przydatna. Przede wszystkim, dobrze jest umieć wyobrazi sobie jak działa model AI. Dodatkowo, tworzenie scen w których model AI ma operować, pomaga osiągnąć dobry efekt. Przykładowo, jeśli chcesz uzyskać dłuższy tekst na jakiś temat od strony praktycznej, możesz użyć komendy typu: „Jesteś osobą która gruntownie naprawia samochód od zera. Opisz jak to robić, na jakie problemy trzeba się przygotować.”

Dobre praktyki

- testuj różne warianty promptu, aż znajdziesz najbardziej trafny

- używaj języka naturalnego, nie musisz pisać jak programista

- sprawdzaj odpowiedzi krytycznie i uzupełniaj brakujące informacje

- zapisuj udane prompt’y, by wykorzystywać je ponownie

Co ciekawe, nie trzeba nawet stosować języka naturalnego, często nie trzeba w ogóle przejmować się gramatyką przy pisaniu komend. W poniższym przykładzie nie oszczędzamy zbyt wiele czasu, ale jeśli mamy dłuższe komendy, to stosowanie uproszczonego języka jest użyteczne. Najczęściej, wygodne jest po prostu dodawanie luźnych słów, do napisanych zdań.

Poprawa naszego tekstu, transkrypcja nagrania, strumień świadomości.

Jeśli używamy modelu językowego jako pomocy w pisaniu tekstów (np. wiadomości e-mail), postów na socjal media, artykułów, to często zamiast próbować stworzyć cały tekst za pomocą promptów, najprościej jest po prostu napisać tekst samodzielnie, na szybko, a potem poprosić model językowy o poprawienie go. Można również tekst podyktować, i użyć transkrypcji. W ten sposób można w 20 min napisać tekst, którego napisanie zajęło by normalnie 4 godziny. Pisząc w ten sposób, omijamy wiele blokad, nie musimy się przejmować tym żeby tekst był zwięzły, bo Chat GPT go skróci. Stąd można nawet stosować metodę strumienia świadomości, czyli pisania jak najszybciej, bez przejmowania się błędami i strukturą.

Czasami użyteczne jest napisanie samodzielnie pierwszych 20% tekstu, i następnie napisanie listy punktów. Po napisaniu tekstu przez model językowy, zostają jeszcze poprawki, za pomocą komend, oraz ręczne modyfikacje.

Po co rozmawiamy z chatem GPT? Główny podział celów.

Korzystanie z modeli językowych możemy podzielić na parę aspektów:

- Wyszukiwanie treści, zdobywanie wiedzy

- Tworzenie treści

- Rozmowa

Dodatkowo, można wyróżnić tworzenie grafik i pisanie kodu, choć można to zakwalifikować do tworzenia treści.

Jest to bardzo użyteczny podział, wszystkie zastosowania modeli językowych (których jest wiele) możemy zaliczyć do tych kategorii, czasem do jednej, czasem do dwóch, czasem do wszystkich (na przemian). Każdy tryb działania, wymaga nieco innego podejścia, i często wykracza poza samo promptowanie.

W przypadku wyszukiwania treści, na ogół używamy modelu językowego jako lepszej wyszukiwarki Google. Forma nie jest istotna, liczy się sama treść. Poza samymi promptami, przydatna jest tu wiedza o tym że istnieją funkcję takie jak deep search.

W przypadku tworzenia treści, poza samymi promptami, użyteczna jest wiedza o tym jak powstają większe treści, jak powinna wyglądać struktura tekstu, jakie problemy ma tekst rozwiązywać (zasada zadawania pytań, i odpowiadania na nie, itd.).

W przypadku rozmowy, kluczowe jest zbudowanie odpowiedniego „profilu pseudopsychologicznego” albo po prostu kontekstu i historii fikcyjnej postaci z którą rozmawiamy.

Użyteczne, ogólne prompty

- Wspomniana wcześniej składnia: „Jestem [opisujesz siebie. odbiorcę], potrzebuję [opis problem], zachowuj się jak [ekspert z jakieś dziedziny, zawód]”

- Podanie konkretnego przykładu osoby czy stylu, np. „pisz jak Platon, Ludwig von Mises,”, postacie mona miksować. Często działa to lepiej, niż ogólna prośba, typu pisz jak dziennikarz.

- „Postaraj się, dostaniesz 50 zł” (są badania sugerujące że zwiększa to jakość odpowiedzi)

- Słowa typu: „Upewnij się, pamiętaj” (zwiększają moc konkretnych słów i wytycznych).

- „Przeredaguj ten tekst tak, żeby brzmiał naturalnie w języku potocznym.”

- „Stwórz listę zagadnień/tematów. ” Potem można rozwijać konkretne zagadnienia

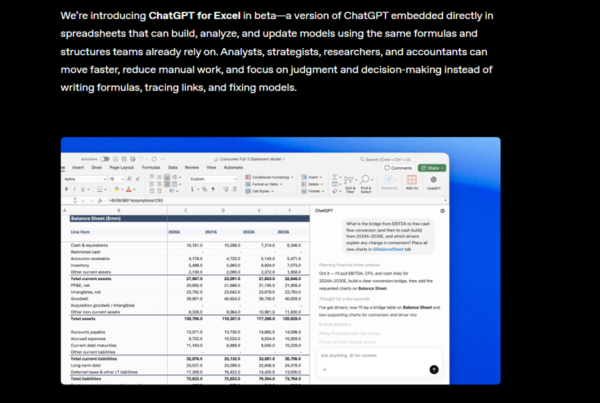

- „Stwórz tabelę, zaprojektuj dokładnie kolumny” – później można dodawać więcej kolumn, jest to bardzo przydatne przy researchu

- „Chcę osiągnąć dany cel, napisz prompta dla mnie”

- „Przemyśl odpowiedź, stwórz plan, następne ją napisz”

Możemy też poprosić model o napisanie promptu na dany temat.

Jailbreaking, bardzo dobry sposób na naukę promptowania

Czym jest jaibreaking?

Jailbreaking to obchodzenie blokad i cenzury w modelach językowych (i w generatorach grafiki). Jest to dobry sposób na naukę pisania komend, ponieważ od razu uzyskujemy wtedy mierzalne efekty naszych działań. Czasami użycie jednego słowa sprawia że model odmawia generowania treści, czasami dodanie odpowiedniego słowa sprawia że model zaczyna współpracować.

Istnieje ryzyko otrzymania bana w Chat GPT, ale jest ono stosunkowo małe. Jeśli nie chcemy w ogóle ryzykować, można skorzystać z konkursów i narzędzi robionych właśnie w tym celu.

https://gandalf.lakera.ai/baseline

Skąd się wzięła popularność hasła prompt enginering?

W wczesnych modelach, odpowiednia struktura promptu była bardzo istotna. Ponieważ modele te (na dzisiejsze standardy) były kiepskie, za pomocą komend dopasowanych do modelu, można było osiągnąć znacząco lepsze rezultaty. Szczególnie było to widoczne w modelach generujących grafikę, nie mających dostępu do bardziej zaawansowanych modeli językowych. W takich przypadkach prompt enginering był po prostu niezbędny. Obraz trzeba było opisać dużo dokładniej, niż podpowiadała intuicja. Przykładowo, konieczne było opisanie całej sceny, określenie stylu, użycie fraz typu: „award winning photo”, opisanie czego nie chcemy. Użycie odpowiedniego słowa, znacząco zmieniało efekt. Budowanie takich promptów, wymagało większego zrozumienia jak działa dany model.

Obecnie taki sposób generowania grafiki nadal jest używany, w tych modelach gdzie użytkownik ma dużo większa kontrolę nad efektem końcowym, np. w civic ai, czy stawianymi na własnym sprzecie modelami stable difussion

Wcześni entuzjaści i użytkownicy AI, którzy nie chcieli się nazywać ekspertami od AI (bo to pojęcie jest jednak zarezerwowane dla bardziej zaawansowanych ludzi, którzy rozumieją jak działają modele, potrafiący je budować), nazywali się wiec prompt enginerami (inżynierami promptów).

Obecnie, w większości przypadków, nie ma sensu. Jeśli ktoś aktywnie korzysta z AI, testuje wiele narzędzi, ale nie tworzy wielkich złożonych promptów, to nazwa promt engineer nie oddaje tego co ktoś robi. Dodatkowo, nazywanie się inżynierem, też rozmywa to pojęcia.

Niedawno natknąłem się na pojęcie: operator AI, i bardzo mi się ono spodobało. Nie sugeruje ono wielkiej wiedzy i doświadczenia, jak to jest w przypadku eksperta AI, czy nawet prompt enginnera, jest badziej szerokie, jednocześnie brzmi bardziej profesjonalnie niż : „świadomy użytkownik AI”.