Kiedy po raz pierwszy usłyszałeś o sztucznej inteligencji, prawdopodobnie przyszły Ci na myśl roboty, automatyczne samochody lub asystenci głosowi. Ale prawdziwa rewolucja nie zaczęła się w metalowych ramionach maszyn, tylko w modelach, które potrafią rozumieć język.

Dzisiaj AI potrafi czytać, pisać, tłumaczyć, a nawet rozmawiać. I to właśnie transformery sprawiły, że to możliwe.

Zanim jednak pojawiły się transformery, droga była długa i kręta. Przez lata naukowcy próbowali nauczyć komputery rozumienia tekstu, lecz każde podejście miało swoje ograniczenia. Sieci rekurencyjne (RNN) czy ich bardziej zaawansowane wersje (LSTM i GRU) potrafiły przetwarzać sekwencje słów, ale z trudem radziły sobie z długimi zdaniami. Model gubił sens, gdy kontekst sięgał zbyt daleko.

I wtedy, w 2017 roku, w laboratoriach Google powstał artykuł naukowy, który rozpoczął nową epokę. Nosił prosty, ale wymowny tytuł: “Attention Is All You Need”.

To właśnie tam narodził się transformer – model, który zredefiniował przetwarzanie języka i stał się fundamentem wszystkiego, co dziś nazywamy generatywną sztuczną inteligencją.

Spis treści

Czym właściwie jest transformer?

W skrócie: transformer to architektura sieci neuronowej, zaprojektowana po to, by uczyć się zależności między elementami w sekwencji, takimi jak słowa w zdaniu. Jego głównym celem jest zrozumienie kontekstu.

Nie brzmi to może szczególnie odkrywczo, ale sposób, w jaki transformer to robi, jest genialny. W przeciwieństwie do wcześniejszych modeli, które analizowały tekst słowo po słowie, transformer patrzy na całość zdania jednocześnie.

Dzięki temu rozumie, że w zdaniu „Pies, który gonił kota, był czarny” słowo „który” odnosi się do psa, nie do kota – mimo że między nimi znajduje się kilka innych wyrazów.

Kluczem do tego jest coś, co nazywamy mechanizmem uwagi (ang. attention).

Mechanizm uwagi, czyli jak model „koncentruje się” na sensie

Wyobraź sobie, że czytasz zdanie. Twój mózg nie przetwarza każdego słowa w izolacji. Zamiast tego cały czas odwołuje się do kontekstu. Kiedy widzisz słowo „który”, automatycznie przypominasz sobie, o czym była mowa wcześniej.

Transformery robią coś bardzo podobnego. Mechanizm uwagi pozwala im „spojrzeć” na wszystkie słowa w zdaniu i zdecydować, które są dla siebie istotne.

Matematycznie rzecz biorąc, każdy token (czyli fragment tekstu, np. słowo lub część słowa) dostaje wektor liczbowy opisujący jego znaczenie. Model następnie oblicza tzw. wagi uwagi (attention weights) – czyli wartości, które określają, jak bardzo dane słowo wpływa na interpretację innego.

To właśnie te wagi pozwalają modelowi uchwycić relacje, znaczenia i emocje, jakie kryją się w języku.

Dzięki temu transformer potrafi zrozumieć różnicę między zdaniami:

- „Jan kocha Marię”

- „Marię kocha Jan”

Mimo że oba zdania zawierają te same słowa, sens jest inny – a model potrafi to odróżnić.

Architektura transformera krok po kroku

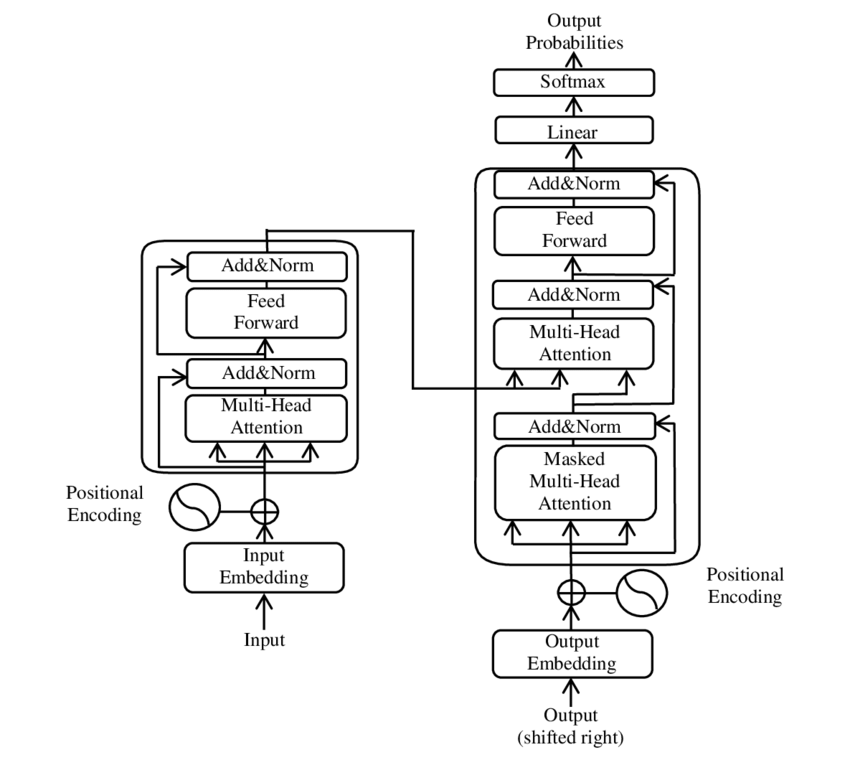

Każdy transformer składa się z dwóch głównych części: enkodera i dekodera.

W uproszczeniu można to porównać do dwóch etapów myślenia:

- Enkoder rozumie, co zostało powiedziane.

- Dekoder odpowiada, co należy na to powiedzieć.

Enkoder – zrozumienie kontekstu

Enkoder przyjmuje dane wejściowe (np. zdanie w języku angielskim) i przekształca je w tzw. reprezentacje wewnętrzne – zestaw liczb, które opisują znaczenie słów i ich wzajemne relacje.

Każda warstwa enkodera składa się z:

- Mechanizmu wielogłowej uwagi (Multi-Head Attention) – wiele niezależnych „uwag”, które uczą się różnych aspektów zdania (np. składni, sensu, relacji emocjonalnych).

- Feed Forward Network – prostej sieci neuronowej, która przetwarza dane po uwadze.

- Normalizacji i połączeń rezydualnych – dzięki nim model uczy się stabilnie i nie „zapomina” informacji z poprzednich warstw.

Dekoder – generowanie odpowiedzi

Dekoder działa podobnie, ale ma dodatkową rolę: na podstawie danych z enkodera generuje wynik, np. tłumaczenie albo odpowiedź.

Podczas generowania każdego słowa dekoder korzysta z tego, co już napisał, oraz z informacji, jakie dostarczył mu enkoder.

W praktyce oznacza to, że model nie tylko rozumie, o czym jest zdanie, ale też wie, jak logicznie i językowo kontynuować myśl.

Tokeny, embeddingi i pozycje – jak model „widzi” tekst

Dla człowieka słowa mają znaczenie. Dla komputera – wszystko to liczby. Dlatego zanim transformer zacznie pracować, tekst musi zostać przetworzony na liczbową postać.

Tokenizacja

Pierwszym krokiem jest tokenizacja, czyli podział tekstu na mniejsze jednostki (tokeny). Tokenem może być całe słowo, sylaba lub nawet pojedyncza litera.

Dzięki tokenizacji model potrafi rozumieć zarówno popularne słowa („dom”), jak i rzadkie formy („domku”, „domostwo”).

Embeddingi – znaczenie w liczbach

Każdy token jest następnie przekształcany w wektor liczbowy, zwany embeddingiem.

To trochę jak współrzędne w przestrzeni znaczeń.

W tej przestrzeni słowo król znajduje się blisko królowa, a daleko od pies.

Dzięki temu model rozumie, że między królem a królową istnieje relacja płci, a nie np. gatunku.

Pozycjonalne kodowanie

Ponieważ transformer nie przetwarza tekstu w kolejności (tak jak ludzie czy RNN), potrzebuje informacji o pozycji każdego słowa w zdaniu.

Tu wkracza positional encoding, czyli dodanie do każdego wektora informacji o jego miejscu w sekwencji.

Dzięki temu model wie, że w zdaniu „Kot zjadł rybę” to kot był sprawcą, a nie ofiarą.

Dlaczego transformery są tak skuteczne

Sukces transformera nie polega tylko na jego architekturze, ale też na tym, jak dobrze skaluje się wraz z danymi.

Równoległość obliczeń

Transformery potrafią przetwarzać wszystkie słowa jednocześnie. Dzięki temu uczenie jest dużo szybsze niż w starszych modelach, które musiały analizować tekst sekwencyjnie.

Długie zależności

Model potrafi „pamiętać” kontekst na dużych dystansach. Może więc rozumieć sens całego akapitu, a nie tylko pojedynczego zdania.

Elastyczność

Ta sama architektura działa w różnych dziedzinach: języku, obrazie, dźwięku, kodzie, biologii. To sprawia, że transformery stały się uniwersalnym wzorcem dla współczesnej AI.

Jak uczą się transformery

Uczenie transformera polega na przewidywaniu – ale nie przyszłości, tylko brakujących słów.

Modele typu BERT

BERT uczy się przez maskowanie.

Model dostaje zdanie z ukrytym słowem:

„Jan poszedł do [MASK] po chleb.”

Jego zadaniem jest odgadnąć, co powinno się tam znaleźć.

Dzięki temu uczy się znaczeń i relacji między słowami.

Modele typu GPT

Z kolei GPT uczy się przez przewidywanie kolejnego słowa.

Dostaje początek zdania:

„Kiedy słońce zachodzi…”

i ma przewidzieć, co nastąpi dalej.

W ten sposób uczy się struktury języka i logicznego ciągu myśli.

Trenowanie na miliardach słów

Nowoczesne modele są trenowane na gigantycznych zbiorach danych: książkach, artykułach, stronach internetowych.

Im więcej danych, tym lepiej model potrafi uchwycić niuanse języka.

Od BERT-a do ChatGPT: ewolucja transformerów

Po publikacji artykułu Google’a świat AI eksplodował.

- 2018 – BERT (Google): rewolucja w rozumieniu języka. Modele zaczęły rozumieć znaczenie zdań, a nie tylko liczyć słowa.

- 2019 – GPT-2 (OpenAI): pierwsze duże modele generujące tekst o zaskakująco spójnym sensie.

- 2020 – GPT-3: 175 miliardów parametrów i przełom w pisaniu, kodowaniu, tłumaczeniu.

- 2022 – ChatGPT: zastosowanie techniki Reinforcement Learning from Human Feedback (RLHF), która pozwoliła modelowi uczyć się z ludzkich ocen i prowadzić rozmowy.

- 2023–2025 – Era multimodalna: Gemini, Claude, GPT-4o i inne modele zaczęły rozumieć nie tylko tekst, ale też obraz, dźwięk, a nawet wideo.

Dziś transformery to nie tylko narzędzie – to fundament całego ekosystemu sztucznej inteligencji.

Transformery poza językiem

Choć powstały dla języka, bardzo szybko znalazły zastosowanie w innych dziedzinach.

Vision Transformer (ViT)

W 2020 roku Google wprowadził Vision Transformer – model, który zamiast przetwarzać piksele jak klasyczna sieć konwolucyjna, dzieli obraz na „tokeny” (małe fragmenty) i analizuje ich relacje tak samo, jak słowa w zdaniu.

Okazało się, że transformer potrafi doskonale rozpoznawać obiekty, kolory i wzory – często lepiej niż wcześniejsze algorytmy.

Audio i muzyka

Transformery analizują też dźwięk. Potrafią rozpoznawać mowę, generować muzykę, a nawet syntezować głos w czasie rzeczywistym.

Biologia i nauka

Model AlphaFold od DeepMind wykorzystał podobne zasady, by przewidywać strukturę białek. To odkrycie nazwano jednym z największych przełomów biologii XXI wieku.

Transformery w praktyce: od Google po Twojego laptopa

Jeśli korzystasz z wyszukiwarki, tłumacza, asystenta głosowego albo ChatGPT, to korzystasz z transformera.

Wyszukiwarki

Google od lat wykorzystuje modele oparte na BERT do lepszego rozumienia zapytań. Dzięki temu, gdy wpiszesz „jak ugotować ryż, żeby się nie kleił”, system rozumie intencję, a nie tylko słowa.

Tłumaczenia

Systemy tłumaczeń (Google Translate, DeepL) używają dekoderów transformerowych, by przekładać zdania z zachowaniem sensu i gramatyki.

Chatboty i asystenci

ChatGPT, Gemini, Claude – wszystkie te systemy to potężne sieci transformerowe, które potrafią nie tylko odpowiadać, ale też analizować, streszczać i tłumaczyć.

Przyszłość transformerów

Rozwój transformerów nie zwalnia. Wręcz przeciwnie – dopiero się zaczyna.

Modele multimodalne

Nowe modele potrafią jednocześnie rozumieć tekst, obraz, dźwięk, a nawet wideo. To oznacza, że w przyszłości AI będzie mogła analizować całą rzeczywistość, a nie tylko jej fragment.

Modele wyspecjalizowane

Zamiast jednego gigantycznego modelu do wszystkiego, pojawia się trend tzw. mixture of experts – zestawu wyspecjalizowanych modeli, które współpracują.

Lokalne transformery

Dzięki postępom w kompresji i optymalizacji, mniejsze wersje transformerów (np. LLaMA 3, Mistral, Phi 3) zaczynają działać bezpośrednio na laptopach i smartfonach.

Czy transformery naprawdę „rozumieją” język?

To pytanie, które powraca jak bumerang.

Z technicznego punktu widzenia – nie, transformery nie mają świadomości. Ale z praktycznego – potrafią operować językiem tak dobrze, że różnica zaczyna się zacierać.

Model nie wie, co to „pies”, ale rozumie, jak ludzie używają tego słowa. To wystarcza, by pisać teksty, tłumaczyć konteksty i rozwiązywać problemy.

W pewnym sensie transformery nie naśladują człowieka – one tworzą własny sposób rozumienia języka.

Podsumowanie: dlaczego transformer to najważniejszy wynalazek w historii AI

Transformery to nie kolejny krok w rozwoju sztucznej inteligencji. To skok o całą generację.

Zmieniły sposób, w jaki uczymy maszyny, myślimy o języku i tworzymy technologię.

Dzięki nim:

- AI potrafi rozumieć kontekst i sens.

- Modele można uczyć równolegle na ogromnych zbiorach danych.

- Technologia stała się bardziej dostępna – od nauki po biznes.

To właśnie transformery umożliwiły powstanie dużych modeli językowych, takich jak ChatGPT czy Gemini, i zapoczątkowały nową erę – erę, w której komunikacja z maszyną staje się naturalna.

I choć wiele jeszcze przed nami, jedno jest pewne: bez transformera nie byłoby współczesnej sztucznej inteligencji.