Ciągle słyszymy o tym, że sztuczna inteligencja jest trenowana, że modele są uczone na danych, i że zużywa to wiele energii i mocy obliczeniowej.

Tyle że dla osób spoza świata uczenia maszynowego brzmi to trochę jak czarna magia. Co tak naprawdę oznacza trenowanie modelu AI i na czym to polega w przypadku języka?

Spróbuję to wyjaśnić w możliwie prosty sposób, a jednocześnie nie uciekać od technicznych szczegółów tam, gdzie są naprawdę istotne. Pokażę, dlaczego wektory słów stały się fundamentem współczesnych modeli językowych, jak wygląda proces uczenia i co z tego wynika – także dla zrozumienia ograniczeń sztucznej inteligencji.

Spis treści

Słowa zamieniamy w liczby, a potem w wektory na przestrzeni wielowymiarowej.

Zacznijmy od podstaw. Komputer nie potrafi operować na słowach jako takich. Dla niego „kot” czy „pies” to nic innego jak ciąg znaków. Żeby model językowy mógł cokolwiek z nimi zrobić, trzeba te słowa przekształcić w liczby.

Najprostszą metodą byłoby przypisanie każdemu słowu jednej liczby, ale to nie daje żadnej wiedzy o relacjach między nimi. Dlatego w praktyce stosuje się wektory – zestawy liczb, które opisują słowo w przestrzeni wielowymiarowej.

Możesz to sobie wyobrazić jak współrzędne na mapie. Tyle że zamiast dwóch czy trzech wymiarów (jak długość, szerokość i wysokość), mamy setki, a czasem nawet tysiące wymiarów. Każde słowo to punkt w tej ogromnej przestrzeni. Dzięki temu słowa podobne znaczeniowo znajdują się blisko siebie, a różne – daleko.

Dlaczego wizualizacja jest tak trudna?

W matematyce dodawanie wymiarów to nic skomplikowanego. Możesz zawsze dodać kolejną oś i kolejną współrzędną. Problem zaczyna się wtedy, gdy chcesz to zobaczyć. Nasz mózg świetnie radzi sobie z trójwymiarem, ale powyżej tego jest bezradny.

Dlatego naukowcy i inżynierowie często używają metod redukcji wymiarów, które sprowadzają przestrzeń np. z tysiąca wymiarów do dwóch lub trzech. Wtedy da się narysować wykres, choć trzeba pamiętać, że to tylko przybliżenie.

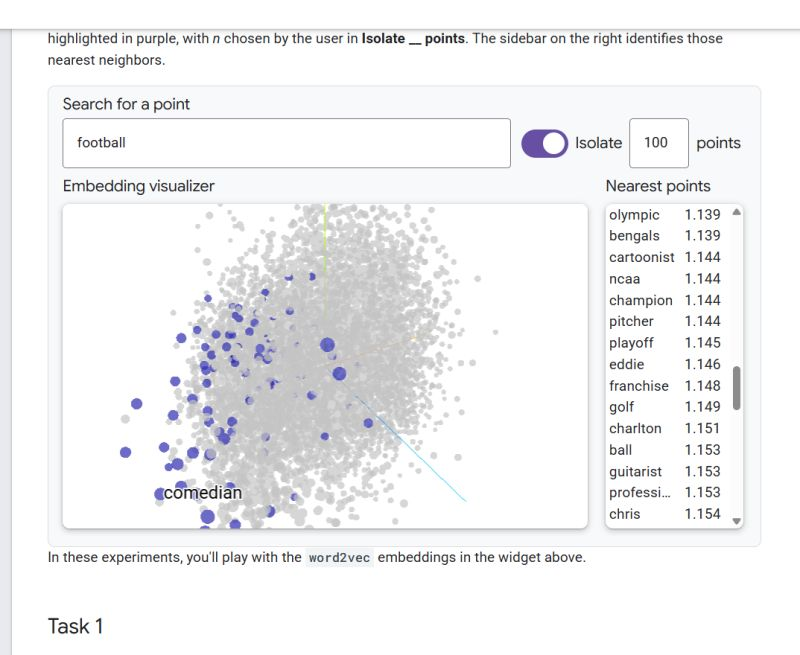

Świetnym narzędziem, które to pokazuje, jest embedding visualizer od Google. Możesz tam wpisać słowo, np. football, a system podświetli 100 najbliższych słów w przestrzeni wektorowej. Nagle widzisz nie tylko oczywiste skojarzenia, jak playoff, ncaa czy olympic, ale też mniej przewidywalne, jak comedian czy guitarist.

Skąd biorą się zaskakujące sąsiedztwa?

Na pierwszy rzut oka trudno zrozumieć, co komik ma wspólnego z piłką nożną. Jednak wystarczy przypomnieć sobie, jak ogromne i zróżnicowane są dane treningowe. Modele uczą się na tekstach z internetu, książkach, artykułach prasowych, forach, social mediach.

Jeśli w takich źródłach ktoś tworzył listy zawodów, zainteresowań albo opisów profili osób, to piłkarz, gitarzysta i komik mogli pojawić się obok siebie. Model „zapamiętał”, że te słowa często współwystępują i w efekcie uznał je za bliższe, niż podpowiadałaby intuicja.

Takie zjawiska są ważne, bo tłumaczą m.in. halucynacje AI – sytuacje, gdy model łączy ze sobą rzeczy, które z ludzkiego punktu widzenia wcale do siebie nie pasują.

Jak wygląda sam proces trenowania?

Do tej pory mówiliśmy o tym, czym są wektory i jak można je zobrazować. Ale jak AI dochodzi do tego, żeby „wiedzieć”, gdzie ustawić dane słowo?

Na początku wszystkie parametry są losowe. Wtedy słowa są w przestrzeni rozrzucone chaotycznie. Model dostaje zadanie – na przykład przewidzieć brakujące słowo w zdaniu: „Kupiłem piłkę i poszedłem grać w ___”.

Jeśli zgadnie, że powinno tam być „piłkę nożną” albo „football”, dostaje punkt. Jeśli pomyli się i poda np. „szachy”, różnica między jego odpowiedzią a poprawnym wynikiem służy do korekty parametrów.

Ten mechanizm, zwany propagacją wsteczną (backpropagation), powtarza się miliardy razy. Model krok po kroku dopasowuje swoje parametry (wagi i biasy), aż wreszcie zaczyna dobrze odwzorowywać prawidłowości obecne w danych.

Wagi i biasy – dwa filary uczenia

Parametry modeli dzieli się na dwie główne kategorie:

- wagi – określają „siłę” połączeń między neuronami w sieci i położenie wektorów w przestrzeni;

- biasy – pełnią rolę przesunięć, które pozwalają modelowi uchwycić kontekst i niuanse.

Dzięki wagom model „wie”, że słowo pies jest bliżej słowa kot niż słowa samochód. Dzięki biasom potrafi wychwycić, że w zdaniu „Założyłam kurtkę” słowo „założyłam” dotyczy ubrania, a nie np. krzesła.

Mechanizm uwagi – czyli jak model „patrzy” na tekst

Współczesne modele, takie jak GPT, używają jeszcze jednego kluczowego elementu: mechanizmu uwagi (attention). To on pozwala im zdecydować, które fragmenty tekstu są dla danego słowa najważniejsze.

Jeśli model analizuje zdanie „Samochód, który kupiłem wczoraj, okazał się czerwony”, to przy słowie „czerwony” powinien patrzeć na „samochód”, a nie na „wczoraj”. To właśnie attention steruje tym, jakie fragmenty są ze sobą łączone.

Można to porównać do rozmowy – czasem skupiasz się na jednym wątku, a inne ignorujesz. AI robi podobnie, tyle że w matematyczny sposób, za pomocą wektorów i macierzy.

Dlaczego trenowanie wymaga tak dużo mocy obliczeniowej?

Kiedy słyszysz, że trenowanie dużego modelu zajmuje tygodnie i wymaga setek procesorów graficznych, chodzi właśnie o ten proces wielokrotnego korygowania parametrów.

Każda iteracja to obliczenia na ogromnych macierzach. A takich iteracji są miliardy. Dlatego bez nowoczesnych kart graficznych, które potrafią wykonywać tysiące operacji równolegle, nie byłoby mowy o praktycznym uczeniu AI na taką skalę.

Dlaczego to ważne dla nas, użytkowników?

Możesz zapytać: „Po co mi ta wiedza, skoro nie planuję sam trenować modeli?”. Odpowiedź jest prosta: żeby lepiej rozumieć ograniczenia i możliwości AI.

Kiedy model podaje nietrafną odpowiedź albo zaczyna halucynować, nie wynika to z lenistwa czy złej woli. To efekt tego, jak ułożone są jego wektory i parametry. Warto o tym pamiętać, szczególnie gdy używamy AI w pracy czy w edukacji.

Eksperymenty z wizualizacjami embeddingów pozwalają też intuicyjnie zrozumieć, że model nie myśli jak człowiek – on operuje na wzorcach statystycznych. To mocne narzędzie, ale działa w ramach swoich matematycznych ograniczeń.

Fine-tuning, czyli dostrajanie pod konkretne potrzeby

I tu właśnie pojawia się pojęcie fine-tuning. Nie każdy użytkownik ma czas czy zasoby, aby trenować model od zera. To byłoby jak budowa całej biblioteki tylko po to, żeby nauczyć się kilku specjalistycznych książek. Fine-tuning działa inaczej – zaczynamy od już wyszkolonego, ogólnego modelu (który zna język, ma ogromną bazę słów i kontekstów), a następnie dostrajamy go do konkretnego zadania.

Przykładowo firma prawnicza może wziąć istniejący model językowy i na niewielkim zestawie własnych dokumentów „przyuczyć” go do żargonu prawniczego, typowych pytań klientów czy struktury opinii prawnych. Efekt? Model, który nadal rozumie język ogólny, ale lepiej radzi sobie w wąskiej dziedzinie.

Z punktu widzenia użytkownika fine-tuning ma kilka zalet:

- lepsza trafność – model rzadziej halucynuje w Twojej dziedzinie, bo ma dodatkowy kontekst;

- większa efektywność – nie trzeba trenować wszystkiego od nowa, a jedynie „dokręcić śrubki” w istniejącej maszynie;

- personalizacja – model może uczyć się terminologii specyficznej dla firmy, branży albo stylu komunikacji.

Dlaczego to działa?

Mechanicznie rzecz biorąc, fine-tuning polega na lekkim skorygowaniu wag i biasów w wytrenowanym już modelu. Te ogromne macierze liczb są jak krajobraz, który ma już ułożone góry i doliny. Fine-tuning nie tworzy nowego świata od podstaw – on po prostu rzeźbi w kilku miejscach, aby krajobraz lepiej pasował do naszej mapy.

Fine-tuning w praktyce

Wyobraź sobie, że ogólny model wie, że „football” leży blisko „playoff” i „ncaa”, ale też – z powodu danych – blisko „comedian”. Jeśli chcesz modelu używać w aplikacji edukacyjnej dla sportowców, możesz w ramach fine-tuning sprawić, by wektory były przesunięte tak, aby bardziej podkreślały sportowe konteksty, a ignorowały te mniej trafne.

Dlaczego warto o tym wiedzieć?

Bo fine-tuning tłumaczy, dlaczego istnieją wersje branżowe i specjalistyczne modeli AI. Jeśli korzystasz z narzędzia do analizy prawnej, medycznej czy technicznej, często jest ono właśnie efektem dostrojenia ogólnego modelu. Wiedza o tym pomaga świadomie wybierać narzędzia – wiesz, że model „z ogólnego internetu” będzie miał inną dokładność niż taki, który przeszedł dodatkowe szkolenie na danych z Twojej branży.

RAG i bazy wiedzy – jeszcze prostsze niż fine-tuning

Choć fine-tuning pozwala dostroić model do specjalistycznych zastosowań, istnieje też jeszcze prostsza metoda – RAG (Retrieval-Augmented Generation). W tym podejściu model nie jest dodatkowo trenowany ani zmieniany w środku. Zamiast tego łączy się go z zewnętrzną bazą wiedzy, z której w czasie rzeczywistym pobiera informacje.

Wyobraź sobie, że model ma odpowiadać na pytania o produkty w Twojej firmie. Zamiast uczyć go od nowa wszystkich opisów i dokumentacji, wystarczy podłączyć go do bazy, w której te informacje są przechowywane. Gdy użytkownik zadaje pytanie, model najpierw „przeszukuje” bazę, a dopiero potem buduje odpowiedź na tej podstawie.

Z punktu widzenia użytkownika to ogromna zaleta: nie trzeba czekać tygodni ani inwestować dużych zasobów w fine-tuning. RAG pozwala szybko i łatwo sprawić, że AI staje się bardziej aktualne, wiarygodne i dostosowane do kontekstu, w którym pracujesz.

Najprostszą formą RAG, jest customowy model/asystent w Chat GPT. Można tez po prostu dodać do wątku lub projektu uporządkowanego pdf z wiedzą, np. w formie zagnieżdżonej listy numerowanej, z zaznaczaniem do jakich punktów odnoszą się dane fragmenty tekstu.

Gdzie to wszystko zmierza?

Uczenie modeli AI rozwija się w kilku kierunkach jednocześnie:

- większe modele – coraz więcej parametrów, co pozwala odwzorować coraz subtelniejsze zależności;

- lepsze dane – czystsze, bardziej różnorodne, lepiej opisane;

- efektywniejsze algorytmy – np. takie, które uczą się szybciej albo zużywają mniej energii;

- specjalizacja – modele trenowane na węższych dziedzinach (medycyna, prawo, edukacja).

Każdy z tych kierunków ma znaczenie. Ale fundament pozostaje ten sam: dopasowywanie parametrów wektorowych tak, by jak najlepiej odwzorować wzory obecne w danych.

Podsumowanie

Trenowanie sztucznej inteligencji to proces dopasowywania liczb – wag i biasów – które określają, jak słowa i konteksty są ułożone w wielowymiarowej przestrzeni. Modele językowe nie rozumieją języka tak jak człowiek, ale dzięki miliardom iteracji uczą się odtwarzać statystyczne wzory obecne w danych.

Narzędzia takie jak interaktywne wizualizacje embeddingów pozwalają zobaczyć namiastkę tego, co dzieje się wewnątrz modelu. Dzięki nim możemy lepiej zrozumieć zarówno jego siłę, jak i ograniczenia.

I właśnie dlatego warto czasem zajrzeć głębiej. Bo sztuczna inteligencja, choć oparta na skomplikowanej matematyce, w swojej istocie opiera się na prostym pomyśle: uczyć się poprzez powtarzanie i poprawianie błędów, aż liczby zaczną układać się w sensowny obraz języka.