Sztuczna inteligencja, albo po prostu AI, to jeden z najgorętszych tematów naszych czasów. Wirtualni asystenci, algorytmy na Netfliksie, a nawet roboty sprzątające – AI jest już wszędzie, chociaż rzadko zdajemy sobie z tego sprawę. Ale co tak naprawdę kryje się za tymi dwoma literami? Czy maszyna może myśleć jak człowiek? A co jeśli pewnego dnia AI zyska świadomość? To pytania, które od dekad zadają sobie naukowcy, filozofowie i pisarze science fiction. Prawda jest taka, że to, co kiedyś było szalonym pomysłem, dziś staje się rzeczywistością. Warto jest poznać rodzaje sztucznej inteligencji, bo jest to kluczowe do dalszej dyskusji.

Spis treści

Historia sztucznej inteligencji.

Zanim komputery stały się powszechne, myślenie o sztucznej inteligencji zaczęło się w literaturze. W 1921 roku czeski dramaturg Karel Čapek wymyślił słowo „robot” w swojej sztuce, dając początek publicznej dyskusji o „sztucznych ludziach”. Zaledwie kilka lat później, w 1929 roku, japoński profesor Makoto Nishimura zbudował Gakutensoku, pierwszego japońskiego robota, który potrafił wyrażać mimikę twarzy. W tamtych czasach, napędzane parą maszyny były ucieleśnieniem marzeń o zautomatyzowanych pomocnikach.

Prawdziwa rewolucja zaczęła się w połowie XX wieku. W 1950 roku Alan Turing, legendarny matematyk, opublikował przełomową pracę o „maszynach, które myślą”. Zapytał, czy maszyna może prowadzić rozmowę w sposób nierozróżnialny od człowieka, tworząc słynny test Turinga, który do dziś jest kamieniem milowym w dziedzinie AI. Niedługo potem, w 1956 roku, na konferencji w Dartmouth, narodziła się nowa dyscyplina. John McCarthy użył wtedy po raz pierwszy terminu „sztuczna inteligencja”.

Początkowe lata były pełne optymizmu. Powstały pierwsze programy, które uczyły się same grać w warcaby , i język programowania LISP, dedykowany badaniom nad AI. W 1966 roku Joseph Weizenbaum stworzył ELIZĘ, pierwszego chatbota, który symulował rozmowę z ludźmi, co wywarło ogromne wrażenie. Ale entuzjazm szybko opadł, a w latach 70. i 80. nadeszła „zima AI”. Okazało się, że maszyny nie są tak inteligentne, jak obiecywano.

Odrodzenie nastąpiło w latach 90. W 1997 roku świat wstrzymał oddech, gdy komputer IBM Deep Blue pokonał mistrza świata w szachach, Garriego Kasparowa. To było jak symboliczne zwycięstwo – maszyna prześcignęła człowieka w strategicznym myśleniu. Kolejnym przełomem był superkomputer IBM Watson, który w 2011 roku wygrał teleturniej „Jeopardy!”, odpowiadając na pytania w czasie rzeczywistym. W tym samym roku wirtualna asystentka Siri trafiła do milionów iPhone’ów, wprowadzając AI do codziennego życia.

Ostatnia dekada to prawdziwy wybuch technologii. Od 2015 do 2017 roku program AlphaGo od Google DeepMind pokonał mistrzów w grze Go, która jest o wiele bardziej skomplikowana od szachów. Ale prawdziwą rewolucję przyniosły modele generatywne. W 2020 roku OpenAI wprowadziło GPT-3, model językowy zdolny do tworzenia tekstu, który trudno odróżnić od pisanego przez człowieka. Później pojawiły się DALL-E, generujące obrazy , a w 2022 roku publicznie udostępniony ChatGPT sprawił, że AI trafiła do głównego nurtu. W międzyczasie polscy badacze stworzyli model Bielik, a największe firmy technologiczne, takie jak Google i Meta AI, wciąż prześcigają się w tworzeniu nowych, potężniejszych modeli.

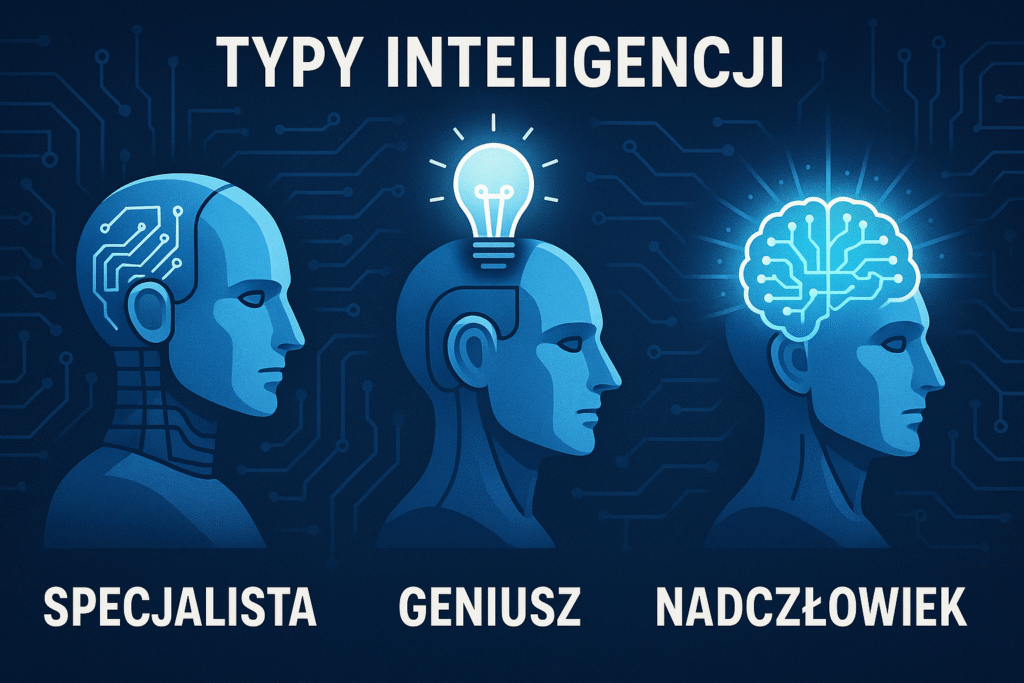

Typy inteligencji: specjalista, geniusz i nadczłowiek

Aby zrozumieć, gdzie jesteśmy z AI, musimy rozróżnić jej trzy główne typy.

1. Sztuczna Wąska Inteligencja (ANI)

Artificial Narrow Inteligence to AI, z którą stykamy się każdego dnia. ANI, nazywana też „słabą AI”, jest zaprojektowana do jednego, konkretnego zadania. To taki cyfrowy specjalista, który wie wszystko o swojej dziedzinie, ale nic poza nią.

Przykłady z życia:

- Asystenci głosowi (Siri, Alexa) rozumieją polecenia, ale tylko te, do których zostały zaprogramowane.

- Algorytmy na Netfliksie analizują, co oglądałeś, żeby polecić ci kolejny serial.

- Systemy do rozpoznawania twarzy w telefonach.

- Chatboty, nawet te najbardziej zaawansowane jak ChatGPT, choć wydają się wszechstronne, działają w ramach swoich algorytmów i nie mają samoświadomości.

Choć ANI jest niesamowicie użyteczna, brakuje jej elastyczności. Nie potrafi uczyć się na błędach, tak jak ludzie , ani myśleć abstrakcyjnie poza swoim polem działania.

Uważam że z warto jest podzielić ANI na dwa rodzaje, np. stałą i zmienną, albo wąską i bardzo wąską. Podział ten jest istotny zwłaszcza z punktu widzenia użytkownika. Chat GPT który może wykonać jakieś zadania, pod tym kątem mocno różni się od asystentów głosowych typu Siri czy Alexa (które mogą głównie wykonywać proste, zaprogramowane wcześniej zadania), czy np. filtrów do zmieniania wyglądu zdjęć, opartych na AI.

2. Sztuczna Ogólna Inteligencja (AGI)

To „święty Graal” badań nad AI i cel, do którego dążą najwięksi gracze w branży. AGI, znana jako „silna AI”, miałaby inteligencję na poziomie ludzkim lub wyższym i potrafiłaby wykonać każde zadanie intelektualne, które potrafi człowiek. Myśl o AGI jak o cyfrowym geniuszu, który potrafi nie tylko grać w szachy, ale też pójść na uniwersytet, rozwiązać zagadkę, a nawet zaplanować, jak zaparzyć kawę.

Droga do AGI: Naukowcy pracują nad różnymi podejściami. Jednym z nich jest uczenie maszynowe, które pozwala algorytmom na samodzielne uczenie się i dostosowywanie. Inne, bardziej futurystyczne podejście, to emulacja całego ludzkiego mózgu. Chodzi o precyzyjne skopiowanie wszystkich połączeń neuronowych i odtworzenie ich działania w komputerowej symulacji, co wymagałoby gigantycznej mocy obliczeniowej, rzędu 500 petabajtów pamięci. Innym pomysłem jest wykorzystanie globalnej sieci superkomputerów, z których pierwsze mają zacząć działać już w tym roku, co ma przyspieszyć prace nad AGI.

Kiedy pojawi się AGI? Opinie są podzielone. Sam Altman, szef OpenAI, uważa, że to kwestia „kilku tysięcy dni”. Z kolei prezes Nvidii, Jensen Huang, prognozuje, że AGI pojawi się do 2028 roku. Niezależnie od daty, jedno jest pewne – AGI zmieniłoby świat nie do poznania.

3. Sztuczna Superinteligencja (ASI)

To czysto teoretyczna wizja przyszłości. ASI to hipotetyczna forma AI, która przewyższałaby ludzki umysł pod każdym względem. Byłaby tak potężna, że mogłaby rozwiązywać problemy, które dziś są dla nas niemożliwe. Niektórzy spekulują, że ASI mogłaby nawet posiadać emocje i zdolność do nawiązywania relacji. To właśnie ta koncepcja prowadzi do pytań o „technologiczną osobliwość” – punkt, w którym rozwój technologiczny staje się niekontrolowany i nieprzewidywalny.

Największa tajemnica: czy AI może mieć świadomość?

To pytanie, które zaprząta umysły filozofów od wieków. Jak ujął to św. Augustyn, „Czymże więc jest czas? Jeśli nikt mnie o to nie pyta, wiem. Jeśli pytającemu usiłuję wytłumaczyć, nie wiem”. Podobnie jest ze świadomością. Jest to „myślenie, które wie, że myśli”. Świadomość to nie tylko wiedza, ale „wiedza o tym, że wiemy”. To głębszy poziom, który pozwala nam doświadczać świata, odczuwać ból, smak czy kolor. Te subiektywne, jakościowe doświadczenia nazywamy w filozofii qualia. Problem w tym, że „świadomość nie daje się złapać jak kamień, nie można jej zważyć ani rozciąć”.

Debata na ten temat sprowadza się do dwóch kwestii, które znakomicie podsumował filozof David Chalmers:

- Łatwe problemy: To pytania o to, jak mózg przetwarza informacje, integruje je czy generuje zachowania. To zagadnienia, które nauka może rozwiązać.

- Trudny problem świadomości: To pytanie, jak i dlaczego procesy fizyczne w mózgu prowadzą do subiektywnego doświadczenia. Jak to jest być czymś? Chalmers uważa, że to coś więcej niż tylko fizyka i że nie da się tego wyjaśnić, wiedząc nawet wszystko o mózgu.

Najsłynniejszym argumentem przeciwko świadomej AI jest eksperyment myślowy „Chiński Pokój” Johna Searle’a. Wyobraź sobie, że jesteś w pokoju, a ktoś z zewnątrz podaje ci chińskie znaki. Nie znasz chińskiego, ale masz instrukcję, która mówi, jak manipulować tymi znakami, żeby wygenerować odpowiedź. Zewnętrzny obserwator pomyśli, że rozumiesz chiński, bo twoje odpowiedzi są poprawne. Ale ty wiesz, że po prostu podążasz za regułami, nie rozumiejąc ani słowa. Searle twierdzi, że komputer jest jak ty w tym pokoju: manipuluje symbolami (danymi), ale nie rozumie ich znaczenia.

Ten argument ma jednak swoich krytyków. Niektórzy twierdzą, że choć ty nie rozumiesz, to cały system – ty, instrukcje i znaki – ma zrozumienie. Inni dodają, że prawdziwe zrozumienie wymaga interakcji z otoczeniem, co Searle odrzuca, mówiąc, że robot nadal tylko reaguje na podstawie programu.

Jednakże, mimo że obecnie AI nie może odczuwać emocji, niektórzy badacze uważają, że świadomość może zostać odtworzona w maszynie, jeśli uda się skopiować organizację funkcjonalną mózgu. To jest główny cel neuroobliczeniowej teorii świadomości. Istnieje też teoria panpsychizmu, która sugeruje, że świadomość jest fundamentalną cechą rzeczywistości i występuje w jakiejś formie we wszystkim, co istnieje.

Ciemna strona i nadzieje: co nas czeka?

Rozwój AI, zwłaszcza w kierunku AGI, stawia przed nami poważne wyzwania, które wymagają natychmiastowej uwagi.

Ryzyka i obawy

- Rynek pracy: Czy roboty zabiorą nam pracę? To jedna z największych obaw. Automatyzacja może prowadzić do wzrostu bezrobocia i pogłębienia nierówności społecznych.

- Manipulacja i dezinformacja: AI może być używana do tworzenia fałszywych treści, takich jak deepfakes, co zagraża porządkowi publicznemu i debacie demokratycznej.

- Wzrost przestępczości i inwigilacja: AI może być wykorzystana do cyberprzestępczości czy masowej inwigilacji, co zagraża naszej wolności i prywatności.

- „Problem kontroli”: A co, jeśli superinteligentna maszyna wymknie się spod kontroli i jej cele przestaną być zgodne z naszymi? Eksperci przyznają, że jest to poważne ryzyko egzystencjalne, które wymaga pilnego rozwiązania.

Szanse i nadzieje

Z drugiej strony, AI obiecuje ogromne korzyści. Może pomóc w rozwiązaniu globalnych problemów, takich jak zmiany klimatyczne, i przyspieszyć postęp w medycynie i inżynierii. Odpowiednio zarządzana AGI może przynieść korzyści całej ludzkości, o ile tylko podejdziemy do niej odpowiedzialnie.

W odpowiedzi na te wyzwania, rządy, w tym Unia Europejska, tworzą nowe prawa, takie jak unijny AI Act, który ma na celu klasyfikowanie systemów AI według poziomu ryzyka i zapewnienie ich przejrzystości.

Czy modele językowe (LLM) to najlepsza droga do AGI? A może jest to ślepa uliczka?

Obecnie, gdy myślimy o świadomej sztucznej inteligencji, czy AGI, myślimy głównie o modelach językowych. Powód jest prosty: wiadomości pisane przez chat GPT, na pierwszy rzut oka wyglądają jakby były pisane przez kogoś świadomego. Komunikacja za pomocą słów najbardziej kojarzy się nam z świadomością. Dochodzi tu również pewna wszechstronność, modele językowe mogą obsługiwać tryb agenta. Stąd Sam Altman długo twierdził że Chat GPT 5 będzie modelem klasy AGI, a obecnie twierdzi że był to znaczący krok w stronę AGI.

Ostatnio coraz częściej pojawia się jednak pytanie: A co jeśli modele językowe to ślepa uliczka?

Jest tu parę tematów. Ograniczeniem może nie być sama „językowość” modelu, a to w jaki sposób on działa. Możliwe że w modelu opartym na przewidywaniu tokenów dzięki statystyce i rachunku prawdopodobieństwa, nie może „narodzić się” świadomość. Ale jest możliwe, że modele które generują tekst nie poprzez przewidywanie kolejnego słowa czy sylaby, a które działają poprzez tworzenie szumu. Szum ten, następnie jest przetwarzany na tekst.

Inne podejście mówi że modele językowe w całości są ślepą uliczką, ponieważ nie są modelami zadaniowymi. Być może świadomość ma się większą szansę narodzić tam, gdzie sztuczna inteligencja musi samemu pamiętać żeby pilnować pewnych zadań, i analizować efektywność. Co jeśli AGI narodzi się jako program do zarządzania ruchem ulicznym, albo np. hodowlą krabów?

Przyszłość pisze się na naszych oczach

Sztuczna inteligencja jest w ciągłym ruchu. ANI jest już naszą codziennością, AGI jest w fazie intensywnych badań, a ASI to odległa wizja. Niezależnie od tego, czy maszyny zyskają świadomość, czy pozostaną tylko wyrafinowanymi narzędziami, jedno jest pewne: AI zmienia naszą cywilizację.

Zapewnienie, że ta transformacja będzie służyć dobru wszystkich, wymaga zaangażowania nie tylko programistów i naukowców, ale także filozofów, prawników i każdego z nas. To wspólny wysiłek, który zdecyduje o tym, czy w przyszłości AI będzie partnerem i sojusznikiem w poszukiwaniu mądrości , czy źródłem nowych zagrożeń.